OmniHuman:端到端多模態數字人視頻生成框架

OmniHuman是字節跳動的一個基于擴散Transformer的多模態數字人視頻生成框架。只需用一張照片和一段音頻,就可以生成視頻,而且動作,口型和表情接近完美。

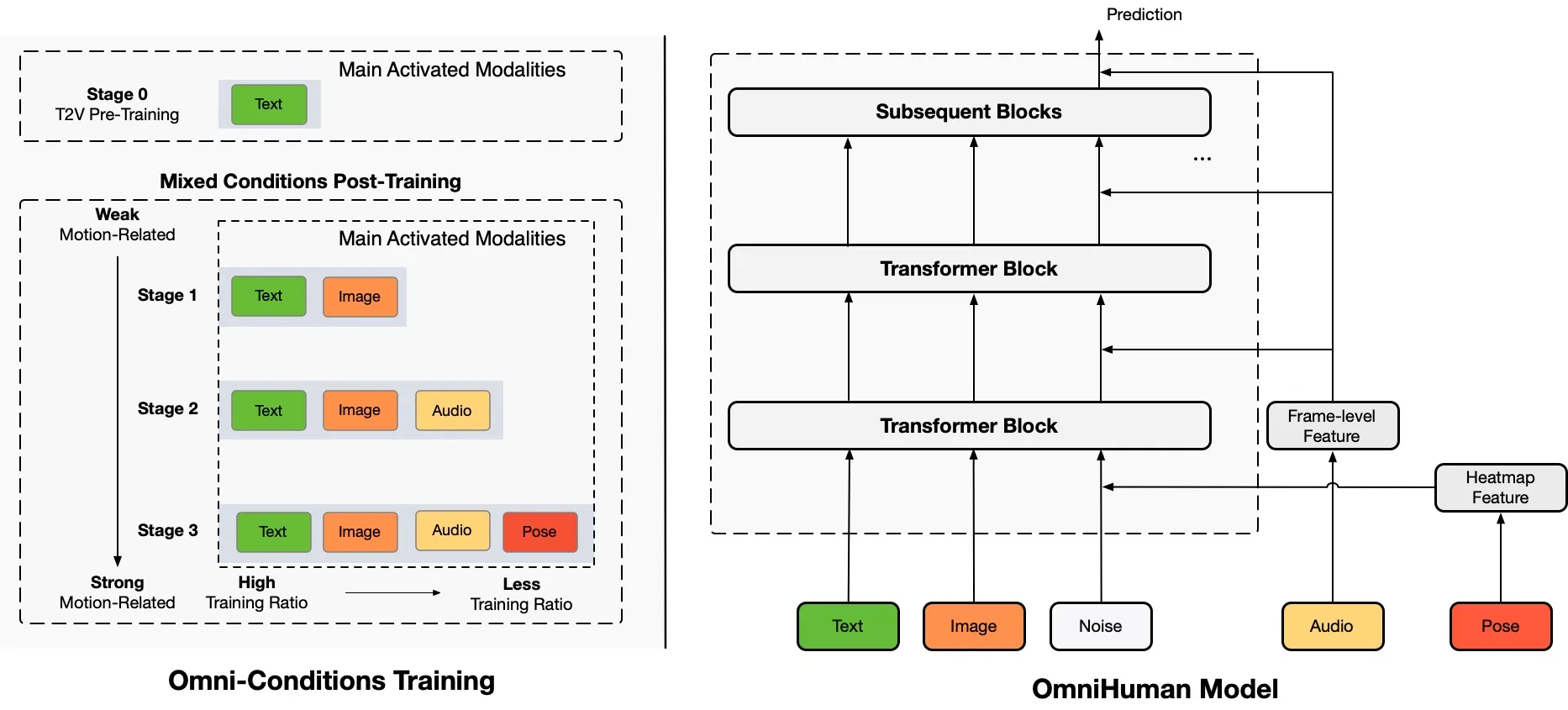

OmniHuman框架通過在訓練階段將與運動相關的條件混合,來擴展數據規模,這一框架的核心在于其能夠處理多種輸入模態,從而生成更加真實和自然的數字人視頻。

OmniHuman關鍵特性

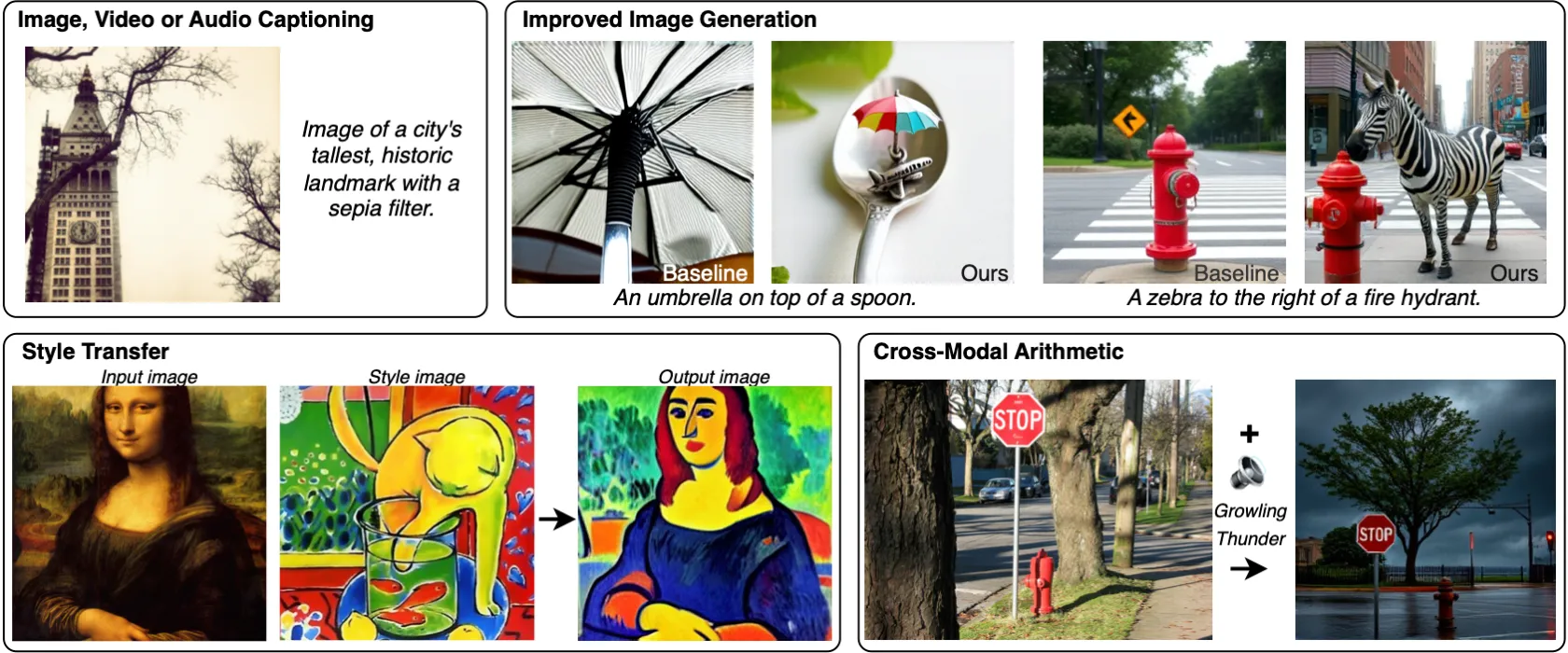

多模態輸入:OmniHuman支持多種輸入形式,包括文本、音頻和視頻,使得生成的數字人能夠在不同場景中表現出更豐富的情感和動作,融合不同模態數據,突破高質量數據稀缺的瓶頸。

擴展數據規模:通過引入運動相關的條件,OmniHuman能夠在訓練過程中有效擴展數據集,從而提高生成模型的泛化能力和表現力。

高質量輸出:該框架利用先進的深度學習技術,能夠生成高質量的數字人視頻,不僅支持真人,也支持3D人物和動漫人物,適用于直播、娛樂和教育等多個領域。

實時生成:OmniHuman還具備實時生成的能力,使得用戶可以在互動場景中即時獲得數字人的反饋和表現。

OmniHuman還支持多種驅動模式,包括音頻驅動、視頻驅動和組合驅動信號,使用戶在輸入方面擁有更大的靈活性。此外,OmniHuman能夠處理人體與物體的互動和具有挑戰性的身體姿勢,進一步增強了生成視頻的真實感和表現力。OmniHuman框架的設計理念是充分利用數據驅動的動作生成,最終實現高度逼真的人類視頻生成。與現有的端到端音頻驅動方法相比,OmniHuman不僅能夠產生更逼真的視頻,還能在輸入方面提供更大的靈活性。視頻樣本可在ttfamily項目頁面上找到,展示了其在不同場景下的應用效果。

OmniHuman應用場景

虛擬主播:在直播平臺上,OmniHuman可以生成虛擬主播,提供實時互動和娛樂內容。

教育培訓:通過生成虛擬教師,OmniHuman可以在在線教育中提供個性化的學習體驗。

游戲開發:在游戲中,虛擬角色可以通過OmniHuman生成,提升游戲的沉浸感和互動性。

OmniHuman項目地址:https://omnihuman-lab.github.io

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI