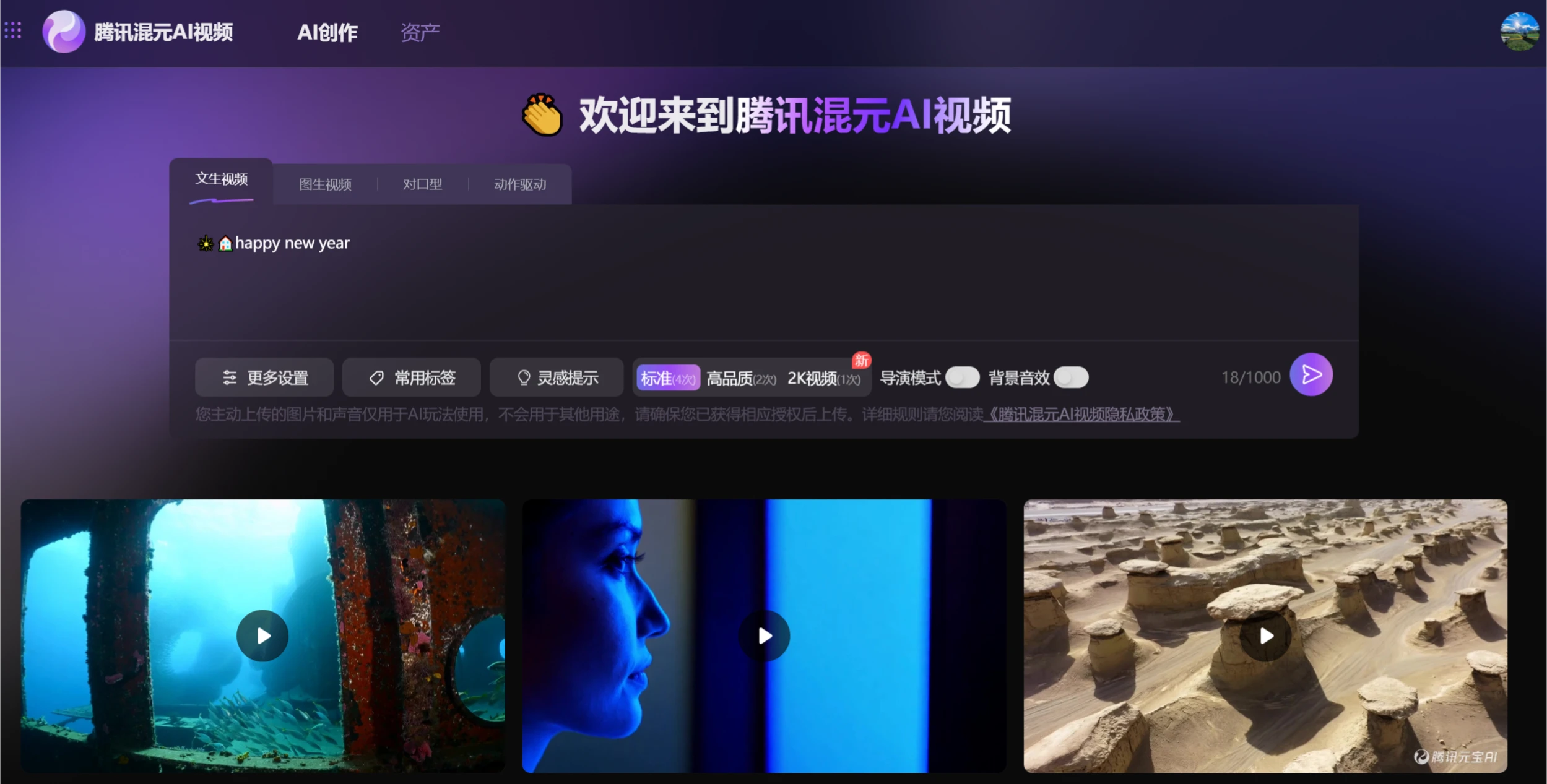

HunyuanVideo-I2V:騰訊混元開源的圖像轉(zhuǎn)視頻生成框架

HunyuanVideo-I2V 是什么?

HunyuanVideo-I2V是騰訊混元團(tuán)隊(duì)于2025年3月6日開源的全新圖生視頻框架。該框架基于之前開源的HunyuanVideo,進(jìn)一步擴(kuò)展了圖像到視頻生成的能力,視頻創(chuàng)作者可以從單張圖片生成高質(zhì)量的短視頻,并支持定制化特效訓(xùn)練。

HunyuanVideo-I2V功能特點(diǎn)

圖生視頻:HunyuanVideo-I2V 可以將靜態(tài)圖像作為視頻的第一幀,根據(jù)用戶輸入的字幕或描述生成匹配的視頻內(nèi)容。

多模態(tài)大語言模型(MLLM):該模型采用預(yù)訓(xùn)練的多模態(tài)大語言模型作為文本編碼器,顯著增強(qiáng)了對輸入圖像語義內(nèi)容的理解能力。

3D變分自編碼器(3D VAE):使用CausalConv3D技術(shù)訓(xùn)練的3D VAE,將像素空間中的視頻和圖像壓縮到緊湊的潛在空間,減少后續(xù)模型中的token數(shù)量。

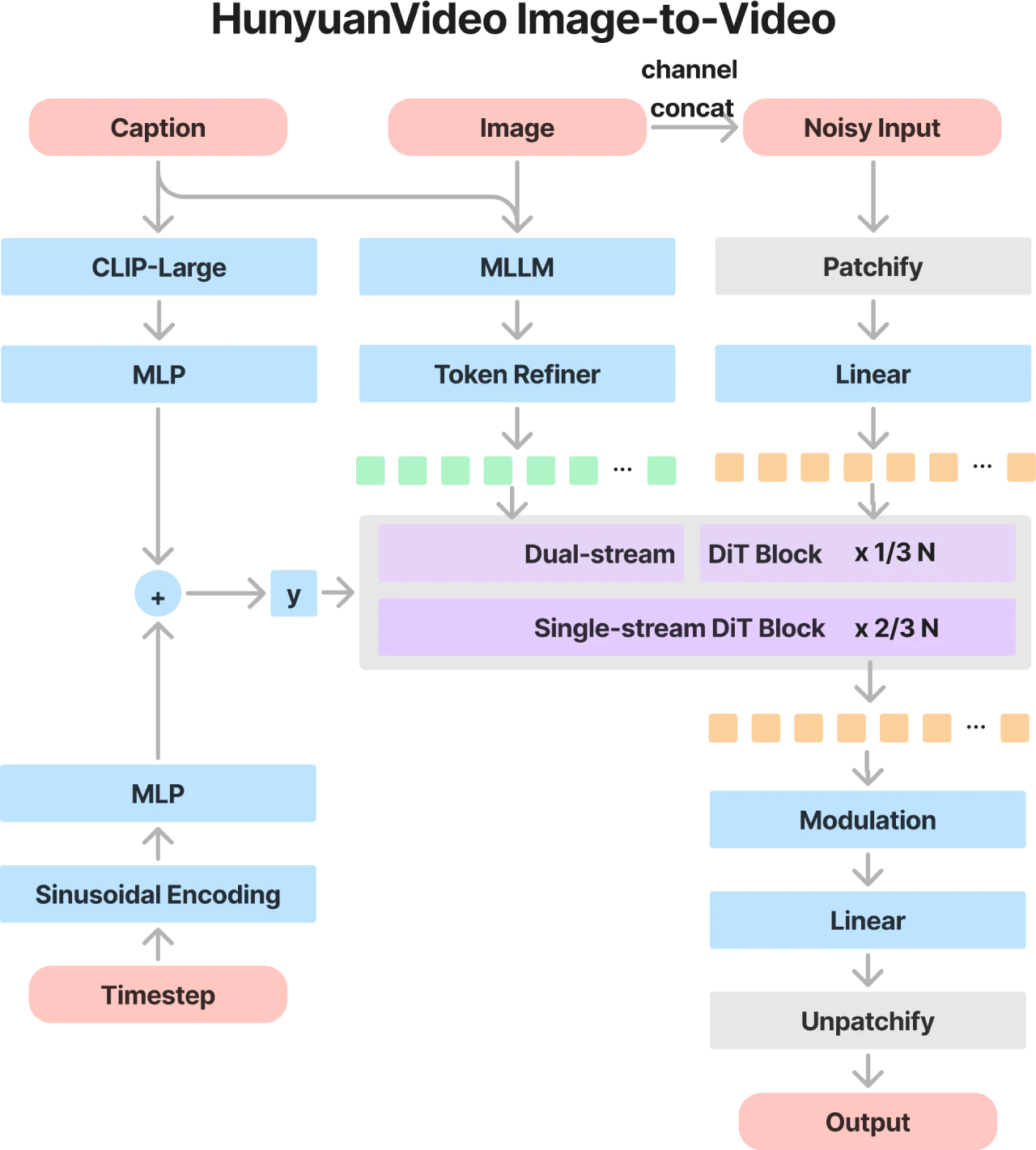

雙流轉(zhuǎn)單流的混合模型設(shè)計(jì):在雙流階段,視頻和文本token通過多個(gè)Transformer塊獨(dú)立處理;在單流階段,將視頻和文本token連接起來,進(jìn)行多模態(tài)信息融合。

漸進(jìn)式訓(xùn)練策略:從低分辨率、短視頻逐步過渡到高分辨率、長視頻,提高模型的收斂速度。

提示詞重寫模型:解決用戶提示詞的語言風(fēng)格和長度多變性問題,將用戶輸入的提示詞轉(zhuǎn)換為模型更易理解的格式。

可定制化LoRA訓(xùn)練:支持通過少量數(shù)據(jù)訓(xùn)練出具有特定效果的視頻生成模型,例如“頭發(fā)生長”或“人物動作”等特效。

高效推理:提供單GPU推理和多GPU序列并行推理,支持更快的推理速度。

HunyuanVideo-I2V技術(shù)架構(gòu)

HunyuanVideo-I2V在整體架構(gòu)上延續(xù)了HunyuanVideo的設(shè)計(jì)思路,并在此基礎(chǔ)上針對圖像到視頻生成任務(wù)進(jìn)行了優(yōu)化。其核心在于利用圖像隱空間拼接技術(shù),將參考圖片的關(guān)鍵信息注入到視頻生成流程中,同時(shí)通過MLLM實(shí)現(xiàn)文本和圖像信息的跨模態(tài)深度融合。

HunyuanVideo-I2V使用方法

1. 安裝與依賴

安裝PyTorch和其他依賴項(xiàng),具體安裝指南可在GitHub頁面找到。

推薦使用NVIDIA GPU,至少需要80GB的顯存。

2. 下載預(yù)訓(xùn)練模型

預(yù)訓(xùn)練模型權(quán)重可在GitHub頁面或Hugging Face頁面下載。

3. 推理代碼

使用提供的推理代碼(如sample_video.py)生成視頻。

4. LoRA訓(xùn)練

提供LoRA訓(xùn)練代碼,用戶可以通過少量數(shù)據(jù)訓(xùn)練出具有特定效果的視頻生成模型。

HunyuanVideo-I2V應(yīng)用場景

視頻內(nèi)容創(chuàng)作:為視頻創(chuàng)作者提供高效、高質(zhì)量的視頻生成工具。

影視制作:生成影視級視頻內(nèi)容。

個(gè)性化視頻:根據(jù)用戶上傳的圖片和描述生成個(gè)性化視頻。

官網(wǎng):https://video.hunyuan.tencent.com/

GitHub:https://github.com/Tencent/HunyuanVideo-I2V

Hugging Face:https://huggingface.co/tencent/HunyuanVideo-I2V

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI