Being-M0:具備數據、模型協同特性的人形機器人通用動作生成框架

北京大學和中國人民大學的研究團隊在人形機器人動作生成方面取得了重要進展。他們開發了一個名為 Being-M0 的通用動作生成框架,并創建了首個規模達百萬級的動作生成數據集 MotionLib。這個數據集通過創新的數據處理流程和詳細的標注方法,提取出高質量的動作數據,支持多種數據形式。研究結果表明,利用大量數據和強大模型可以有效提升動作生成效果。團隊還提出了 MotionBook 這種新的動作編碼方法,進一步優化了動作生成效果。此外,他們通過結合優化和學習的方法,將人體動作高效地應用到多種人形機器人上,為人形機器人的發展提供了有力支持。

數據集 MotionLib

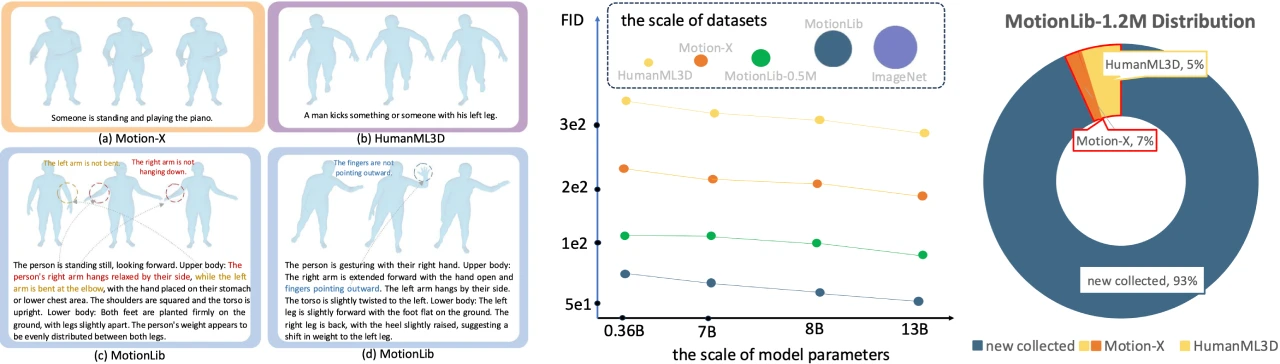

規模與標注:MotionLib 是業界首個百萬規模的動作生成數據集,包含超過120萬段動作序列,并配有分層且詳細的文本標注。該數據集通過系統性地從公開數據集和在線平臺收集超過2000萬段人體動作視頻,并開發了一套創新的數據處理流水線。

數據優化:為提升數據質量,團隊使用預訓練模型進行2D人體關鍵點估計,并通過置信度閾值篩選,再利用先進模型生成高精度3D關鍵點數據。此外,還訓練了基于強化學習的策略來優化原始動作,使其更符合物理規律。

動作編碼方法 MotionBook

二維無查找量化:提出 MotionBook,將動作序列建模為單通道二維“動作圖像”,分別在時間軸和關節軸構建獨立編碼空間,完整保留運動的多維結構特征。這種方法顯著擴展了動作編碼器的容量,無需查找對應token,提升了動作表示的效率。

模型 Being-M0

性能與規模效應:基于 MotionLib 和 MotionBook,Being-M0 展現了顯著的規模效應,驗證了“大數據+大模型”在動作生成領域的技術可行性。在同等數據條件下,模型容量與生成質量呈顯著正相關,13B參數的LLaMA-2模型相較700M參數的GPT2,在動作多樣性和語義對齊精度等核心指標上均實現突破。

跨平臺動作遷移:創新融合優化與學習方法,實現了動作數據向多款人形機器人的高效遷移,顯著提升了跨平臺運動適配能力。

項目鏈接

項目地址:https://beingbeyond.github.io/Being-M0/

論文鏈接:https://arxiv.org/abs/2410.03311

Github:https://github.com/BeingBeyond/Being-M0

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI