MILS:Meta發布的無需訓練就能讓LLM獲得多模態能力的方法

MILS(Meta Interpretive Learning System),Meta發布的無需訓練就能讓LLM獲得多模態能力的開源ai模型,與傳統的訓練方法不同,MILS旨在無需額外的特定任務訓練就能賦予大型語言模型(LLMs)處理視覺和聽覺任務的能力,它能看懂圖片視頻、聽懂聲音,零樣本學習。

MILS結合了深度學習和解釋性學習的優勢,能夠在多種任務中表現出色,尤其是在需要理解和推理的復雜場景中。

MILS主要有兩個模塊,一個生成器,負責生成候選方案; 一個評分器,用于評估生成器生成候選方案的質量,通過迭代過程在無額外訓練的情況下實現多模態任務的解決。

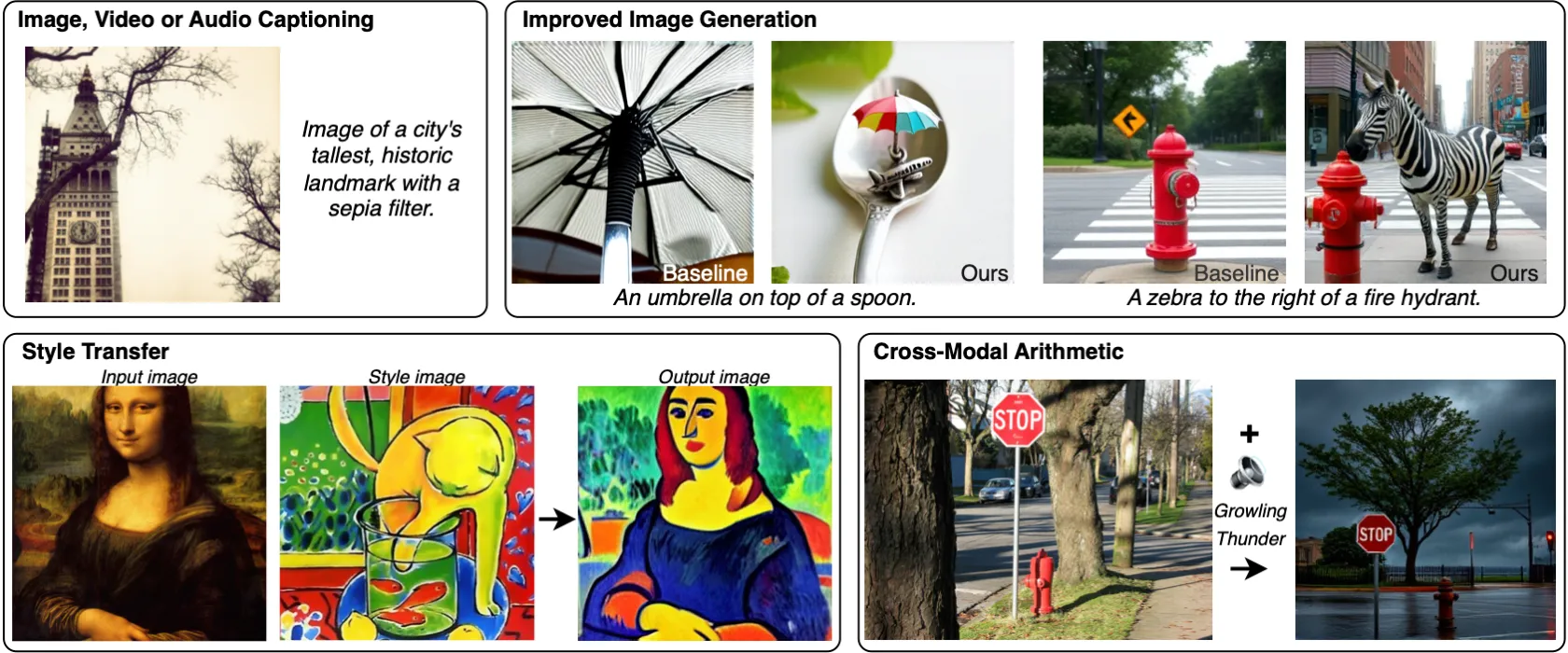

MILS的特點包括支持多種語言和多模態輸入,能夠處理文本、圖像和音頻數據,MILS可用于多種多模態任務,像圖像/視頻/音頻描述、圖像生成增強、風格遷移等。

MILS關鍵特點與工作原理

零樣本生成:MILS的核心在于其零樣本學習能力,意味著模型能夠在沒有直接針對特定模態任務進行訓練的情況下,解決多模態問題。它通過迭代反饋機制,逐步改進生成的輸出,從而達到高質量的多模態描述或生成。

迭代反饋循環:在生成過程中,MILS首先讓語言模型基于文本提示生成一個初步的多模態輸出(如圖像描述)。然后,這個輸出被用作輸入,模型再次嘗試生成或優化,通過不斷的自我反饋和修正,最終達到滿意的解決方案。

利用預訓練模型的潛力:MILS依賴于大型語言模型的預訓練知識,這些模型已經學習了大量的文本數據,從而能夠理解復雜的語義和上下文。通過這種方式,MILS能夠利用這些模型的內在能力,跨越到理解和生成圖像、聲音等非文本數據。

論文:https://arxiv.org/pdf/2501.18096

Github:https://github.com/facebookresearch/MILS

相關文章

- 用戶登錄

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺