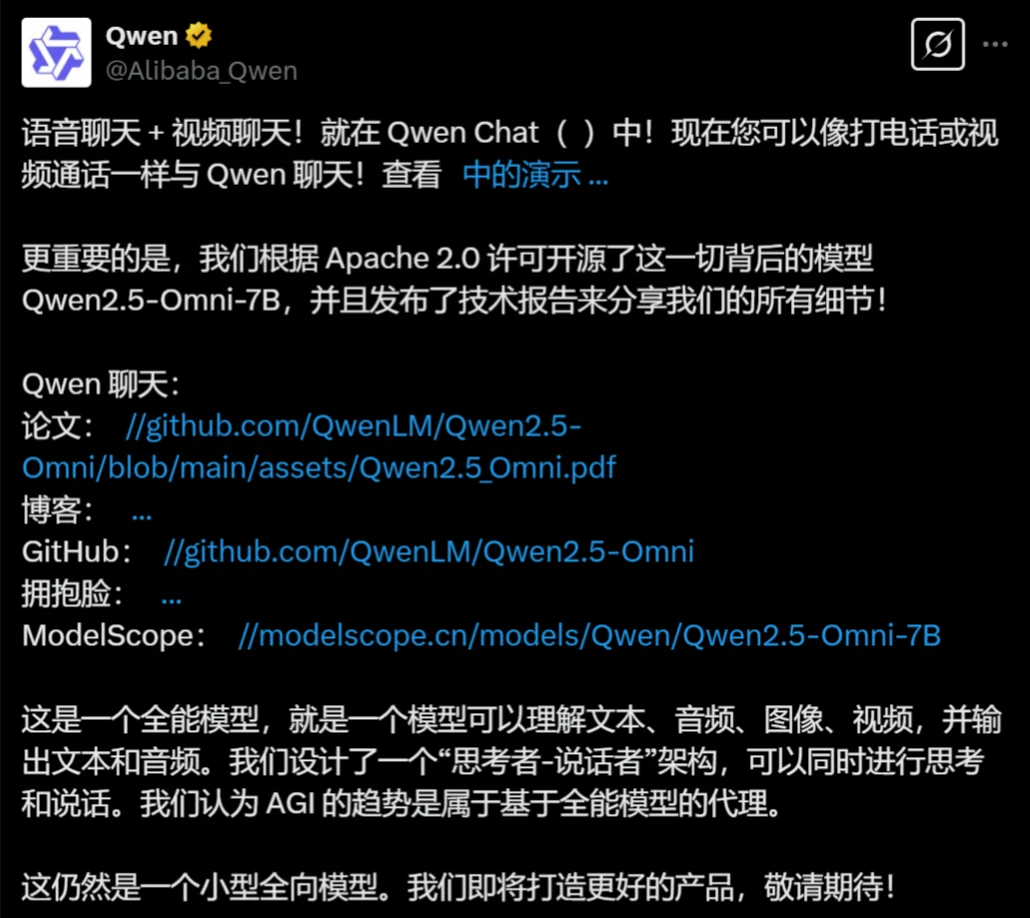

Qwen2.5-Omni:阿里巴巴發布的端到端全能多模態旗艦模型

Qwen2.5-Omni是什么?

Qwen2.5-Omni 是阿里巴巴發布的Qwen 系列中的新一代端到端多模態旗艦模型。它專為全方位多模態感知設計,也就是可以理解文本、音頻、圖像、視頻,可以同時進行思考和說話,并通過實時流式響應同時生成文本與自然語音合成輸出的一個ai模型。

Qwen2.5-Omni核心特點

創新架構:

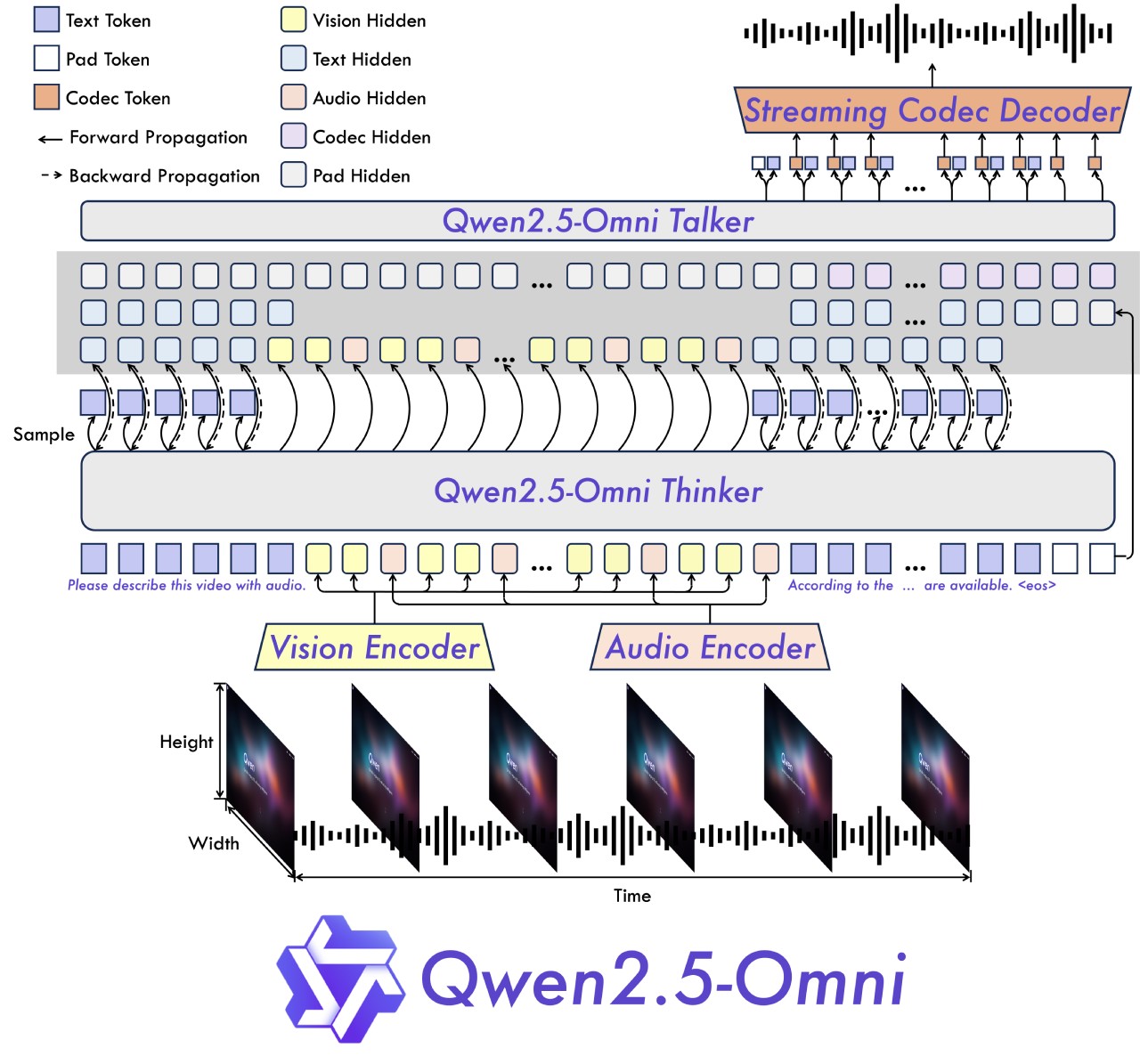

Thinker-Talker 架構:Thinker 負責處理和理解來自文本、音頻和視頻模態的輸入,生成高級語義表征和對應的文本內容;Talker 則將這些內容轉化為自然語音輸出。

TMRoPE 技術:提出了一種名為 TMRoPE(Time-aligned Multimodal RoPE)的新型位置編碼技術,用于同步視頻輸入與音頻的時間戳。

實時交互:

支持完全實時交互,能夠處理分塊輸入并即時輸出。

自然流暢的語音生成:

在語音生成的自然性和穩定性方面超越了許多現有的流式和非流式替代方案。

全模態性能優勢:

在多模態任務(如 OmniBench)中表現出色,同時在單模態任務(如語音識別、翻譯、音頻理解、圖像推理、視頻理解等)中也表現出色。

端到端語音指令跟隨能力:

在端到端語音指令跟隨方面表現出與文本輸入處理相媲美的效果,在 MMLU 和 GSM8K 等基準測試中表現優異。

Qwen2.5-Omni架構設計

Thinker:類似于大腦,負責處理和理解來自文本、音頻和視頻模態的輸入,生成高級語義表征和對應的文本內容。

Talker:類似于人類的嘴巴,接收 Thinker 生成的高級語義表征和文本內容,并以流式方式輸出自然語音。

整體架構:Thinker 是一個 Transformer 解碼器,配備用于音頻和圖像的編碼器以提取信息。Talker 是一個雙軌自回歸 Transformer 解碼器架構。在訓練和推理過程中,Talker 直接接收來自 Thinker 的高維表征,并共享 Thinker 的所有歷史上下文信息,整個架構作為一個統一的模型進行端到端訓練和推理。

Qwen2.5-Omni性能表現

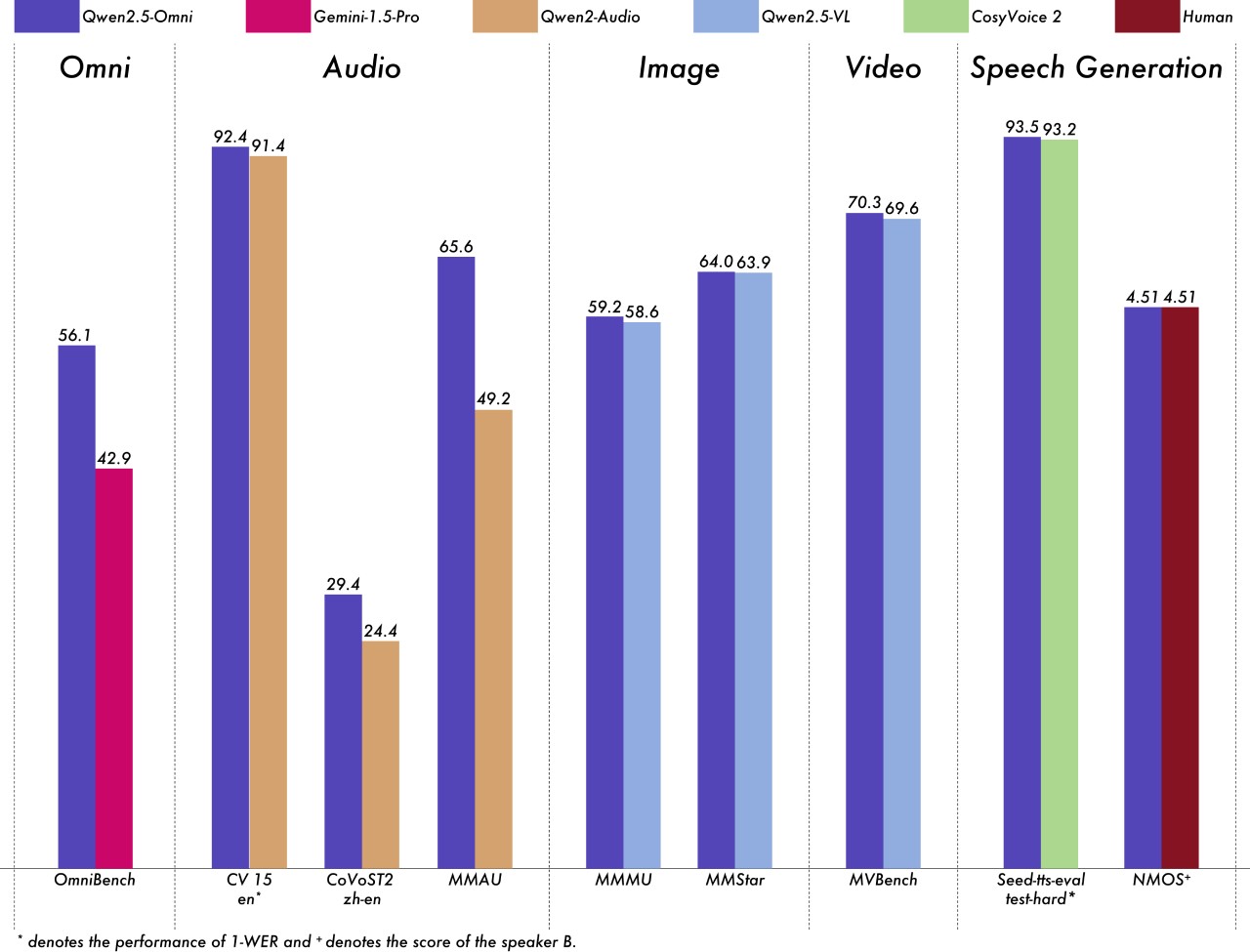

在多模態任務(如 OmniBench)中,Qwen2.5-Omni 實現了最先進的性能。

在單模態任務中,它在語音識別(Common Voice)、翻譯(CoVoST2)、音頻理解(MMAU)、圖像推理(MMMU、MMStar)、視頻理解(MVBench)和語音生成(Seed-tts-eval 和主觀自然性)等方面表現出色。

相關鏈接

Qwen Chat:https://chat.qwenlm.ai

Hugging Face:https://huggingface.co/Qwen/Qwen2.5-Omni-7B

ModelScope:https://modelscope.cn/models/Qwen/Qwen2.5-Omni-7B

DashScope:https://help.aliyun.com/zh/model-studio/user-guide/qwen-omni

GitHub:https://github.com/QwenLM/Qwen2.5-Omni

Demo體驗:https://modelscope.cn/studios/Qwen/Qwen2.5-Omni-Demo

相關文章

- 用戶登錄

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺