MoshiVis:一款能聽還能看,并用流暢的語音跟你討論圖像內容的視覺語音模型

MoshiVis是什么?

MoshiVis 是一個在Moshi基礎上開發的一款視覺語音模型,并保持了Moshi的低延遲和自然對話能力,能夠以自然對話風格討論圖像內容。支持多輪對話,可以描述圖片的文字內容并回答有關于圖片的問題。

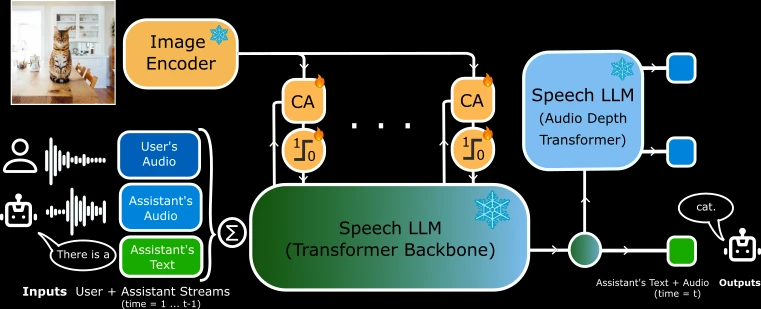

它通過交叉注意力機制將視覺信息融入語音流,同時保持低延遲和低內存占用。MoshiVis 提供了多種后端支持(如 PyTorch、Rust、MLX),并發布了預訓練模型和合成視覺對話數據集,適用于實時語音交互場景。

MoshiVis核心功能

視覺與語音結合:MoshiVis 在 Moshi 的基礎上增加了視覺理解能力,能夠將圖像信息融入語音對話中。通過擴展核心 Transformer 架構,引入交叉注意力機制,將視覺信息注入語音流中。

低延遲與低內存占用:為了保持低延遲并減少內存使用,MoshiVis 的交叉注意力投影權重在各層之間共享,并通過門控機制調節視覺輸入流。

自然對話風格:模型在融入視覺能力的同時,保留了 Moshi 原有的自然對話風格。

MoshiVis技術架構

基礎模型:基于 Moshi,一個 7B 參數的語音-文本基礎模型。

視覺編碼器:使用 PaliGemma2 家族的預訓練凍結 400M 視覺編碼器。

適配器參數:在 Moshi 基礎上增加了約 206M 的適配器參數,用于視覺信息的處理。

交叉注意力機制:通過交叉注意力模塊將視覺信息注入語音流,同時通過門控機制調節視覺輸入的影響。

MoshiVis模型發布

模型變體:發布了基于 Moshika(女聲)的 MoshiVis 模型,包含完整的模型權重,包括語音編解碼器、文本分詞器、圖像編碼器和基礎 Moshi 模型。

后端支持:提供了三種后端支持,包括 PyTorch、Rust 和 MLX,支持不同的量化格式(如 BF16、Q8_0 等)。

許可證:模型權重(不包括視覺編碼器)在 CC-BY 4.0 許可下發布,視覺編碼器在 Gemma 許可下發布。

MoshiVis使用方式

WebUI 前端:提供了 WebUI 前端,支持回聲消除,提升模型表現。用戶可以通過預構建的靜態版本或自行編譯源代碼來使用。

后端運行:

PyTorch:需要約 24GB GPU 內存,不支持量化。

Rust:支持 GPU 加速,需要 Rust 工具鏈和 CUDA(或 macOS 上的 Metal)。

MLX:支持 bfloat16 和量化(q4、q8)格式。

運行命令:提供了詳細的運行命令,用戶可以根據需要選擇不同的后端和量化格式。

相關鏈接:

GitHub項目:https://github.com/kyutai-labs/moshivis

HuggingFace模型:https://huggingface.co/collections/kyutai/moshivis-v01-67cef4acae6a5d75d6d6c883

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺