阿里推出QwenLong-L1-32B:一款用于長上下文推理的LLM

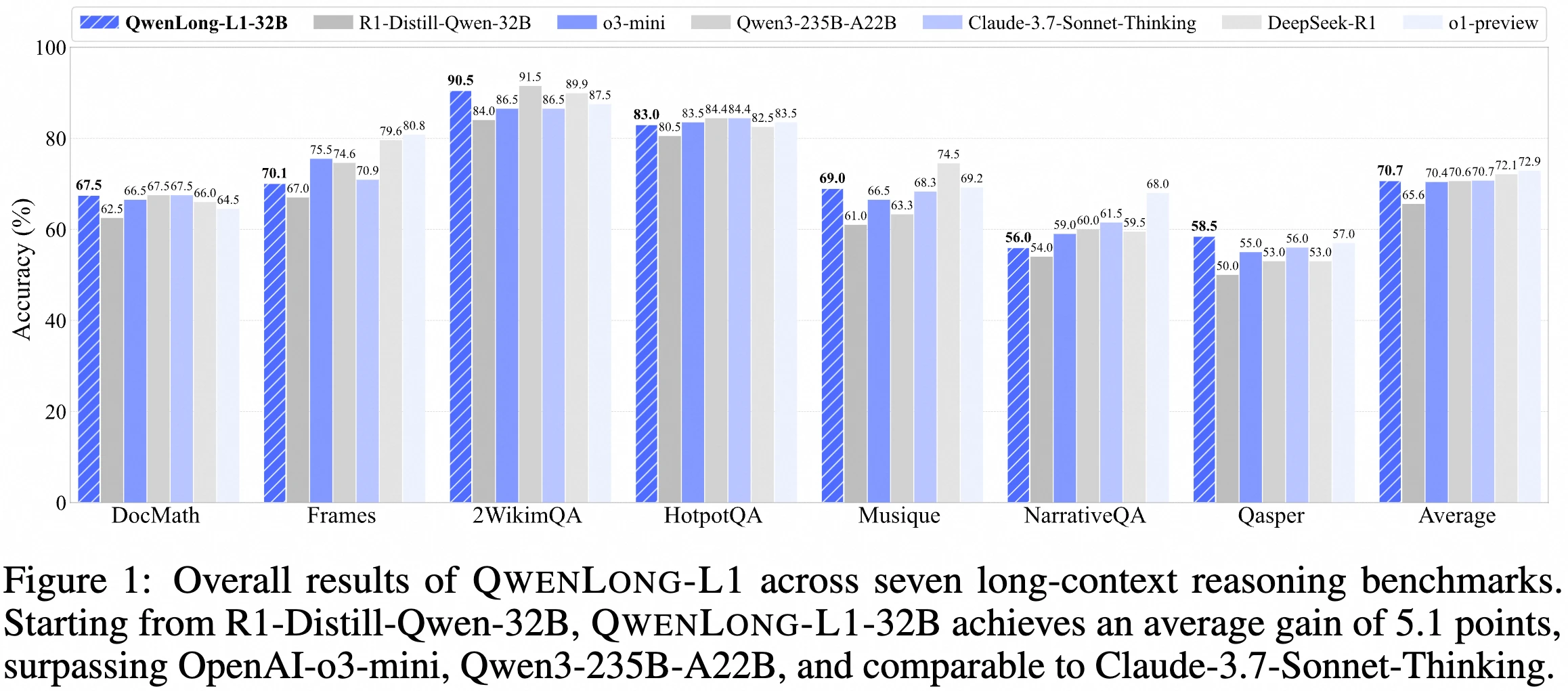

2025年5月26日,阿里巴巴團隊發(fā)布QwenLong-L1-32B,首個基于強化學習訓練的長上下文大推理模型,和DocQA-RL-1.6K數(shù)據(jù)集(含1600個數(shù)學、邏輯、多跳推理類文檔問答問題)。其框架通過預熱監(jiān)督微調(diào)、課程引導強化學習、難度感知回顧采樣機制解決長上下文推理強化學習中訓練效率低、優(yōu)化過程不穩(wěn)定的挑戰(zhàn),在7個長上下文DocQA基準測試中性能優(yōu)于Openai-o3-mini和Qwen3-235B-A22B,與Claude-3.7-Sonnet-Thinking持平。

模型框架

核心理念:通過強化學習(RL)將短上下文大規(guī)模推理模型(LRMs)適應到長上下文場景中。

主要組成部分:

預熱監(jiān)督微調(diào)(SFT)階段:建立穩(wěn)健的初始策略。

基于課程的分階段強化學習技術(shù):穩(wěn)定策略演化。

難度感知回顧采樣策略:激勵策略探索。

訓練數(shù)據(jù)

使用了名為DocQA-RL-1.6K的專門強化學習訓練數(shù)據(jù)集,包含1600個涵蓋數(shù)學、邏輯和多跳推理領域的文檔問答問題。

性能表現(xiàn)

在七個長上下文文檔問答基準測試中,QwenLong-L1-32B的表現(xiàn)超過了OpenAI-o3-mini和Qwen3-235B-A22B等旗艦級LRMs,達到了與Claude-3.7-Sonnet-Thinking相當?shù)乃剑诋斍白钕冗M的LRMs中表現(xiàn)出領先性能。

實驗設計

構(gòu)建了一個專門的RL訓練數(shù)據(jù)集DocQA-RL-1.6K,包含1600個文檔問答問題,涵蓋數(shù)學、邏輯和多跳推理領域。

數(shù)學推理部分使用了DocMath數(shù)據(jù)集的600個問題,其中75%用于訓練,25%用于評估。

邏輯推理部分通過DeepSeek-R1合成了600個多選題,涵蓋法律、金融、保險和生產(chǎn)領域的實際文檔。

多跳推理部分從MultiHopRAG和Musique中各采樣200個例子,強調(diào)跨文檔推理。

在七個長上下文DocQA基準測試上進行了評估,包括2WikiMultihopQA、HotpotQA、Musique、NarrativeQA、Qasper、Frames和DocMath。

結(jié)果與分析

QwenLong-L1-32B在七個長上下文DocQA基準測試中表現(xiàn)優(yōu)異,超過了OpenAI-o3-mini和Qwen3-235B-A22B等旗艦LRM模型,性能與Claude-3.7-Sonnet-Thinking相當。

在數(shù)學推理基準DocMath上,QwenLong-L1-32B的精確匹配和LLM判斷準確率達到了85.3%。

在多跳推理基準HotpotQA上,模型的表現(xiàn)達到了87.6%,顯著優(yōu)于現(xiàn)有模型。

項目鏈接

Github:https://github.com/Tongyi-Zhiwen/QwenLong-L1

Huggingface:https://huggingface.co/Tongyi-Zhiwen/QwenLong-L1-32B

Modelscope:https://www.modelscope.cn/models/iic/QwenLong-L1-32B

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺