阿里開源了其最新推理模型:QwQ-32B,可媲美DeepSeek-R1

2025年3月6日凌晨,阿里巴巴正式對外發(fā)布并開源了他們最新的推理模型——通義千問QwQ - 32B。

通義千問QwQ - 32B是用大規(guī)模強化學習訓練出來的。和以往的預訓練、后訓練方法不一樣,強化學習能讓模型在和環(huán)境互動的過程中去學習知識。就因為這樣,它在數(shù)學推理、編程還有通用能力這些方面都特別出色,推理能力也能得到更有效的提升。

另外,這個模型里面還加入了和Agent有關(guān)的能力。有了這個能力,模型在使用工具的時候,就能夠進行批判性思考,還能根據(jù)環(huán)境給出的反饋,隨時調(diào)整推理的過程 。

通義千問QwQ-32B模型概述

通義千問QwQ - 32B是一款推理模型,有320億個參數(shù)。雖然它的參數(shù)量比DeepSeek - R1(有6710億參數(shù),其中370億被激活)少很多,但性能卻能和DeepSeek - R1滿血版相媲美。

這個模型采用Apache 2.0開源協(xié)議,用戶能免費下載,還能用于商業(yè)用途。模型開源平臺有兩個,分別是Hugging Face(https://huggingface.co/Qwen/QwQ - 32B )和ModelScope(https://modelscope.cn/models/Qwen/QwQ - 32B )。

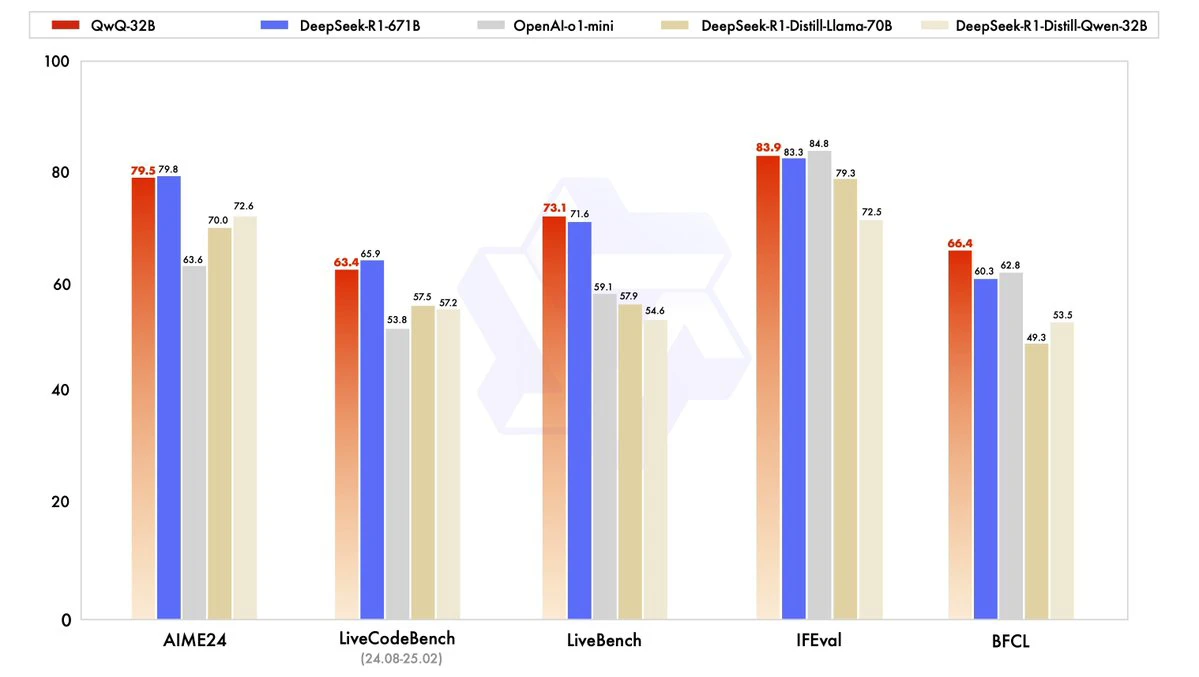

通義千問QwQ-32B模型性能

性能表現(xiàn)突出:在數(shù)學推理、編程以及通用能力方面,QwQ - 32B都相當厲害。在aiME24評測集和LiveCodeBench測試里,它的表現(xiàn)和DeepSeek - R1差不多,比其他同尺寸的模型都要好。

強化學習與智能體助力:QwQ - 32B通過大規(guī)模強化學習,推理能力有了很大提升,能夠深入思考和處理復雜問題。而且模型里集成了智能體能力,在使用工具的時候,它能進行批判性思考,還會根據(jù)環(huán)境反饋來調(diào)整推理過程。

多領(lǐng)域都能適應:QwQ - 32B在數(shù)學、編程和通用任務處理上表現(xiàn)都很出色,還支持多模態(tài)任務,像語音轉(zhuǎn)寫、圖像識別這些都不在話下。在LiveBench、IFEval和BFCL等基準測試中,它的得分超過了DeepSeek - R1 。另外,它對硬件資源需求不高,消費級顯卡就能實現(xiàn)本地部署,很適合硬件資源有限的應用場景。

通義千問QwQ-32B模型應用

數(shù)學與邏輯推理:在數(shù)學推理任務,比如AIME24里,QwQ - 32B成績優(yōu)異,在教育和科研領(lǐng)域都能派上用場。

編程與代碼生成:在LiveCodeBench測試中,它能生成高質(zhì)量的代碼,適合軟件開發(fā)和編程教育工作。

通用任務處理:在指令遵循(IFEval)、多模態(tài)任務處理等方面,QwQ - 32B表現(xiàn)卓越,能應對多種通用任務。

智能體相關(guān)任務:因為它支持智能體能力,能進行動態(tài)決策和適應環(huán)境,所以適用于復雜任務的自動化處理 。

HF:https://huggingface.co/Qwen/QwQ-32B

模型:https://modelscope.cn/models/Qwen/QwQ-32B

演示:https://huggingface.co/spaces/Qwen/QwQ-32B-Demo

聊天:https://chat.qwen.ai

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺