阿里Ovis-U1:具備多模態理解、圖像生成、圖像編輯三合一能力

2025年6月29日,阿里巴巴國際ai團隊推出多模態大模型Ovis-U1,屬于Ovis系列最新版本,基于原有架構開發,參數規模為3億。

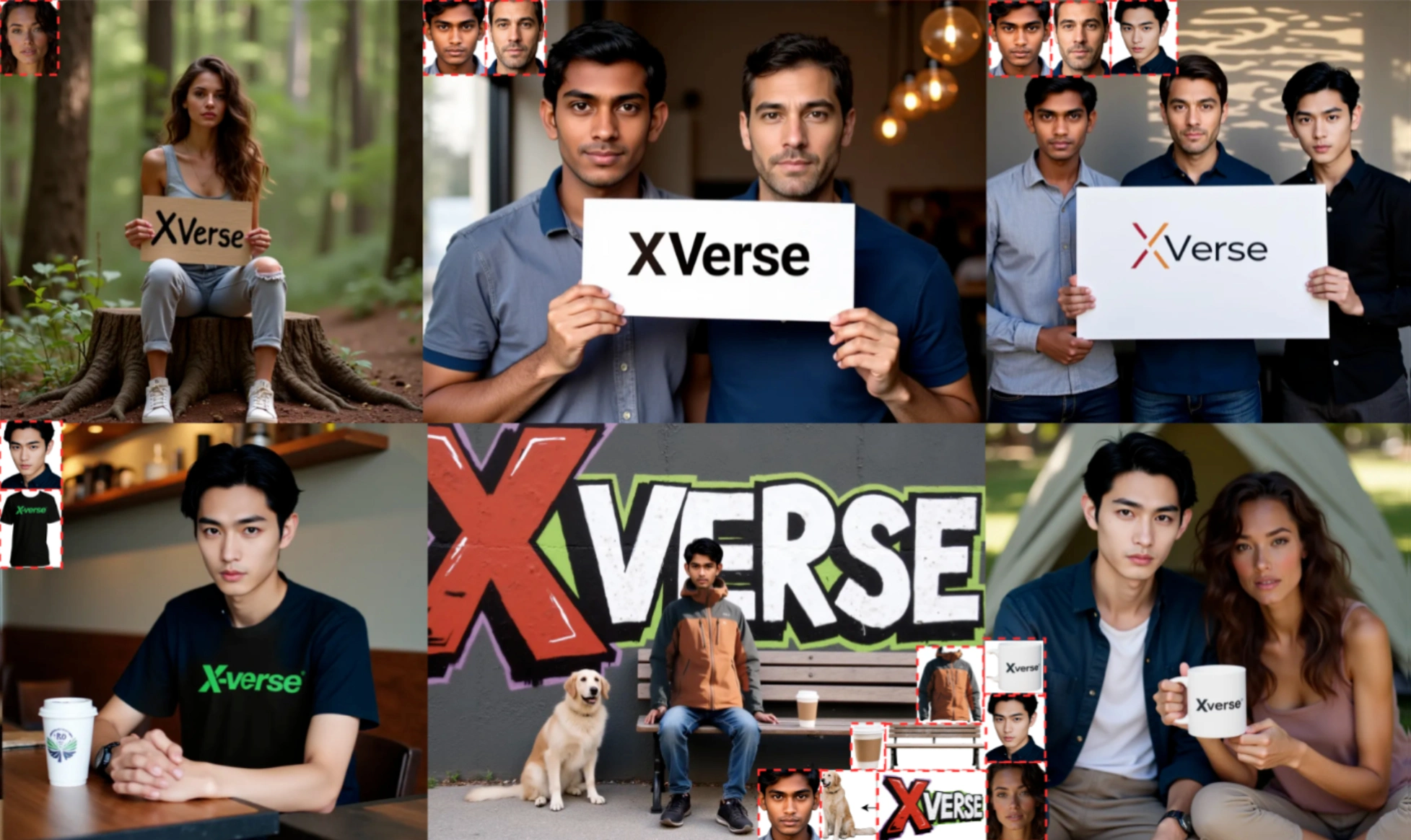

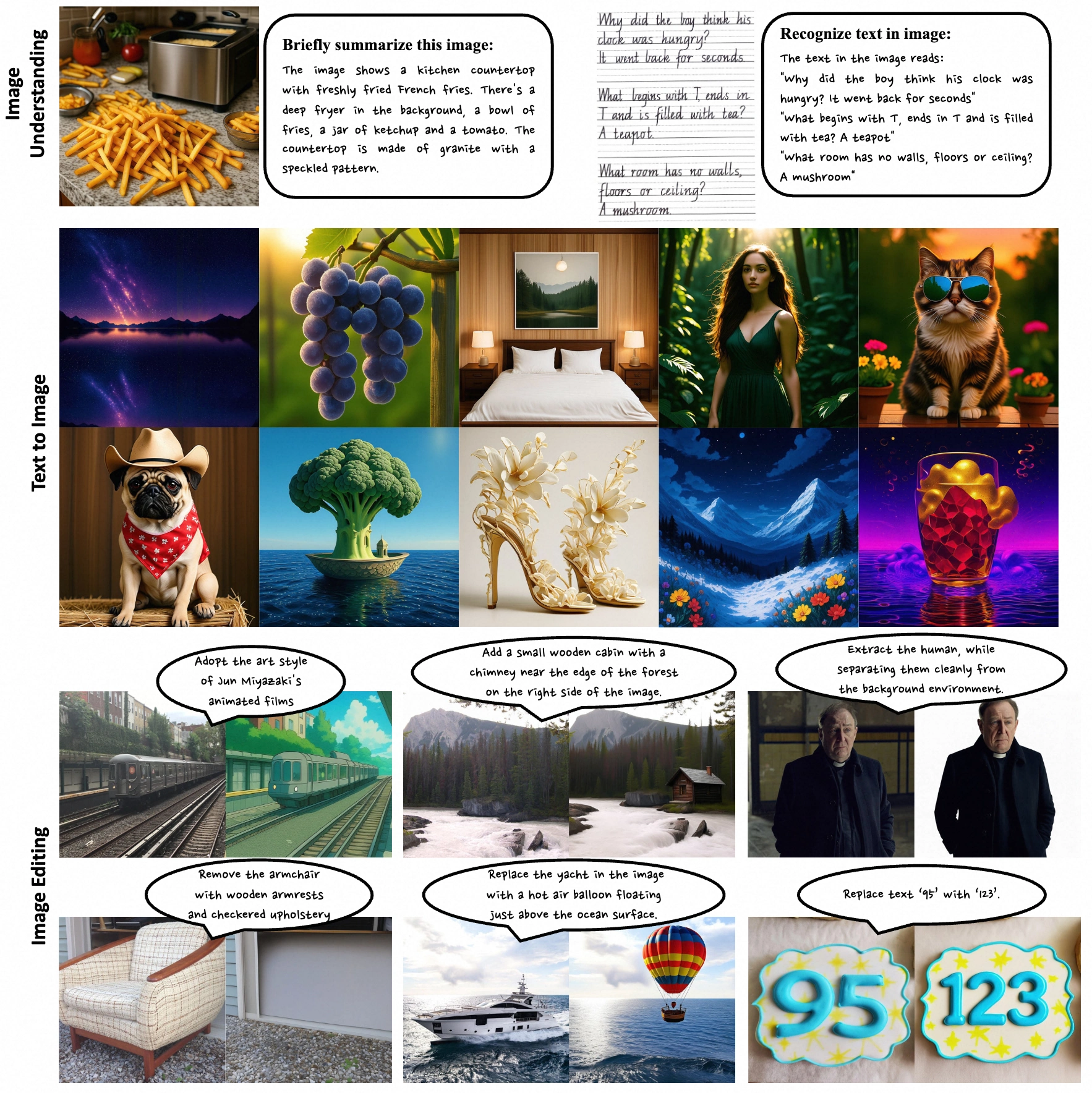

該模型整合了多模態理解、圖像生成和編輯功能,核心組件包括視覺分詞器、視覺嵌入表和大型語言模型。通過優化視覺與文本嵌入的匹配度,解決了傳統多模態模型的部分局限,在復雜場景中表現更好。支持文本、圖像輸入,在數學推理、物體識別等任務中效果突出,既能精準識別圖像中的物體或手寫文字,也能按指令生成或修改圖像。

核心能力

多模態理解:可分析復雜視覺場景與文本內容,回答圖像相關問題,完成視覺問答(VQA)、圖像描述生成等任務。

文本到圖像生成:根據文字描述生成高質量圖像,適配多種風格與復雜場景需求。

圖像編輯:通過文本指令對圖像元素進行添加、調整、替換、刪除等操作,支持風格轉換。

技術架構

視覺解碼器:采用基于擴散的Transformer架構(MMDiT),將文本嵌入轉化為高質量圖像。

雙向令牌細化器:強化文本與視覺嵌入的交互,提升圖像合成與編輯效果。

視覺編碼器:基于預訓練模型(如Aimv2-large-patch14-448)微調,適配多模態任務。

適配器:連接視覺編碼器與多模態大語言模型(MLLM),對齊兩類嵌入數據。

多模態大語言模型:作為核心模塊,處理文本與視覺信息,支持多任務處理。

訓練方法

Ovis-U1通過同步訓練多模態理解、圖像生成和編輯任務,共享知識提升泛化能力。訓練分六個階段逐步優化各任務表現。

數據構成

多模態理解數據:來自COYO、Wukong、Laion等公開數據集及內部開發數據。

圖像生成數據:基于Laion5B、JourneyDB數據集及預訓練模型生成的詳細描述。

圖像編輯數據:涵蓋參考圖像驅動生成、像素級控制等任務的數據。

性能優化

在圖像編輯中通過調整文本與圖像引導系數(CFG)精準控制指令執行。采用OpenCompass、GenEval等基準測試全面評估模型能力。

應用場景

內容創作:輔助藝術家與視頻編輯進行創意構思。

廣告營銷:根據產品與受眾描述生成廣告圖像與海報。

游戲開發:生成游戲場景、角色及道具圖像。

建筑設計:輸出建筑概念圖及室內布置方案。

科學研究:可視化復雜科學現象與實驗場景。

延續Ovis系列開源傳統,模型代碼、權重及訓練數據已通過Apache2.0協議在Hugging Face和GitHub公開,開發者可快速復現部署。

項目地址

GitHub倉庫:https://github.com/AIDC-AI/Ovis-U1

HuggingFace模型庫:https://huggingface.co/AIDC-AI/Ovis-U1-3B

技術論文:https://github.com/AIDC-AI/Ovis-U1/blob/main/docs/Ovis_U1_Report.pdf

在線體驗:https://huggingface.co/spaces/AIDC-AI/Ovis-U1-3B

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺