什么是大模型的蒸餾(distillation),DeepSeek遭遇的“模型蒸餾”指控是怎么回事?

DeepSeek是一家新興的人工智能公司,最近因被指控使用Openai的技術進行模型蒸餾而引發大量關注。OpenAI聲稱,DeepSeek可能通過蒸餾技術提取了其模型的知識,從而開發出競爭對手的產品。

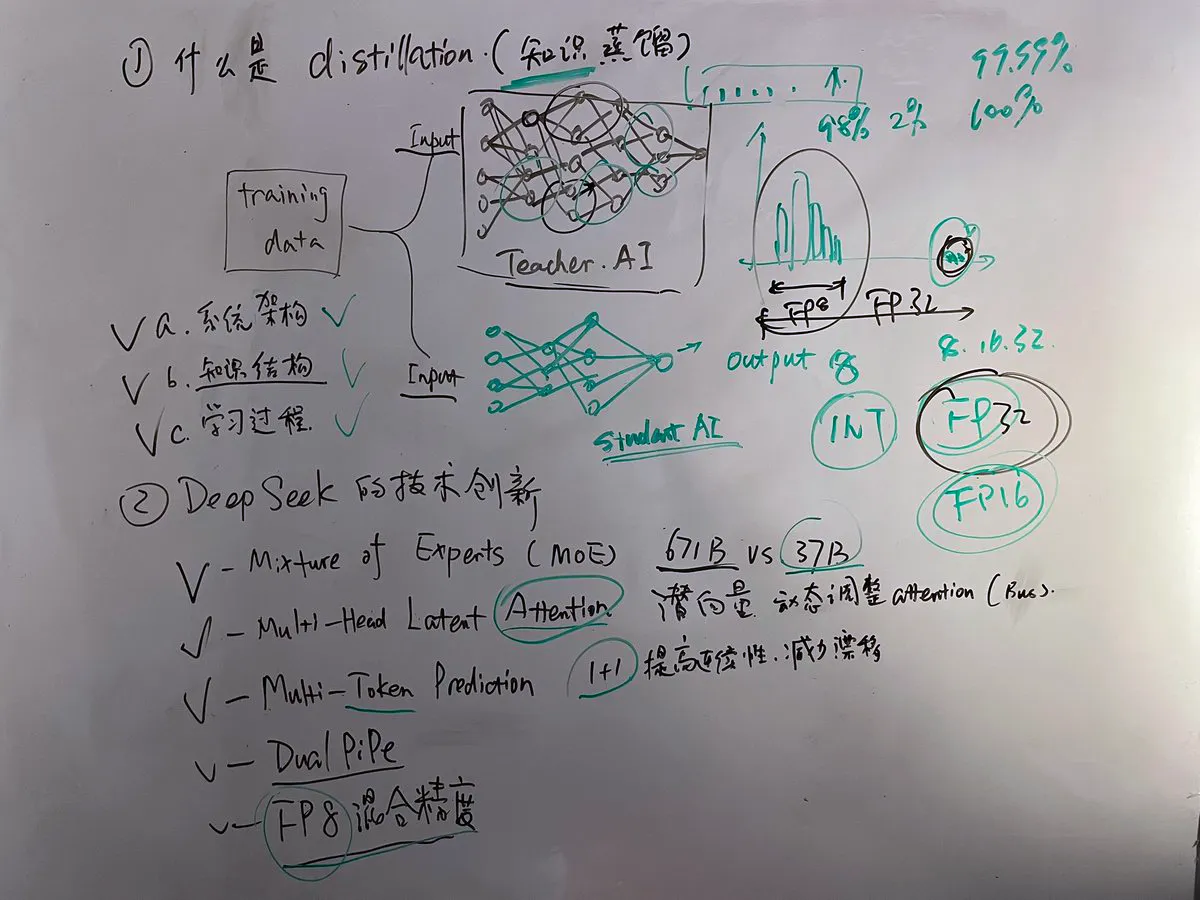

什么是大模型的蒸餾(Distillation)?

大模型的蒸餾是一種模型壓縮技術,旨在將一個大型、復雜的模型(稱為教師模型)的知識轉移到一個較小、更高效的模型(稱為學生模型)中。這一過程通過訓練學生模型,使其能夠模仿教師模型的輸出,從而在保持性能的同時減少計算資源的消耗。

這一概念由Hinton等人在2015年提出,常用于模型壓縮、加速推理和降低部署成本,同時盡量保留原模型的性能。蒸餾技術在深度學習中被廣泛應用,尤其是在自然語言處理和計算機視覺等領域。

下面用一張youtube“Jeff科技視角”Jeff Li的思維導圖體會一下。Jeff Li老師在《第379期:大模型的 蒸餾 (Distillation)及 DeepSeek 遭遇的指控》視頻中講得非常詳細。

大模型的蒸餾實施方式:

軟標簽(Soft Labels): 使用教師模型生成的概率分布而不是硬標簽來進行訓練。

隱藏激活(Hidden Activations): 將教師模型的部分中間層輸出作為輔助信號給學生模型。

注意力權重(Attention Weights): 如果涉及到序列模型,也可以遷移注意機制的相關信息

DeepSeek 遭遇的“模型蒸餾”指控

起因背景:

DeepSeek 是一家初創企業, 提供了自己的大語言模型產品。

DeepSeek的低成本模型開發、開源、免費策略可能威脅到OpenAI 和 Anthropic等公司的市場地位,導致競爭對手對其展開了批評,認為 DeepSeek 不正當使用他們的技術和數據。

關鍵點:

OpenAI 的立場

指責 DeepSeek 抓取并使用了未經許可的數據來訓練自己的模型。

自身存在的問題:OpenAI 自己也被指摘曾非法抓取互聯網上的數據來訓練其模型,尤其是受版權保護的文章作品。此外,OpenAI 曾因為類似行為遭到《紐約時報》等出版方的法律訴訟。

Anthropic 的觀點

反駁嚴重性: Anthropic 認為 DeepSeek 并沒有達到對其產品的真正威脅的程度,稱其技術水平相當于幾個月之前的版本而已。

微軟的態度

微軟在其Azure AI和GitHub平臺上線了 DeepSeek 模型,顯示出某種形式的支持態度,這也引發了關于利益沖突的討論。

模型蒸餾的具體爭議

合法性和規范性:模型蒸餾是一項常見的技術實踐,但在實際操作中有嚴格的規則約束。特別是針對商業用途和技術共享協議的規定,各家公司有不同的解讀和執行力度。

如何界定 "未經授權的方式" 獲取數據?

是否允許使用某些 API 輸出的數據來訓練新的競爭性的模型?

證據和支持材料:目前雙方都沒有完全公開詳細的證據支持各自的主張,這增加了事件的復雜性和不確定性。

行業反應和社會輿論

社區內外對此事的看法不一,有人認為這是市場競爭的一部分表現;但也有很多聲音關注此事背后的倫理和法律規定是否得到了充分尊重。

DeepSeek 遭遇的 “模型蒸餾” 控訴反映了當前 AI 行業中存在的激烈競爭態勢以及圍繞著數據使用權、技術創新邊界等方面的法規模糊地帶帶來的挑戰。

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺