OpenManus-RL:一個提升LLM智能體的推理與決策能力開源項目

OpenManus-RL是什么?

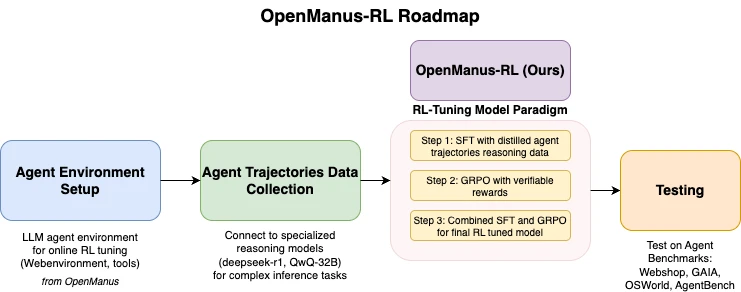

OpenManus-RL是一個由UIUC-Ulab與MetaGPT社區的OpenManus團隊聯合開發的開源項目,可以通過強化學習RL技術提升大型語言模型LLM智能體的推理與決策能力。該項目基于Deepseek-R1、QwQ-32B等先進模型的經驗,探索新的調優方法,以增強智能體在復雜任務中的表現。 OpenManus-RL的核心功能包括智能體環境的搭建、軌跡數據的收集、強化學習調優支持以及基準測試的集成。它還集成了多種強化學習策略,如Tree-of-Thoughts和蒙特卡洛樹搜索(Monte Carlo Tree Search),以提升智能體的推理能力。

OpenManus-RL功能特征

智能體環境搭建:提供在線強化學習(RL)調優的智能體環境配置工具,方便用戶為特定任務定制智能體環境。

軌跡數據收集:能夠連接Deepseek-R1、QwQ-32B等模型,收集復雜任務的行為數據,為后續的調優提供數據支持。

RL調優支持:支持定制化智能體行為的強化學習方法,用戶可以通過指定獎勵函數等方式對智能體的行為進行優化。

基準測試集成:內置WebShop、GaiA、OSWorld、AgentBench等測試環境,方便用戶對智能體的性能進行量化評估。

多樣化策略:集成Tree-of-Thoughts、Monte Carlo Tree Search等強化學習策略,提升智能體在長程規劃任務中的推理能力。

社區協作:允許用戶提交代碼、數據集等,重要貢獻者可成為論文共同作者,促進社區的共同開發。

實時進展分享:通過動態更新展示RL調優過程與成果,方便用戶了解項目的最新進展。

OpenManus-RL應用場景

購物決策:通過定制智能體環境,優化智能體在購物決策任務中的表現,例如在WebShop中提升購買成功率。

復雜任務分析:分析智能體在復雜任務中的表現,如在GAIA、OSWorld等基準測試中的成功率、響應時間等指標,幫助開發者對比模型性能。

多模態任務優化:在OSWorld等多模態任務環境中,優化智能體的行為,提升其在多模態任務中的表現。

長程規劃任務:利用集成的多樣化策略,提升智能體在長程規劃任務中的推理能力,例如通過Tree-of-Thoughts策略優化智能體的行為。

OpenManus-RL安裝

1. 創建Conda環境:為避免依賴沖突,建議使用Conda創建環境,命令如下:

conda create -n openmanus-rl python=3.10 conda activate openmanus-rl

2. 克隆項目:確保已安裝Git,然后克隆項目并進入項目目錄,命令如下:

git clone https://github.com/OpenManus/OpenManus-RL.git cd OpenManus-RL

3. 安裝依賴:在項目根目錄執行以下命令安裝依賴,若下載慢可使用國內鏡像:

pip install -r requirements.txt

或

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

可視化工具需額外安裝:

pip install matplotlib numpy

4. 配置模型與數據集:

監督微調(SFT):指定模型和數據集,命令如下:

python -m openmanus_rl.sft --model_name_or_path Qwen/Qwen2.5-1.5B-Instruct --dataset_name CharlieDreemur/OpenManus-RL

強化學習調優(GRPO):配置獎勵函數,命令如下:

python -m openmanus_rl.grpo --model_name_or_path Qwen/Qwen2.5-1.5B-Instruct --dataset_name CharlieDreemur/OpenManus-RL-GRPO --reward_funcs accuracy format tag_count

數據集可從Huggingface獲取。

5. 運行項目:

單GPU運行SFT:

python -m openmanus_rl.sft --output_dir data/sft-output

多GPU運行GRPO(需配置zero3.yaml):

accelerate launch --config_file=configs/accelerate_configs/zero3.yaml openmanus_rl/grpo.py --output_dir data/grpo-output

OpenManus-RL使用

1. 智能體環境搭建:

運行python -m openmanus_rl.sft生成基礎環境。

修改配置文件(如任務目標或獎勵函數)。

執行python -m openmanus_rl.grpo開始調優。

2. 數據收集與測試:

配置模型(如Deepseek-R1):python -m openmanus_rl.grpo --model_name_or_path Deepseek-R1

運行測試:--benchmark GAIA,結果保存至data/目錄。

3. RL調優操作:

運行GRPO模式:python -m openmanus_rl.grpo --reward_funcs accuracy

查看訓練日志,模型保存至data/grpo-output。

GitHub倉庫地址:https://github.com/OpenManus/OpenManus-RL

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI