NSA:DeepSeek團隊推出的加速超長上下文的訓練和推理技術(shù)

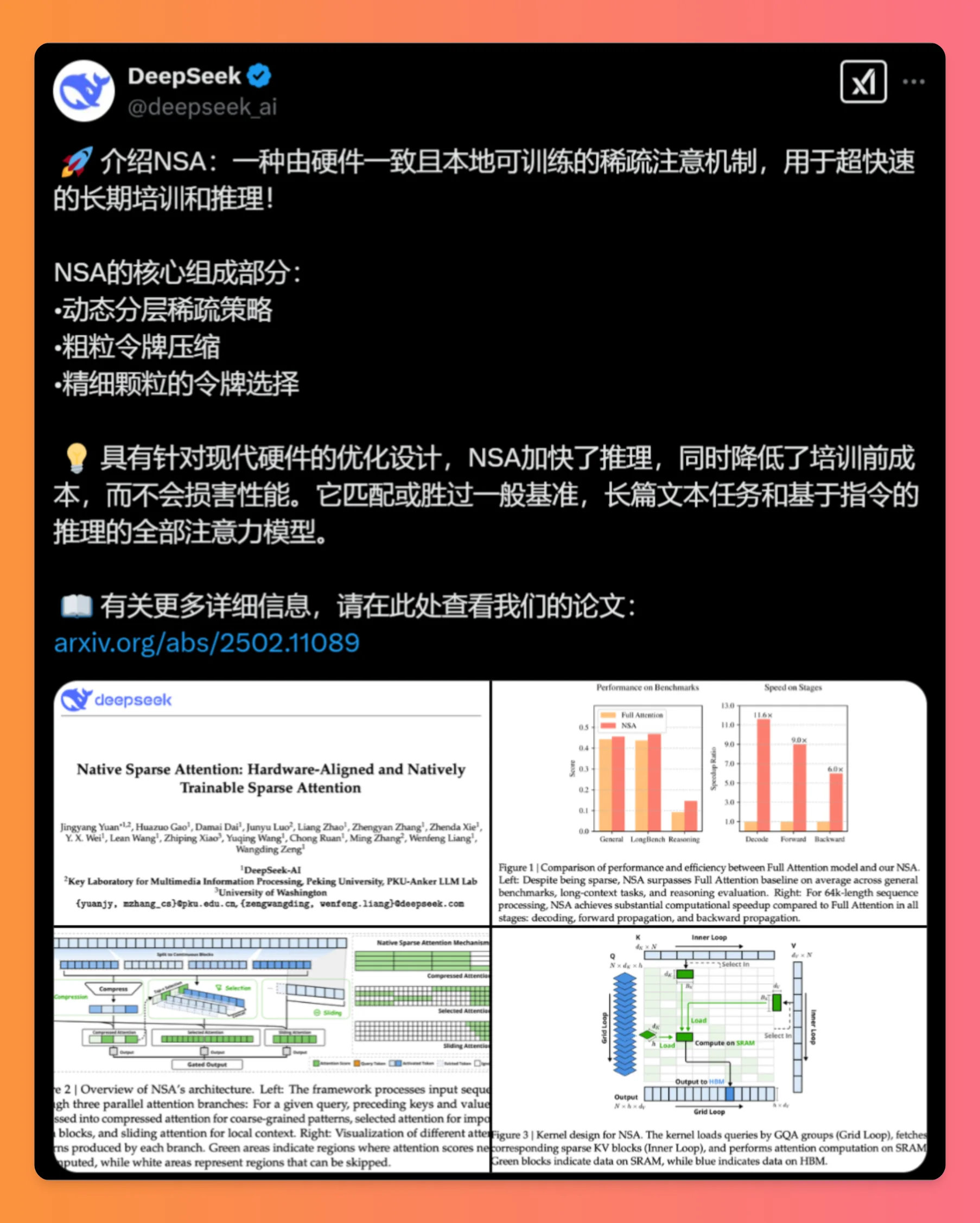

DeepSeek團隊在2025年2月18日推出了一種創(chuàng)新的注意力機制,名為NSA(Native Sparse Attention)。NSA致力于解決長文本處理過程中遇到的計算效率和性能障礙,這個技術(shù)通過硬件一致的設(shè)計以及原生訓練支持,可以大幅提高推理速度并降低預訓練成本。

NSA的主要特性:

硬件友好:設(shè)計時考慮了與各類硬件架構(gòu)的兼容性,旨在提高訓練效率。

本地訓練能力:支持在數(shù)據(jù)上直接訓練,增強了模型的適應性和靈活性。

高效推理與訓練:加速長上下文處理,助力復雜模型的應用,有效應對更長的序列數(shù)據(jù),例如文本和視頻。

動態(tài)層級稀疏策略:利用細粒度標記選擇和粗粒度標記壓縮技術(shù),在保留信息的同時降低計算復雜性。

成本降低:通過優(yōu)化設(shè)計,顯著減少了訓練深度學習模型時的資源消耗,包括時間和計算成本,對研究人員和開發(fā)者頗具價值。

NSA的核心構(gòu)成:

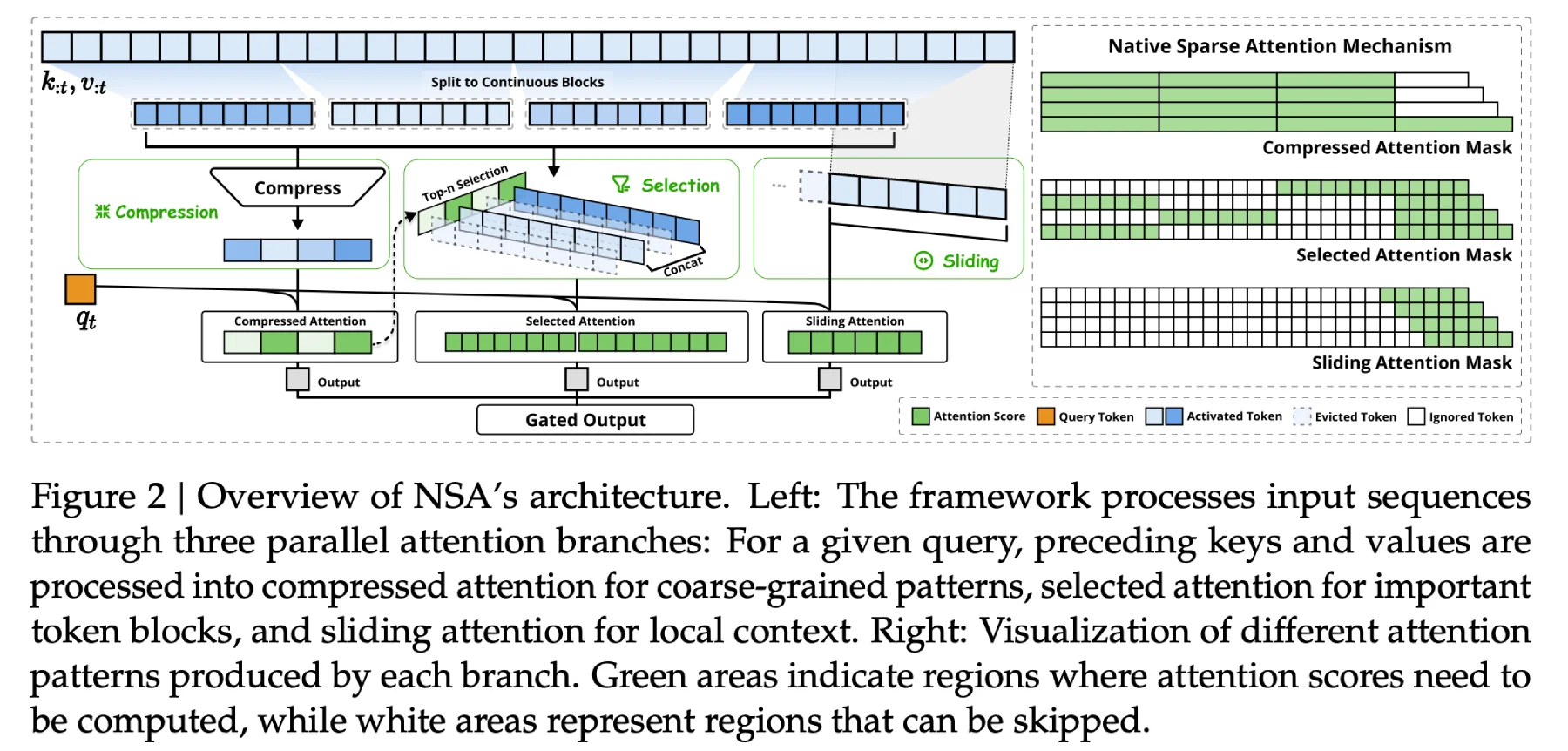

動態(tài)分層稀疏策略:融合粗粒度Token壓縮和細粒度Token選擇,提高效率的同時,確保模型對全局上下文和局部細節(jié)的感知。

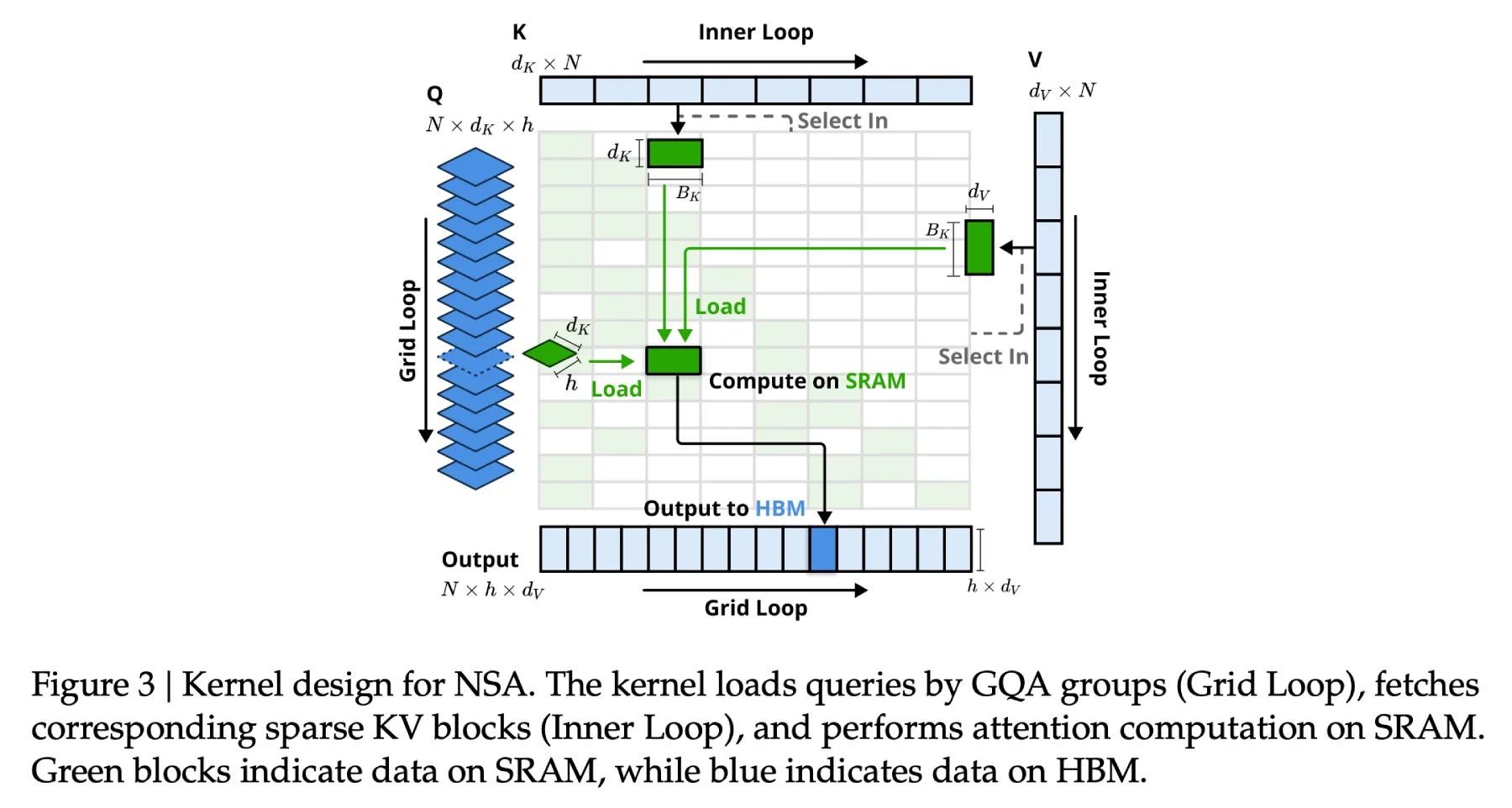

硬件對齊設(shè)計:優(yōu)化內(nèi)存訪問,適配GPU張量核心,分塊加載數(shù)據(jù),降低冗余傳輸,增進并行效率。

端到端可訓練:支持從預訓練到推理的稀疏計算全流程,保持反向傳播的穩(wěn)定性,避免傳統(tǒng)稀疏方法的“訓練掉隊”問題。

NSA的技術(shù)細節(jié):

動態(tài)分層稀疏策略:靈活地確定關(guān)鍵信息和可忽略信息,優(yōu)化信息處理,確保模型在處理長上下文時捕捉關(guān)鍵全局語義,同時減輕計算負擔。

粗粒度Token壓縮:通過整合相似或不重要的Token,減少數(shù)據(jù)處理量,加速計算,同時保持對文本粗粒度語義的理解。

細粒度Token選擇:在壓縮數(shù)據(jù)中進一步篩選重要Token,確保模型關(guān)注細節(jié),維持局部精確性,防止重要信息丟失。

滑動窗口:利用滑動窗口機制捕獲局部上下文信息,避免忽略近鄰關(guān)系。

NSA的性能成果:

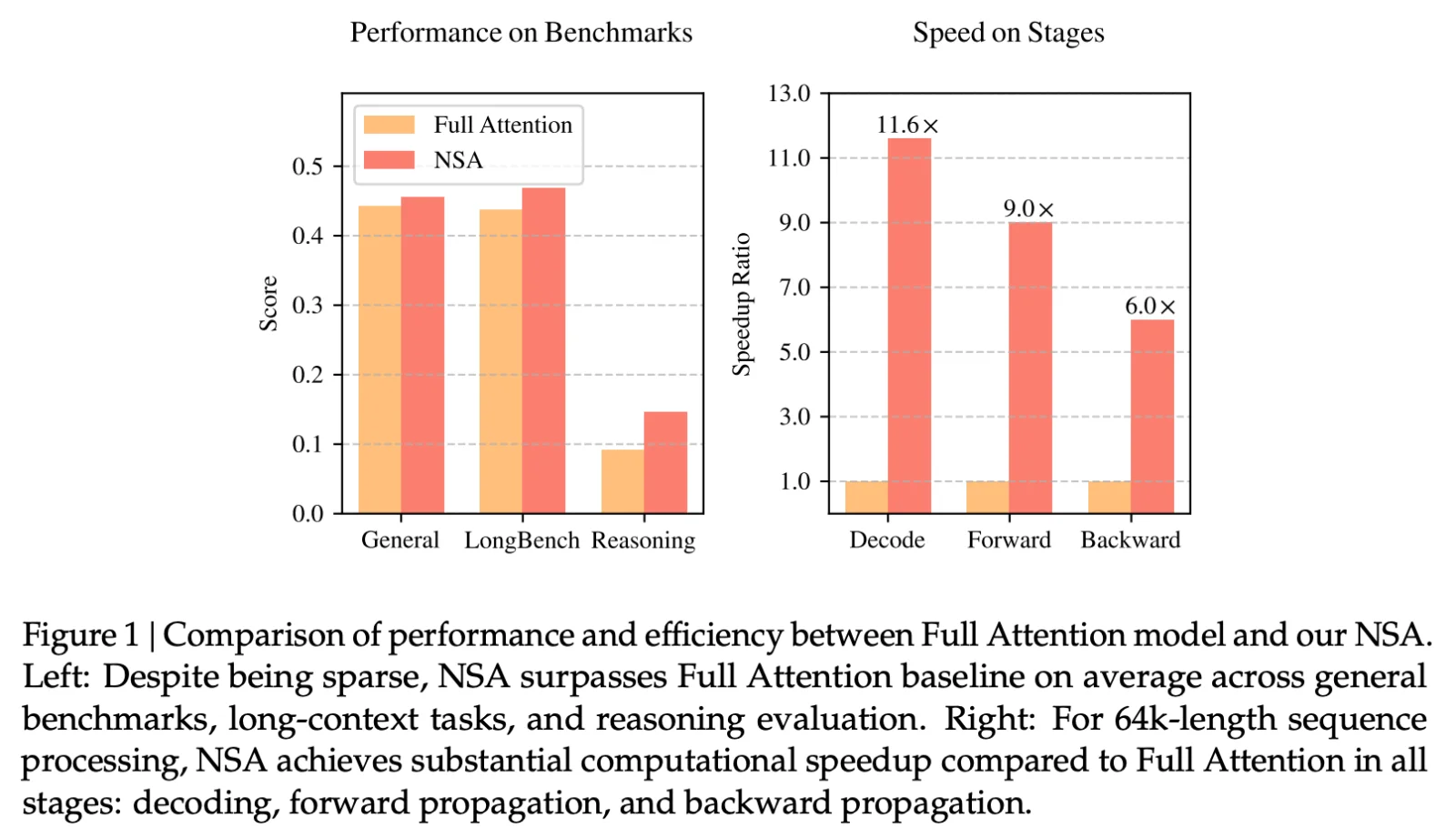

速度提升:處理64k長度序列時,NSA在解碼、前向傳播和反向傳播等階段實現(xiàn)顯著速度提升,最高達11.6倍。

性能優(yōu)越:在多個基準測試中,NSA表現(xiàn)與全注意力模型相當甚至更優(yōu),尤其在長上下文任務和指令推理方面。

NSA的應用領(lǐng)域:

智能助手:實現(xiàn)更復雜的多輪對話和個性化服務。

科學計算:如物理模擬、工程建模中的長序列數(shù)據(jù)處理。

代碼生成與調(diào)試:理解長代碼庫并生成高質(zhì)量解決方案。

NSA的論文:https://arxiv.org/abs/2502.11089

DeepSeek是一家專注于通用人工智能的中國企業(yè),致力于發(fā)掘AGI核心技術(shù)并實現(xiàn)產(chǎn)品化。DeepSeek已推出多款高性能開源ai大模型,如支持128k上下文長文本理解的DeepSeek-V2,以及在MT-Bench中文評測中表現(xiàn)優(yōu)異的DeepSeek-R1-Lite-Preview。

相關(guān)文章

- 用戶登錄

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺