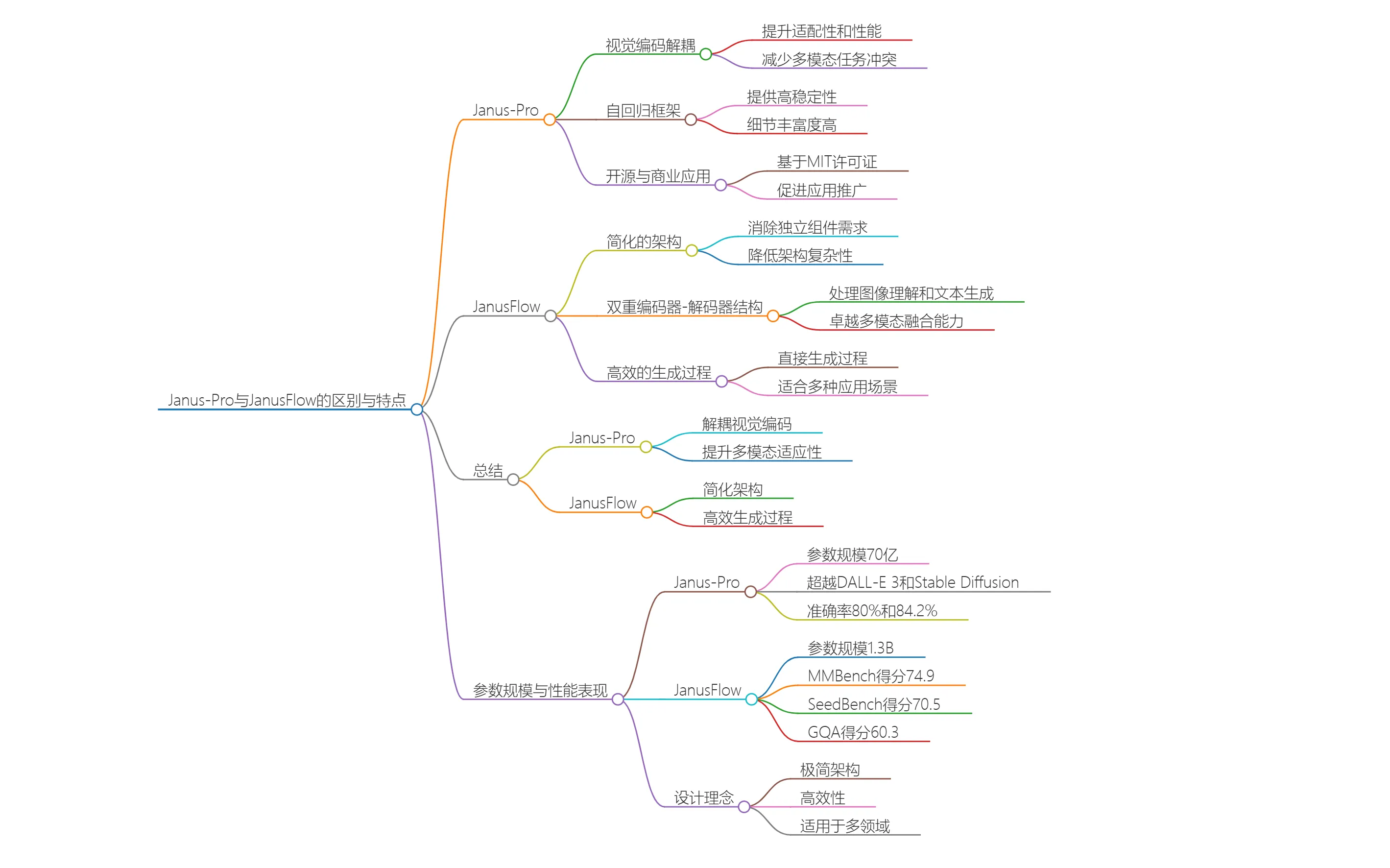

阿里通義千問發布新一代視覺語言模型:Qwen2.5-VL

阿里Qwen2.5-VL是阿里巴巴通義千問團隊推出的全新的視覺理解模型,該模型具備強大的視覺理解、代理、長視頻理解及事件捕捉能力,旨在推動ai在多領域的應用與發展。

Qwen2.5-VL主要功能

視覺理解:Qwen2.5-VL能夠精準識別圖像中的常見物體,如花、鳥、魚和昆蟲,并且可以分析圖像中的文本、圖表、圖標、圖形和布局。這使得它在處理視覺信息時表現出色,能夠為用戶提供詳細的圖像分析結果。

視頻理解:該模型突破性地支持超過1小時的視頻理解,能夠在視頻中識別和解析具體事件。這一功能使得Qwen2.5-VL在視頻內容分析和處理方面具有顯著優勢。

動態推理能力:Qwen2.5-VL具備動態推理能力,能夠根據視覺環境和文本指令進行復雜的決策和操作。這使得它可以作為一個AI視覺智能體,直接操控手機和電腦等設備。

多尺寸版本:Qwen2.5-VL提供了3B、7B和72B三個不同規模的模型,用戶可以根據需求選擇合適的版本,以滿足不同的計算資源和應用場景。

主要特性

多尺寸版本

提供3B、7B和72B三個不同參數量的版本,分別適用于不同的應用場景和硬件配置。

3B 版本:適合移動端和其他資源受限的環境。

7B 版本:平衡性能和資源消耗,適用于多數應用場景。

72B 版本:最高性能版本,適用于需要高精度和強大功能的應用。

先進功能

視覺定位能力:能夠精確識別圖像中的對象,并以坐標形式返回位置信息。

通用圖像識別:不僅能識別常見的物體(如花、鳥、魚),還能分析圖像中的文本、圖表、圖標等元素。

文檔解析:顯著提高了對文檔和表格的理解能力,特別是在學術問題解答、數學能力和文檔驗證等方面表現出色。

視頻理解:支持長時間視頻(可達小時級別)的理解,具備秒級事件定位能力,能夠總結視頻要點并提取關鍵信息。

視覺Agent:無需特定任務微調就能操作電腦和手機,執行復雜的推理和決策任務。

文字識別與理解:增強了OCR識別能力,支持多場景、多語言和多方向的文字識別及信息抽取。

改進之處

時空感知能力:增強了模型對時間和空間尺度的感知能力,使其更好地理解和處理不同類型的數據。

網絡結構簡化:引入了窗口注意力機制,減少計算負擔,提高模型效率。

動態分辨率:使用原生動態分辨率的ViT,確保模型保持原生分辨率的同時降低計算壓力。

性能表現

多項基準測試領先:在多個領域的基準測試中展現出優異的表現,尤其是在文檔理解、視覺問答、視頻理解和視覺Agent等多個任務中超越了同類競爭模型。

具體案例:

文檔理解:在DocVQA等任務中表現出色。

視頻理解:能夠準確理解長達幾小時的視頻內容,并快速定位和摘要重要事件。

視覺Agent:無需額外調整即可執行復雜的自動化任務,如控制設備和軟件界面。

Qwen2.5-VL應用場景

智能客服:Qwen2.5-VL可以應用于視頻客服場景,實時分析用戶展示的產品圖像或條形碼,并提供相關商品信息。

金融和商業領域:該模型支持結構化輸出,適用于發票、表單等數據處理,特別適合金融和商業領域的應用。

教育和培訓:在教育領域,Qwen2.5-VL可以用于分析教學視頻,幫助學生理解復雜的概念和內容。

醫療影像分析:該模型的視覺理解能力也可以應用于醫學影像分析,幫助醫生更好地解讀影像數據。

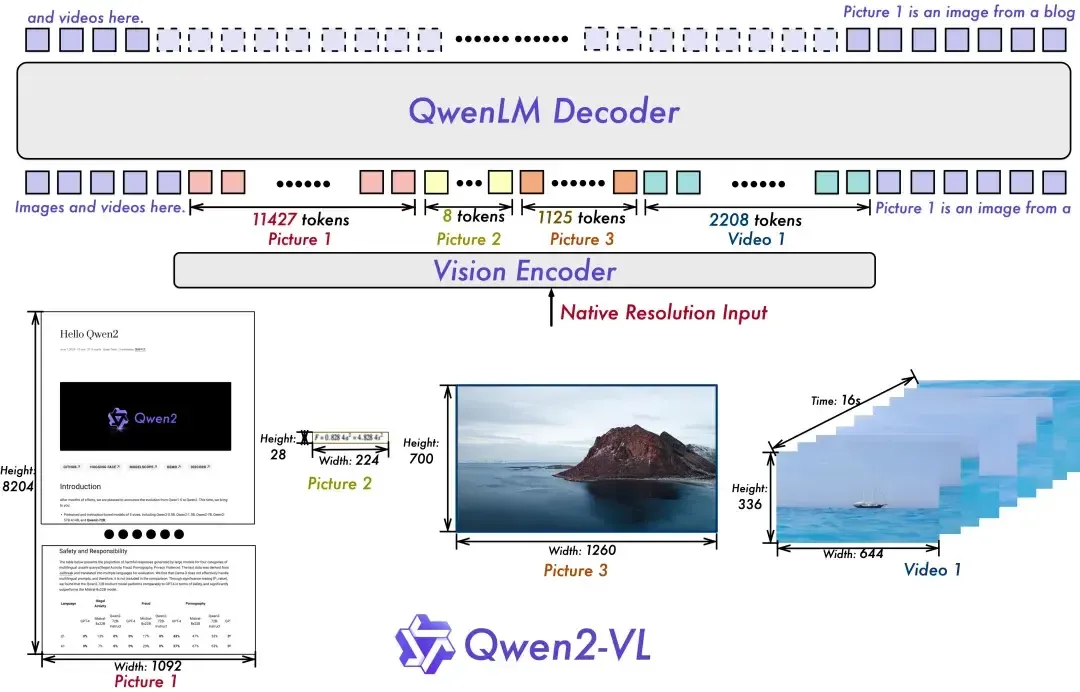

Qwen2.5-VL模型延續了上一代Qwen-VL的結構,采用了ViT(視覺變換器)與Qwen2的串聯結構,支持圖像和視頻的統一輸入。這種設計使得模型能夠更好地融合視覺和語言信息,提高對多模態數據的理解能力。此外,Qwen2.5-VL引入了多模態旋轉位置編碼(M-ROPE),將位置編碼分解為時間、空間(高度和寬度)三部分,從而增強了模型的多模態處理和推理能力。該模型還具備任意分辨率圖像識別的能力,能夠處理不同分辨率和長寬比的圖像,確保輸入和圖像信息的一致性。

Qwen2.5-VL獲取方式:

開源地址:Hugging Face

Github:Qwen2.5-VL

在線體驗:Qwen Chat

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺