VRAG-RL:阿里通義團隊推出的一款基于視覺感知RAG框架

VRAG-RL是什么?

VRAG-RL是阿里巴巴通義團隊最近推出的一款基于視覺感知RAG框架的模型。這款模型在Qwen2.5-VL-3B上性能提升了30%,在Qwen2.5-VL-7B上提升了20%。

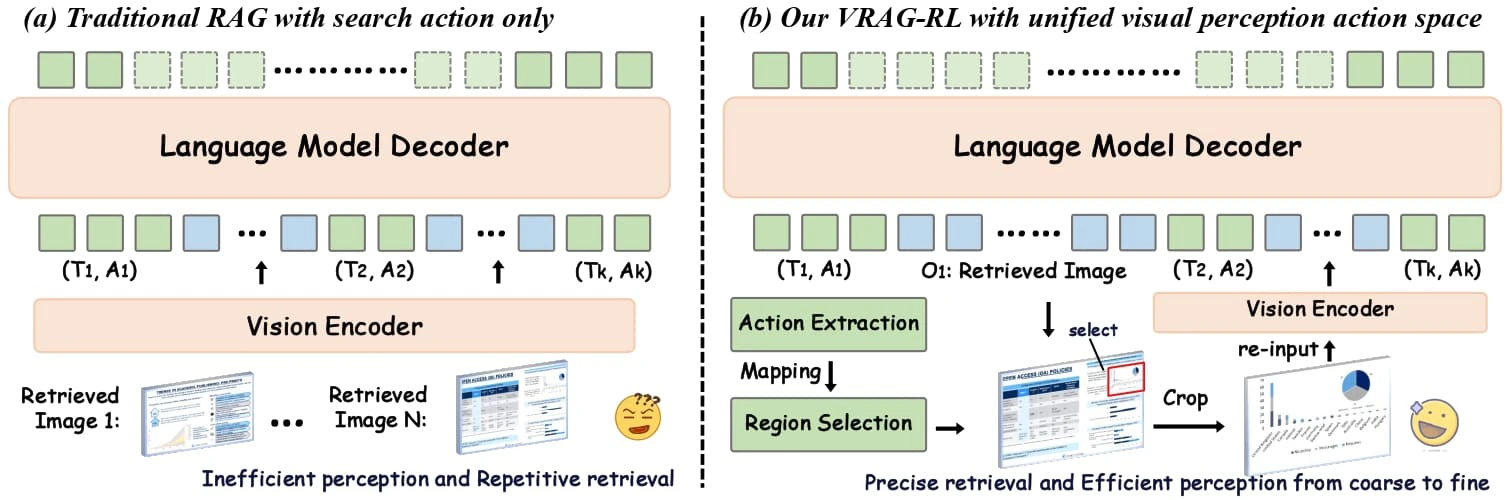

VRAG-RL通過強化學習訓練,讓模型具備多輪思考和推理能力,逐步增強對視覺語言模型(VLM)的理解力和答案準確性。它定義了視覺感知動作空間,使模型能從粗到細聚焦信息密集區域,精準提取關鍵視覺信息,提升VLM在檢索、推理和理解視覺信息方面的能力。

此外,VRAG-RL具備多模態檢索和迭代推理能力,通過多輪交互逐步完善對視覺信息的理解,最終生成準確且全面的答案。它適用于多種視覺任務,如圖像理解、圖表分析、復雜布局解析等場景。

傳統RAG方法存在局限性

視覺信息處理能力不足:無法有效解析圖像中的信息,缺乏對視覺數據的理解和推理能力。

固定流程限制動態推理:多采用固定的檢索 - 生成流程,難以在復雜任務中動態調整推理路徑,限制了模型挖掘視覺信息的能力。

檢索效率與推理深度不足:在處理復雜視覺任務時,往往無法高效定位關鍵信息,導致生成結果不夠精準。

VRAG-RL的核心創新

視覺感知動作空間:引入多種視覺感知動作,如區域選擇、裁剪和縮放等,使模型能從粗粒度到細粒度逐步聚焦信息密集區域,精準提取關鍵視覺信息。這種從粗到細的感知方式不僅提高了模型對視覺信息的理解能力,還顯著提升了檢索效率。

強化學習框架:通過強化學習(RL)優化模型的推理和檢索能力。模型與搜索引擎進行多輪交互,自主采樣單輪或多輪推理軌跡,并基于樣本進行持續優化。

綜合獎勵機制:設計了一種綜合獎勵函數,包括檢索效率獎勵、模式一致性獎勵和基于模型的結果獎勵。這種獎勵機制關注最終結果,優化檢索過程,讓模型更有效地獲取相關信息。

多專家采樣策略:結合大規模模型的推理能力和專家模型的精確標注能力,使模型能夠學習到更有效的視覺感知策略。

多輪交互訓練:基于多輪交互訓練策略,模型在與外部環境的持續交互中逐步優化推理過程,提升推理的穩定性和一致性。

VRAG-RL的技術優勢

提升性能:實驗結果表明,VRAG-RL在多個視覺語言基準數據集上均取得了顯著優于現有方法的性能表現。任務類型涵蓋從單跳到多跳推理、從純文本理解到圖表識別和復雜布局解析等多種視覺豐富場景。

支持多輪交互:能夠在推理階段逐步聚焦于信息密集區域,實現從粗到細的信息獲取。

高效訓練:引入了業界領先的GRPO算法,通過本地部署搜索引擎模擬真實世界應用場景,實現搜索引擎調用零成本,模型訓練更加高效。

VRAG-RL的應用場景

復雜圖表分析:從財務報表、科學圖表中提取關鍵數據。

設計稿解析:理解和推理設計稿中的布局與元素。

文檔檢索:在包含圖像、表格的文檔知識庫中高效檢索信息。

多模態問答:結合文本與圖像進行多跳推理,回答復雜問題。

項目鏈接

GitHub倉庫:https://github.com/Alibaba-NLP/VRAG

HuggingFace模型庫:https://huggingface.co/collections/autumncc/vrag-rl

arXiv技術論文:https://arxiv.org/pdf/2505.22019

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺