阿里巴巴正式推出開源大模型Qwen2.5-1M

阿里巴巴于2025年1月27日正式推出開源大模型Qwen2.5-1M系列,這是通義千問團隊首次將開源模型的上下文長度擴展至100萬Tokens(約合10本長篇小說或3萬行代碼),并在長文本處理性能上實現顯著突破。

一、Qwen2.5-1M主要特點

超長上下文支持:Qwen2.5-1M模型支持高達100萬tokens的上下文處理,相當于約100萬個英文單詞或150萬個漢字。這一特性使得模型能夠處理長篇文檔,如書籍、法律文件和長篇報告,而無需進行繁瑣的文本分割。

多種模型尺寸:此次發布的模型包括Qwen2.5-7B-Instruct-1M和Qwen2.5-14B-Instruct-1M,提供了不同的參數規模,以滿足不同應用場景的需求。

高效的推理框架:Qwen團隊開源了基于vLLM的推理框架,集成了稀疏注意力機制,使得在處理1M標記輸入時的速度提升了3倍到7倍。這種高效性使得開發者能夠更快速地部署和應用模型。

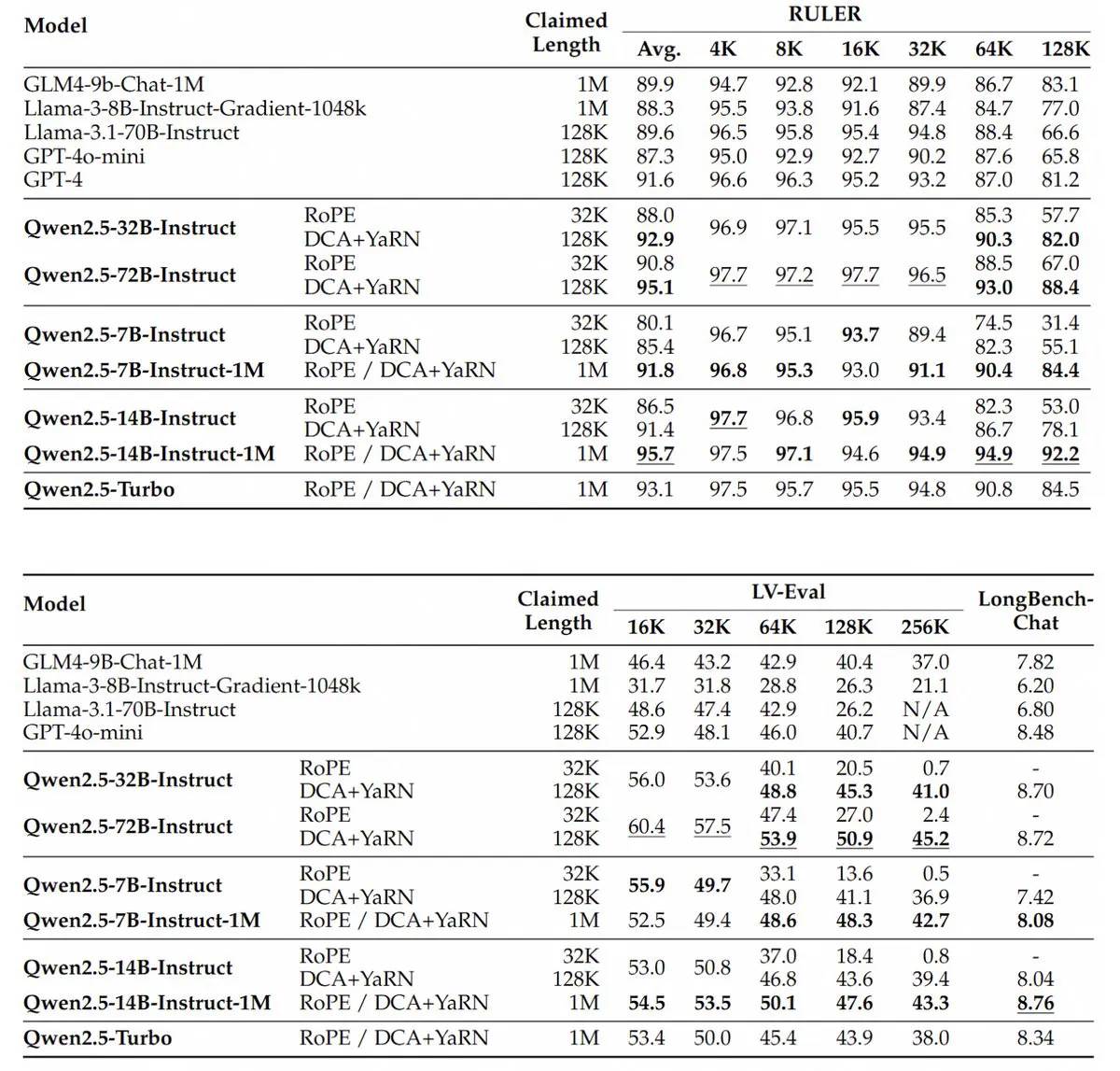

性能優勢:在長文本任務中,Qwen2.5-1M模型的表現顯著優于之前的128K版本,特別是在處理超過64K長度的任務時,展現出更強的能力。

二、模型特性與性能表現

長上下文處理能力

百萬Tokens支持:Qwen2.5-1M系列包含7B和14B兩個版本,原生支持1M Tokens上下文長度,可處理長篇文檔、代碼倉庫或復雜多輪對話,無需分段輸入。

精準檢索與理解:在“大海撈針”(Passkey Retrieval)任務中,模型能從1M Tokens文檔中準確提取隱藏信息,僅7B版本出現少量錯誤;在RULER、LV-eval等長文本理解基準測試中,14B版本表現穩定超越自家閉源模型Qwen2.5-Turbo和Openai的GPT-4o-mini。

短文本任務兼容性

7B和14B模型在短文本任務(如問答、摘要)中表現與128K版本相當,未因長上下文能力增強而犧牲基礎性能。例如,14B模型在短文本任務中與GPT-4o-mini性能接近,但上下文長度是其8倍。

三、技術突破與開源框架

漸進式訓練與長度外推

分階段擴展:從預訓練到監督微調,逐步將上下文長度從4K擴展至256K,再通過強化學習優化短文本對齊能力56。

Dual Chunk Attention(DCA):引入創新的位置編碼外推技術,無需額外訓練即可將模型支持的上下文長度從256K擴展至1M,解決了長距離位置編碼的注意力退化問題。

高效推理優化

稀疏注意力機制:基于vLLM框架集成稀疏注意力(MInference),結合分塊預填充和動態并行技術,使1M Tokens輸入的推理速度提升3.2至6.7倍,顯著降低內存占用(如7B模型激活內存減少96.7%)。

開源框架支持:完全開源推理框架及訓練技術報告,開發者可快速部署模型,并支持FP8量化以降低硬件需求。

四、應用場景

文本生成:Qwen2.5-1M模型可以用于生成長篇文章、報告和故事,適用于內容創作、新聞寫作等領域。

信息檢索:由于其超長上下文處理能力,模型可以在長文本中進行有效的信息檢索,適合用于法律、醫療等需要處理大量文檔的行業。

對話系統:該模型可以用于構建智能對話系統,能夠理解和生成復雜的對話內容,提升用戶體驗。

多模態應用:Qwen2.5-1M模型的設計使其能夠與其他模態(如圖像、音頻)結合,擴展其應用范圍到多模態理解和生成任務中。

Qwen2.5-1M的發布不僅填補了開源模型在超長上下文處理領域的空白,更通過技術創新與生態開放,為開發者提供了高性能、低門檻的工具選擇。其成功可能加速全球AI產業對長文本應用的探索,并推動開源社區在AGI競賽中的角色升級。

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺