Open-Sora 1.1發(fā)布:視頻生成質(zhì)量和持續(xù)時間顯著提升

今天,我們很高興地推出 Open-Sora-Plan v1.1.0,它顯著提高了視頻生成質(zhì)量和持續(xù)時間以及文本控制功能。與之前的 Open-Sora-Plan v1.1.0 版本相比,改進(jìn)了:

更好的壓縮視覺表示:我們優(yōu)化了 CausalVideoVAE 架構(gòu),該架構(gòu)現(xiàn)在具有更強(qiáng)的性能和更高的推理效率。

生成質(zhì)量更高、時長更長:我們使用了更高質(zhì)量的視覺數(shù)據(jù)和標(biāo)題以及ShareGPT4Video對長視頻進(jìn)行注釋的能力,我們可以生成更高質(zhì)量和更長的視頻。

除了性能改進(jìn)外,Open-Sora-Plan v1.1.0 還保持了 v1.0.0 的極簡設(shè)計和數(shù)據(jù)效率。值得注意的是,我們發(fā)現(xiàn) v1.1.0 表現(xiàn)出與 Sora 基礎(chǔ)模型相似的性能,這表明我們版本的演變與 Sora 演示的縮放定律一致。

我們開源了 Open-Sora-Plan,以促進(jìn)社區(qū)視頻生成的未來發(fā)展。代碼、數(shù)據(jù)、模型將公開提供。

演示:Hugging Face 演示在這里。

代碼:所有訓(xùn)練腳本和示例腳本。

模型:此處為 Diffusion Model 和 CasualVideoVAE。

數(shù)據(jù):此處為原始視頻和字幕。

GitHub:https://github.com/PKU-YuanGroup/Open-Sora-Plan/tree/main

在線體驗:https://huggingface.co/spaces/LanguageBind/Open-Sora-Plan-v1.1.0

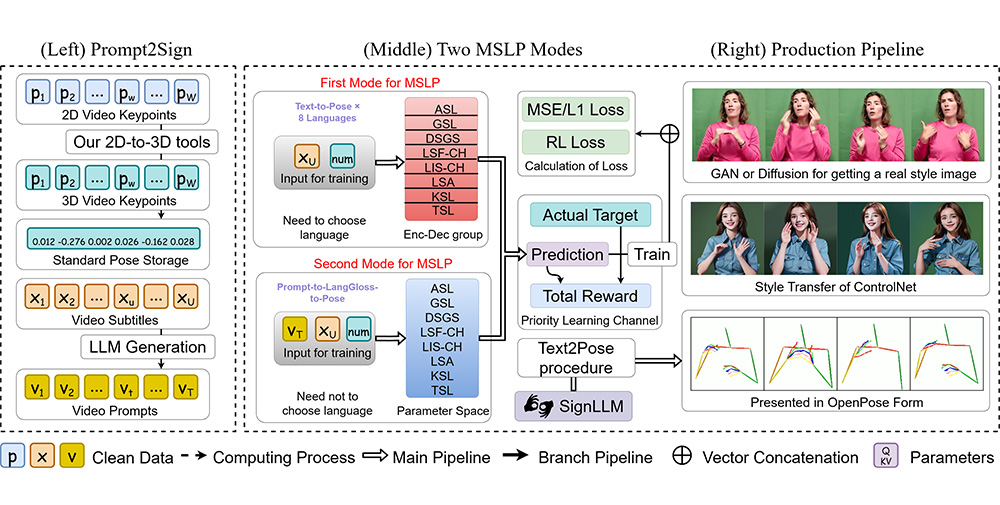

Open-Sora-Plan v1.1.0基于 transformer 的文本到視頻擴(kuò)散系統(tǒng),基于 T5 的文本嵌入進(jìn)行訓(xùn)練。

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺

開源AI應(yīng)用平臺