SignLLM:第一個多語種手語生成模型

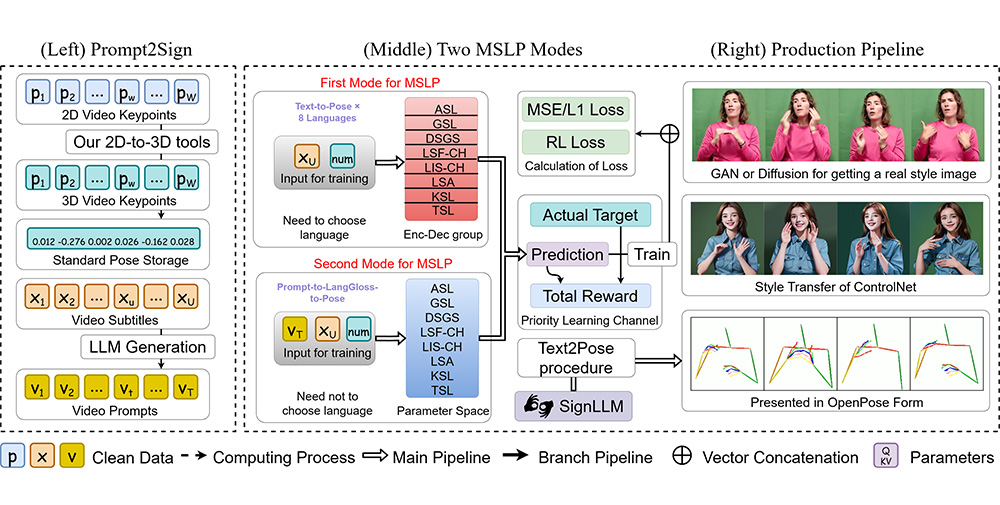

SignLLM,第一個多語種手語生成模型,可以將輸入的文本或提示轉化為相應的手語手勢視頻。SignLLM通過先進的ai技術生成和翻譯多種手語。SignLLM引入了首個多語言手語數據集,名為 Prompt2Sign,并基于此數據集開發了多種生成手語的模型。此數據集將大量視頻轉化為便于模型訓練的格式,優化了如 seq2seq 和 text2text 等翻譯模型的訓練。基于這些數據集,我們展示了 SignLLM 的基準結果,表明我們的模型在八種手語的手語生成任務中達到了最先進的性能。

SignLLM受到在廣泛的多語言文本語料庫上訓練的大型語言模型 (LLMs) 強大翻譯能力的啟發,我們的目標是利用現成的 LLMs 來處理 SLT。在本文中,我們對手語視頻進行規范化以體現口語的語言特征,并提出了一種新穎的 SignLLM 框架,將手語視頻轉換為類似語言的表示形式,以提高現成的 LLMs 的可讀性。

SignLLM 包含兩個關鍵模塊:

1、矢量量化視覺符號模塊將符號視頻轉換為一系列離散字符級符號標記。

2、代碼本重建和對齊模塊將這些字符級標記轉換為單詞級使用最佳傳輸公式進行符號表示。符號-文本對齊損失進一步彌合了符號和文本標記之間的差距,增強了語義兼容性。我們在兩個廣泛使用的 SLT 基準測試中取得了最先進的無光澤結果。

SignLLM GITHUB地址:https://signllm.github.io/

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺