Google Gemma是什么,如何使用?

Google Gemma是什么?

Google Gemma 是由 Google DeepMind 和 Google 其他團隊開發的一系列輕量級、先進的開放模型,對標另一個ai模型:Llama,Gemma這個名字來源于拉丁語中的“寶石”,靈感來自該公司更大、功能更強大的 AI 模型 Gemini,Gemma將向全球用戶提供兩種規模版本:2B(20億參數)和7B(70億參數),能夠支持各種工具和系統,同時能在開發者的筆記本電腦及工作站上順暢運行。

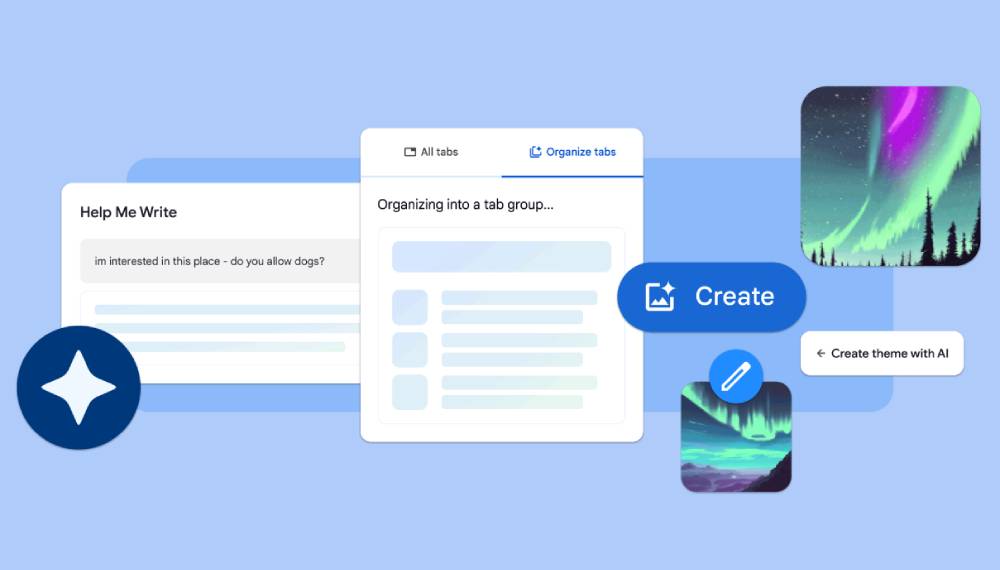

與 Gemma 一起,Google 還發布了一個新的生成式AI工具包,為使用 Gemma 創建更安全的 AI 應用程序提供指導和基本工具。

要想體驗Gemma,最方便直觀用 LM Studio。使用地址:https://lmstudio.ai,點擊下載模型,自帶GUI對話界面。

Google Gemma功能特征:

技術背景:Gemma 建立在用于創建 Gemini 模型的相同研究和技術之上,利用相同的基礎設施組件。

型號尺寸:發布了兩種尺寸的 Gemma 型號:Gemma 2B 和 Gemma 7B,每種型號都配備了預訓練和指令調整的變體。

性能:盡管重量輕,但 Gemma 型號提供了最先進的性能,超出了對其尺寸的預期,并遵守了 Google 關于安全和負責任輸出的嚴格標準。

責任:谷歌強調負責任地使用人工智能,采用自動化技術從訓練集中過濾掉敏感數據,并采用廣泛的微調和強化學習方法。

可訪問性:Gemma 型號在全球范圍內可用,并附帶支持開發人員創新、促進協作和指導負責任使用的工具。

硬件兼容性:這些模型經過優化,可在各種 AI 硬件平臺上運行,確保在部署在 Google Cloud 的 TPU 或 NVIDIA GPU 上時具有行業領先的性能。

Google Gemma如何使用?

為了有效地使用Google Gemma,建議遵循以下步驟:

1、深入了解 Gemma 模型及其規格

熟悉 Gemma 的不同版本,例如 Gemma 2B 和 Gemma 7B。

掌握各型號的預訓練和指令調整變體,以及它們的適用場景。

2、探索支持工具和框架

了解 Google 提供的工具,這些工具旨在支持 Gemma 模型的創新使用和負責任使用。

熟悉跨 JAX、PyTorch 和 TensorFlow 等主流框架的工具鏈,以便于進行模型推理和監督微調。

3、評估實際應用和性能

通過研究技術報告和實際應用案例,了解 Gemma 模型在實際環境中的表現。

查閱 Gemma 模型在 MMLU 語言理解基準和 HumanEval 編程挑戰等基準測試中的表現。

4、確保負責任使用和遵守道德規范

了解集成到 Gemma 中的 AI 原則,以及為保證模型輸出的安全性和負責任性所做的努力。

利用 Google 提供的負責任生成式 AI 工具包,指導模型的負責任使用。

5、掌握技術細節和硬件兼容性

深入了解 Gemma 模型的技術細節,包括在不同 AI 硬件平臺上的優化策略。

了解模型的使用條款,包括允許的商業用途和分發政策。

6、實踐教程和示例

通過 Keras NLP 指南中提供的動手教程和示例,開始實踐使用 Gemma。

探索如何使用 LoRA API 和多 GPU/TPU 來微調 Gemma 模型。

7、實現與外部平臺的集成

探索將 Gemma 與外部平臺和工具(如 Hugging Face、MaxText 和 TensorRT-LLM)的集成方法。

8、探索部署選項

根據項目需求,選擇在本地機器、Google Cloud(包括 Vertex AI 和 Google Kubernetes Engine)或通過參加 Kaggle 和 Colab 競賽來部署 Gemma 模型。

其他資源

訪問Google Gemma GitHub 庫或者通過訪問 ai.google.dev/gemma,獲取更多關于Google Gemma及其開發的信息并獲取快速入門指南。

根據以上步驟,您可以有效地整合 Google Gemma 模型到您的項目中。

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺