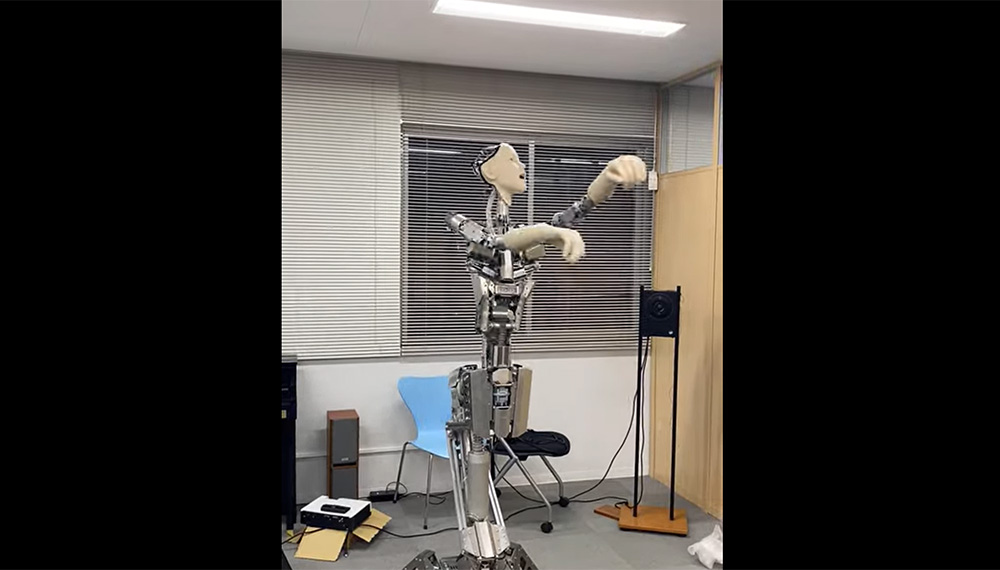

Alter3:GPT-4 為人形機器人運動和對話控制提供動力

東京大學的科學家將 Openai 的 GPT-4 大型語言模型 (LLM) 與人形機器人聯系起來。正如一篇新發表的論文所解釋的那樣,這個名為Alter3的機器人可以很好地理解對話提示,從而控制機器人的運動和手勢。

Alter3項目地址:https://tnoinkwms.github.io/ALTER-LLM/

東京大學團隊演示了 Alter3 在用自然語言指導時采用自拍、彈吉他或假裝成鬼魂等姿勢,而無需對每個動作進行顯式編程。GPT-4 也為 ChatGPT 提供動力,它能夠理解人們用他們喜歡的任何術語描述的內容、做出實物回應或生成與 DALL-E 3 相關的圖像的方式大致相同。

科學家們的這一突破彌合了與物理機器人的對話交互的差距,這通常需要使用專門的基于硬件的代碼進行精細的運動控制。研究人員將高級命令轉換為Alter3可以執行的指令。機器人可以像人類直觀地拾取動作一樣學習動作——從基本的洗牌到更協調的動作。用戶可以引導 Alter3 的姿勢并幫助它區分細微差別,例如不同的舞蹈動作。

這是一種能夠使用大型語言模型 (LLM) 生成自發運動的人形機器人,特別是 GPT-4。這一成就是通過將 GPT-4 集成到我們專有的機器人 Alter3 中來實現的,從而有效地將 LLM 與 Alter 的身體運動聯系起來。通常,低級機器人控制依賴于硬件,不屬于 LLM 語料庫的范圍,這給基于 LLM 的直接機器人控制帶來了挑戰。

然而,在像 Alter3 這樣的人形機器人的情況下,通過程序代碼將人類動作的語言表達映射到機器人的身體上,直接控制是可行的。值得注意的是,這種方法使 Alter3 能夠采用各種姿勢,例如“自拍”姿勢或“假裝成幽靈”,并隨著時間的推移生成一系列動作,而無需對每個身體部位進行顯式編程。

這證明了機器人的零樣本學習能力。此外,口頭反饋可以調整姿勢,無需微調。

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺