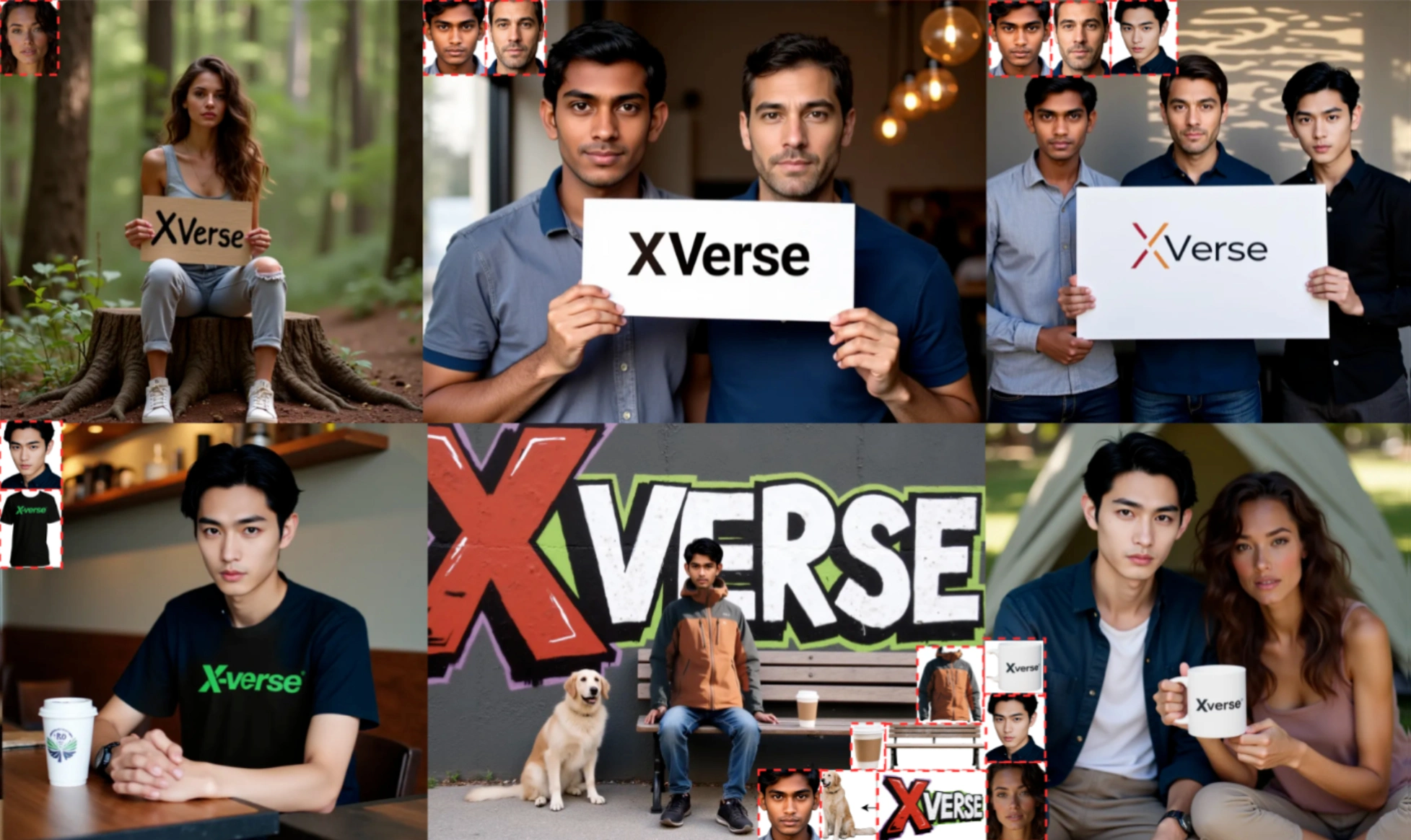

XVerse:字節(jié)跳動推出的多主體圖像合成開源工具

XVerse是字節(jié)跳動推出的一款多主體圖像合成工具,可以實(shí)現(xiàn)高精度的多主體圖像生成。它通過用戶獨(dú)立且精確地控制多個主體,大大提高復(fù)雜場景的生成能力。

核心功能

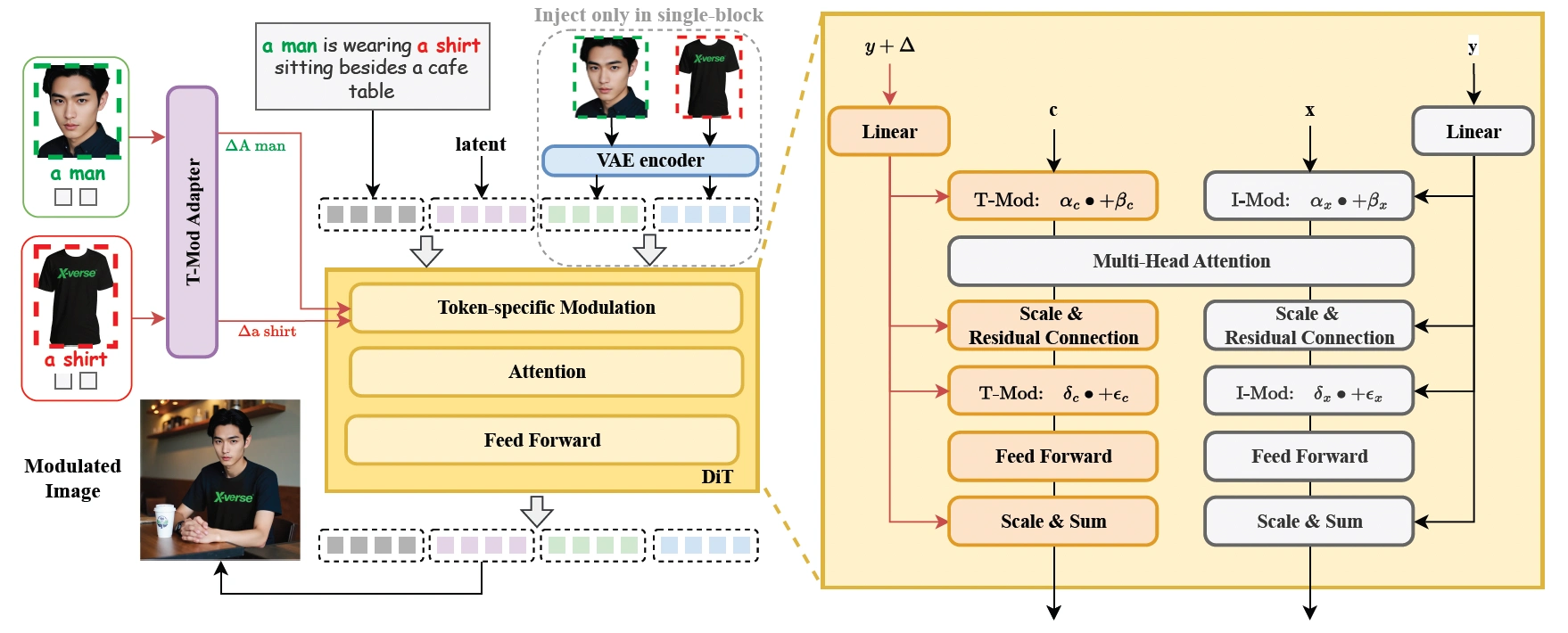

多主體控制:XVerse將參考圖像轉(zhuǎn)換為文本流調(diào)制的偏移量,精確控制每個主體的身份特征,獨(dú)立調(diào)整語義屬性(姿勢、風(fēng)格、光照等)。這解決了傳統(tǒng)模型在多主體場景中常見的身份混淆和屬性糾纏問題,實(shí)現(xiàn)了高保真、可編輯的多主體圖像合成。

文本流調(diào)制增強(qiáng):通過結(jié)合參考圖像特征與文本提示特征生成偏移量,并將其注入特定文本標(biāo)記嵌入,XVerse實(shí)現(xiàn)了對每個主體的精確控制,同時保持了生成圖像的整體結(jié)構(gòu),并能精細(xì)調(diào)整細(xì)節(jié)。

VAE編碼圖像特征:XVerse引入VAE編碼的圖像特征作為輔助輸入,注入到DiTs的單個塊中。這有助于捕捉和再現(xiàn)圖像細(xì)節(jié)信息,避免了直接注入圖像特征可能導(dǎo)致的偽影和質(zhì)量下降。

正則化技術(shù):采用區(qū)域保持損失,強(qiáng)制模型在未調(diào)制區(qū)域保持一致性,區(qū)分和保持不同主體的特征。通過文本-圖像注意力損失,對齊調(diào)制模型和參考T2I分支之間的交叉注意力圖,確保模型在調(diào)制過程中語義交互的一致性和可編輯性。

XVerse技術(shù)原理

文本流調(diào)制機(jī)制:XVerse將參考圖像轉(zhuǎn)換為特定于標(biāo)記的文本流調(diào)制偏移量,添加到模型的文本嵌入中,從而實(shí)現(xiàn)對特定主體的精確控制,而不干擾圖像潛在變量或特征。

VAE編碼圖像特征模塊:為了增強(qiáng)生成圖像的細(xì)節(jié)保留能力,XVerse引入了VAE編碼的圖像特征模塊。該模塊作為輔助模塊,幫助模型在生成過程中保留更多細(xì)節(jié)信息,減少偽影和失真。

正則化技術(shù):基于隨機(jī)保留一側(cè)的調(diào)制注入,強(qiáng)制模型在非調(diào)制區(qū)域保持一致性。正則化主體特定的特征,作為多主體數(shù)據(jù)集的數(shù)據(jù)增強(qiáng)策略,提高模型在多主體場景中的區(qū)分和保持主體特征的能力。通過計算調(diào)制模型和參考T2I分支之間的文本圖像交叉注意力圖的L2損失,確保調(diào)制模型保留與T2I分支一致的注意力模式,保持語義交互的一致性和可編輯性。

應(yīng)用場景

數(shù)字內(nèi)容創(chuàng)作:XVerse幫助創(chuàng)作者輕松實(shí)現(xiàn)對多個主體的精確控制,可用于繪制漫畫、創(chuàng)作故事插圖、構(gòu)建復(fù)雜虛擬場景等,使作品更生動、豐富、富有想象力。

廣告行業(yè):XVerse能夠精準(zhǔn)控制每個主體的屬性,確保廣告畫面的高保真度和一致性,使廣告更引人注目,提升傳播效果。

藝術(shù)領(lǐng)域:為藝術(shù)家提供全新的創(chuàng)作工具,突破傳統(tǒng)創(chuàng)作限制,創(chuàng)造獨(dú)特、富有表現(xiàn)力的藝術(shù)作品。

XVerse使用方法

用戶需要創(chuàng)建一個包含Python 3.10.16的conda環(huán)境,安裝依賴項(xiàng),并下載相關(guān)檢查點(diǎn)和人臉識別模型。用戶界面友好,提供豐富的輸入設(shè)置選項(xiàng),包括“檢測與分割”功能,可分析上傳圖像,自動裁剪人臉并生成描述。此外,還提供互動的Gradio演示,用戶可以上傳圖像、輸入描述,并實(shí)時生成圖像,通過調(diào)節(jié)參數(shù)優(yōu)化效果。

項(xiàng)目地址

項(xiàng)目官網(wǎng):https://bytedance.github.io/XVerse/

GitHub倉庫:https://github.com/bytedance/XVerse

HuggingFace模型庫:https://huggingface.co/ByteDance/XVerse

arXiv技術(shù)論文:https://arxiv.org/pdf/2506.21416

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺

開源AI應(yīng)用平臺