Qwen-Image:阿里云通義千問團隊開源的圖形海報生成模型

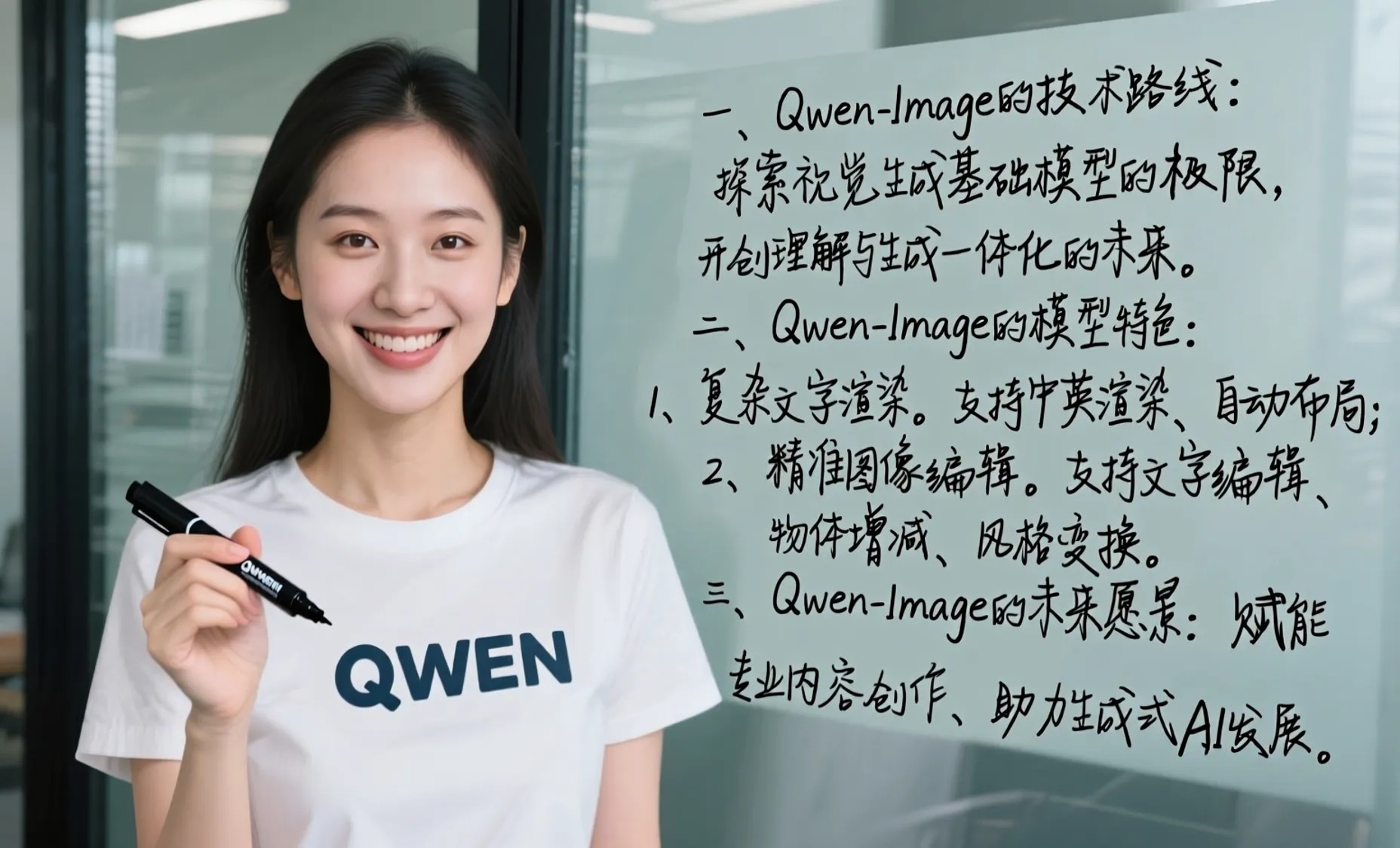

Qwen-Image 是阿里通義千問團隊在 2025 年 8 月 5 日開源的圖像生成基礎模型,參數規模 200 億,采用 MMDiT 架構。它在復雜文本渲染和精準圖像編輯方面表現突出,尤其擅長生成大量精準的中文,也支持中文提示詞,在 LongText-Bench、ChineseWord 等中文專項測試中領先很多。

這個模型支持中英雙語,能處理不同字體、超長段落和復雜的圖文布局,可生成海報、ppt 等多種場景的圖像,還能進行風格遷移、增減物體、調整姿態等圖像編輯。它能應用在廣告設計、影視制作、游戲開發、教育培訓等多個行業。用戶可以在 QwenChat(chat.qwen.ai)里選圖像生成功能來體驗,既能生成海報、PPT 頁面、商品宣傳圖等,也能對圖像做各種編輯,給設計師提供了有力工具。

主要特性

文本渲染能力強:支持多行布局、段落級文本生成和細節呈現,中英文都能高保真輸出,在 LongText-Bench、ChineseWord 和 TextCraft 等測試中表現很好,中文文本渲染比現有先進模型好很多,能生成不同語種、風格的文字,還能寫毛筆字,或者直接生成帶文本和圖像的 PPT 頁面。

圖像編輯一致性好:通過加強的多任務訓練,編輯時能保持視覺和語義上的連貫,支持風格遷移、增刪改、細節增強、文字編輯、調整人物姿態等操作。

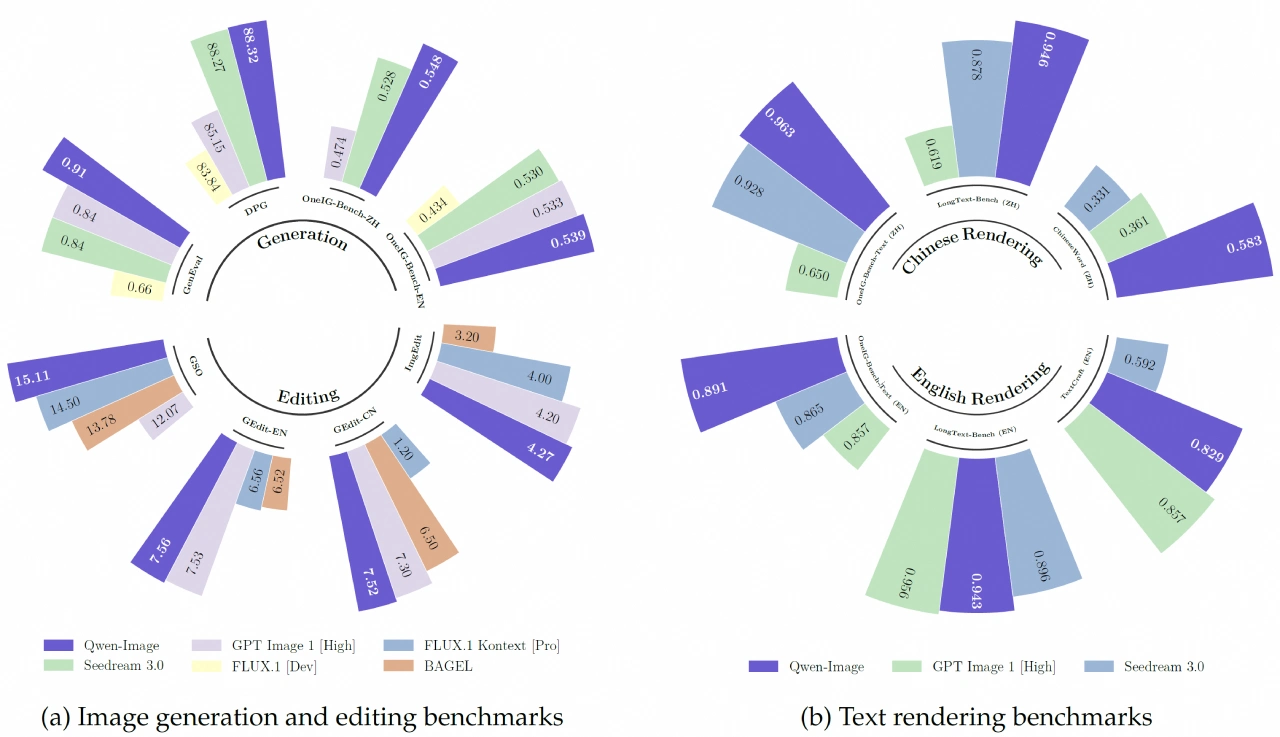

跨基準性能佳:在通用圖像生成的 GenEval、DPG 和 OneIG-Bench,以及圖像編輯的 GEdit、ImgEdit 和 GSO 等多個公開測試中,都取得了頂尖性能。

核心組件

Qwen2.5-VL 多模態大語言模型:作為條件編碼器,從文本中提取特征,根據系統提示詳細描述物體和背景的顏色、數量、文字等,為圖像生成提供依據,讓生成的內容更精細。

Wan-2.1 視頻生成模型的分自編碼器(VAE):相當于圖像分詞器,能把輸入圖像壓縮成緊湊的潛在表示,推理時再解碼還原。團隊凍結了編碼器,只微調解碼器,讓圖像細節更突出。

多模態擴散 Transformer(MMDiT):作為主干擴散模型,在文本引導下處理噪聲和圖像潛在表示的關系,加入多模態可擴展 RoPE 方法,幫助區分圖像和文本信息,既能生成高分辨率圖像,又能準確生成文字。

Qwen-Image技術架構

MMDiT 架構:用多模態擴散變換器,實現文本和圖像的深度融合。

單編碼器雙解碼器的 VAE:負責把圖像壓縮成緊湊的潛在表示,生成后再解碼成像素。通過調整重建損失和感知損失的平衡,能逼真還原圖像細節。

多模態可擴展旋轉位置編碼(MSRoPE):把文本信息在圖像網格的 “對角線” 上編碼,既保持文本獨立性,又能利用圖像分辨率縮放的優勢。

訓練策略

采用多階段、漸進式的預訓練:從低分辨率到高分辨率,從通用內容到專門內容,從海量數據到精煉數據逐步訓練。

訓練后期用監督微調(SFT)和強化學習(RL):用人工精選的高質量數據微調,還通過 DPO 等技術讓模型學習人類偏好。

應用場景

廣告設計:根據品牌風格快速生成高質量圖片,支持風格轉換和細節優化,幫設計師快速試多種效果,滿足客戶需求。

影視制作:用于前期概念圖、場景預設和角色設計,縮短制作周期,降低成本。

電商視覺:商家能快速生成產品展示圖、虛擬試穿圖和營銷素材,提升用戶體驗和購買率。

海報制作:根據文字和設計要求生成有沖擊力、藝術感的海報(如電影、活動海報),適配不同風格和主題。

PPT制作:生成企業級PPT頁面,采用星空藍主色調,搭配流動科技線條和微光粒子特效,畫面專業現代,支持多種風格和布局。

性能表現

通用圖像生成:在 GenEval、DPG 和 OneIG-Bench 等測試中表現優秀。

圖像編輯:在 GEdit、ImgEdit 和 GSO 等專業測試中性能頂尖。

文本渲染:在 LongText-Bench、ChineseWord 和 TextCraft 等測試中能力突出,尤其中文文本渲染遠超現有頂尖模型。

Qwen-Image優勢

中文支持更好:專門優化中文,渲染效果比 DALL-E 好很多。

完全免費:不用付費訂閱,還能在本地部署。

開源透明:代碼公開,可自定義修改。

編輯功能更強:支持更多樣的圖像編輯操作。

無使用限制:不受 API 調用次數限制。

Qwen-Image使用方法

環境準備:安裝最新版本的 diffusers。

基礎代碼:

from diffusers import DiffusionPipeline

import torch

model_name = "Qwen/Qwen-Image"

if torch.cuda.is_available():

torch_dtype = torch.bfloat16

device = "cuda"

else:

torch_dtype = torch.float32

device = "cpu"

pipe = DiffusionPipeline.from_pretrained(model_name, torch_dtype=torch_dtype)

pipe = pipe.to(device)

prompt = '''一個穿著"QWEN"標志T恤的中國美女正拿著黑色馬克筆面向鏡頭微笑。她身后的玻璃板上手寫體寫著"歡迎使用Qwen-Image,一款強大的圖像基礎模型"'''

aspect_ratios = {

"1:1": (1328, 1328),

"16:9": (1664, 928),

"9:16": (928, 1664),

"4:3": (1472, 1140),

"3:4": (1140, 1472)

}

width, height = aspect_ratios["16:9"]

image = pipe(

prompt=prompt + "超清,4K,電影級構圖",

width=width,

height=height,

num_inference_steps=50,

true_cfg_scale=4.0,

generator=torch.Generator(device=device).manual_seed(42)

).images[0]

image.save("qwen_image_example.png")硬件要求:推薦用 NVIDIA GPU(8GB 以上顯存),CPU 模式生成速度較慢,但也能使用。

?Qwen-Image官方介紹:https://qwenlm.github.io/zh/blog/qwen-image/

?Qwen-Image模型:https://huggingface.co/Qwen/Qwen-Image

?在線使用:https://chat.qwen.ai/(選輸入框下面的圖像生成)

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI