Aero-1-Audio:LMMs-Lab開發的一款緊湊型音頻模型

Aero-1-Audio是什么?

Aero-1-Audio是由LMMs-Lab開發的一款緊湊型音頻模型,基于Qwen-2.5-1.5B語言模型構建,擁有 24.2 億參數,采用MIT許可協議。它能高效處理多種音頻任務,適合在資源受限情況下部署高質量音頻處理功能的場景,比如手機語音助手、會議記錄和轉寫系統、或者課堂實時語音轉寫等等。

Aero-1-Audio模型特點

高效性能:Aero-1-Audio 基于 Qwen-2.5-1.5B 構建,不過雖然參數規模較小,但是在多個音頻基準測試中都很出色,甚至超越了許多更大規模的ai模型,比如 Whisper、Qwen-2-Audio 和 ElevenLabs/Scribe。

訓練效率高:Aero-1-Audio模型僅用 16 個 H100 GPU 在一天內完成訓練,使用了約 50 億個 tokens(相當于 5 萬小時音頻)的高質量過濾數據。

長音頻處理能力強:Aero-1-Audio 能夠不需要分割就可以處理長達 15 分鐘的連續音頻輸入,這在當前的音頻模型中比較少見。

性能評估

語音識別任務:在 AMI、LibriSpeech 和 SPGISpeech 等數據集上,Aero-1-Audio 的詞錯誤率(WER)最低。在長語音 ASR 測試中,它的性能下降幅度最小。

音頻理解任務:在音頻分析與理解、語音指令跟隨和音頻場景理解等多個維度上,Aero-1-Audio 表現都比較出色,優于或媲美其他大型模型。

技術優勢

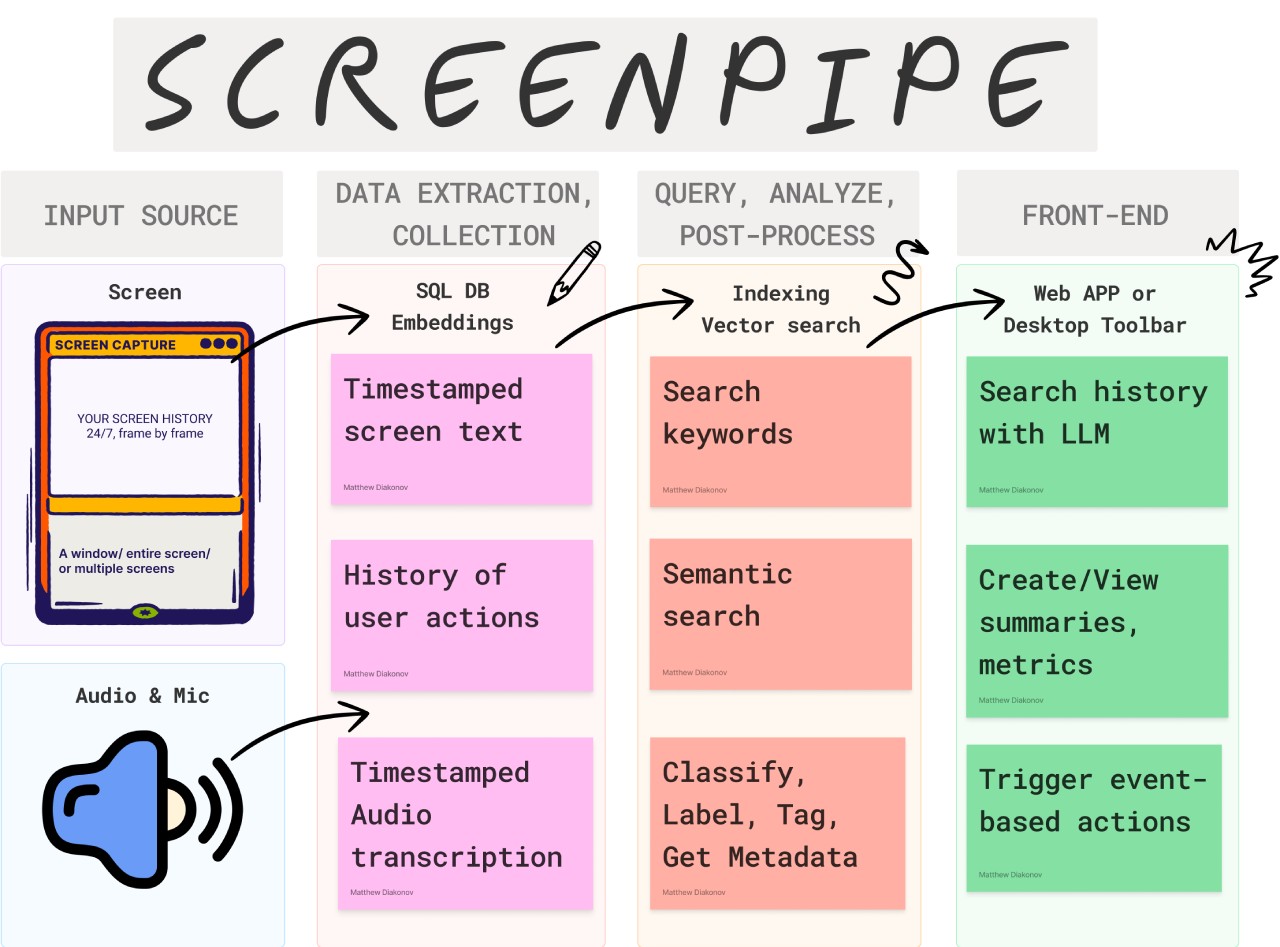

動態批大小:Aero-1-Audio 使用基于 token 長度的動態批處理策略,提高了計算資源利用率。

序列打包:通過序列打包技術結合 Liger 內核融合,平均模型 FLOP 利用率(MFU)從 0.03 提升至 0.34,訓練效率得到提高。

Aero-1-Audio應用場景

Aero-1-Audio 只要應用在教育、醫療、娛樂等領域,比如自動生成講座筆記、輔助醫生記錄病歷、實時生成視頻字幕等。

Aero-1-Audio使用方法

安裝依賴:需安裝特定版本的 transformers 庫,命令為python3 -m pip install transformers@git+https://github.com/huggingface/transformers@v4.51.3-Qwen2.5-Omni-preview。

簡單演示:通過導入相關庫和函數,加載音頻,使用AutoProcessor和AutoModelForCausalLM類,構建輸入并生成輸出,實現音頻處理,如轉錄音頻。

批量推理:類似簡單演示,可處理多個音頻,需調整輸入數據格式和參數設置,如設置填充方向等。

常見問題

問:Aero-1-Audio 與其他大型音頻模型相比,優勢體現在哪些方面?

答:Aero-1-Audio 參數使用更高效,訓練數據量比 Qwen-Omni 和 Phi-4 等模型小超 100 倍,但性能仍具競爭力。它還能準確處理長達 15 分鐘的連續音頻輸入,這在其他模型很少見的。

問:使用 Aero-1-Audio 模型進行推理前,需要做哪些準備工作?

答:需安裝特定版本的 transformers 庫,命令為python3 -m pip install transformers@git+https://github.com/huggingface/transformers@v4.51.3-Qwen2.5-Omni-preview。若想提升性能,可安裝flash-attn,命令為pip install --no-build-isolation flash-attn,不想使用flash attn時,也可選擇sdpa或eager。

問:Aero-1-Audio 的訓練數據有什么特點?

答:訓練數據來自 20 多個公開數據集,約 50 億個標記,對應約 5 萬小時音頻數據。相比其他模型,它的訓練數據量小但樣本效率高,能讓模型在較小數據量下達到有競爭力的性能。

HuggingFace:https://huggingface.co/lmms-lab/Aero-1-Audio

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺