OmniTalker:阿里推出的一款實(shí)時(shí)文本驅(qū)動(dòng)的說(shuō)話頭像多模態(tài)生成框架多模態(tài)框架

OmniTalker 是什么?

OmniTalker是阿里巴巴通義實(shí)驗(yàn)室研發(fā)的一款實(shí)時(shí)文本驅(qū)動(dòng)的說(shuō)話頭像ai多模態(tài)生成框架。它可以根據(jù)輸入的文本內(nèi)容,實(shí)時(shí)生成與之匹配的語(yǔ)音和視頻動(dòng)畫(huà)。生成的語(yǔ)音和視頻不僅高質(zhì)量,還能逼真地模擬面部表情和頭部動(dòng)作,仿佛是一個(gè)真實(shí)的“數(shù)字人”在與你對(duì)話。OmniTalker支持中英文互轉(zhuǎn),支持情感表達(dá),比如平靜、快樂(lè)、悲傷、憤怒等等情緒并支持長(zhǎng)視頻生成。

OmniTalker功能特點(diǎn)

多模態(tài)輸入處理:能夠感知文本、圖像、音頻和視頻等多種模態(tài)。

流式生成:以流式方式生成文本和自然語(yǔ)音響應(yīng),音頻和視頻編碼器采用按塊處理方法,解耦了對(duì)長(zhǎng)序列多模態(tài)數(shù)據(jù)的處理。

音視頻精準(zhǔn)同步:通過(guò) TMRoPE 技術(shù),確保視頻與音頻輸入的精準(zhǔn)同步。

實(shí)時(shí)交互:支持分塊輸入和即時(shí)輸出,能夠進(jìn)行完全實(shí)時(shí)交互。

語(yǔ)音生成自然流暢:在語(yǔ)音生成的自然性和穩(wěn)定性方面表現(xiàn)優(yōu)異,超越了許多現(xiàn)有的流式和非流式替代方案。

性能優(yōu)勢(shì):在多模態(tài)基準(zhǔn)測(cè)試中表現(xiàn)出色,音頻能力優(yōu)于類似大小的 Qwen2-Audio,并與 Qwen2.5-VL-7B 保持同等水平。

OmniTalker核心技術(shù)

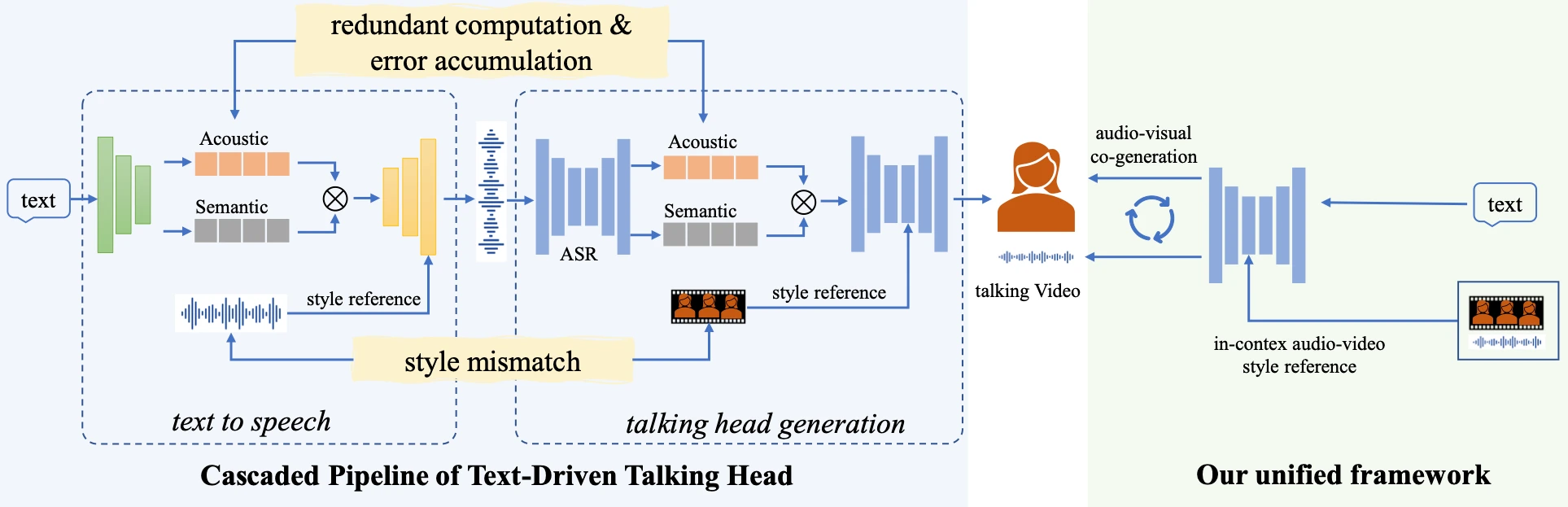

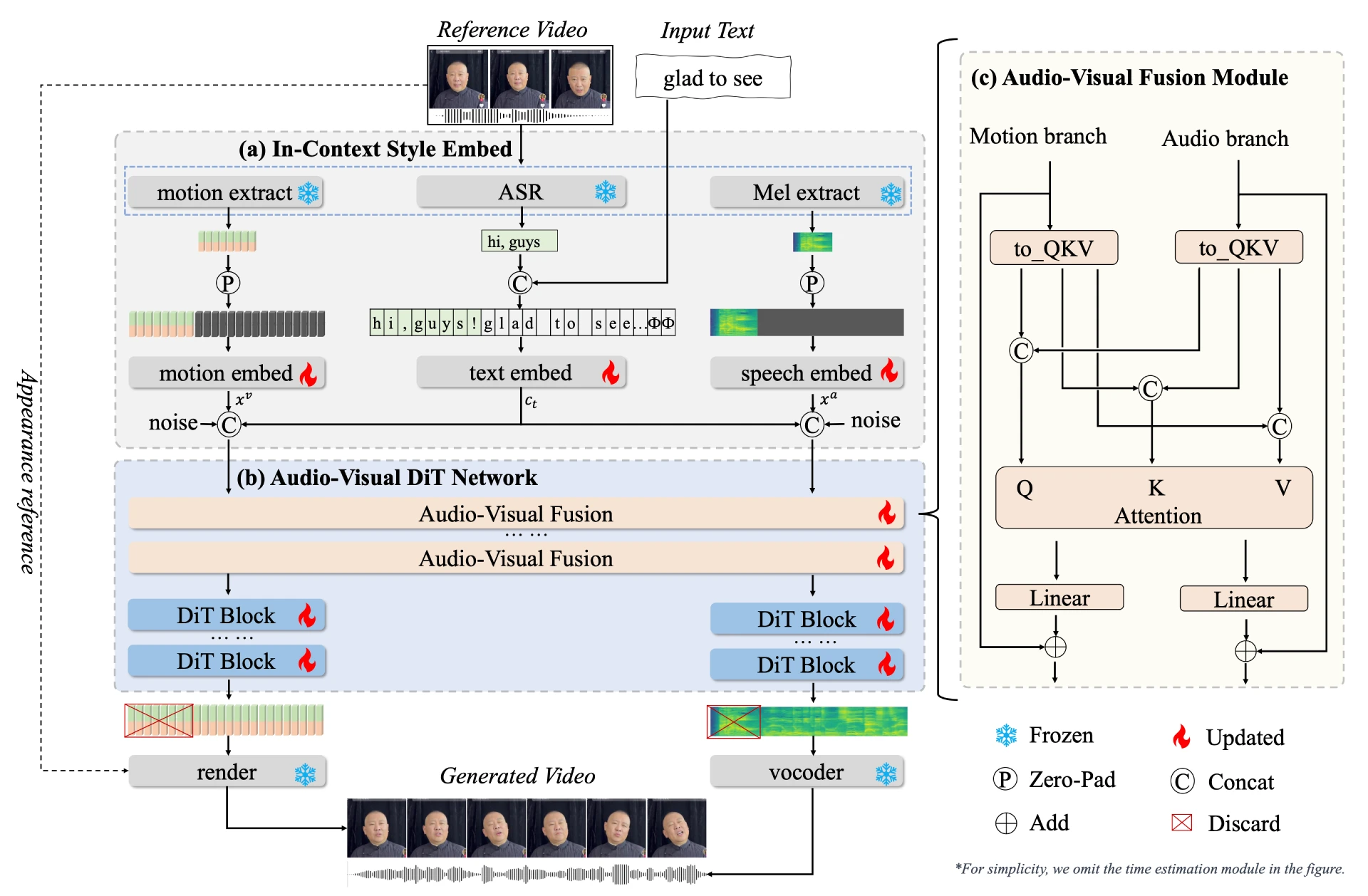

1. 雙分支擴(kuò)散變換器(DiT)架構(gòu)

包含 音頻分支 和 視覺(jué)分支:

音頻分支:從文本中合成高質(zhì)量的語(yǔ)音。

視覺(jué)分支:預(yù)測(cè)頭部姿勢(shì)和面部動(dòng)態(tài)。

通過(guò)一個(gè)新穎的 音頻-視覺(jué)融合模塊,確保音頻和視頻輸出在時(shí)間上的同步性和風(fēng)格上的一致性。

2. 上下文參考學(xué)習(xí)

OmniTalker 能夠從單個(gè)參考視頻中捕獲語(yǔ)音和面部風(fēng)格特征,無(wú)需額外的風(fēng)格提取模塊。這意味著,無(wú)論輸入的文本是什么,OmniTalker 都能夠生成與參考視頻風(fēng)格高度一致的語(yǔ)音和視頻內(nèi)容。

3. 實(shí)時(shí)性與高效性

OmniTalker 能夠以 25 FPS 的速度實(shí)時(shí)生成語(yǔ)音和視頻,這在同類技術(shù)中是非常領(lǐng)先的。這種高效的推理速度使得 OmniTalker 可以應(yīng)用于實(shí)時(shí)視頻聊天、虛擬直播等場(chǎng)景,為用戶帶來(lái)流暢的交互體驗(yàn)。

OmniTalker應(yīng)用場(chǎng)景

智能語(yǔ)音助手:處理用戶的語(yǔ)音指令,實(shí)時(shí)生成語(yǔ)音回應(yīng)。

多模態(tài)內(nèi)容創(chuàng)作:同時(shí)處理文本、圖像和視頻輸入,生成相應(yīng)的文本或語(yǔ)音描述。

教育與培訓(xùn):生成虛擬教師,根據(jù)教學(xué)內(nèi)容生成語(yǔ)音和視頻。

虛擬客服與助手:創(chuàng)建虛擬客服或助手,實(shí)時(shí)生成語(yǔ)音和視頻回應(yīng)。

娛樂(lè)與媒體:創(chuàng)建虛擬主播、演員,實(shí)時(shí)生成表演內(nèi)容。

OmniTalker優(yōu)勢(shì)

高質(zhì)量生成:生成的語(yǔ)音和視頻內(nèi)容質(zhì)量高,能精準(zhǔn)復(fù)制參考視頻的風(fēng)格,包括語(yǔ)音語(yǔ)調(diào)、節(jié)奏和面部表情的細(xì)微變化。

零樣本學(xué)習(xí):無(wú)需大量訓(xùn)練數(shù)據(jù),可根據(jù)輸入文本和參考視頻快速生成內(nèi)容,適應(yīng)不同場(chǎng)景和需求。

實(shí)時(shí)交互:以25 FPS的速度實(shí)時(shí)生成語(yǔ)音和視頻,延遲低,適用于實(shí)時(shí)視頻聊天、虛擬直播等場(chǎng)景。

項(xiàng)目官網(wǎng):https://humanaigc.github.io/omnitalker/

技術(shù)論文:https://arxiv.org/pdf/2504.02433v1

相關(guān)文章

- 用戶登錄

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開(kāi)源AI應(yīng)用平臺(tái)

開(kāi)源AI應(yīng)用平臺(tái)