Llama 4:首批采用混合專家(MoE)架構的多模態(tài)AI模型

Llama 4是什么?

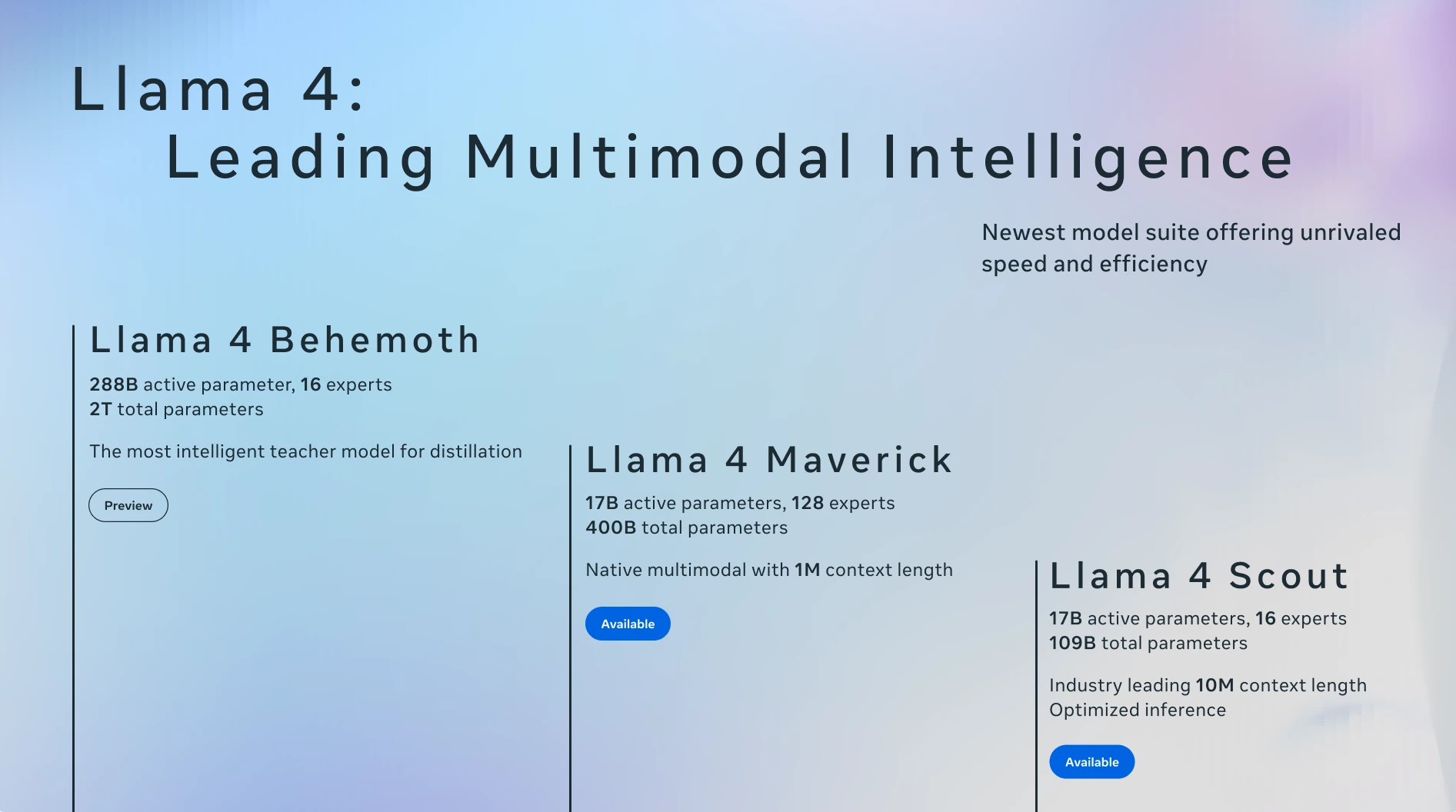

Llama 4 是 Meta 公司于 2025年4月5日發(fā)布的最新一代開源ai模型系列。包括Llama 4 Scout和Llama 4 Maverick,它們是首批采用混合專家(MoE)架構的多模態(tài)AI模型。Scout 擁有 170 億個活躍參數(shù)、16個“專家”模型、總參數(shù)量為1090億,而 Maverick 同樣有170億個活躍參數(shù),但配備了 128 個“專家”模型,總參數(shù)量高達4000億。此外,還有一個正在開發(fā)中的更強大的版本Llama 4 Behemoth,它有2880億個活躍參數(shù)、16個“專家”模型,總參數(shù)量接近2萬億。這些模型經(jīng)過大量未標注的文本、圖像和視頻數(shù)據(jù)訓練,具備視覺理解能力。

Llama 4 系列模型

Llama 4 Scout

參數(shù)規(guī)模:170 億活躍參數(shù),16 個專家

硬件需求:可在單張 NVIDIA H100 GPU 上運行

上下文窗口:支持高達 1000 萬個 token 的超長上下文窗口

性能優(yōu)勢:優(yōu)于 Gemma 3、Gemini 2.0 Flash-Lite 和 Mistral 3.1

Llama 4 Maverick

參數(shù)規(guī)模:170 億活躍參數(shù),128 個專家,總參數(shù)量 4000 億

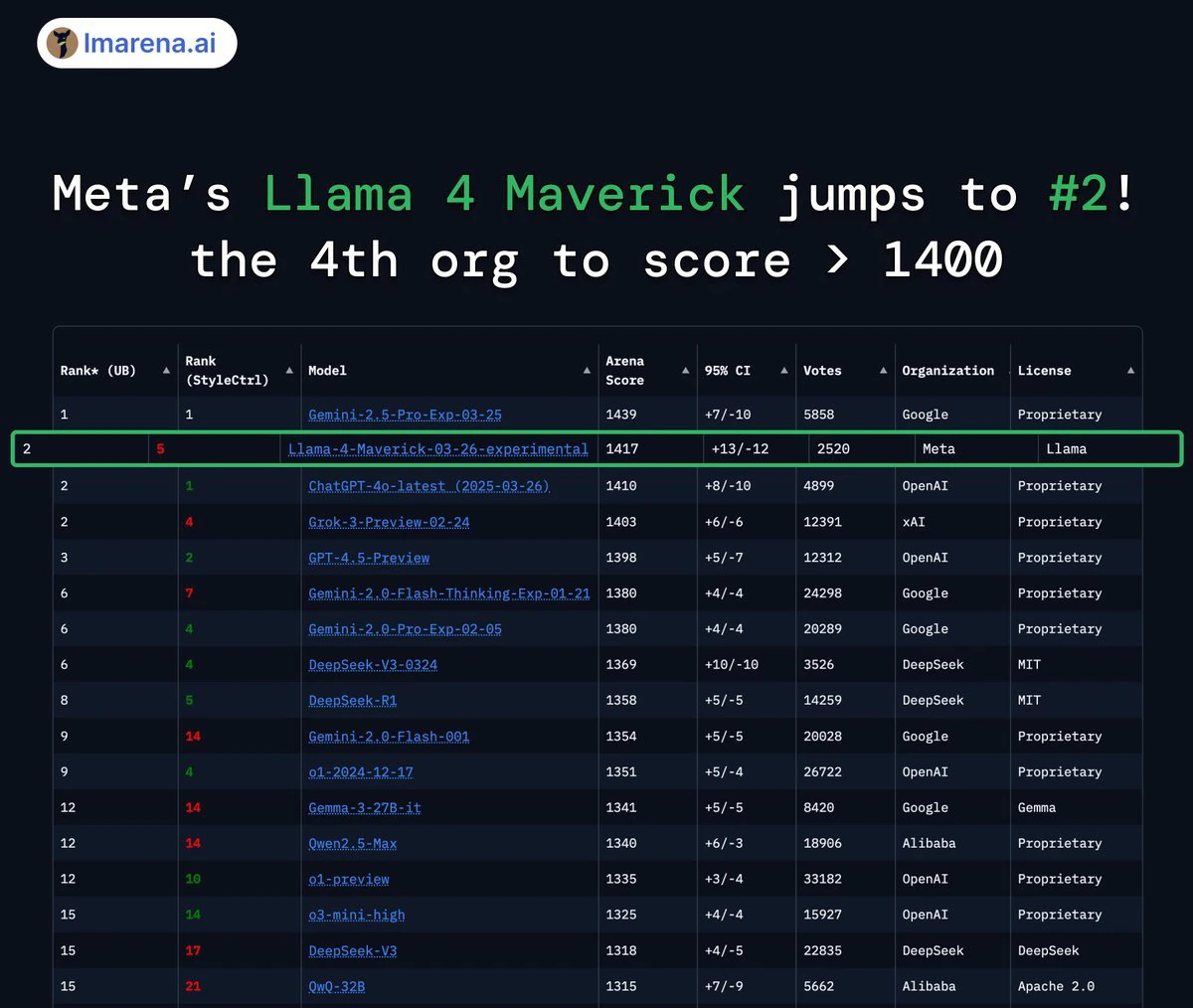

性能優(yōu)勢:在多模態(tài)任務中表現(xiàn)卓越,性能超過 GPT-4o 和 Gemini 2.0 Flash

推理能力:推理和編程能力與 DeepSeek v3 相當,但活躍參數(shù)不到其一半

Llama 4 Behemoth(預覽版)

參數(shù)規(guī)模:2880 億活躍參數(shù),16 個專家,總參數(shù)量接近 2 萬億

性能優(yōu)勢:在多個 STEM 基準測試中,性能超過 GPT-4.5、Claude Sonnet 3.7 和 Gemini 2.0 Pro

角色定位:作為教師模型用于蒸餾其他 Llama 4 模型,目前仍在訓練中

Llama 4功能特征

多模態(tài)能力:Llama 4 是一個多模態(tài)大模型,能夠處理和整合文本、視頻、圖像和音頻等不同類型的數(shù)據(jù),并在這些格式之間轉(zhuǎn)換內(nèi)容。例如,Llama 4 Scout 可以在復雜環(huán)境中分析圖像內(nèi)容。

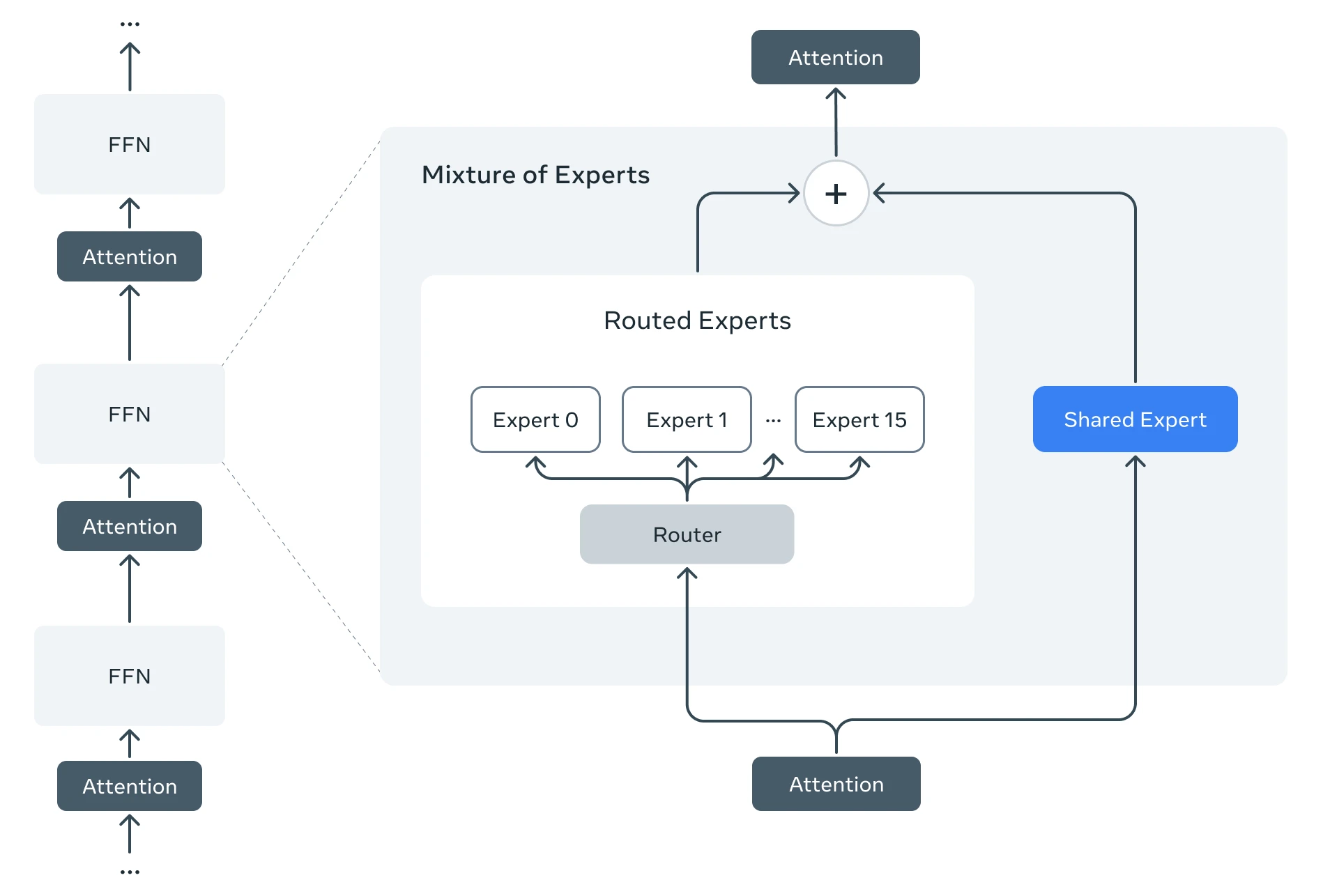

混合專家架構:這是 Llama 4 的核心特點之一。該架構將模型劃分為多個專注于特定任務的“專家”子模型,從而提高訓練和回答用戶查詢時的效率。例如,Llama 4 Maverick 模型總共有 4000 億個參數(shù),但僅有 170 億個參數(shù)在實際運算中活躍。

長上下文處理能力:Llama 4 Scout 的上下文窗口可達到 1000 萬個詞元,這使得它在處理冗長文檔時表現(xiàn)尤為優(yōu)異。

語音功能:Llama 4 引入了原生語音處理功能,能夠直接處理語音信息,無需先將語音轉(zhuǎn)換為文本再輸入模型處理,最后又將文本轉(zhuǎn)換回語音。這極大地提升了語音交互的效率和流暢度。

應用

客戶服務:企業(yè)可以使用這種多模態(tài) AI 模型快速分析用戶提出的問題,提供更加準確和高效的答復。

教育領域:智能教學助手可以通過理解學生的提問和輔以圖像的方式來解釋復雜概念,極大提升學習效果。

虛擬會議:在虛擬會議中,Llama 4 能夠充當助手,幫助用戶進行實時翻譯、記錄會議要點,甚至還可以模擬參與者的發(fā)言,提高溝通效率。

智能設備控制:用戶通過語音指令,可輕松完成撰寫文本、發(fā)送信息、控制智能家居設備等任務。

信息密集型領域:Llama 4 的長上下文處理能力使其在醫(yī)學、科學、工程、數(shù)學、文學等信息密集型領域非常實用。

Llama 4技術特點

模型規(guī)模和參數(shù)數(shù)量:Llama 4 Scout 擁有 170 億個活躍參數(shù)、16 個“專家”模型、總參數(shù)量為 1090 億;Llama 4 Maverick 同樣有 170 億個活躍參數(shù),但配備了 128 個“專家”模型,總參數(shù)量高達 4000 億;Llama 4 Behemoth 則擁有 2880 億個活躍參數(shù)和 2 萬億個總參數(shù)。

訓練數(shù)據(jù)和多樣性:所有模型都經(jīng)過了大量未標注的文本、圖像和視頻數(shù)據(jù)的訓練,以獲得廣泛的視覺理解能力。

架構優(yōu)化:采用了混合專家架構,通過將數(shù)據(jù)處理任務分解為子任務,并將其分配給更小的“專家”模型,實現(xiàn)了更高的運行效率。

推理效率:通過降低模型運行成本和延遲,提高了推理效率。例如,Llama 4 Maverick 可以在單個英偉達 H100 DGX 主機上運行。

Meta 估計Llama 4 Maverick 的推理成本為每 100 萬個 tokens 0.19 美元至 0.49 美元(輸入和輸出比例為 3:1),這使得它比像 GPT-4o 這樣的專有模型便宜得多。

詳細閱讀:https://ai.meta.com/blog/llama-4-multimodal-intelligence/

模型下載:https://www.llama.com/llama-downloads/?utm_source=llama-home-hero&utm_medium=llama-referral&utm_campaign=llama-utm&utm_offering=llama-downloads&utm_product=llama

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺