Moshi

Moshi簡(jiǎn)介

Moshi 是一個(gè)多流實(shí)時(shí)語(yǔ)音生成 Transformer 模型,支持全雙工語(yǔ)音對(duì)話(huà)。其主要特點(diǎn)是同時(shí)語(yǔ)音輸入和輸出(全雙工),以及處理復(fù)雜對(duì)話(huà)場(chǎng)景的能力,包括重疊語(yǔ)音、中斷和情緒表達(dá)等非語(yǔ)言信息。

這意味著它可以同時(shí)聽(tīng)和說(shuō),旨在解決傳統(tǒng)對(duì)話(huà)系統(tǒng)中的一些問(wèn)題,例如延遲、非語(yǔ)言信息(例如情緒)丟失以及對(duì)話(huà)輪流的僵化結(jié)構(gòu)。

全雙工通信:傳統(tǒng)的對(duì)話(huà)系統(tǒng)是回合制的(一個(gè)人在另一個(gè)人開(kāi)始之前結(jié)束講話(huà))。 Moshi 突破了這一限制,支持全雙工通信。這意味著 Moshi 可以在用戶(hù)說(shuō)話(huà)時(shí)生成語(yǔ)音響應(yīng),不受回合限制,并且可以處理復(fù)雜的對(duì)話(huà)動(dòng)態(tài),例如重疊語(yǔ)音、中斷和快速反饋。

多流處理:Moshi 通過(guò)處理多個(gè)音頻流來(lái)實(shí)現(xiàn)同時(shí)收聽(tīng)和生成語(yǔ)音。這種多流架構(gòu)使其能夠靈活處理用戶(hù)和系統(tǒng)之間的語(yǔ)音交互,而不會(huì)中斷對(duì)話(huà)的自然流程。

相比傳統(tǒng)的語(yǔ)音對(duì)話(huà)系統(tǒng), Moshi 有幾個(gè)顯著的優(yōu)勢(shì):

實(shí)時(shí)響應(yīng):Moshi的響應(yīng)速度非常快,延遲僅為160-200毫秒,接近自然對(duì)話(huà)中的反應(yīng)速度,因此可以提供更流暢的對(duì)話(huà)體驗(yàn)。

語(yǔ)音到語(yǔ)音處理:傳統(tǒng)系統(tǒng)通常依賴(lài)于語(yǔ)音到文本到語(yǔ)音的過(guò)程,而 Moshi 可以直接處理語(yǔ)音輸入并生成語(yǔ)音輸出,保留語(yǔ)氣和情緒等非語(yǔ)言信息。

全雙工對(duì)話(huà):Moshi不依賴(lài)于嚴(yán)格的對(duì)話(huà)輪流,而是可以同時(shí)處理用戶(hù)和系統(tǒng)語(yǔ)音,這意味著它可以處理重疊語(yǔ)音和中斷,更接近人類(lèi)對(duì)話(huà)的自然形式。

Moshi 的主要特點(diǎn):

實(shí)時(shí)語(yǔ)音對(duì)話(huà):Moshi 直接從音頻輸入生成音頻輸出,而不是依賴(lài)傳統(tǒng)的語(yǔ)音到文本到語(yǔ)音的過(guò)程。通過(guò)直接處理語(yǔ)音數(shù)據(jù),Moshi 保留了語(yǔ)氣、情緒、重疊語(yǔ)音和中斷等非語(yǔ)言信息,確保對(duì)話(huà)更加自然和流暢。

全雙工通信:Moshi 能夠同時(shí)聽(tīng)和說(shuō),這意味著它可以在用戶(hù)說(shuō)話(huà)時(shí)生成語(yǔ)音響應(yīng),而無(wú)需嚴(yán)格的對(duì)話(huà)輪流。它可以處理復(fù)雜的對(duì)話(huà)場(chǎng)景,例如重疊的語(yǔ)音和可以隨時(shí)插入的不間斷反饋(例如“嗯”或“我明白”)。

低延遲:Moshi 的設(shè)計(jì)延遲非常低,理論上只有 160 毫秒,實(shí)際上約為 200 毫秒。這意味著 Moshi 可以近乎實(shí)時(shí)地響應(yīng)用戶(hù)輸入,提供更流暢的對(duì)話(huà)體驗(yàn)。

內(nèi)心獨(dú)白法:Moshi 在生成語(yǔ)音之前預(yù)測(cè)文本標(biāo)記,這顯著提高了生成語(yǔ)音的語(yǔ)言質(zhì)量和一致性。這不僅使生成的語(yǔ)音更加清晰,還提高了系統(tǒng)在流媒體環(huán)境下的語(yǔ)音識(shí)別和文本轉(zhuǎn)語(yǔ)音能力。 Moshi通過(guò)引入“內(nèi)心獨(dú)白”機(jī)制,實(shí)現(xiàn)了流式語(yǔ)音識(shí)別(ASR)和文本轉(zhuǎn)語(yǔ)音(TTS)功能,支持在連續(xù)對(duì)話(huà)流中同時(shí)處理語(yǔ)言和音頻。

并行處理多個(gè)音頻流:Moshi 能夠同時(shí)處理用戶(hù)和系統(tǒng)的語(yǔ)音流。這種多流處理能力讓Moshi不僅能夠生成自己的語(yǔ)音,還能實(shí)時(shí)理解并響應(yīng)用戶(hù)的語(yǔ)音。

情緒和言語(yǔ)動(dòng)態(tài)處理:通過(guò)直接處理語(yǔ)音而不是中間文本,Moshi 能夠理解和生成充滿(mǎn)情感的語(yǔ)音,并處理復(fù)雜的對(duì)話(huà)動(dòng)態(tài),例如情緒表達(dá)、聲音變化等。

支持復(fù)雜的對(duì)話(huà)動(dòng)態(tài):Moshi 能夠處理自然對(duì)話(huà)的復(fù)雜動(dòng)態(tài),例如打斷、交錯(cuò)、感嘆詞和響應(yīng)。傳統(tǒng)系統(tǒng)依賴(lài)于清晰的對(duì)話(huà)輪流(一個(gè)人在另一個(gè)人輪流之前發(fā)言),但 Moshi 消除了這一限制,使對(duì)話(huà)更加自然。

Moshi的模型架構(gòu)

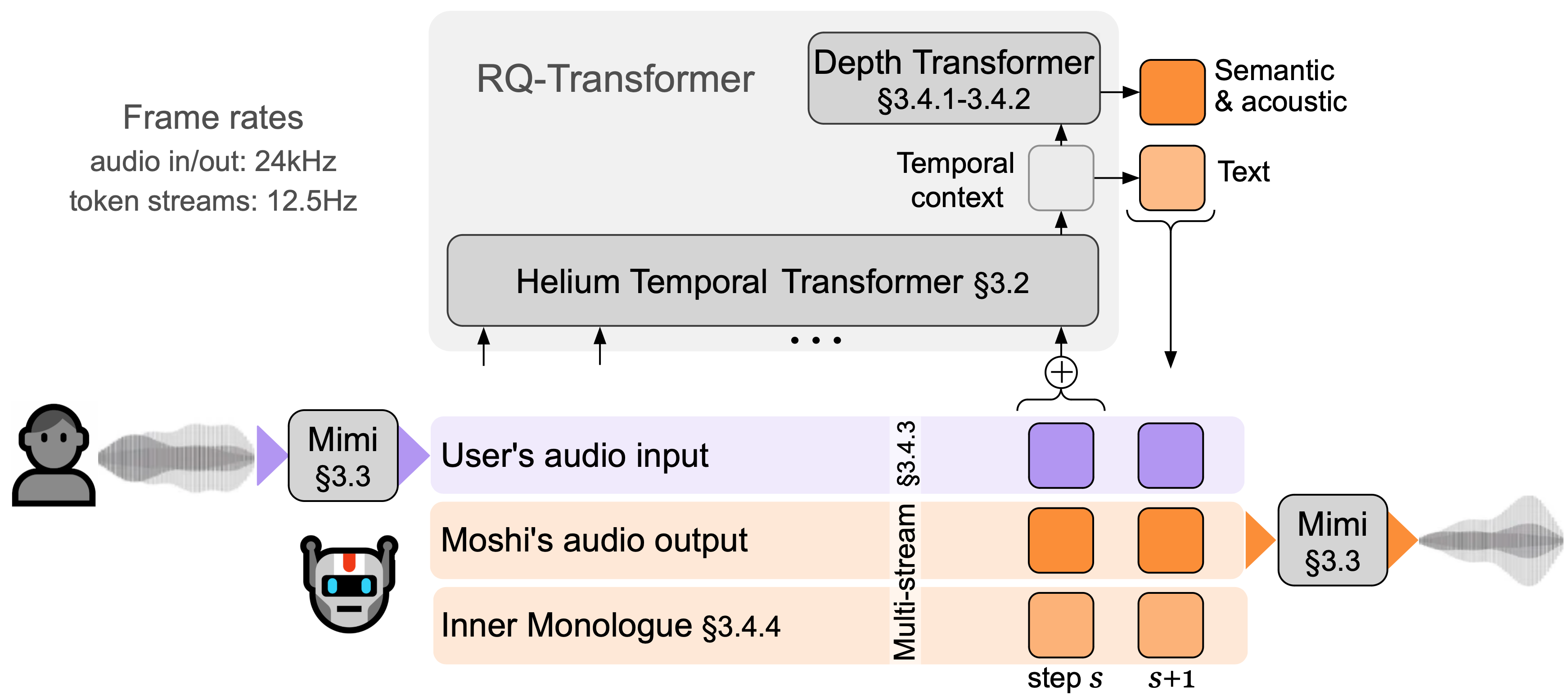

Moshi 由三個(gè)主要部分組成: Helium,一個(gè)用 2.1 萬(wàn)億個(gè) token 訓(xùn)練的 7B 語(yǔ)言模型; Mimi,一種對(duì)語(yǔ)義和聲學(xué)信息進(jìn)行建模的神經(jīng)音頻編解碼器;以及新的多流架構(gòu),可以分別對(duì)用戶(hù)和 Moshi 的音頻進(jìn)行建模。

通過(guò)協(xié)同工作,這些模塊可以實(shí)現(xiàn)流暢的全雙工對(duì)話(huà)、情感表達(dá)以及復(fù)雜對(duì)話(huà)動(dòng)態(tài)的處理。

Helium 文本語(yǔ)言模型

氦氣是 Moshi 的核心。它是一個(gè)基于 Transformer 架構(gòu)(類(lèi)似于 GPT)的具有 70 億個(gè)參數(shù)的文本語(yǔ)言模型。 Helium為Moshi提供了強(qiáng)大的語(yǔ)言理解和生成能力,能夠處理復(fù)雜的文本推理和對(duì)話(huà)任務(wù)。

其訓(xùn)練數(shù)據(jù)包括 2.1 萬(wàn)億個(gè)英語(yǔ)單詞,賦予其廣泛的知識(shí)和語(yǔ)言能力。

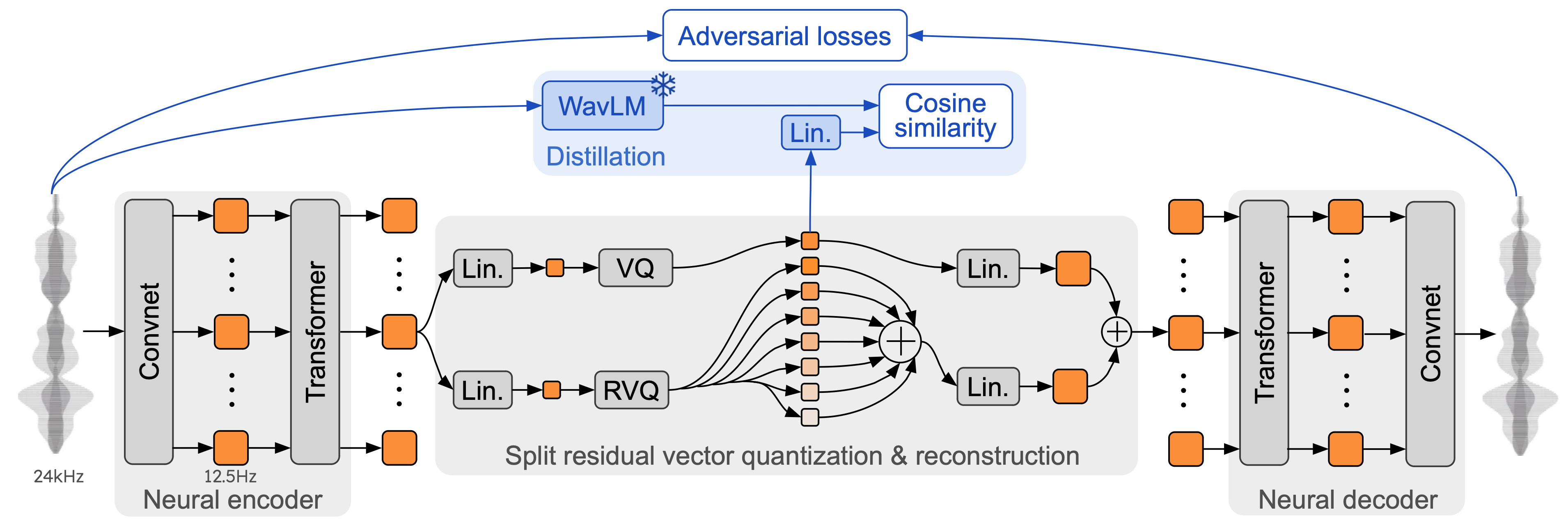

Mimi 神經(jīng)音頻編解碼器:Mimi是 Moshi 的音頻處理組件。它是一種神經(jīng)網(wǎng)絡(luò)音頻編解碼器,負(fù)責(zé)將音頻轉(zhuǎn)換為離散語(yǔ)音標(biāo)記,并能夠反向生成高質(zhì)量的語(yǔ)音輸出。

Mimi使用殘差矢量量化(RVQ)技術(shù)將語(yǔ)音數(shù)據(jù)編碼為離散的語(yǔ)音和語(yǔ)義標(biāo)記,確保高語(yǔ)音保真度和語(yǔ)言一致性。

通過(guò)結(jié)合語(yǔ)義和聲學(xué)標(biāo)記,Mimi 不僅可以生成自然語(yǔ)音,還可以處理復(fù)雜的語(yǔ)音上下文和情感信息。

內(nèi)心獨(dú)白法:內(nèi)部獨(dú)白方法是 Moshi 語(yǔ)音生成的關(guān)鍵技術(shù),它允許模型在生成語(yǔ)音之前預(yù)測(cè)與音頻同步的文本標(biāo)簽。這種方法不僅提高了生成語(yǔ)音的語(yǔ)言質(zhì)量,還讓Moshi能夠在流媒體環(huán)境下實(shí)現(xiàn)語(yǔ)音識(shí)別和文本到語(yǔ)音的轉(zhuǎn)換功能。

同步生成文本和語(yǔ)音:在生成音頻之前,Moshi 生成與其語(yǔ)音輸出相對(duì)應(yīng)的文本流。該文本流作為語(yǔ)音生成的基礎(chǔ),使語(yǔ)音生成更加準(zhǔn)確,有助于處理復(fù)雜的對(duì)話(huà)場(chǎng)景。

流媒體兼容性:這種方法允許 Moshi 處理語(yǔ)音,同時(shí)仍然在流媒體環(huán)境中實(shí)現(xiàn)高效的語(yǔ)音識(shí)別和文本轉(zhuǎn)語(yǔ)音 (TTS)。

該模型架構(gòu)旨在處理多個(gè)并行音頻流并實(shí)時(shí)生成語(yǔ)音和文本。 Moshi 可以在處理用戶(hù)語(yǔ)音的同時(shí)生成系統(tǒng)語(yǔ)音,這使其能夠支持不間斷的自然對(duì)話(huà)。

Moshi詳細(xì)技術(shù)方法

1. 語(yǔ)音到語(yǔ)音生成架構(gòu)

Moshi 的核心創(chuàng)新在于將語(yǔ)音對(duì)話(huà)視為語(yǔ)音到語(yǔ)音的生成任務(wù),而不是傳統(tǒng)的文本到語(yǔ)音再到語(yǔ)音的多組件過(guò)程。傳統(tǒng)的語(yǔ)音對(duì)話(huà)系統(tǒng)包括語(yǔ)音活動(dòng)檢測(cè)(VAD)、語(yǔ)音識(shí)別(ASR)、自然語(yǔ)言理解(NLU)、自然語(yǔ)言生成(NLG)和文本轉(zhuǎn)語(yǔ)音(TTS)等多個(gè)獨(dú)立模塊。

Moshi 直接生成語(yǔ)音標(biāo)記,使得語(yǔ)音在理解和生成過(guò)程中不依賴(lài)于中間文本表示,從而避免了信息(例如情感、語(yǔ)氣和非語(yǔ)言聲音)的丟失。

2. Helium 文本語(yǔ)言模型

Moshi 基于 Helium 文本語(yǔ)言模型,這是一個(gè)具有 7B 參數(shù)的大型文本生成模型。 Helium經(jīng)過(guò)2.1萬(wàn)億英文數(shù)據(jù)預(yù)訓(xùn)練,具有強(qiáng)大的語(yǔ)言理解、推理和生成能力。它是 Moshi 的語(yǔ)義理解基礎(chǔ),支持復(fù)雜的自然語(yǔ)言處理功能,包括開(kāi)放式對(duì)話(huà)和問(wèn)答。

氦氣的主要特點(diǎn):

自回歸 Transformer 架構(gòu):Moshi 基于 Helium,一種基于 Transformer 架構(gòu)的文本語(yǔ)言模型。與經(jīng)典的 Transformer 類(lèi)似,Helium 使用多層注意力機(jī)制和自回歸建模方法來(lái)處理文本輸入并生成輸出。該模型有7B個(gè)參數(shù),足以支持大規(guī)模語(yǔ)料庫(kù)的學(xué)習(xí)。

RMS歸一化:在注意力模塊、前饋模塊、輸出層使用RMS歸一化,提高模型的訓(xùn)練穩(wěn)定性。

旋轉(zhuǎn)位置編碼(RoPE) :用于處理較長(zhǎng)的上下文窗口(4096 個(gè)令牌),以確保模型可以捕獲對(duì)話(huà)中的遠(yuǎn)程依賴(lài)關(guān)系。

高效的 FlashAttention :通過(guò)優(yōu)化的注意力計(jì)算,長(zhǎng)序列輸入下的模型推理更加高效。

3.Mimi神經(jīng)音頻編解碼器

Mimi 是 Moshi 中用于語(yǔ)音處理的神經(jīng)音頻編解碼器。它的任務(wù)是將連續(xù)的語(yǔ)音信號(hào)離散化為音頻標(biāo)記。這些離散的音頻標(biāo)記類(lèi)似于文本標(biāo)記,可以表示語(yǔ)音中的詳細(xì)信息。 Mimi采用殘差矢量量化(RVQ)技術(shù),以較低的比特率保留高質(zhì)量的音頻,支持實(shí)時(shí)語(yǔ)音生成和處理。

咪咪關(guān)鍵技術(shù):

殘差矢量量化(RVQ) :Mimi使用多級(jí)殘差矢量量化將復(fù)雜的音頻信號(hào)離散化為多個(gè)級(jí)別的音頻令牌。這種方法允許每個(gè)時(shí)間步驟有效地編碼語(yǔ)音的語(yǔ)義和聲學(xué)信息,同時(shí)確保音頻重建的質(zhì)量。

語(yǔ)義和聲學(xué)標(biāo)記的組合:Mimi 使用的音頻標(biāo)記包括語(yǔ)義和聲學(xué)信息。語(yǔ)義標(biāo)記保留語(yǔ)音的內(nèi)容(例如所說(shuō)的特定單詞),而聲學(xué)標(biāo)記則描述語(yǔ)音的音頻特征,例如音色、情感和語(yǔ)調(diào)。

流式編碼和解碼:Mimi支持流式傳輸,可以在實(shí)時(shí)對(duì)話(huà)中實(shí)現(xiàn)連續(xù)的語(yǔ)音生成和識(shí)別。這使得Moshi的反應(yīng)速度非常接近自然對(duì)話(huà)。

4. RQ-Transformer的架構(gòu)

Moshi 采用多流分層生成架構(gòu),可以并行處理多個(gè)音頻流。 Moshi 通過(guò)同時(shí)對(duì)用戶(hù)的語(yǔ)音流和系統(tǒng)自身的語(yǔ)音流進(jìn)行建模,實(shí)現(xiàn)對(duì)話(huà)中的靈活交互,允許復(fù)雜的對(duì)話(huà)動(dòng)態(tài),例如說(shuō)話(huà)者之間的交錯(cuò)、中斷和感嘆詞。

這是先前提出的用于離散圖像生成的架構(gòu),并且可以在不增加 Helium 序列長(zhǎng)度的情況下對(duì)語(yǔ)義和聲學(xué)標(biāo)記的層次結(jié)構(gòu)進(jìn)行建模。這意味著每一秒的音頻只需要通過(guò)7B骨干模型12.5次,就可以在L4或M3 Macbook pro上實(shí)時(shí)運(yùn)行!與 MusicGen 的令牌延遲相結(jié)合,這為音頻語(yǔ)言建模提供了最先進(jìn)的性能。

分層自回歸建模:Moshi 使用 RQ-Transformer(Residual Quantizer Transformer)將音頻標(biāo)記分解為多個(gè)級(jí)別,并通過(guò)分層自回歸建模生成音頻。具體來(lái)說(shuō),模型首先使用較大的 Temporal Transformer 來(lái)處理時(shí)間序列,然后使用較小的 Depth Transformer 在每個(gè)時(shí)間步處理多個(gè)子序列。這種設(shè)計(jì)大大提高了生成長(zhǎng)音頻序列的效率。

多模態(tài)序列生成:模型同時(shí)生成多個(gè)序列(包括文本、語(yǔ)義標(biāo)記和音頻標(biāo)記),并通過(guò)內(nèi)部獨(dú)白機(jī)制確保它們?cè)跁r(shí)間上精確對(duì)齊。每個(gè)時(shí)間步生成的內(nèi)容不僅包含當(dāng)前語(yǔ)音,還包含相應(yīng)的文本前綴,使得生成的語(yǔ)音內(nèi)容在語(yǔ)義上更具邏輯性。

Architecture of RQ-Transformer

5、“內(nèi)心獨(dú)白”機(jī)制

Moshi的“內(nèi)心獨(dú)白”機(jī)制是其語(yǔ)音生成的關(guān)鍵創(chuàng)新之一。通過(guò)這種機(jī)制,Moshi 在生成音頻之前預(yù)測(cè)相應(yīng)的時(shí)間對(duì)齊文本標(biāo)記。這不僅提高了生成語(yǔ)音的語(yǔ)言一致性,還支持實(shí)時(shí)語(yǔ)音識(shí)別(ASR)和文本到語(yǔ)音(TTS)轉(zhuǎn)換。

“內(nèi)心獨(dú)白”機(jī)制的特點(diǎn):

對(duì)齊的文本和音頻生成:Moshi 首先預(yù)測(cè)文本,然后生成音頻,使生成的語(yǔ)音在語(yǔ)法和內(nèi)容上更加準(zhǔn)確和流暢。

延遲機(jī)制:通過(guò)在文本和音頻之間引入延遲,Moshi 可以分別執(zhí)行 ASR 和 TTS 任務(wù)。例如,先生成文本,后生成音頻,則模型為T(mén)TS模式;否則,處于 ASR 模式。 Moshi 可以在這兩種模式之間無(wú)縫切換,確保模型既能生成又能識(shí)別語(yǔ)音。

Moshi: Delay mechanism

Moshi: TTS mode

6.多流建模

Moshi 的架構(gòu)允許同時(shí)處理多個(gè)音頻流,既可以監(jiān)控用戶(hù)的語(yǔ)音,也可以生成系統(tǒng)自己的語(yǔ)音。在對(duì)話(huà)過(guò)程中,Moshi 可以動(dòng)態(tài)處理音頻的重疊部分(例如中斷、交錯(cuò)),而無(wú)需提前明確劃分揚(yáng)聲器輪流。這項(xiàng)技術(shù)使對(duì)話(huà)更加自然。

同步生成語(yǔ)義和聲音令牌:Moshi 使用并行語(yǔ)義和音頻令牌生成機(jī)制,并通過(guò)引入時(shí)間延遲來(lái)優(yōu)化這些令牌之間的依賴(lài)關(guān)系。通過(guò)對(duì)用戶(hù)和系統(tǒng)的音頻流進(jìn)行精確建模,Moshi能夠靈活應(yīng)對(duì)復(fù)雜的對(duì)話(huà)場(chǎng)景。

雙流音頻處理:Moshi 同時(shí)處理用戶(hù)和系統(tǒng)語(yǔ)音流,并通過(guò)并行建模兩個(gè)自回歸音頻流來(lái)實(shí)現(xiàn)全雙工會(huì)話(huà)。這種設(shè)計(jì)使模型能夠應(yīng)對(duì)自然對(duì)話(huà)中的重疊語(yǔ)音和中斷。

語(yǔ)義和音頻的延遲對(duì)齊:通過(guò)在語(yǔ)義標(biāo)記和音頻標(biāo)記之間引入延遲,確保生成的語(yǔ)音內(nèi)容連貫且高效。延遲可能是 1 到 2 幀,具體取決于對(duì)話(huà)動(dòng)態(tài)。

Moshi: Multi-stream modeling

7. 模型訓(xùn)練與微調(diào)

大規(guī)模預(yù)訓(xùn)練:Moshi 的文本語(yǔ)言模型(Helium)通過(guò)對(duì)超過(guò) 2.1 萬(wàn)億個(gè)英文 token 的預(yù)訓(xùn)練,擁有豐富的語(yǔ)言理解和生成能力。該模型經(jīng)過(guò)大規(guī)模文本和語(yǔ)音數(shù)據(jù)的訓(xùn)練,可以處理各種復(fù)雜的對(duì)話(huà)場(chǎng)景。

無(wú)監(jiān)督和有監(jiān)督多階段訓(xùn)練:Moshi首先對(duì)大規(guī)模無(wú)監(jiān)督語(yǔ)音數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,然后對(duì)包含自然對(duì)話(huà)的多流數(shù)據(jù)進(jìn)行后訓(xùn)練,最后進(jìn)行指令微調(diào),使其在實(shí)際對(duì)話(huà)中表現(xiàn)更好。

Helium預(yù)訓(xùn)練:首先,在大規(guī)模文本數(shù)據(jù)集上預(yù)訓(xùn)練Helium文本語(yǔ)言模型,以提高其語(yǔ)言理解和推理能力。

Moshi 預(yù)訓(xùn)練:在未標(biāo)記的音頻數(shù)據(jù)集上訓(xùn)練多流音頻模型,以學(xué)習(xí)處理語(yǔ)音生成和語(yǔ)義理解。

多流微調(diào):使用Fisher數(shù)據(jù)集(包含兩路語(yǔ)音對(duì)話(huà)數(shù)據(jù))對(duì)模型進(jìn)行微調(diào),提高其處理多流語(yǔ)音輸入的能力。

指令微調(diào):最后利用生成的指令對(duì)話(huà)數(shù)據(jù)進(jìn)行微調(diào),以增強(qiáng)模型在自然對(duì)話(huà)場(chǎng)景下的性能。

數(shù)據(jù)增強(qiáng):在訓(xùn)練過(guò)程中,Moshi使用了數(shù)據(jù)增強(qiáng)技術(shù),例如添加背景噪聲、模擬用戶(hù)回聲等,使模型能夠在不同的語(yǔ)音環(huán)境下穩(wěn)定表現(xiàn),增強(qiáng)其魯棒性。

Moshi的性能評(píng)估

1. 語(yǔ)音生成的質(zhì)量和一致性

語(yǔ)音清晰度:Moshi 在語(yǔ)音生成方面表現(xiàn)出色,實(shí)驗(yàn)表明它可以生成高質(zhì)量且易于理解的語(yǔ)音。它可以在生成過(guò)程中保持語(yǔ)音連貫性,尤其是在長(zhǎng)對(duì)話(huà)中,這是復(fù)雜上下文中對(duì)話(huà)模型的重要性能指標(biāo)。

語(yǔ)音的自然性和一致性:通過(guò)使用Mimi神經(jīng)音頻編解碼器,Moshi可以生成高保真語(yǔ)音并保持系統(tǒng)語(yǔ)音的一致性。此外,該模型能夠根據(jù)不同的對(duì)話(huà)上下文生成適當(dāng)?shù)那榫w語(yǔ)調(diào),提高用戶(hù)體驗(yàn)的自然度。

2. 實(shí)時(shí)響應(yīng)性能

低延遲:Moshi的延遲理論上為160毫秒,實(shí)際測(cè)試約為200毫秒。這意味著Moshi可以近乎實(shí)時(shí)地響應(yīng)用戶(hù)輸入,顯著提高交互的流暢度和用戶(hù)的對(duì)話(huà)體驗(yàn)。

全雙工通信能力:Moshi在測(cè)試中展示了其同時(shí)接收和生成語(yǔ)音的能力。這種全雙工功能使其能夠處理重疊語(yǔ)音和對(duì)話(huà)中斷,顯示出接近自然人類(lèi)對(duì)話(huà)的響應(yīng)速度。

3. 語(yǔ)音識(shí)別和對(duì)話(huà)理解

自動(dòng)語(yǔ)音識(shí)別(ASR) :通過(guò)內(nèi)部獨(dú)白方法,Moshi 將文本和語(yǔ)音流結(jié)合起來(lái),顯著提高語(yǔ)音識(shí)別的準(zhǔn)確性。該模型不僅捕獲用戶(hù)的語(yǔ)音輸入,還通過(guò)首先生成文本預(yù)測(cè)來(lái)增強(qiáng)系統(tǒng)的響應(yīng)準(zhǔn)確性。

對(duì)話(huà)理解和推理能力:Moshi使用Helium語(yǔ)言模型進(jìn)行文本理解和推理,這使得它在處理復(fù)雜問(wèn)題、開(kāi)放式對(duì)話(huà)和知識(shí)問(wèn)答方面表現(xiàn)良好。實(shí)驗(yàn)結(jié)果表明,Moshi 可以有效地理解上下文并提供合理的答案。

4. 多流語(yǔ)音處理的魯棒性

重疊語(yǔ)音處理:Moshi 能夠在評(píng)估中處理復(fù)雜的對(duì)話(huà)場(chǎng)景,例如多個(gè)語(yǔ)音流的重疊對(duì)話(huà)。這對(duì)于現(xiàn)實(shí)應(yīng)用中的多任務(wù)處理非常重要,因?yàn)樽匀粚?duì)話(huà)通常會(huì)涉及中斷和重疊語(yǔ)音。

多上下文對(duì)話(huà)處理:Moshi 在多個(gè)數(shù)據(jù)流上進(jìn)行訓(xùn)練,能夠在不同的對(duì)話(huà)場(chǎng)景中表現(xiàn)良好,無(wú)論是單個(gè)用戶(hù)的語(yǔ)音流還是同時(shí)與多個(gè)用戶(hù)的對(duì)話(huà)。

5. 問(wèn)答和知識(shí)獲取

Moshi 在問(wèn)答和知識(shí)獲取任務(wù)方面優(yōu)于當(dāng)前的其他語(yǔ)音對(duì)話(huà)系統(tǒng)。憑借強(qiáng)大的文本理解能力和實(shí)時(shí)語(yǔ)音生成能力,Moshi 可以處理多輪問(wèn)答,準(zhǔn)確提取并回復(fù)用戶(hù)問(wèn)題。

語(yǔ)言推理和常識(shí)問(wèn)答:該模型能夠處理復(fù)雜的推理任務(wù),并且在自然語(yǔ)言處理(NLP)的各種標(biāo)準(zhǔn)評(píng)估中表現(xiàn)良好,例如常識(shí)問(wèn)答、閱讀理解和開(kāi)放式問(wèn)答。

6.語(yǔ)音情感與個(gè)性化生成

情感語(yǔ)音生成:Moshi 在評(píng)估中展示了其生成情感語(yǔ)音的能力。它能夠根據(jù)對(duì)話(huà)的上下文生成具有不同情緒的語(yǔ)音輸出,例如憤怒、快樂(lè)或悲傷。

個(gè)性化語(yǔ)音風(fēng)格:通過(guò)訓(xùn)練過(guò)程中的指令微調(diào),Moshi可以根據(jù)用戶(hù)需求生成不同風(fēng)格或特定角色的語(yǔ)音。這種個(gè)性化的能力使其在特定的對(duì)話(huà)場(chǎng)景下表現(xiàn)更加多樣化。

7、安全可靠

安全對(duì)話(huà)評(píng)估:Moshi 在處理包含敏感或不適當(dāng)內(nèi)容的對(duì)話(huà)時(shí)表現(xiàn)出良好的安全性。它能夠有效識(shí)別并避免生成不當(dāng)內(nèi)容,確保對(duì)話(huà)的安全性和道德性。

魯棒性和對(duì)噪聲環(huán)境的適應(yīng):在噪聲和復(fù)雜環(huán)境的評(píng)估中,Moshi表現(xiàn)出了良好的魯棒性。通過(guò)數(shù)據(jù)增強(qiáng)技術(shù)(例如噪聲添加和回聲處理),該模型能夠應(yīng)對(duì)不同的語(yǔ)音環(huán)境,并保證在噪聲環(huán)境下的高質(zhì)量輸出。

八、綜合測(cè)試結(jié)果

Moshi的綜合性能測(cè)試表明,其在語(yǔ)音生成、對(duì)話(huà)理解、實(shí)時(shí)響應(yīng)、復(fù)雜對(duì)話(huà)處理等方面取得了領(lǐng)先的成績(jī)。尤其是,Moshi 在處理重疊對(duì)話(huà)、語(yǔ)音中斷、情感產(chǎn)生等方面的表現(xiàn)遠(yuǎn)遠(yuǎn)超過(guò)傳統(tǒng)對(duì)話(huà)系統(tǒng)。

技術(shù)報(bào)告: https://kyutai.org/Moshi.pdf

GitHub: https://github.com/kyutai-labs/moshi

模型下載: https ://huggingface.co/collections/kyutai/moshi-v01-release-66eaeaf3302bef6bd9ad7acd

在線嘗試: https://moshi.chat/

相關(guān)資訊:

MoshiVis:一款能聽(tīng)還能看,并用流暢的語(yǔ)音跟你討論圖像內(nèi)容的視覺(jué)語(yǔ)音模型

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI