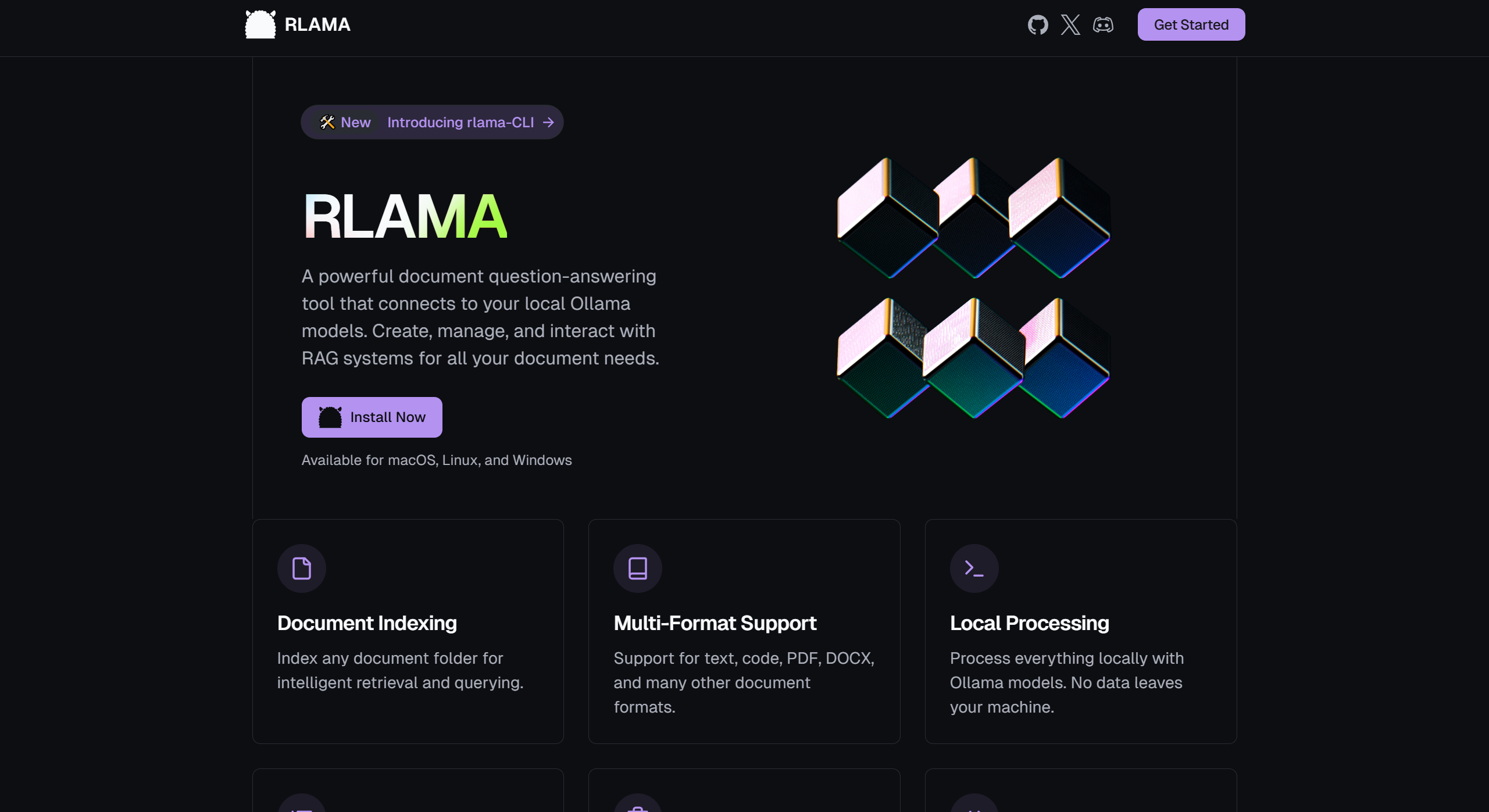

RLAMA:開源的本地文檔問答工具,可高效管理和檢索文檔

RLAMA是什么?

RLAMA是一個由 DonTizi 開發(fā)的開源工具,用于創(chuàng)建、管理和與基于文檔的檢索增強生成(Retrieval-Augmented Generation, RAG)系統(tǒng)進行交互。RLAMA通過連接到本地的Ollama模型,為用戶提供強大的文檔問答功能。

RLAMA主要功能

創(chuàng)建RAG系統(tǒng):通過指定文件夾路徑,RLAMA可以對文件夾中的文檔進行索引,并創(chuàng)建一個RAG系統(tǒng)。

交互式問答:用戶可以通過命令行與RAG系統(tǒng)進行交互,提出問題并獲取基于文檔內(nèi)容的答案。

管理RAG系統(tǒng):用戶可以列出所有已創(chuàng)建的RAG系統(tǒng),或者刪除不再需要的系統(tǒng)。

更新與版本管理:RLAMA支持通過命令行更新到最新版本,并顯示當(dāng)前版本信息。

RLAMA技術(shù)棧

核心語言:Go,因其高性能、跨平臺兼容性和單二進制分發(fā)特性。

命令行框架:Cobra,用于構(gòu)建命令行界面。

LLM集成:通過Ollama API實現(xiàn)嵌入和補全功能。

存儲:基于本地文件系統(tǒng)(JSON文件)的存儲,簡單且便于移植。

向量搜索:自定義實現(xiàn)余弦相似度算法,用于嵌入檢索。

RLAMA的應(yīng)用場景

技術(shù)團隊的文檔管理:幫助團隊成員快速找到所需的代碼示例或解決方案。

研究人員的知識檢索:快速定位關(guān)鍵內(nèi)容。

個人知識管理:作為強大的知識庫工具,幫助個人用戶快速找到所需內(nèi)容。

RLAMA安裝使用

1、安裝:通過終端運行以下命令即可:

curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh

2、使用:用戶可以通過簡單的命令行指令創(chuàng)建、管理和使用RAG系統(tǒng)。

RLAMA優(yōu)勢

數(shù)據(jù)安全:所有數(shù)據(jù)都在本地處理,不用擔(dān)心隱私泄露。

高效問答:通過強大的語言模型,快速理解問題并提供相關(guān)答案。

簡單易用:安裝和使用簡單,適合新手。

開源項目:可以根據(jù)需求進行定制,參與社區(qū)開發(fā)。

RLAMA支持的文檔格式

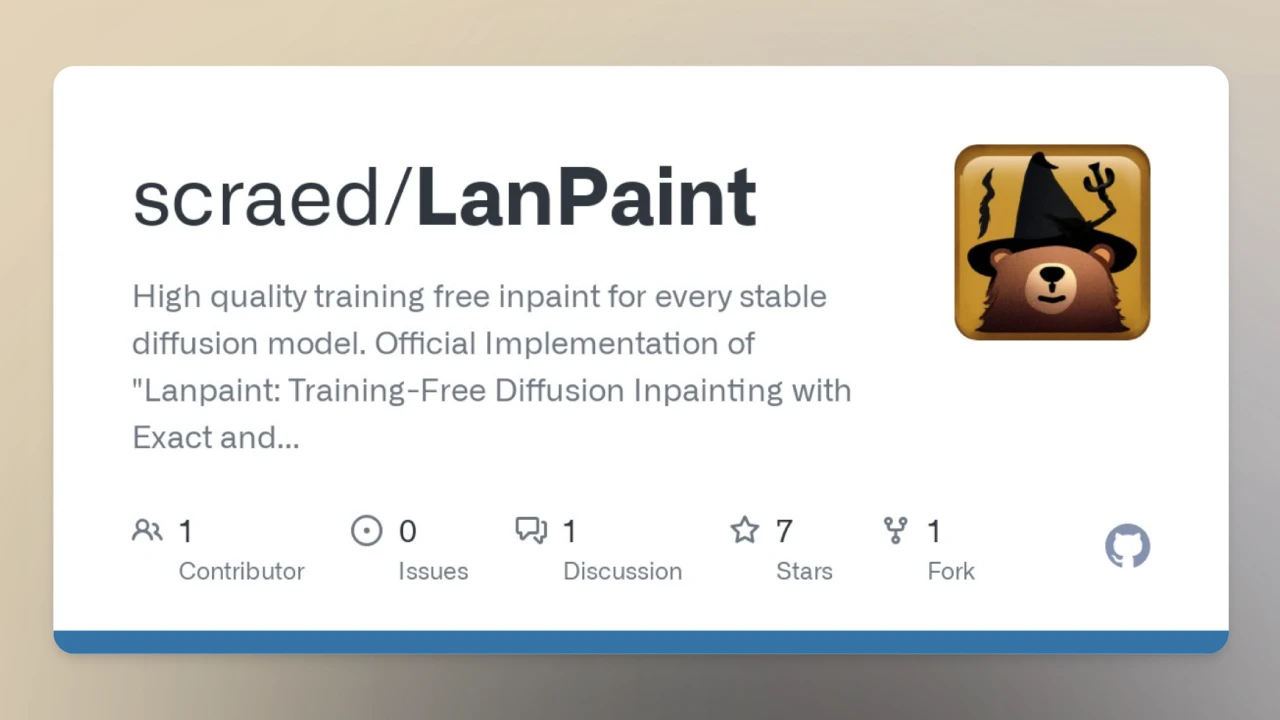

GitHub倉庫地址:https://github.com/dontizi/rlama

RLAMA官網(wǎng):https://rlama.dev/

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺

開源AI應(yīng)用平臺