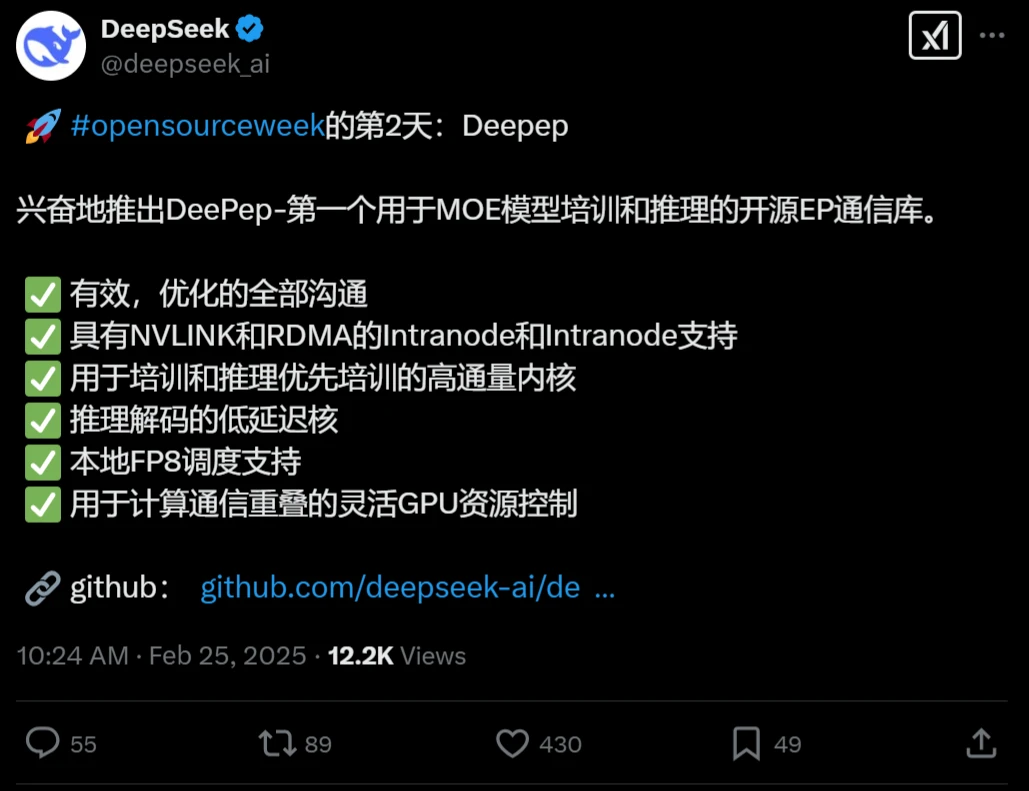

DeepSeek開源周第二天開源項目:Deepep

昨天是DeepSeek ai開源周第一天,開源的項目是FlashMLA,不到半小時,Github已經已經300多Star了,短短1小時就超過10W閱讀,非常的火爆,今天是DeepSeek開源周的第二天,DeepSeek開源了第2個項目:Deepep。

什么是Deepep?

Deepep是一個用于MOE模型培訓和推理的開源EP通信庫。它基于先進的混合專家架構,充分利用了大規模數據集以提高其預訓練和微調的有效性。DeepEP的設計導向是減少計算負擔與內存使用,使得用戶能夠在常規硬件上有效運行大規模模型。

Deepep的功能特點

MoE架構優化:

DeepEP專為Mixture-of-Experts (MoE) 和專家并行 (EP) 設計,提供高效的all-to-all GPU內核,適用于訓練和推理任務。

支持低精度運算,包括FP8和BF16,提升計算效率,節省顯存。

高性能通信:

提供高吞吐量和低延遲的通信內核,支持NVLink和RDMA網絡。在H800 GPU上測試,最大帶寬可達153 GB/s (NVLink) 和46 GB/s (RDMA)。

針對NVLink到RDMA的非對稱帶寬轉發場景進行了優化,確保高吞吐量表現。

低延遲通信:

提供純RDMA的低延遲內核,特別適合推理解碼階段,延遲低至163微秒。

引入基于hook的通信-計算重疊方法,不占用GPU SM資源,最大化計算效率。

硬件優化:

利用未公開的PTX指令提升Hopper架構的性能。

支持InfiniBand網絡,并理論上兼容RoCE,提供靈活的網絡配置選項。

Deepep的應用場景

大規模模型訓練:

適用于Mixture-of-Experts (MoE) 模型的訓練,提供高效的并行通信支持,顯著提升訓練效率。

推理任務:

特別適合延遲敏感的推理解碼場景,顯著提升效率,降低延遲,提高推理吞吐量。

高性能計算需求:

完美適配現代高性能計算需求,支持多種硬件平臺,包括Hopper GPU架構,未來可能擴展更多設備。

Deepep的使用與集成

易用性:

支持Hopper GPU架構,需要Python 3.8+、CUDA 12.3+和PyTorch 2.1+環境。

安裝時需搭配團隊修改版的NVSHMEM,安裝指南詳細。

集成方式:

開源且易于集成,只需幾行命令即可構建并運行測試。

安裝后導入deep_ep模塊即可直接使用,提供示例代碼和測試腳本。

DeepEP已在GitHub上開源,地址:https://github.com/deepseek-ai/DeepEP

1. DeepSeek開源周第一天開源項目:DeepSeek FlashMLA

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺