MOSS-TTSD:開源雙語對話語音合成模型

MOSS-TTSD是清華大學語音與語言實驗室聯(lián)合騰訊 ai Lab 等機構開發(fā)的開源雙語對話語音合成模型。它支持中英文,能把兩個說話者的對話腳本轉(zhuǎn)換成自然、有表現(xiàn)力的對話語音。該模型基于 Qwen3-1.7B-base 模型繼續(xù)訓練,用離散化語音序列建模,通過 XY-Tokenizer 把語音壓縮到 1kbps,同時保留語義和聲學信息。

MOSS-TTSD模型支持中英雙語,能零樣本克隆多個說話人的音色,最長可生成 960 秒的語音,適合 AI 播客、影視配音、長篇訪談等場景。它的模型權重、推理代碼和 API 接口都已開源,還支持免費商業(yè)使用。

主要特點

?高表現(xiàn)力的對話語音:依托統(tǒng)一的語義 - 聲學神經(jīng)音頻編解碼器、預訓練的大型語言模型,以及數(shù)百萬小時的 TTS 數(shù)據(jù)和 40 萬小時的合成與真實對話語音構建,能生成有自然對話韻律、表現(xiàn)力強的類人對話語音。

?雙揚聲器語音克隆:支持零樣本雙揚聲器語音克隆,能根據(jù)對話腳本準確切換說話人,生成對話語音。

?中英雙語支持:可生成中英文兩種語言的高表現(xiàn)力語音。

?長語音生成:借助低比特率編解碼器和訓練框架優(yōu)化,專門針對長語音生成做了訓練。

?完全開源且可商用:MOSS-TTSD 及其未來更新會完全開源,且支持免費商業(yè)使用。

MOSS-TTSD技術原理

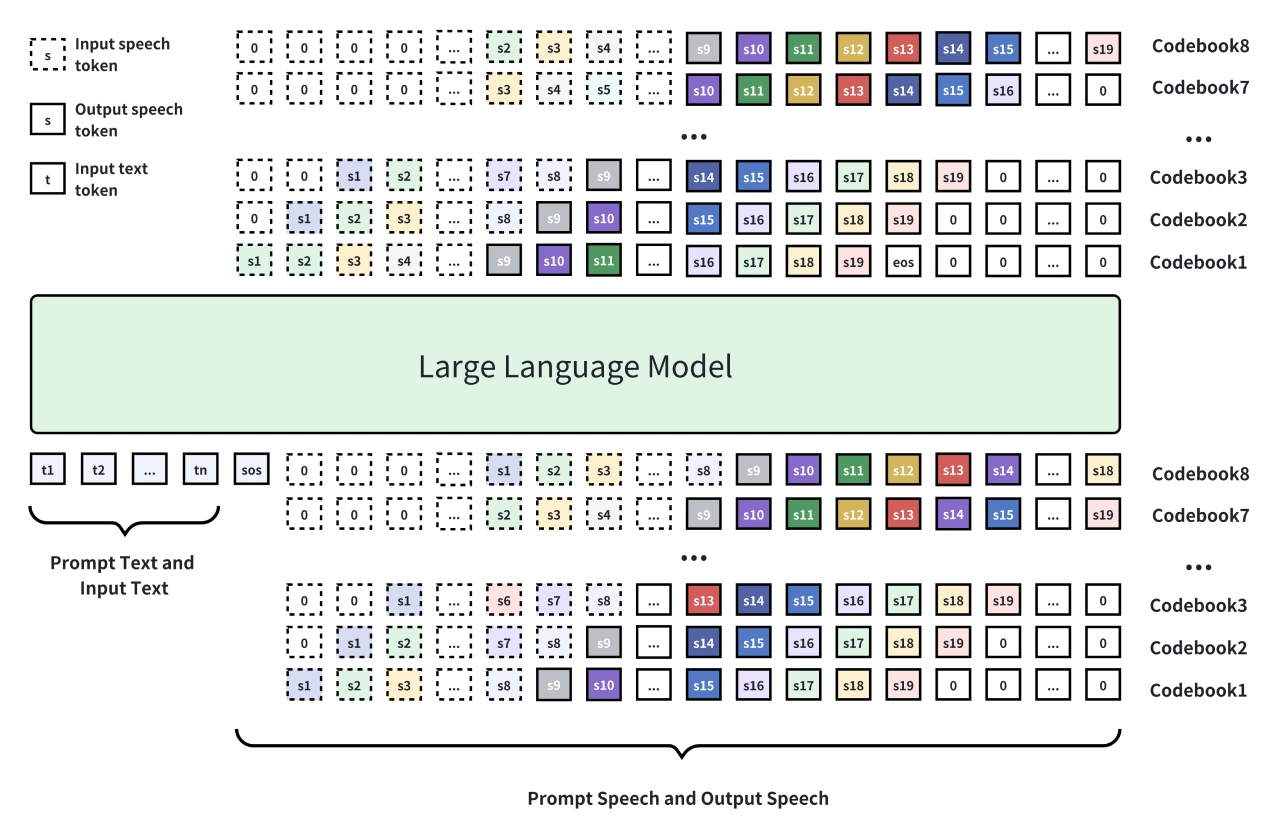

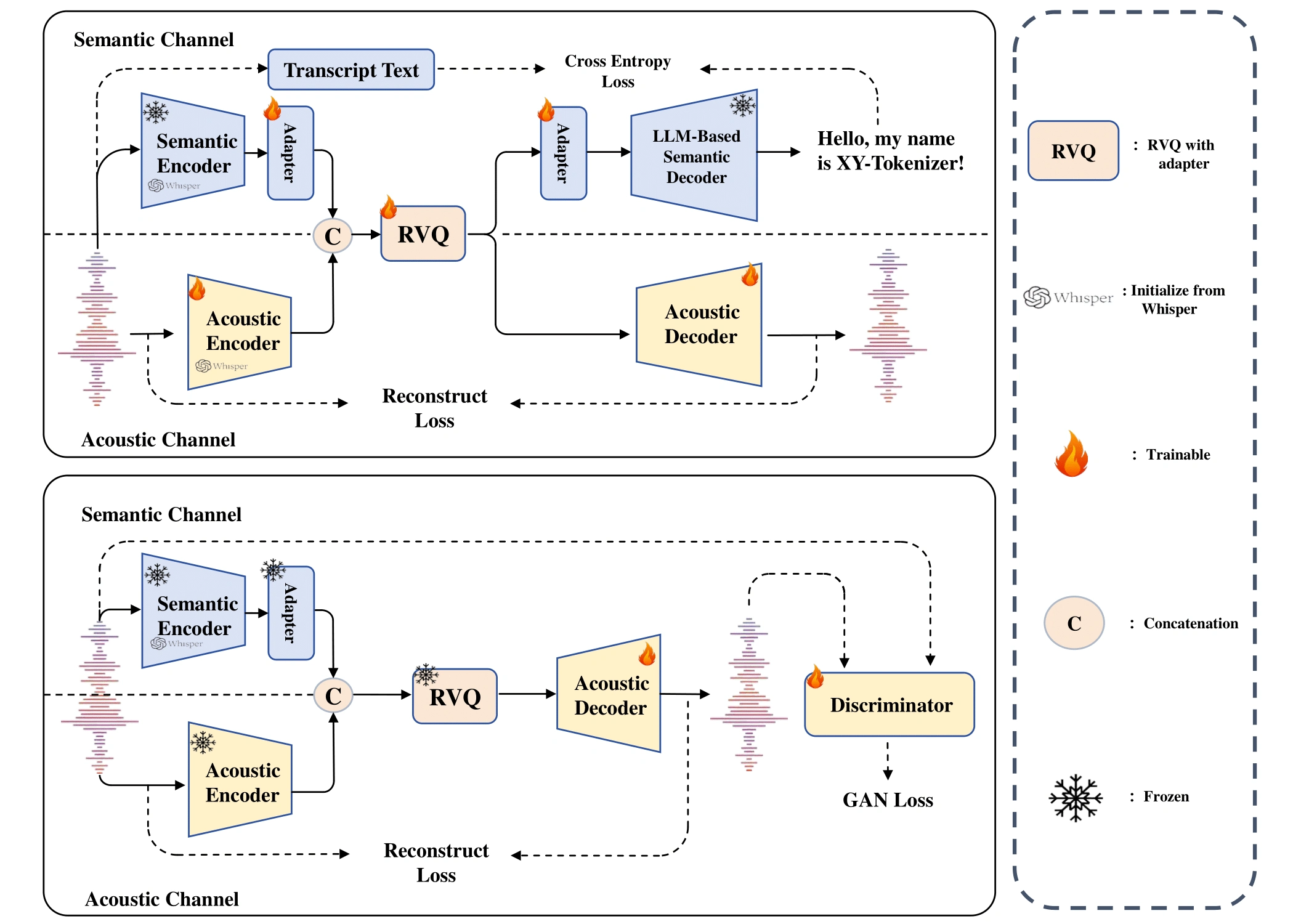

?模型架構:在 Qwen3-1.7B-base 模型基礎上微調(diào),采用離散化語音建模。通過 8 層 RVQ(殘差向量量化)把語音信號轉(zhuǎn)換成離散 token 序列,用自回歸方式結(jié)合 Delay Pattern 生成,最后由解碼器還原成語音。

?核心創(chuàng)新:XY-Tokenizer 有雙階段多任務學習流程。第一階段同時訓練自動語音識別(ASR)和語音重建任務,融合語義和粗粒度聲學信息;第二階段固定編碼器和量化器,只訓練解碼器,加入重建損失和 GAN 損失,增強細節(jié)表現(xiàn)。

?數(shù)據(jù)規(guī)模與預訓練:用約 100 萬小時的單說話人語音數(shù)據(jù)和 40 萬小時的對話語音數(shù)據(jù)訓練,數(shù)據(jù)經(jīng)過嚴格篩選和標注,還進行了中英文 TTS 預訓練。

應用場景

?AI 播客制作:MOSS-TTSD能自動把文本轉(zhuǎn)成多人對話的播客音頻,支持零樣本人聲克隆和長語音生成,能降低制作成本。

?影視配音與動畫:為影視作品、動畫生成自然對話語音,支持多語言切換,提高配音效率。

?長篇訪談與會議記錄:把訪談或會議文本轉(zhuǎn)成語音,保留對話的韻律和情感,方便存檔和分享。

優(yōu)勢與特點

?開源且商用友好:MOSS-TTSD模型權重、推理代碼和 API 接口都已開源,用戶可以免費商業(yè)使用。

?自然度和表現(xiàn)力:聲音自然度和表現(xiàn)力達到業(yè)界領先水平。

?支持聲音事件控制:比如笑聲等非語言聲音,讓語音更有表現(xiàn)力。

開源地址:https://github.com/OpenMOSS/MOSS-TTSD

MOSS-TTSD官網(wǎng):https://www.open-moss.com/cn/

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI