ContextGem:可從文檔中提取結構化數據的AI工具

ContextGem是什么?

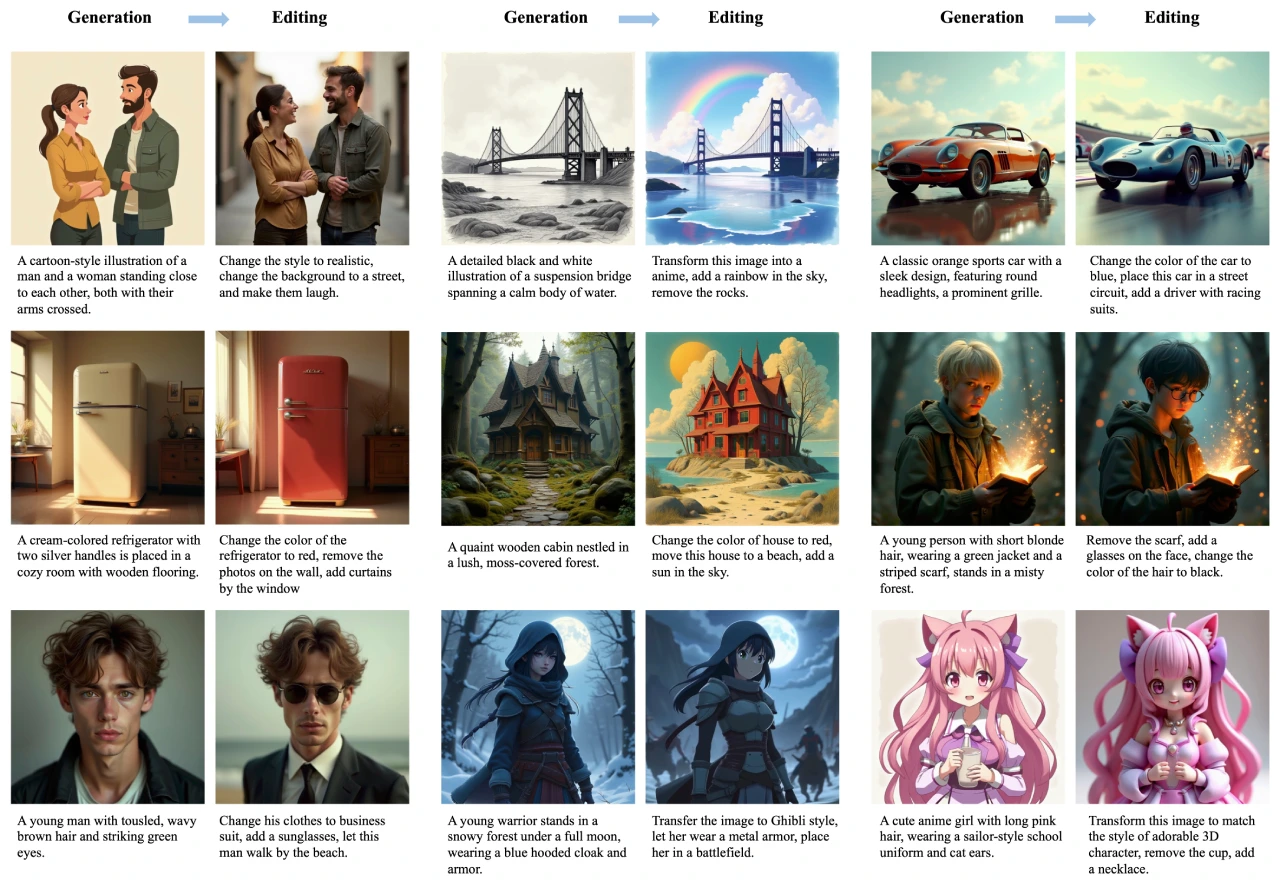

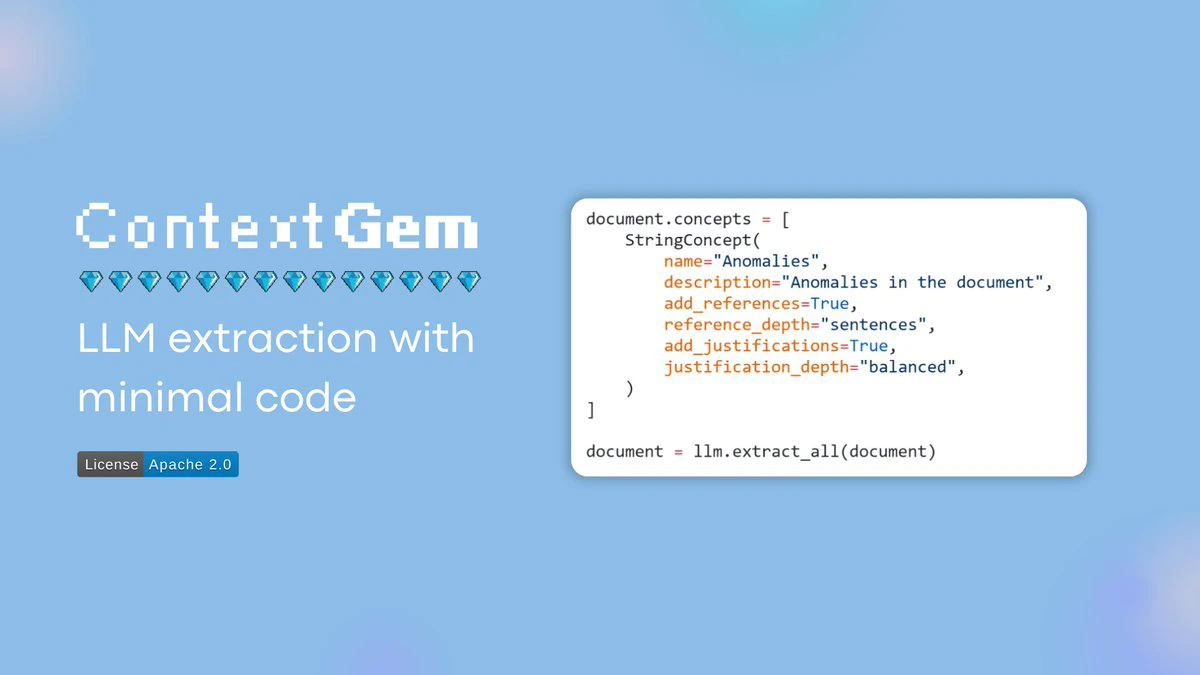

ContextGem是一款從文檔中提取結構化數據的ai工具,其核心能力在于能夠根據用戶指定的提取信息自動理解意圖,并精準定位到文檔中對應的內容,尤其擅長進行深度分析。

它非常適合需要大量閱讀文檔的場景,比如提取合同中的關鍵條款、報告中的重要數據、論文中的核心觀點等,幫助用戶高效地進行精讀。

ContextGem不僅能定位信息,告訴你具體在哪一段、哪一句話,還能解釋提取這些信息的原因以及推理過程。它通過幾行代碼就能完成復雜的提取任務,自動化程度非常高,許多復雜操作都被封裝好了。它能夠自動生成提示詞、自動進行數據驗證、自動分段,大大簡化了用戶的操作流程。

ContextGem核心功能

自動化動態提示:自動根據提取需求生成定制化的全面提示,無需手動編寫和維護提示。

自動生成數據模型和驗證器:自動從定義中創建 Pydantic 數據模型和驗證邏輯,避免重復編寫樣板代碼。

精確映射提取內容:自動將提取數據精確映射回源文檔的位置(精確到段落或句子級別),確保結果可驗證和可追溯。

提供提取理由:自動包括支持每條提取數據的文本理由或證據,增強結果的透明度和可信度。

智能文檔分割:利用最先進的神經分割(SaT)模型,準確地將文檔分割成段落和句子,并支持多種語言。

統一提取流程:允許在單一、聲明式且可重用的管道配置中定義整個提取工作流,包括嵌套上下文和特定角色的 LLM。

支持嵌套上下文提取:自動根據管道定義處理層次化信息提取(例如文檔 > 部分 > 子部分 > 實體),簡化復雜文檔分析。

內置并發處理:通過簡單的 use_concurrency=True 開關,啟用并發 I/O 處理,加速涉及多個 LLM 調用的密集型提取工作流。

自動跟蹤使用和成本:無需額外設置即可監控工作流中的 LLM 調用、令牌使用量和相關成本。

集成回退和重試邏輯:內置重試機制,并允許輕松配置回退 LLM,提高彈性。

多語言支持:支持輸入和輸出多種語言,無需額外提示。

支持多種 LLM 提供商:支持云 LLM(如 OpenAI、Anthropic、Google、Azure OpenAI 等)和本地 LLM(如 Ollama、LM Studio 等),并提供統一接口,便于切換。

優化策略:提供優化準確性、速度和成本的策略,以及處理長文檔和選擇合適 LLM 的建議。

結果序列化:可以保存和加載文檔對象、管道和 LLM 配置,避免重復調用昂貴的 LLM。

文檔轉換器

ContextGem 提供了內置的文檔轉換器,可以將 DOCX 文件轉換為 LLM 可用的數據。它能夠提取其他開源工具通常無法捕獲的信息,如錯位表格、注釋、腳注、文本框、頁眉/頁腳和嵌入圖像,并保留文檔結構和豐富的元數據,以便進行更好的 LLM 分析。

ContextGem應用場景

ContextGem 專注于從單個文檔中進行深入、準確的分析,利用現代 LLM 的擴展上下文窗口和能力。它適用于需要從特定文檔中提取精確數據和見解的場景,例如法律合同分析、財務文件處理等。不過,它目前不支持跨文檔查詢或整個語料庫的檢索,對于這些用例,現代 RAG 系統(如 LlamaIndex、Haystack)可能更合適。

ContextGem項目鏈接

https://github.com/shcherbak-ai/contextgem

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺