LiveCC:字節(jié)跳動和新加坡國立大學(xué)合作開發(fā)的能實(shí)時解說的視頻大語言模型

LiveCC是什么?

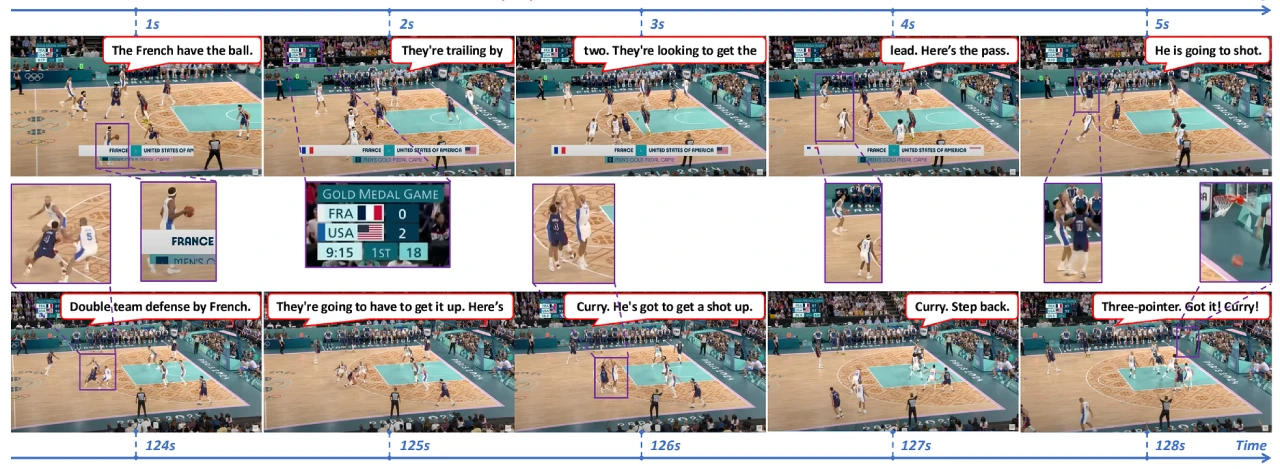

LiveCC是字節(jié)跳動和新加坡國立大學(xué)合作開發(fā)的視頻大語言模型,能實(shí)時解說視頻內(nèi)容。它用自動語音識別(ASR)轉(zhuǎn)錄本訓(xùn)練,成本低,效率高。研究人員還開發(fā)了新的流訓(xùn)練方法和數(shù)據(jù)生產(chǎn)管道,構(gòu)建了Live-CC-5M和Live-WhisperX-526K兩個數(shù)據(jù)集。即使沒有經(jīng)過高質(zhì)量監(jiān)督微調(diào),LiveCC-7B-Base模型在視頻問答和實(shí)時解說上表現(xiàn)也很出色。經(jīng)過LiveSports-3K基準(zhǔn)測試評估,最終的LiveCC-7B-Instruct模型在實(shí)時解說質(zhì)量上超過了72B的先進(jìn)模型,在VideoMME和OVOBench等視頻問答基準(zhǔn)測試中也取得了頂尖成績。

LiveCC核心特點(diǎn)

模型訓(xùn)練方法

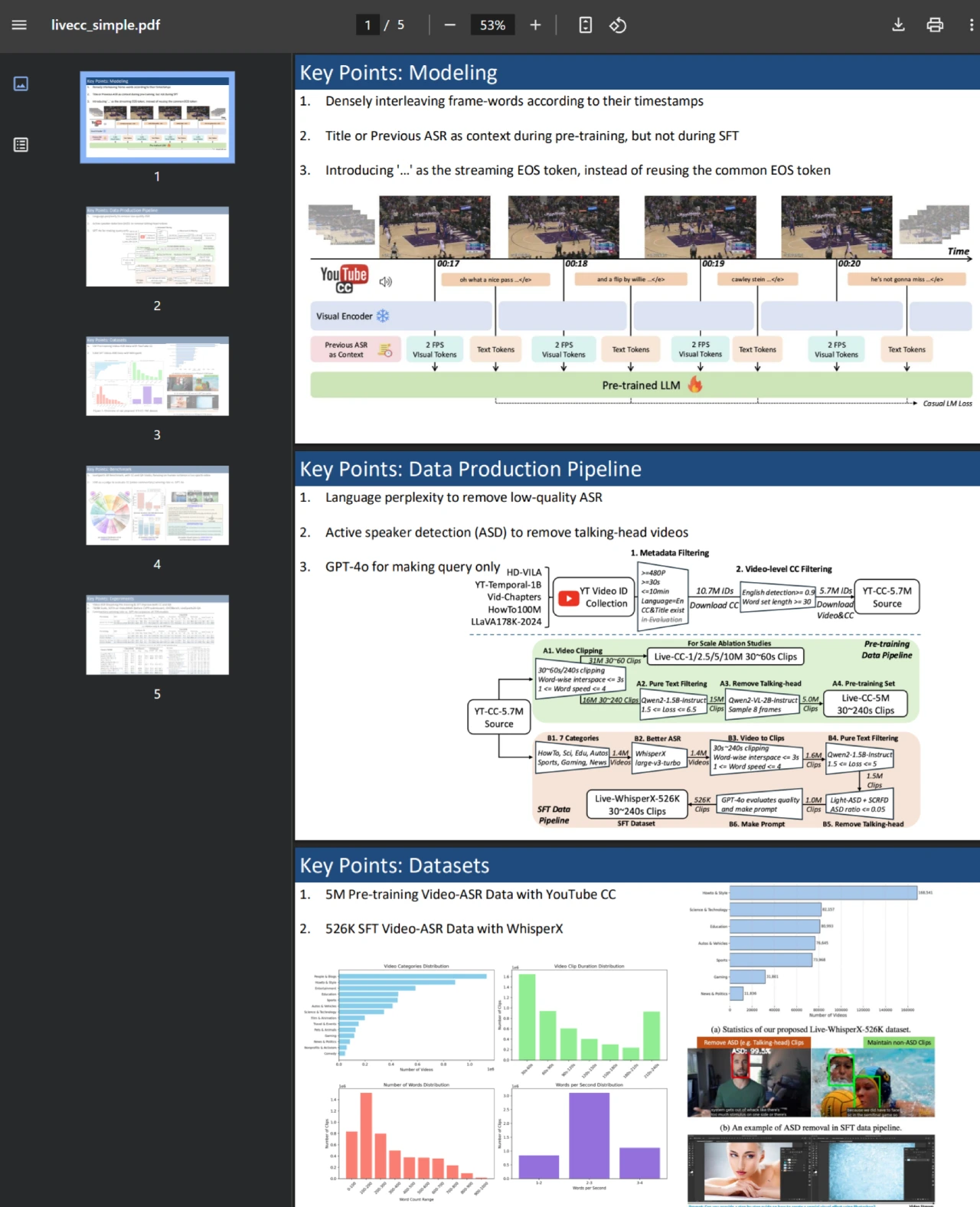

創(chuàng)新訓(xùn)練方式:提出一種新穎的視頻 - ASR 流訓(xùn)練方法,根據(jù)時間戳將 ASR 單詞和視頻幀緊密交織,符合 ASR 的流特性,使模型能學(xué)習(xí)時間對齊、細(xì)粒度的視覺語言建模。

數(shù)據(jù)生產(chǎn)與數(shù)據(jù)集構(gòu)建:引入數(shù)據(jù)生產(chǎn)管道處理 YouTube 視頻及其字幕(CC,等同于 ASR),構(gòu)建了用于預(yù)訓(xùn)練的Live-CC-5M數(shù)據(jù)集和用于高質(zhì)量監(jiān)督微調(diào)(SFT)的Live-WhisperX-526K數(shù)據(jù)集。

模型性能

LiveCC-7B-Base 模型:即便未進(jìn)行 SFT,該模型在通用視頻問答任務(wù)中就展現(xiàn)出有競爭力的性能,還具備實(shí)時視頻解說的新能力。

LiveCC-7B-Instruct 模型:通過精心設(shè)計(jì)的LiveSports-3K基準(zhǔn)測試(使用 LLM 作為評判標(biāo)準(zhǔn)衡量自由形式解說)評估,該模型在實(shí)時模式下的解說質(zhì)量超越先進(jìn)的 72B 模型(如 Qwen2.5-VL-72B-Instruct、LLaVA-Video-72B)。在流行的視頻問答基準(zhǔn)測試(如 VideoMME 和 OVOBench)中,在 7B/8B 規(guī)模上取得了最先進(jìn)的成果,證明了方法的廣泛通用性。

LiveCC應(yīng)用

LiveCC 可以廣泛應(yīng)用于視頻內(nèi)容的實(shí)時解讀、體育賽事的實(shí)時評論、教育視頻的互動講解等領(lǐng)域。

常見問題

問:LiveCC 與其他視頻大語言模型在訓(xùn)練數(shù)據(jù)獲取上有什么不同?

答:LiveCC 利用廉價(jià)的自動語音識別(ASR)轉(zhuǎn)錄本進(jìn)行大規(guī)模訓(xùn)練,而其他模型常依賴昂貴的人工注釋或?qū)S心P?API(如 GPT-4o),這種差異使LiveCC 在訓(xùn)練數(shù)據(jù)的成本和規(guī)模上更加有優(yōu)勢。

問:Live-CC-5M 和 Live-WhisperX-526K 數(shù)據(jù)集分別有什么作用?

答:Live-CC-5M 數(shù)據(jù)集用于模型的預(yù)訓(xùn)練,幫助模型學(xué)習(xí)通用的視覺語言特征和知識;Live-WhisperX-526K 數(shù)據(jù)集用于高質(zhì)量監(jiān)督微調(diào)(SFT),使模型在特定任務(wù)上表現(xiàn)更好,提升模型的性能。

問:LiveCC-7B-Instruct 模型在實(shí)時解說方面超越 72B 模型有什么意義?

答:表明 LiveCC 的訓(xùn)練方法和模型架構(gòu)有效,能夠在較低參數(shù)量下實(shí)現(xiàn)更高效的實(shí)時解說功能,這為視頻大語言模型在實(shí)時應(yīng)用場景(如體育賽事直播解說等)的推廣提供了更具性價(jià)比的解決方案。

相關(guān)鏈接

GitHub 倉庫地址:https://github.com/showlab/livecc

Releases 頁面:https://github.com/showlab/livecc/releases

項(xiàng)目主頁:https://showlab.github.io/livecc/

論文鏈接:https://arxiv.org/abs/2504.06885

在線演示:https://huggingface.co/spaces/chenjoya/LiveCC

相關(guān)文章

- 用戶登錄

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺

開源AI應(yīng)用平臺