langchain推出mcpdoc:通過解析llms.txt文件提取信息,解決信息過載不準(zhǔn)確問題

MCPdoc是什么?

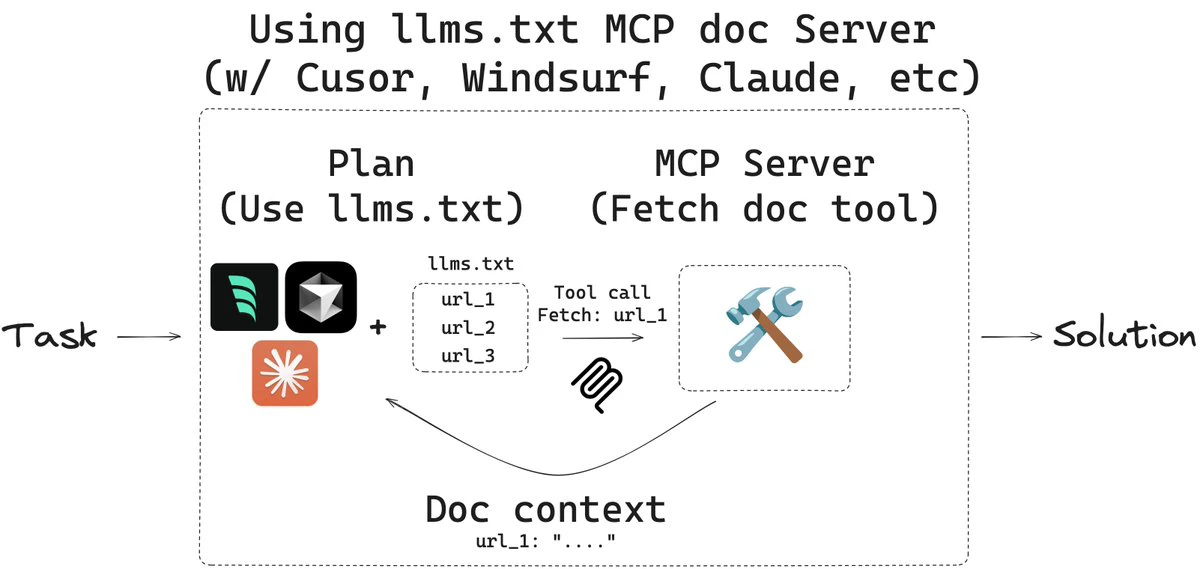

mcpdoc 是 LangChain 推出的一個可以通過 MCP服務(wù)器,將 llms.txt 文件的內(nèi)容以編程開發(fā)工具的形式暴露給集成開發(fā)環(huán)境或其他應(yīng)用程序,解決信息過載/不完整/不準(zhǔn)確的問題,幫Ai助手理解復(fù)雜的框架文檔,為開發(fā)者提供更高效、更透明的開發(fā)體驗。

mcpdoc原理

mcpdoc 的核心是 MCP 服務(wù)器,它負(fù)責(zé)索引和管理 LLMs 的配置信息,并向 IDE 和其他應(yīng)用程序提供上下文數(shù)據(jù)。應(yīng)用程序根據(jù)當(dāng)前開發(fā)環(huán)境和代碼上下文,通過 API 調(diào)用向 MCP 服務(wù)器請求相關(guān)的 LLM 配置信息。

mcpdoc核心功能

提供 llms.txt 文件的訪問接口:llms.txt 是一個為 LLMs(Large Language Models,大型語言模型)提供上下文信息的文件,它包含了背景信息、指導(dǎo)內(nèi)容以及指向詳細(xì)文檔的鏈接。mcpdoc 通過 MCP 服務(wù)器,將這些信息以標(biāo)準(zhǔn)化的方式提供給 IDEs 或其他應(yīng)用程序。

支持多種文檔來源:用戶可以通過多種方式指定 llms.txt 文件的來源,包括直接指定 URL、使用 YAML 配置文件或 JSON 配置文件。

增強(qiáng)開發(fā)工具的上下文理解能力:通過 MCP 服務(wù)器,IDEs 或其他應(yīng)用程序可以動態(tài)獲取和解析 llms.txt 文件中的內(nèi)容,從而為開發(fā)者提供更豐富的上下文信息,幫助他們更好地理解和使用 LLMs。

審計和控制工具調(diào)用:與直接使用內(nèi)置工具讀取和處理 llms.txt 文件相比,mcpdoc 允許用戶審計每次工具調(diào)用以及返回的上下文內(nèi)容,從而提供更高的透明度和控制力。

mcpdoc應(yīng)用場景

集成開發(fā)環(huán)境(IDEs):例如 Cursor、Windsurf 等 IDEs 可以通過 mcpdoc 提供的 MCP 服務(wù)器,動態(tài)獲取 llms.txt 文件中的上下文信息,從而為開發(fā)者提供更智能的代碼輔助功能。

AI 輔助開發(fā)工具:像 Claude Code/Desktop 等工具可以利用 mcpdoc 提供的上下文信息,為開發(fā)者提供更準(zhǔn)確的代碼建議和文檔支持。

文檔生成與管理:mcpdoc 可以幫助開發(fā)者自動生成和管理與代碼相關(guān)的文檔,減少手動編寫和維護(hù)文檔的工作量。

mcpdoc使用方法

安裝

首先需要安裝 uv 工具,可以通過以下命令安裝:

curl -LsSf https://astral.sh/uv/install.sh | sh

啟動 MCP 服務(wù)器

可以通過以下命令啟動 mcpdoc 服務(wù)器,指定 llms.txt 文件的來源:

uvx --from mcpdoc mcpdoc \ --urls "LangGraph:https://langchain-ai.github.io/langgraph/llms.txt" "LangChain:https://python.langchain.com/llms.txt" \ --transport sse \ --port 8082 \ --host localhost

--urls 參數(shù)用于指定 llms.txt 文件的來源,可以指定多個 URL。

--transport 參數(shù)指定通信方式,例如 sse(Server-Sent Events)。

--port 和 --host 參數(shù)用于指定服務(wù)器的端口和主機(jī)地址。

Github項目:https://github.com/langchain-ai/mcpdoc

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺

開源AI應(yīng)用平臺