Ghibli-Diffusion:吉卜力工作室風格的AI圖像生成模型

Ghibli-Diffusion是什么?

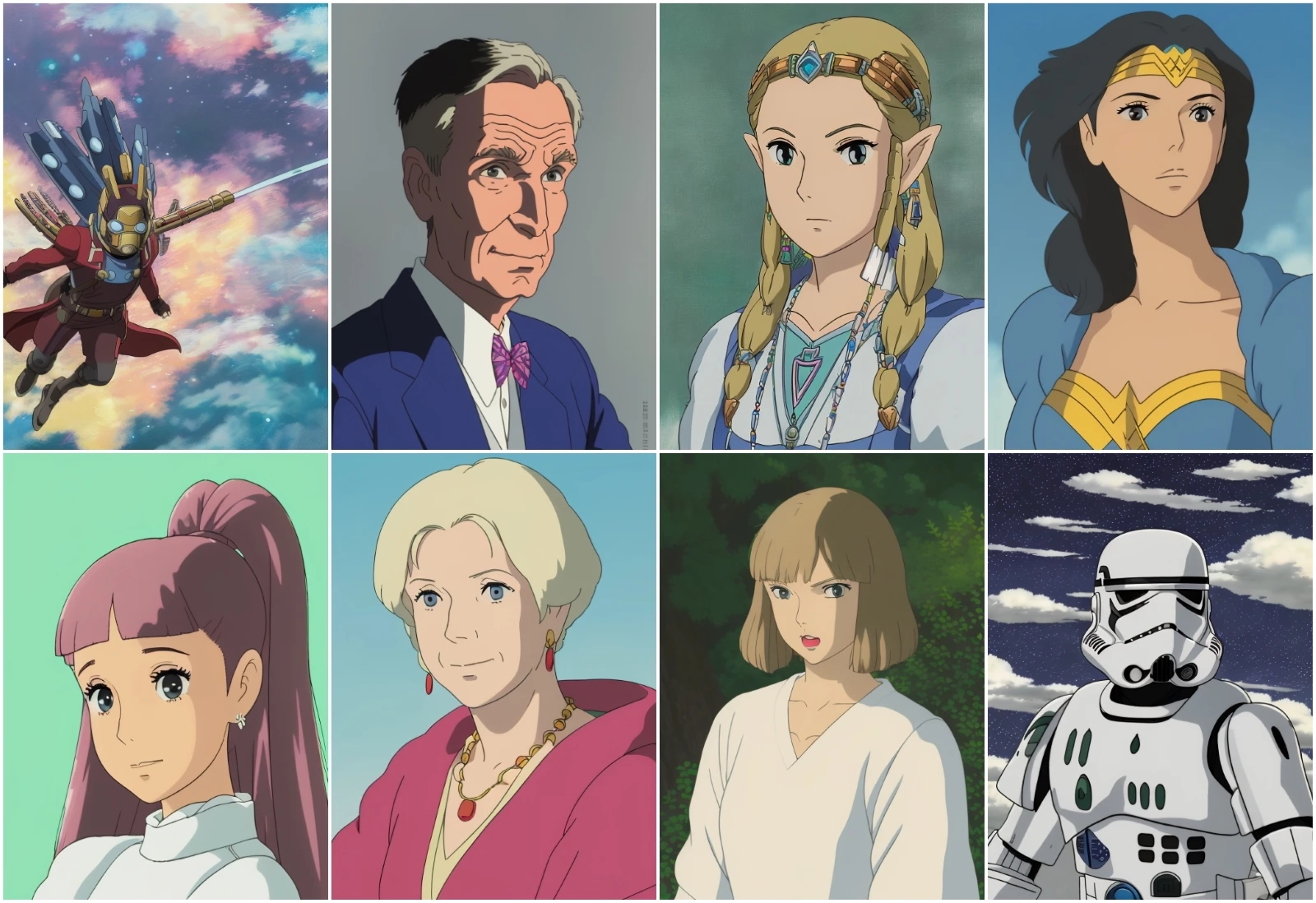

Ghibli-Diffusion是一個基于Stable Diffusion模型微調的文本到圖像生成模型,專門用于生成具有吉卜力工作室(Studio Ghibli)風格的動畫圖像。這個模型由ai藝術家 nitrosocke 開發,訓練數據來源于吉卜力工作室的現代動畫電影。

Ghibli-Diffusion核心功能

文本到圖像生成:用戶可以通過輸入文本提示詞(如“ghibli style”)來生成具有吉卜力風格的圖像。

圖像到圖像轉換:用戶可以上傳現有圖片,并將其轉換為吉卜力風格的圖像。

支持多種場景和對象:模型能夠生成各種場景(如海灘、冰原、北極光等)和特定對象(如風暴兵、大眾甲殼蟲汽車等)。

Ghibli-Diffusion技術特點

擴散模型技術:基于擴散模型的正向和反向過程,逐步從噪聲中重建出清晰的圖像。

訓練方法:采用 dreambooth 訓練方法,結合先驗保留損失(prior-preservation loss)和文本編碼器訓練標志,確保生成圖像的高質量。

性能優化:最新版本在保持吉卜力風格的基礎上,引入更多細節和個性化元素,生成速度更快。

Ghibli-Diffusion使用場景

創意設計:藝術家和設計師可以快速生成概念藝術、壁紙、海報等。

故事創作:幫助創作者將想象中的場景和角色轉化為視覺藝術。

個性化內容:用戶可以將自己的照片轉換為吉卜力風格,用于社交媒體或個人藝術項目。

Ghibli-Diffusion使用教程

文本提示:在提示詞中加入“ghibli style”,描述你想要生成的圖像內容。

調整參數:根據需要調整采樣器、CFG scale和步數等設置,以優化生成效果。

負提示詞:使用負提示詞排除不希望出現的元素,提高生成圖像的質量。

優勢與局限性

優勢:

高質量的吉卜力風格圖像。

快速生成,平均生成一張圖像僅需5秒。

靈活性高,支持多種創作需求。

局限性:

生成的圖像可能在某些復雜場景下不夠完美。

對計算資源要求較高,需要較強的GPU支持。

示例代碼

from diffusers import StableDiffusionPipeline

import torch

model_id = "nitrosocke/Ghibli-Diffusion"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda")

prompt = "ghibli style magical princess with golden hair"

image = pipe(prompt).images[0]

image.save("./magical_princess.png")huggingface演示:https://huggingface.co/nitrosocke/Ghibli-Diffusion

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺