OpenAI 發(fā)布了三款全新語音模型,包括兩款語音轉(zhuǎn)文本模型以及一款文本轉(zhuǎn)語音模型

2025 年 3 月 20 日,Openai 發(fā)布了三款全新的語音模型,包括兩款語音轉(zhuǎn)文本模型(GPT-4o-transcribe 和 GPT-4o-mini-transcribe)以及一款文本轉(zhuǎn)語音模型(GPT-4o-mini-tts)。

語音轉(zhuǎn)文本模型

GPT-4o-transcribe:該模型經(jīng)過多樣化、高質(zhì)量音頻數(shù)據(jù)集的長時間訓練,能夠更好地捕捉語音的細微差別,減少誤識別,大幅提升轉(zhuǎn)錄可靠性。它適用于處理口音多樣、環(huán)境嘈雜、語速變化等復雜場景,例如客戶呼叫中心和會議記錄轉(zhuǎn)錄等領域。

GPT-4o-mini-transcribe:這是 GPT-4o-transcribe 的精簡版本,速度更快、效率更高。雖然其單詞錯誤率(WER)稍高于完整版模型,但仍優(yōu)于原有的 Whisper 模型,更適合資源有限但需要高質(zhì)量語音識別的應用場景。

文本轉(zhuǎn)語音模型

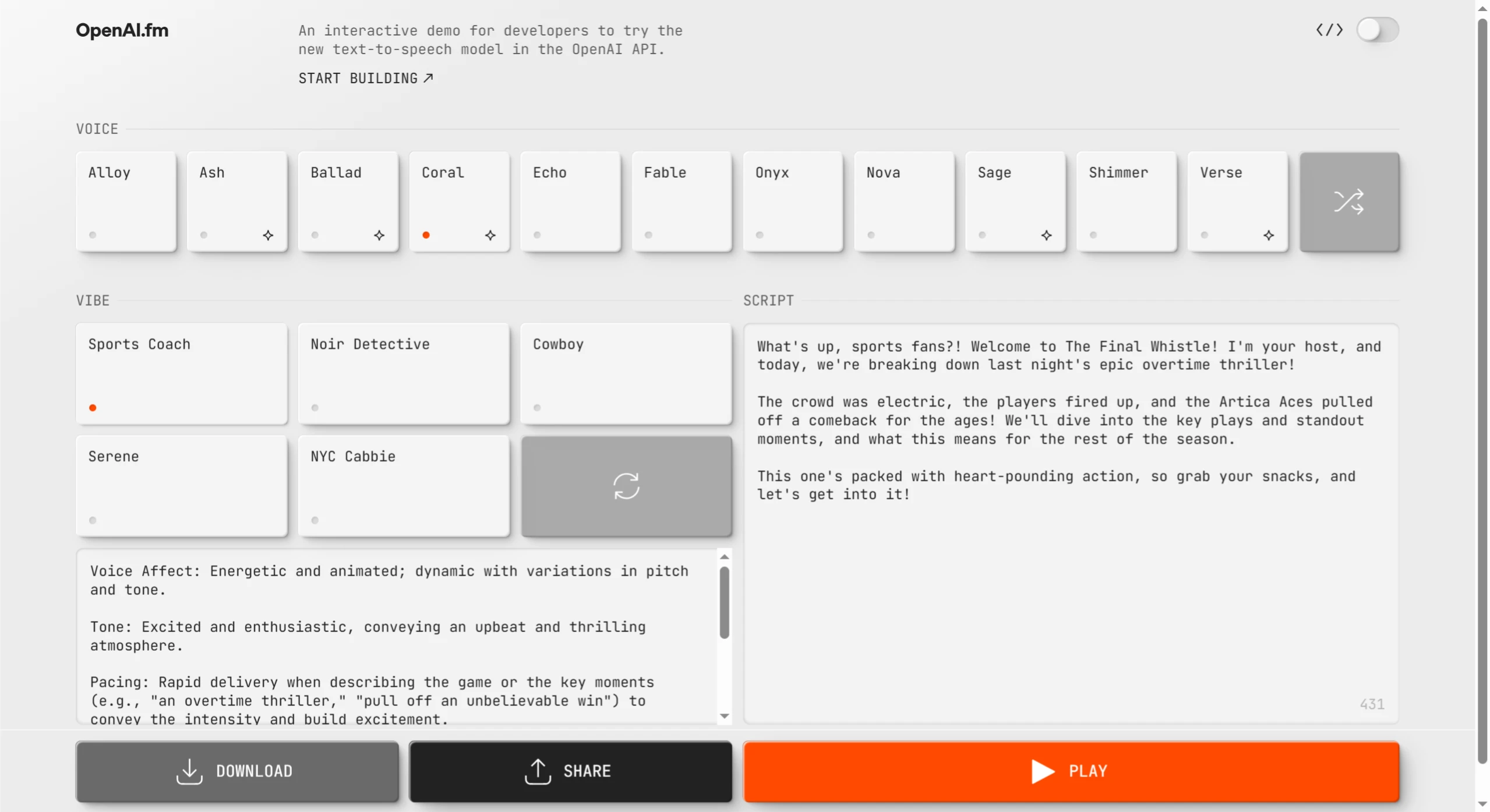

GPT-4o-mini-tts:這款模型首次支持“可引導性”(steerability),開發(fā)者不僅可以指定模型“說什么”,還能控制“怎么說”,例如可以預設語音風格為“平靜”“沖浪者”“專業(yè)的”“中世紀騎士”等,還能根據(jù)指令調(diào)整語音風格,如“像富有同情心的客服 Agent 一樣說話”。

技術創(chuàng)新

使用真實音頻數(shù)據(jù)集進行預訓練,優(yōu)化模型性能。

增強的蒸餾方法,實現(xiàn)從大模型到小模型的知識轉(zhuǎn)移。

強化學習,提升轉(zhuǎn)錄精度并減少“幻覺”現(xiàn)象。

應用場景

呼叫中心:提供更準確的語音識別和更自然的語音合成,提升客戶服務體驗。

會議記錄:快速準確地將會議語音內(nèi)容轉(zhuǎn)錄為文本。

個性化客服:通過語音風格的定制,提供更具溫度和表現(xiàn)力的語音體驗。

創(chuàng)意故事講述:為故事添加生動的語音效果。

定價

GPT-4o-transcribe 的價格與之前的 Whisper 模型相同,每分鐘 0.006 美元。

GPT-4o-mini-transcribe 的價格為每分鐘 0.003 美元。

GPT-4o-mini-tts 的定價為每分鐘 1 美分。

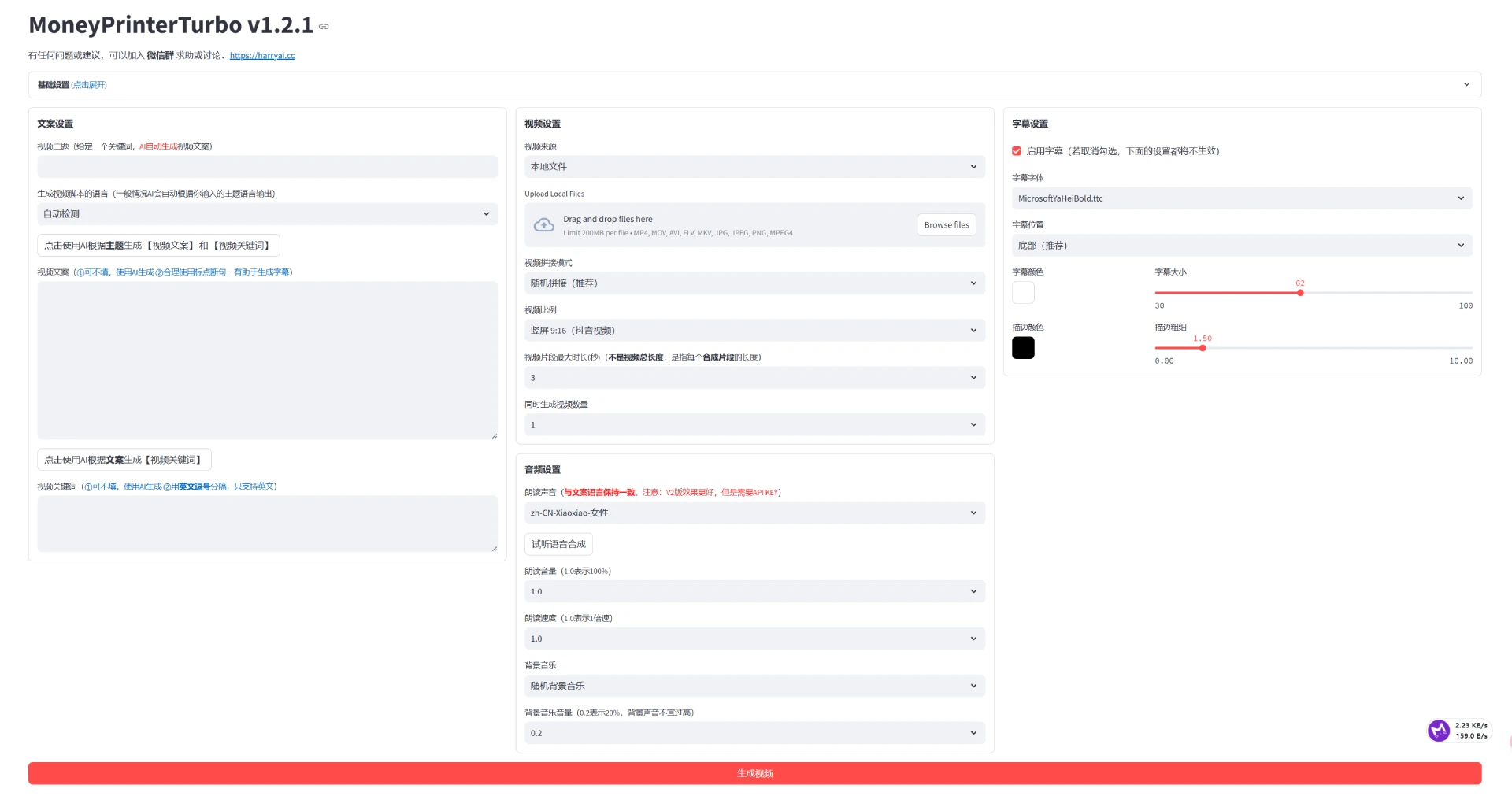

OpenAI 語音模型網(wǎng)站:OpenAI.fm,網(wǎng)站提供了豐富的預設模板,包括人設、語氣、方言、發(fā)音等設置。用戶可以在此體驗并制作 GPT-4o-mini-tts 的相關音頻。此外,OpenAI 還提供了升級版的 Agent SDK,幫助開發(fā)者更便捷地構(gòu)建語音智能體。

官方網(wǎng)站:http://openai.fm/

官方博客:https://openai.com/index/introducing-our-next-generation-audio-models/

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI