Vid2Avatar-Pro:從單目自然視頻中生成逼真的3D人體虛擬形象

Vid2Avatar-Pro是什么?

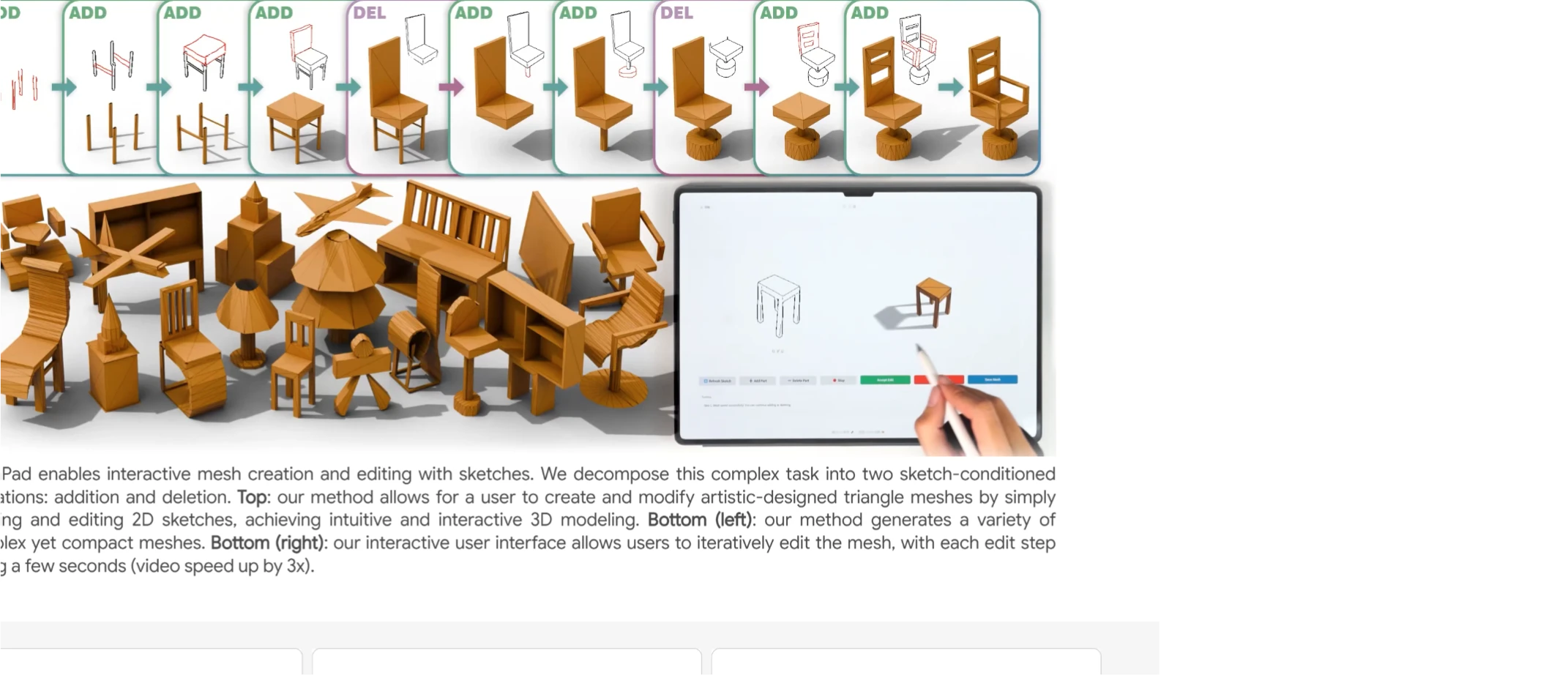

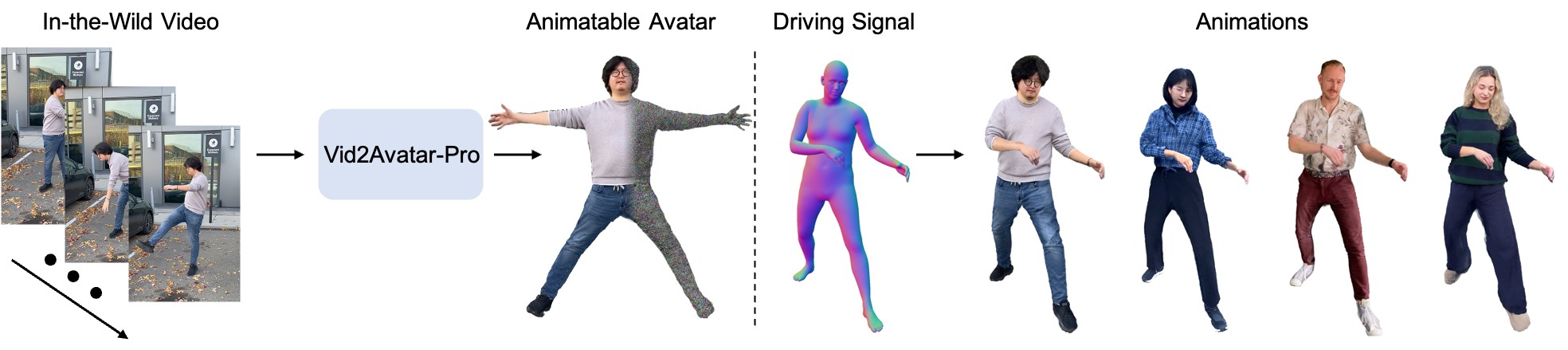

Vid2Avatar-Pro 是一種能夠從普通的單目自然視頻中創建逼真且可動畫化的3D人體虛擬形象的技術。它是 Vid2Avatar 的升級版本,通過引入通用先驗模型(Universal Prior Model, UPM)和優化的 3D 表示方法,提升了虛擬形象的逼真度和泛化能力。

Vid2Avatar-Pro功能特征

高逼真度與可動畫性:Vid2Avatar-Pro 能夠從普通單目視頻中生成逼真的 3D 虛擬形象,并支持復雜的動作動畫。

多視角渲染:生成的虛擬形象可以被渲染到任意視角,解決了傳統方法中視角受限的問題。

多樣化動作支持:虛擬形象能夠執行多種復雜動作,如打羽毛球、打鼓、單腿跳躍等。

通用先驗模型(UPM):通過大規模多視角數據預訓練的通用先驗模型,顯著提升了對新姿態和視角的泛化能力。

Vid2Avatar-Pro應用場景

影視制作:從普通視頻中重建演員的 3D 模型,用于特效制作。

虛擬現實(VR)與增強現實(AR):創建逼真的虛擬角色,提升沉浸感。

時尚與電商:通過視頻重建用戶 3D 模型,實現虛擬試衣。

體育分析:從比賽視頻中重建運動員模型,分析動作細節。

醫療康復:記錄和分析患者康復過程中的動作。

Vid2Avatar-Pro 技術原理

通用先驗模型(UPM)

預訓練階段:使用大規模多視角、動態的穿衣人類表演數據訓練 UPM,使其能夠捕捉人類外觀和姿態的通用特征。

微調階段:在給定的單目野外視頻上,通過逆渲染技術對預訓練的 UPM 進行微調,恢復特定人物的細節。

3D 高斯表示

使用規范前后地圖的 3D 高斯表示來構建虛擬形象,這些地圖在不同身份之間共享。

通過正向線性混合蒙皮(LBS)和光柵化技術合成訓練姿態/形狀參數。

自監督場景分解

不依賴外部分割模塊,直接在 3D 中分離人體和背景。

通過兩個獨立的神經場對人物和背景進行參數化,解決了場景分解和表面重建任務。

優化策略

引入由粗到細的采樣策略和新穎的目標函數,清晰地分離動態人體和靜態背景。

優化背景模型、規范化的人體形狀和紋理以及每幀人體姿態參數。

Vid2Avatar-Pro使用方法

1. 數據準備:

使用 ROMP 獲取初始 SMPL 形狀和姿勢。

使用 OpenPose 提取關鍵點。

2. 模型訓練:

對背景模型、人體形狀紋理和姿態參數進行聯合優化。

使用預訓練的 UPM 模型進行微調。

3. 生成與渲染:

使用訓練好的模型生成最終的 3D 虛擬形象。

通過逆渲染技術實現多視角渲染。

4. 動畫生成:

將虛擬形象綁定到新的動作序列,實現多樣化動畫。

論文鏈接:https://moygcc.github.io/vid2avatar-pro/static/CVPR2025_Vid2Avatar_Pro.pdf

項目主頁:https://moygcc.github.io/vid2avatar-pro/

相關文章

- 用戶登錄

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺