UniTok:字節開源的一個同時用于生成和理解任務的視覺分詞器

UniTok是什么?

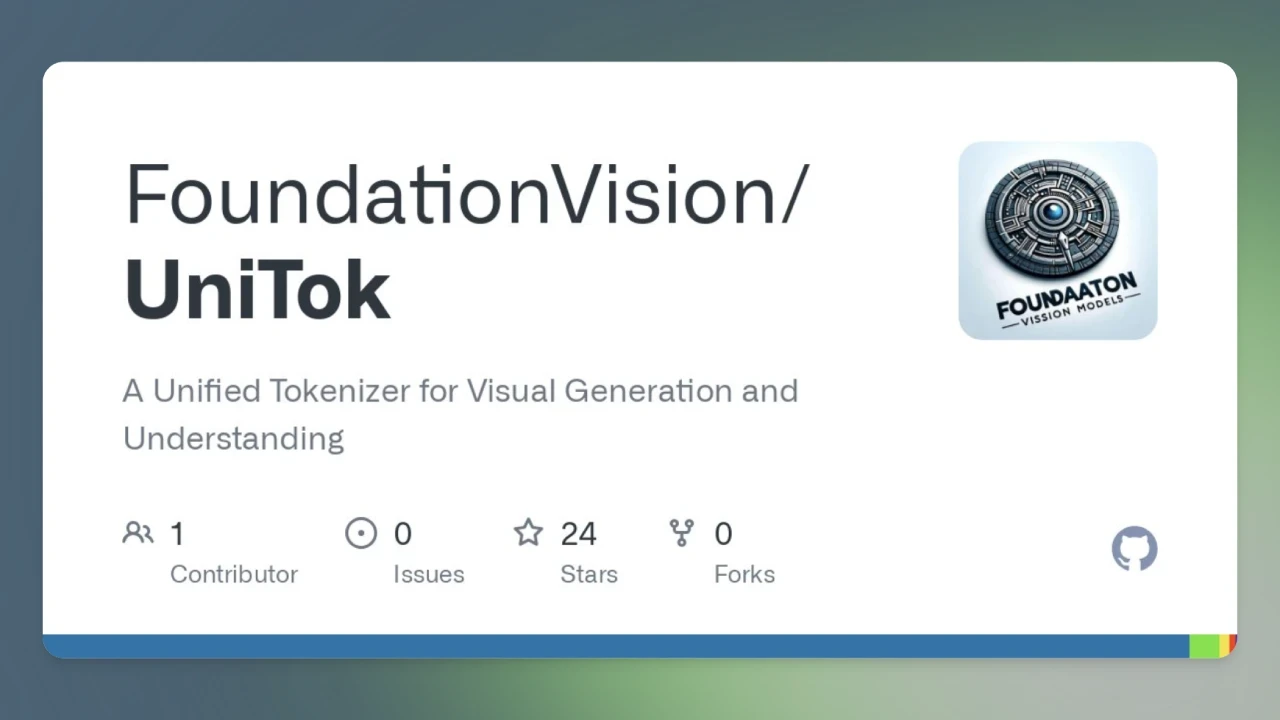

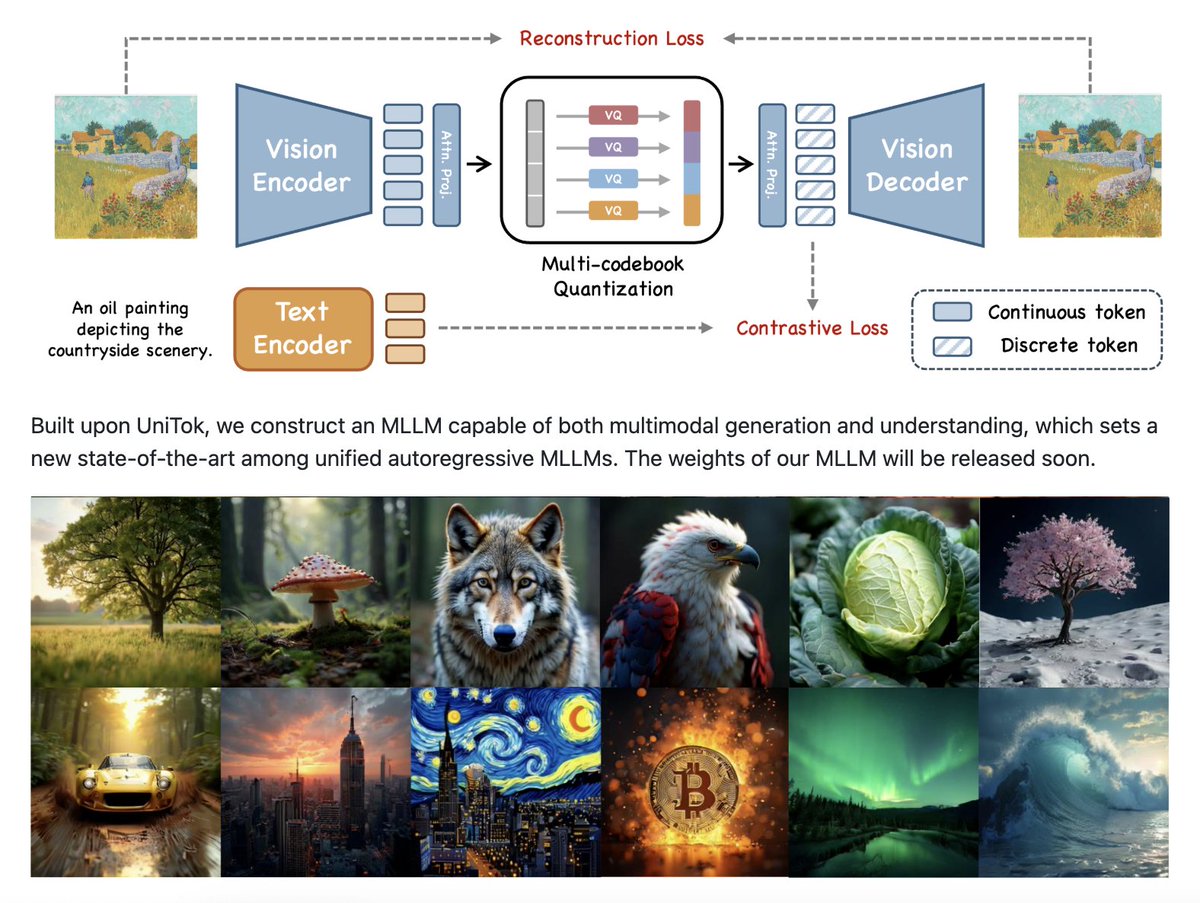

UniTok 是字節開源的一個同時用于生成和理解任務的視覺分詞器,能夠高效地將視覺信息轉化為 token,適用于多種自回歸生成模型和多模態理解模型。它通過創新的視覺分詞技術,能夠以極低的 token 數量(如 256 個 token)實現高質量的視覺內容生成,例如圖像和視頻的重建。

UniTok 的核心功能

高效視覺編碼:UniTok 能夠將復雜的視覺信息(如圖像和視頻)分解為離散的 token,便于模型處理。

多模態支持:它不僅適用于圖像,還能處理視頻內容,支持連續和離散分詞化。

低資源需求:UniTok 在低 token 數量下仍能保持高重建質量,例如在 256 個 token 下的重建誤差僅為 0.39。

靈活的壓縮率:用戶可以根據需求調整 token 數量,以平衡生成質量和計算效率。

UniTok應用領域

視覺生成任務:如圖像和視頻重建、語言模型驅動的視覺合成。

多模態理解:結合文本和視覺信息,實現更高效的多模態模型訓練。

擴散模型:與 DiT 和 Latte 等擴散模型結合,生成高質量的視覺內容。

UniTok技術實現

UniTok 基于 VQVAE(變分量子化自編碼器)和 VAE(變分自編碼器)技術,通過兩階段訓練實現高效的視覺編碼。其訓練過程包括:

圖像單一分辨率訓練:在固定分辨率上進行圖像訓練。

圖像-視頻聯合多分辨率訓練:在多個分辨率上進行圖像和視頻的聯合訓練。

VAE 微調:通過 KL 損失對 VQVAE 模型進行微調,得到 VAE 模型。

UniTok優勢

單一模型和權重:UniTok 通過單一模型和權重處理圖像和視頻分詞,簡化了模型管理和部署。

高適應性:支持高分辨率和長視頻輸入,適應多種應用場景。

兼容性強:與語言模型和擴散模型兼容,實現多樣化的視覺生成。

UniTok 通過多碼本量化技術,解決了傳統分詞器在生成和理解任務中的瓶頸,為多模態大語言模型(MLLMs)提供了一個更高效的解決方案。

項目地址:https://foundationvision.github.io/UniTok/

GitHub倉庫:https://github.com/FoundationVision/UniTok

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺