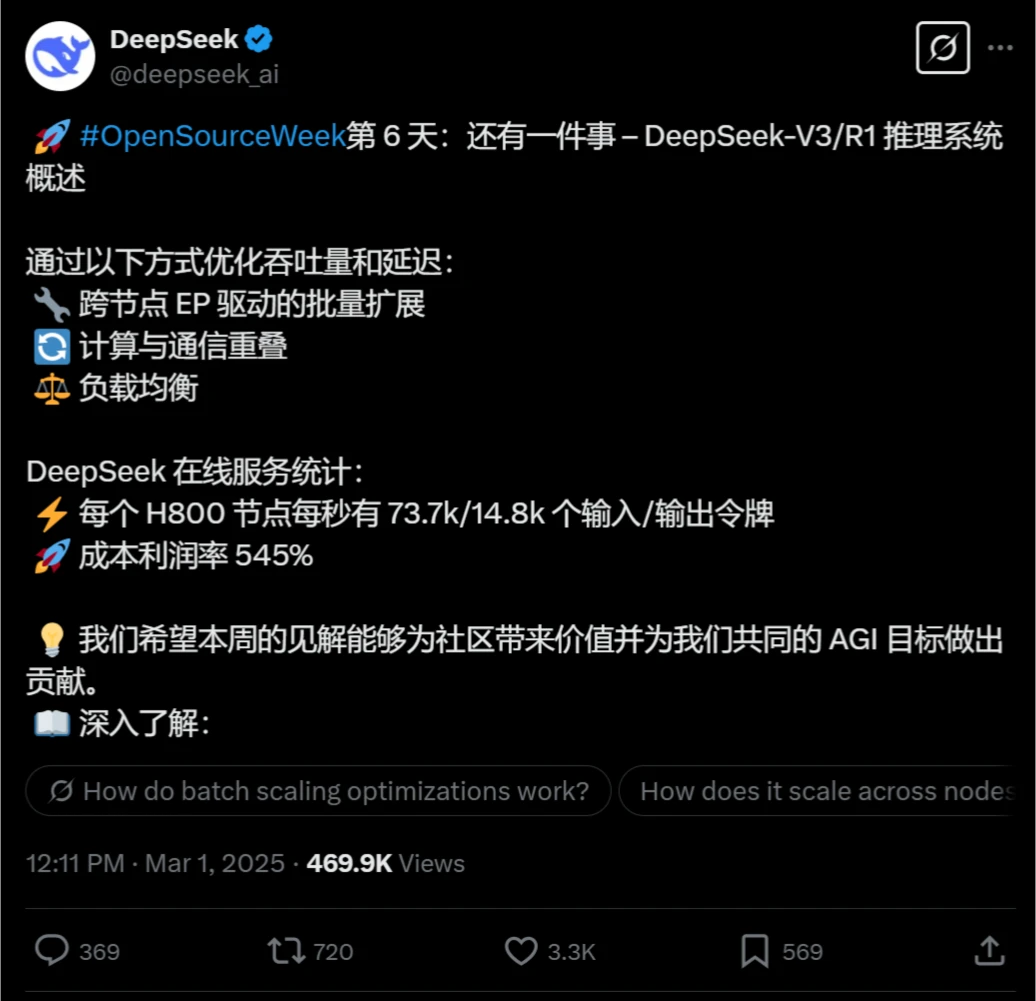

DeepSeek開源周第六天開源項目:DeepSeek-V3/R1推理系統,成本利潤率高達545%

說好的開源周5天,想不到周六還來一個彩蛋,推出了DeepSeek-V3/R1推理系統。

DeepSeek-V3/R1推理系統是什么?

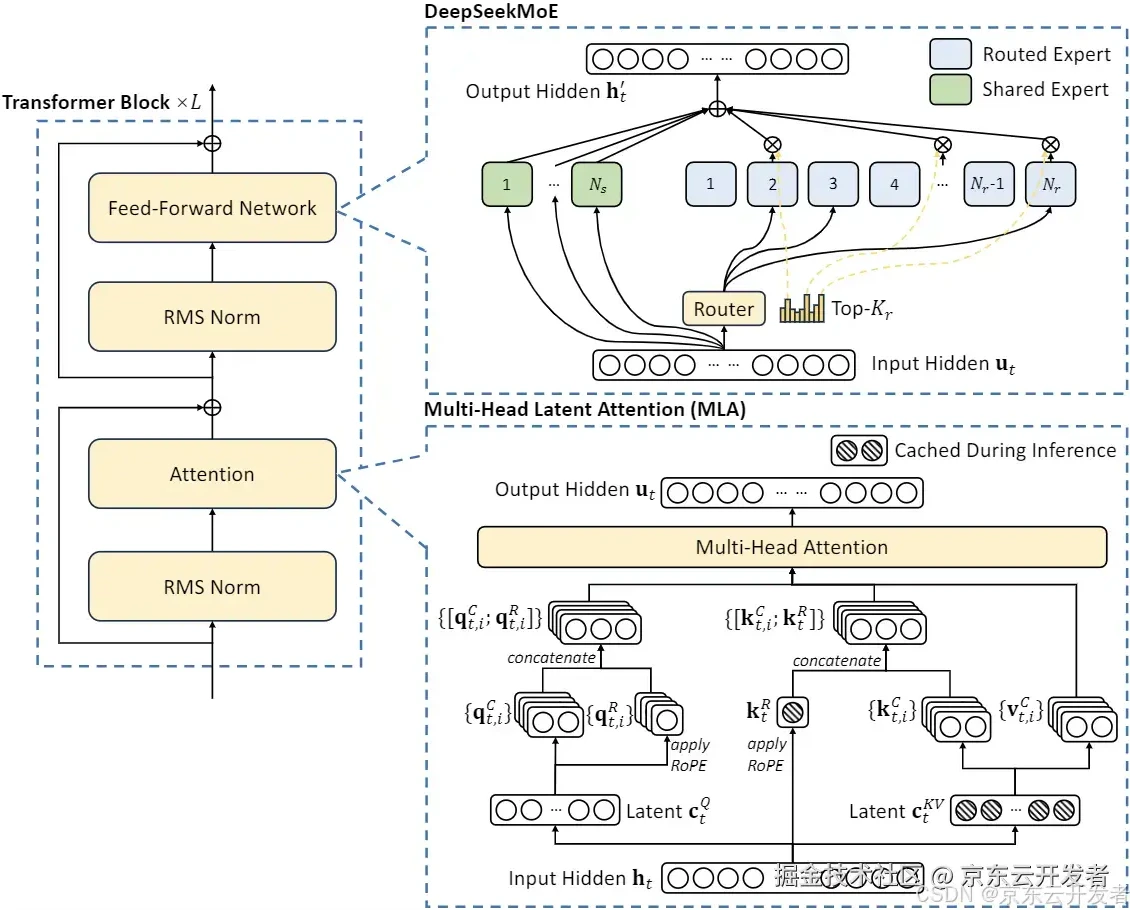

DeepSeek-V3/R1推理系統是DeepSeek最新推出的高性能推理系統,旨在通過優化吞吐量和延遲來提升推理效率。該系統采用了大規模跨節點專家并行(Expert Parallelism, EP)技術,顯著提高了GPU矩陣計算的效率,并通過將專家模塊分布在不同GPU上來降低延遲。

主要特點

高吞吐量和低延遲優化:

采用跨節點專家并行(Expert Parallelism, EP)技術,顯著擴大批處理規模,提高GPU矩陣計算效率。

通過預填充-解碼解耦架構,在預填充和解碼階段分別采用不同程度的并行策略。

智能負載均衡:

在預填充和解碼階段分別實現核心注意力計算和分發發送負載的均衡。

在混合專家模型(MoE)中,平衡每個GPU上的專家計算工作量。

計算-通信重疊處理:

采用dual-batch重疊策略,將同一批請求分割為兩個microbatch,以隱藏通信成本并提高整體吞吐量。

在解碼階段,采用五階段流水線技術,實現計算與通信的無縫重疊。

大規模跨節點專家并行(EP):

每層256個專家中僅激活8個,模型的高稀疏性特點要求采用極大的整體批處理規模。

預填充階段采用路由專家EP32和MLA/共享專家DP32,解碼階段采用路由專家EP144和MLA/共享專家DP144。

高效資源利用:

在白天高峰時段,所有節點都部署推理服務;在夜間低負載時段,減少推理節點并將資源分配給研究和訓練。

關鍵技術

跨節點專家并行(EP):DeepSeek-V3/R1模型能夠激活大量的專家網絡,但每層僅激活256個專家中的8個,生成高度稀疏的計算結構。

負載平衡:系統設計確保各個節點間的計算負載均勻,從而能夠有效利用全部資源。

成本和利潤率:根據模型的最新評估,假設GPU租賃成本為每小時2美元,總成本為每天87072美元,而理論上的一天總收入可達562027美元,成本利潤率高達545%

應用

在線推理服務:

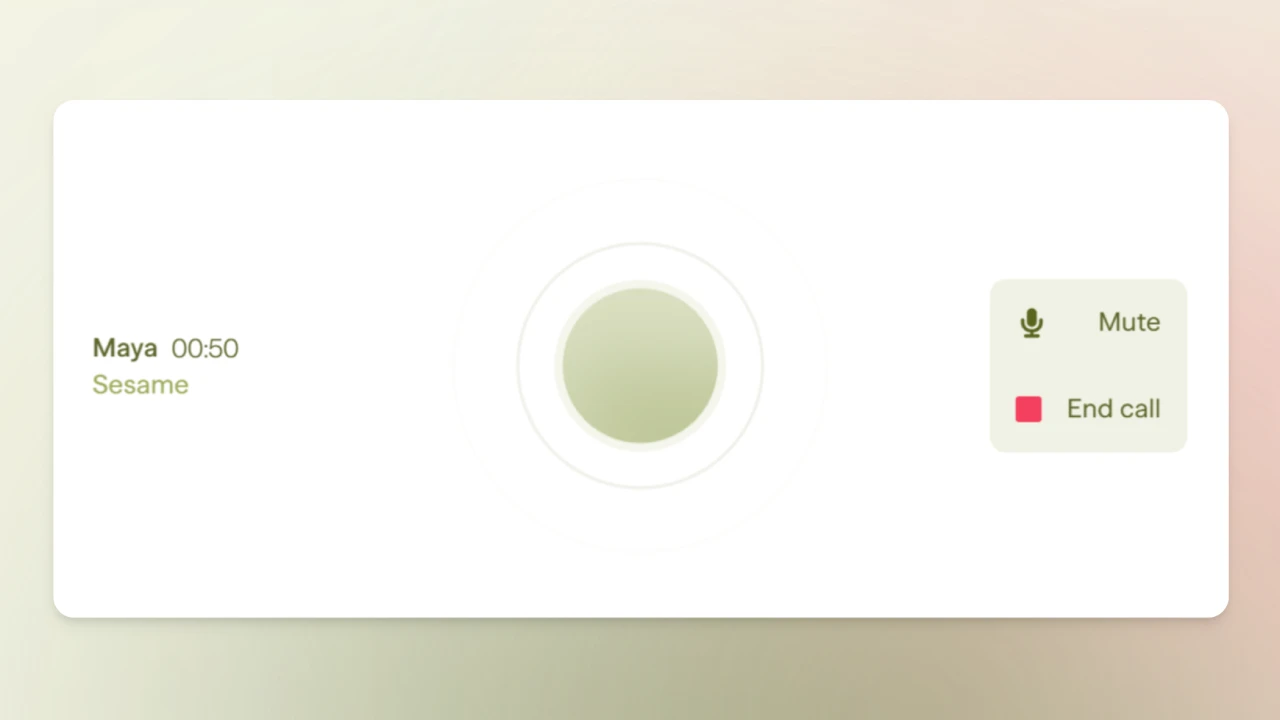

所有DeepSeek-V3/R1推理服務均在H800 GPU上運行,精度與訓練保持一致。

提供高吞吐量和低延遲的在線推理服務,適用于網頁、APP和API的所有用戶請求。

商業化和非商業化服務:

部分服務實現了商業化,網頁和APP訪問仍然免費。

在非高峰時段自動應用夜間折扣,優化資源利用和成本效益。

統計數據

在過去24小時內,V3和R1推理服務的合計峰值節點占用達到278個,平均占用226.75個節點(每個節點包含8個H800 GPU)。

每個H800節點在預填充階段提供平均約7.37萬token/秒的輸入吞吐量,或在解碼階段提供約1.48萬token/秒的輸出吞吐量。

如果所有token都按照DeepSeek-R1的定價計費,每日總收入將達到562,027美元,利潤率為545%。

前五天開源項目回顧

第一天:FlashMLA,針對NVIDIA Hopper GPU的高效解碼內核,優化了多頭潛在注意力(MLA)的性能,顯著提升了ai工具在內容創作中的響應速度。

第二天:DeepeEP,首個用于混合專家模型(MoE)訓練和推理的開源通信庫,優化了大規模分布式訓練的通信效率,降低了延遲。

第三天:DeepGEMM,支持稠密和MoE模型的FP8計算庫,專為NVIDIA Hopper架構GPU設計,顯著提高了計算效率和硬件利用率。

第四天:DualPipe,一種雙向流水線并行算法,旨在優化V3/R1模型訓練中的計算和通信重疊。EPLB,一個專家并行負載均衡器,專門用于解決大規模AI模型中專家并行任務的負載不均衡問題。

第五天:3FS,高性能分布式文件系統。

相關文章

- 用戶登錄

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺