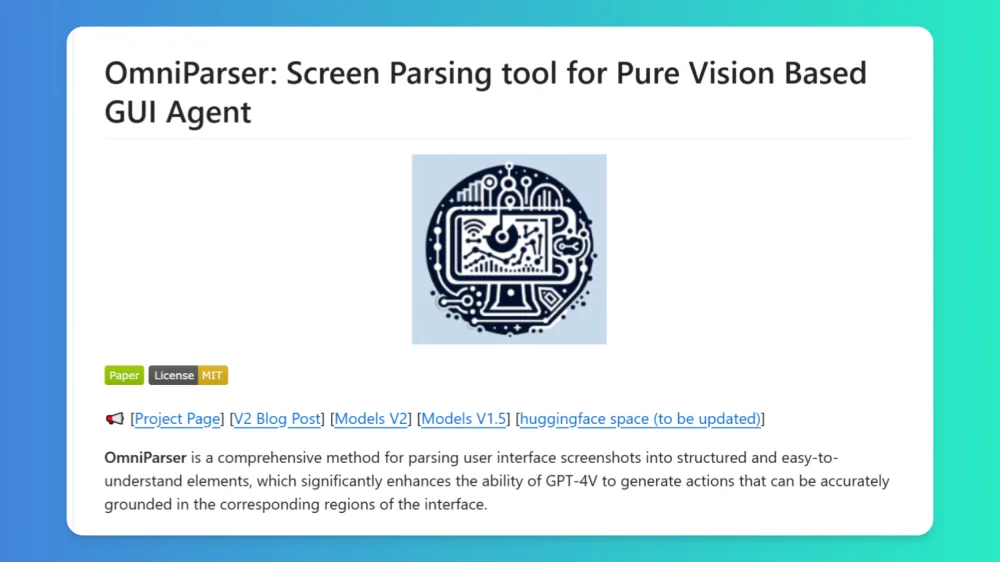

OmniParser V2:微軟推出的一款能夠將屏幕界面截圖轉換為結構化數據的幕解析工具

OmniParser V2 是一款能助力計算機理解并交互用戶界面視覺信息的強大 ai 工具。它運用視覺和語言模型(VLM),不僅能識別屏幕上的交互元素,還可將復雜的 UI 截圖解析為結構化數據,輔助語言模型理解屏幕元素并預測用戶交互動作,進而生成精確操作,是極為強大的屏幕理解解決方案。

OmniParser V2的功能特征

多模型兼容:OmniParser V2 能夠與多種當下最流行的 LLM 兼容,像 OpenAI、DeepSeek 等,靈活性和應用范圍得以大大增強。

視覺語言融合:這款工具巧把視覺和語言模型(VLM)相結合,能精準解析、理解截取的 UI 元素,這對開發智能體意義非凡。

輸出結構數據:在解析屏幕截圖時,OmniParser V2 可以自動識別與分類 UI 元素,像是按鈕、文本框等,再轉化為結構化信息,方便后續操作及分析。

生成精準操作:它不但能識別 UI 元素,還能依據識別結果生成相應操作指令,為應用程序的智能自動化開發提供了便捷條件。

OCR 智能提取:運用先進的 OCR 技術,精準識別屏幕文字信息,同時結合圖標邊界框,保證信息提取得全面且無遺漏。

結構化整合:將圖標、文字、邊界框和語義標簽等整合成有序結構,類似 DOM 樹,將界面元素邏輯清晰呈現。

OmniParser V2的應用場景:

自動化辦公:能自動處理文檔格式,統一 Word 文檔排版,自動填充 Excel 數據。

自動化測試:在軟件測試方面,借助 OmniParser V2 能夠實現對用戶界面的自動化測試,提升測試效率和準確性。

GUI 自動化測試:為軟件測試提供精確的界面元素識別,還可自動化執行測試腳本來減少人工成本。

用戶體驗分析:通過解析用戶界面數據,企業能深入剖析用戶體驗,優化產品設計。

智能助手開發:憑借其結構化輸出,開發者可打造更智能的助手,使其能夠理解并操作各類界面,達成更復雜的用戶指令。

教育和培訓:用于教育軟件中,能夠幫助學生通過圖形界面與內容進行互動。

OmniParser V2的使用方法

1. 獲取資源

從 GitHub 倉庫(https://github.com/microsoft/OmniParser)獲取項目代碼和文檔。

在 HuggingFace 模型庫(https://huggingface.co/microsoft/OmniParser)下載預訓練模型。

2. 環境設置:用戶在對應的適宜環境中安裝 OmniParser V2,保證兼容的 LLM 可用。

3. 數據輸入:準備好后,將需解析的 UI 截圖輸入 OmniParser V2。若從本地文件夾讀取,確保截圖格式是 OmniParser V2 支持的常見格式,像 PNG、JPEG 等。

4. 解析過程監控

解析時,若有監控界面,可以通過它查看解析進度,其中會顯示當前處理的截圖編號、預計剩余時間等信息。

也可查看日志文件(若已生成),這里記錄著解析過程的詳細信息,包括可能報錯的提示等。

5. 數據處理

解析完成后,OmniParser V2 輸出的數據通常以 JSON 等格式呈現。

根據應用場景對解析結果處理,比如用于自動化測試,可能需要將解析得到的 UI 元素位置和屬性等信息用于編寫測試腳本;若是用于數據錄入,可能就需要將結果導入到數據庫中。

GitHub倉庫:https://github.com/microsoft/OmniParser

HuggingFac模型庫:https://huggingface.co/microsoft/OmniParser

相關文章

- 用戶登錄

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺