VideoWorld:無需依賴語言模型,只通過視覺就可實現復雜任務

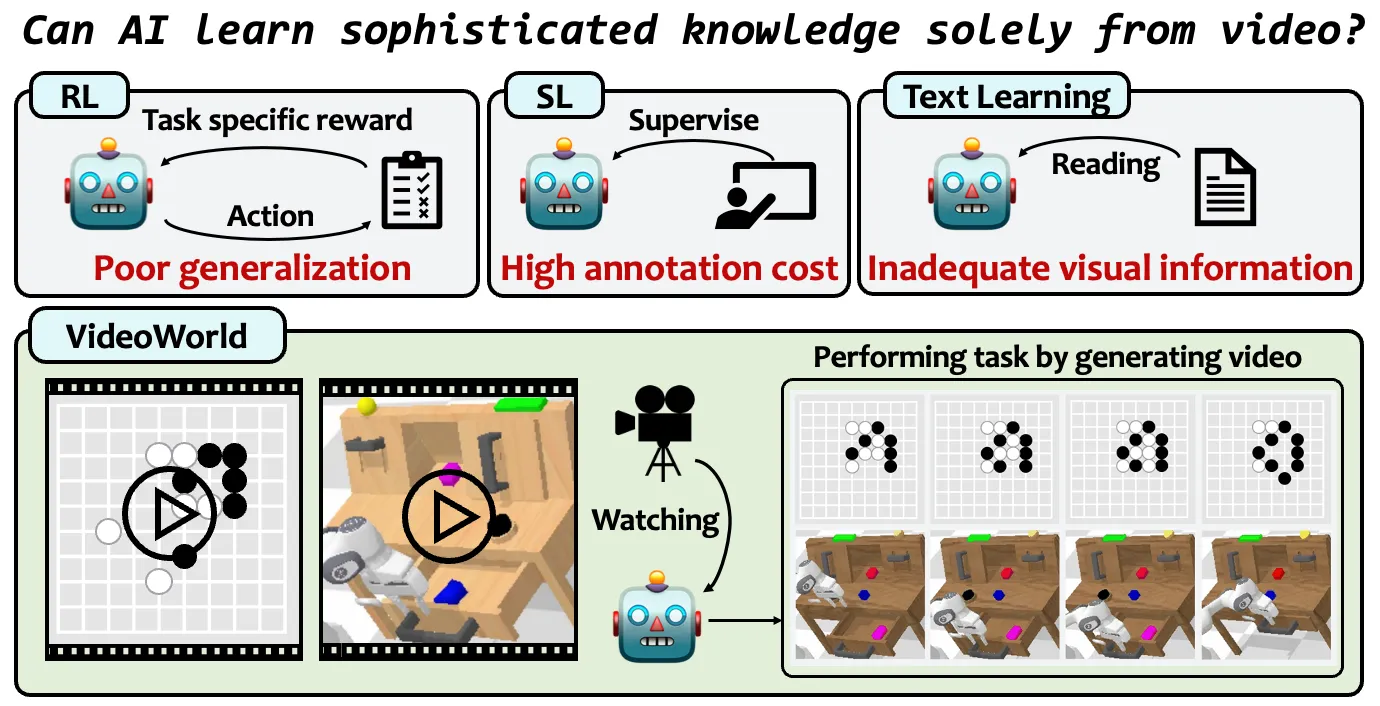

2025年2月10日,視頻生成模型“VideoWorld”由豆包大模型團隊與北京交通大學、中國科學技術大學聯合開發并正式開源,VideoWorld模型的核心創新在于它完全無需依賴語言模型,只通過視覺信息就可實現復雜任務的學習與生成。

一、核心功能特征

1. 純視覺知識學習

通過無標注視頻數據自主掌握復雜規則與策略(如圍棋落子邏輯、機器人操作時序),無需語言指令或強化學習的獎勵機制

支持多步驟推理與長期規劃能力,例如圍棋對弈中預判對手后續5-9步行動

2. 高效視覺表征壓縮

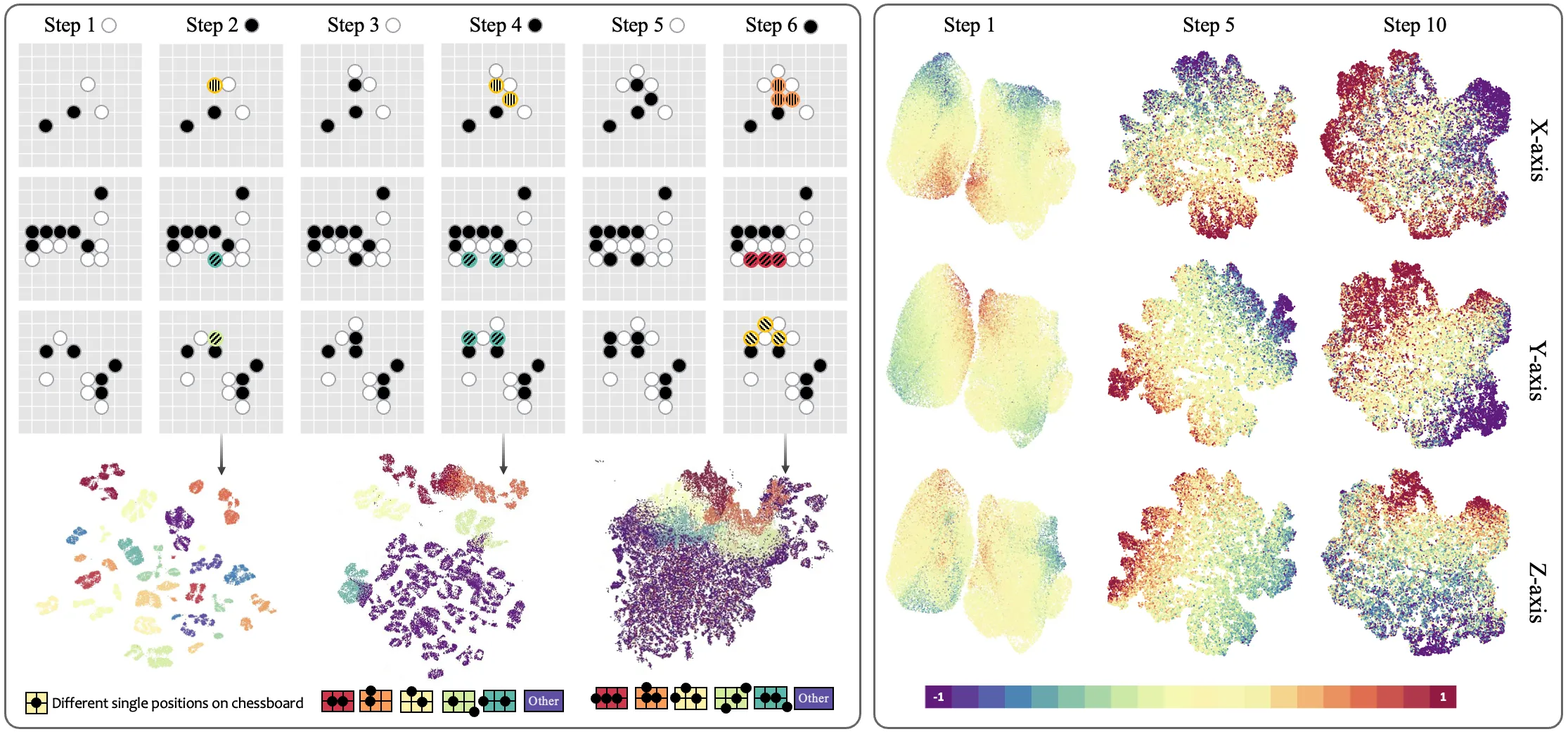

引入潛在動態模型(LDM)將視頻幀間變化編碼為緊湊的潛在序列,降低冗余信息干擾

實現長短期動態依賴的聯合建模,短時關注精細位移(如機械臂微調),長時捕捉任務級模式(如圍棋戰術組合)

3. 跨場景泛化能力

在CALVIN與RLBench機器人測試集上接近Oracle模型性能,可適應不同環境參數(如光照、物體位置)

圍棋對弈達職業五段水平(Video-GoBench基準),超越傳統強化學習代理。

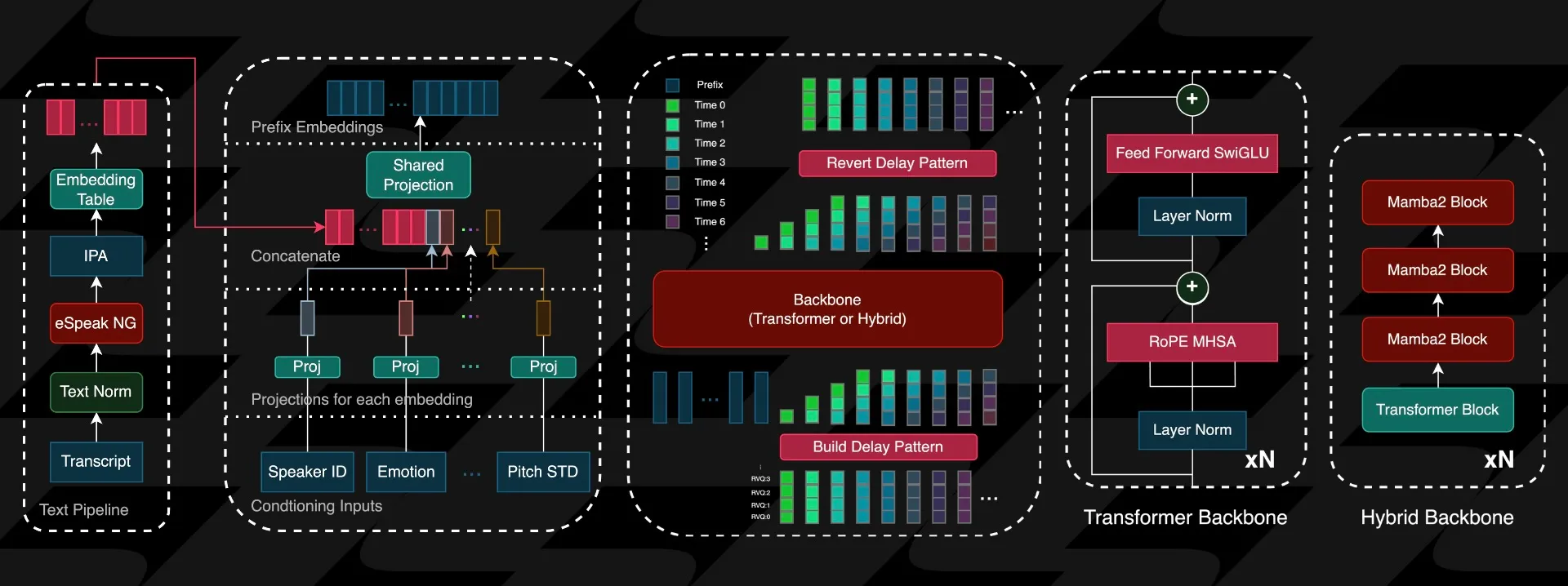

二、VideoWorld技術架構:

基礎架構

基于VQ-VAE將視頻幀離散化為token序列,采用自回歸Transformer實現幀級預測

訓練數據僅包含任務執行過程視頻(如圍棋棋局演變、機械臂操作記錄)

潛在動態模型(LDM)

編碼機制:將未來H幀視覺變化壓縮為連續潛在代碼,量化后作為預測目標

雙流預測:聯合優化視頻幀生成與潛在代碼預測,增強對關鍵決策節點的建模

可解釋分析:通過UMAP可視化顯示潛在空間聚類與任務動態強相關。

效率優化設計

模型參數量控制在3億級,相比傳統視頻模型降低80%計算開銷

訓練數據規模:Video-GoBench包含十萬級圍棋對局視頻幀

三、VideoWorld應用場景

內容創作:為短視頻制作、電影場景構思、游戲中的視覺內容生成等提供強大的支持。

教育:通過生成動態視頻,幫助學生更生動地理解復雜的知識。

廣告:根據用戶的偏好,生成個性化的廣告視頻,提升營銷效果。

四、VideoWorld下載和安裝:

1. 克隆倉庫:

git clone https://github.com/bytedance/VideoWorld.git cd VideoWorld

2. 安裝依賴:

pip install -r requirements.txt

3. 運行示例:示例代碼通常位于 examples 或 scripts 目錄下。根據需要調整配置文件并運行相應的腳本。

五、VideoWorld項目頁面:

項目主頁:https://maverickren.github.io/VideoWorld.github.io

GitHub 地址: https://github.com/bytedance/VideoWorld

論文鏈接: https://arxiv.org/abs/2501.09781

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺