AnyDressing:通過潛在擴(kuò)散模型實(shí)現(xiàn)可定制的多服裝虛擬穿衣

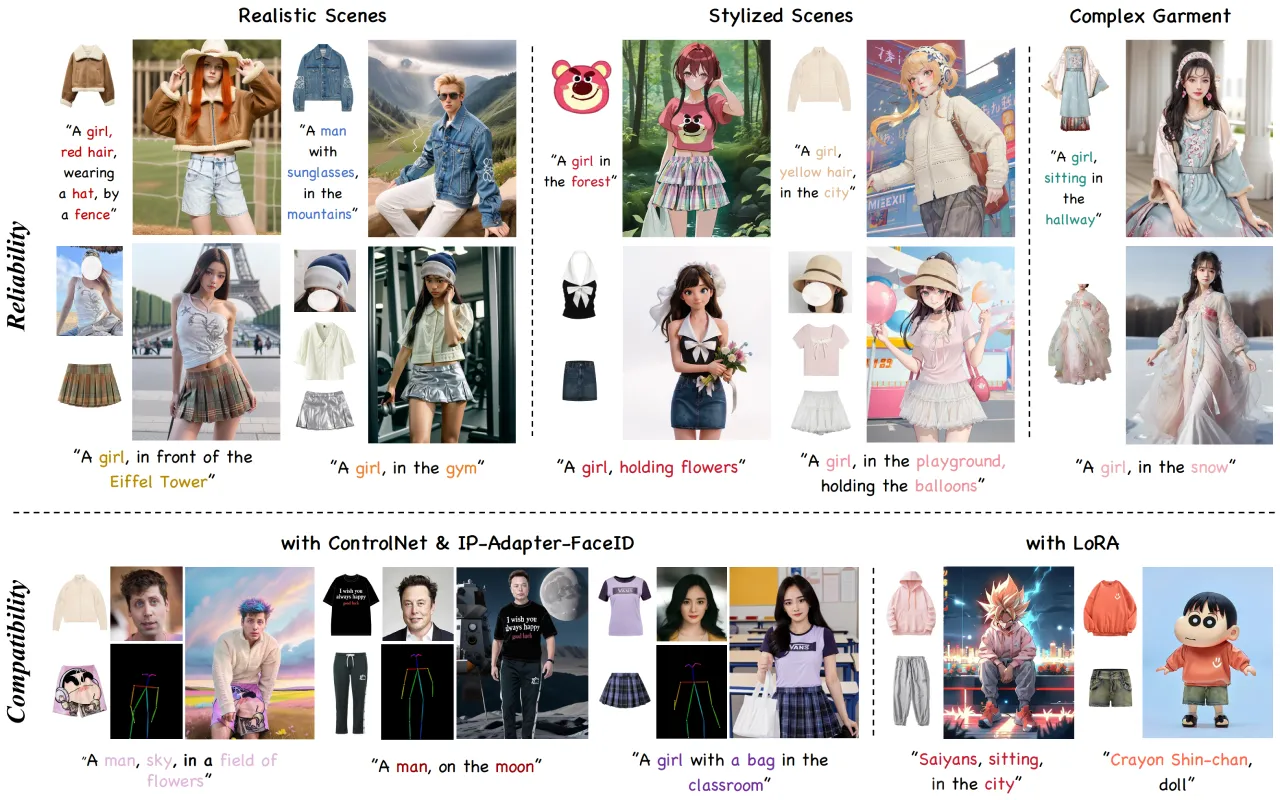

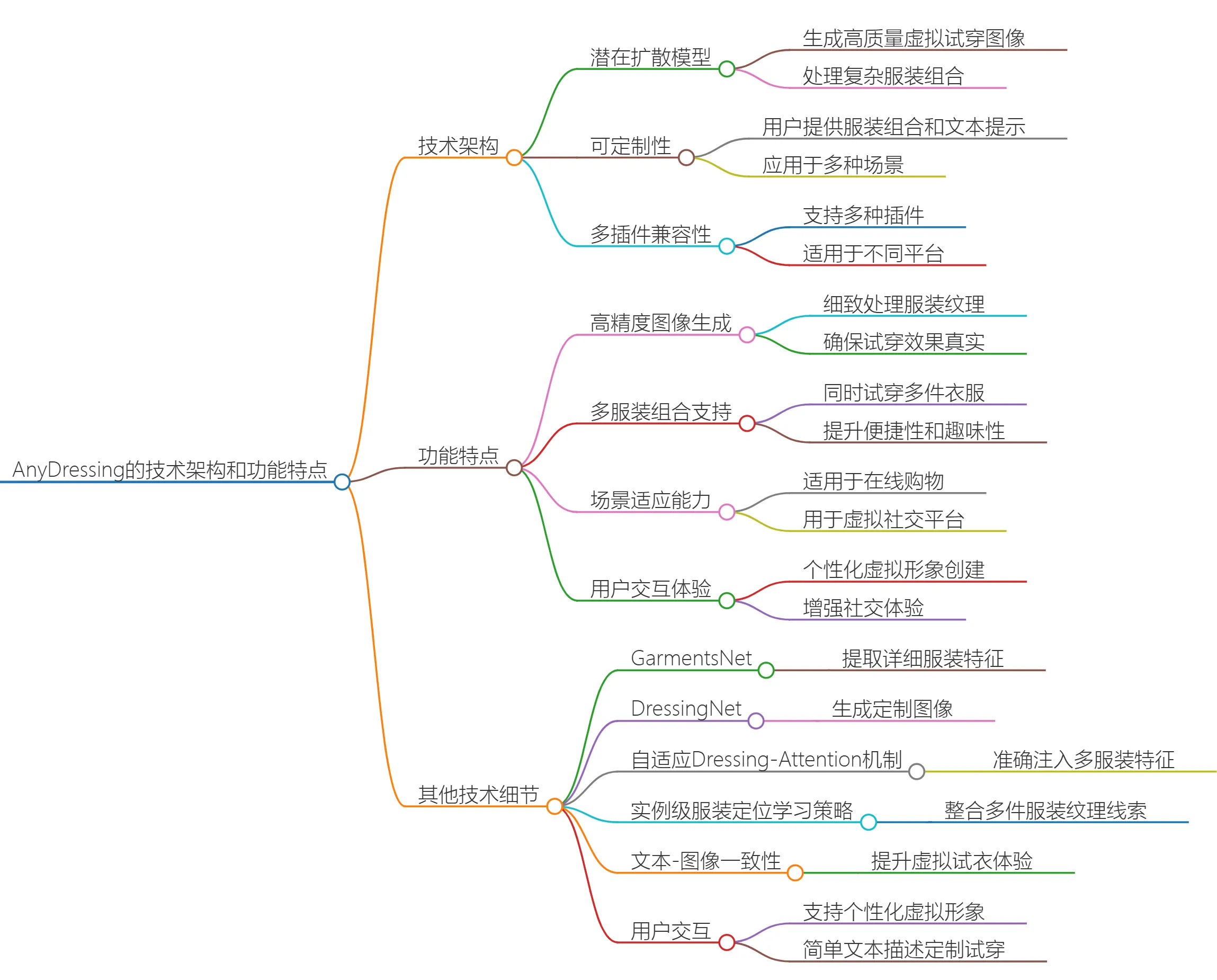

AnyDressing是字節(jié)跳動(dòng)和清華大學(xué)提出的一種基于潛在擴(kuò)散模型的可定制多服裝虛擬試穿方法,AnyDressing由GarmentsNet和DressingNet兩個(gè)主要網(wǎng)絡(luò)組成,分別用于提取詳細(xì)的服裝特征和實(shí)現(xiàn)多服裝的虛擬穿搭,AnyDressing可以應(yīng)用于多種虛擬試衣場(chǎng)景,包括現(xiàn)實(shí)和風(fēng)格化的場(chǎng)景,提供用戶定制化的虛擬試衣體驗(yàn)。

AnyDressing主要功能:

多服裝組合試穿:用戶可以同時(shí)試穿多件衣服,系統(tǒng)能夠處理復(fù)雜的服裝組合,確保每件衣服的細(xì)節(jié)和貼合度都得到良好呈現(xiàn)。

個(gè)性化定制:用戶可以根據(jù)自己的需求,通過提供參考服裝和文本提示,定制化試穿效果。這種個(gè)性化的功能使得用戶能夠根據(jù)自己的風(fēng)格和喜好進(jìn)行選擇。

高質(zhì)量圖像生成:AnyDressing利用先進(jìn)的圖像生成技術(shù),能夠生成逼真的虛擬試穿圖像,幫助用戶更好地理解服裝在自己身上的效果。

適用場(chǎng)景廣泛:該技術(shù)可以應(yīng)用于時(shí)尚零售、在線購物、社交媒體等多個(gè)領(lǐng)域,提升用戶的購物體驗(yàn)和滿意度。

研究與開發(fā):AnyDressing目前處于研究階段,由字節(jié)跳動(dòng)和清華大學(xué)的研究團(tuán)隊(duì)共同開發(fā),主要面向?qū)W術(shù)研究和效果展示,尚未正式商業(yè)化。

AnyDressing技術(shù)架構(gòu):

AnyDressing的技術(shù)架構(gòu)包括兩個(gè)主要網(wǎng)絡(luò):GarmentsNet和DressingNet。GarmentsNet負(fù)責(zé)提取詳細(xì)的服裝特征,而DressingNet則生成定制化的圖像。GarmentsNet中引入的服裝特征提取器能夠并行編碼多個(gè)服裝的紋理,避免了服裝混淆,同時(shí)確保網(wǎng)絡(luò)的高效性。DressingNet則采用自適應(yīng)的注意力機(jī)制和實(shí)例級(jí)服裝定位學(xué)習(xí)策略,準(zhǔn)確地將多服裝特征注入到相應(yīng)區(qū)域,從而提高生成圖像的多樣性和可控性。此外,AnyDressing還引入了增強(qiáng)紋理學(xué)習(xí)策略,以改善服裝的細(xì)節(jié)表現(xiàn)。該技術(shù)的實(shí)驗(yàn)結(jié)果顯示,AnyDressing在多服裝虛擬試穿任務(wù)中達(dá)到了最先進(jìn)的效果,具有很高的實(shí)用價(jià)值和研究潛力。

AnyDressing 的設(shè)計(jì)解決了現(xiàn)有技術(shù)在多服裝合成時(shí)面臨的挑戰(zhàn),如服裝保真度、文本一致性以及與社區(qū)控制擴(kuò)展的兼容性問題。它通過自適應(yīng)的 Dressing-Attention 機(jī)制和實(shí)例級(jí)服裝定位學(xué)習(xí)策略,精確地將服裝特征融入到正確的位置,同時(shí)通過服裝增強(qiáng)紋理學(xué)習(xí)策略來提升細(xì)節(jié)質(zhì)量,確保生成的虛擬服裝具有高度的逼真感。

AnyDressing相關(guān)鏈接:

項(xiàng)目官網(wǎng):https://crayon-shinchan.github.io/AnyDressing/

HuggingFace: https://huggingface.co/papers/2412.04146

代碼:https://github.com/Crayon-Shinchan/AnyDressing

論文:https://arxiv.org/abs/2412.04146

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺(tái)

開源AI應(yīng)用平臺(tái)