InspireMusic

InspireMusic簡介

InspireMusic是由阿里巴巴通義實驗室推出的開源音樂生成框架,其技術架構集成了多項音頻領域前沿研究成果,為開發者和研究者提供音樂創作、風格轉換及音效合成的全流程解決方案。該框架依托多模態大模型技術,支持通過文本描述或音頻輸入進行智能化創作,同時提供完善的模型調優工具鏈。

InspireMusic的文生音樂創作模式非常強。它支持通過文字描述生成各種風格和情感的音樂,用戶可以根據個人喜好生成爵士樂或旋律悠揚的童謠等多樣化作品。

InspireMusic核心功能:

音樂生成:InspireMusic可以基于用戶提供的文本描述,例如情感、風格、和聲等信息,自動生成符合要求的音樂作品。

音頻樣式轉換:該技術支持將現有音頻樣本轉換為不同風格的音樂,使用戶可以輕松實現風格轉換的效果。

訓練和調優工具:InspireMusic為開發者提供了一系列音頻生成模型的訓練和調優工具,以優化生成效果,滿足個性化需求。

多模態應用:通過結合文本、音頻及其交互,InspireMusic能夠提供豐富的音樂創作體驗,支持多種類型的音樂生成與編輯功能。

主要特點

統一的音頻生成框架:基于音頻大模型技術,InspireMusic支持音樂、歌曲及音頻的生成,為用戶提供多樣化選擇;

靈活可控生成:基于文本提示和音樂特征描述,用戶可精準控制生成音樂的風格和結構;

簡單易用:簡便的模型微調和推理工具,為用戶提供高效的訓練與調優工具。

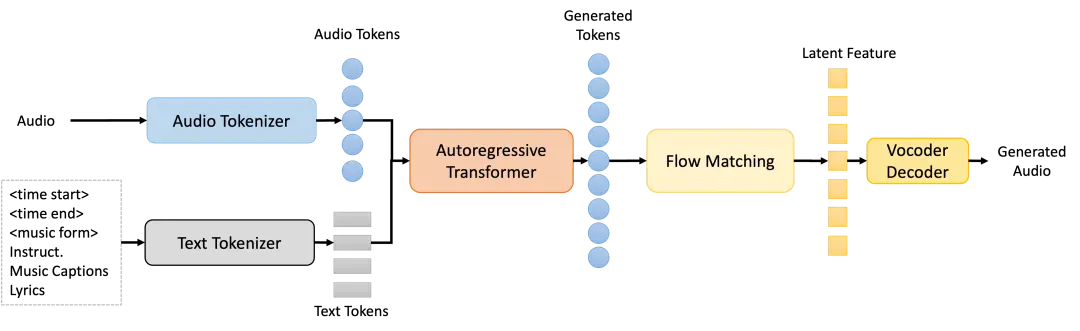

InspireMusic主要技術原理:

音頻Tokenizer:通過高壓縮比的單碼本WavTokenizer,將輸入的連續音頻特征轉換為離散的音頻token,支持模型處理的音頻數據格式。

自回歸Transformer模型:該模型基于Qwen模型進行初始化,用于根據文本提示預測音頻token,能夠理解并生成與文本描述匹配的音樂序列。

擴散模型(Conditional Flow Matching, CFM):用于從生成的音頻token中恢復高質量音頻特征,增強音樂生成的連貫性和自然度。

Vocoder:將重建后的音頻特征轉換為高質量的音頻波形,最終輸出音樂作品。它支持多種采樣率(如24kHz和48kHz),并能夠生成超過5分鐘的長音頻作品。

核心模型:

InspireMusic模型框架:由音頻tokenizer、自回歸Transformer模型、基于常微分方程的擴散模型即Conditional Flow Matching (CFM)模型、Vocoder所組成,可支持文本生成音樂、音樂續寫等任務。

InspireMusic的應用:

音樂創作:用戶通過簡單的文字描述或音頻提示生成多種風格的音樂作品。

教育和學習:該工具包為音樂愛好者和學習者提供了一個易于使用的創作平臺。

游戲和娛樂:InspireMusic可以用于生成游戲背景音樂或音效。

影視制作:用于影視配樂和音效制作。

廣告和營銷:InspireMusic可以生成符合廣告需求的音樂。

科研和開發:為研究者和開發者提供音樂生成模型的訓練和調優工具。

使用方式:

近日,阿里通義實驗室宣布旗下音樂生成技術InspireMusic已正式開源。用戶可以通過GitHub倉庫、ModelScope創空間以及HuggingFace Spaces等平臺訪問和使用InspireMusic。

GitHub 倉庫:https://github.com/FunAudioLLM/InspireMusic

ModelScope:https://modelscope.cn/studios/iic/InspireMusic/summary

HuggingFace:https://huggingface.co/spaces/FunAudioLLM/InspireMusic

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI