Xiaomi MiMo:小米開源的首個“為推理而生”的大模型

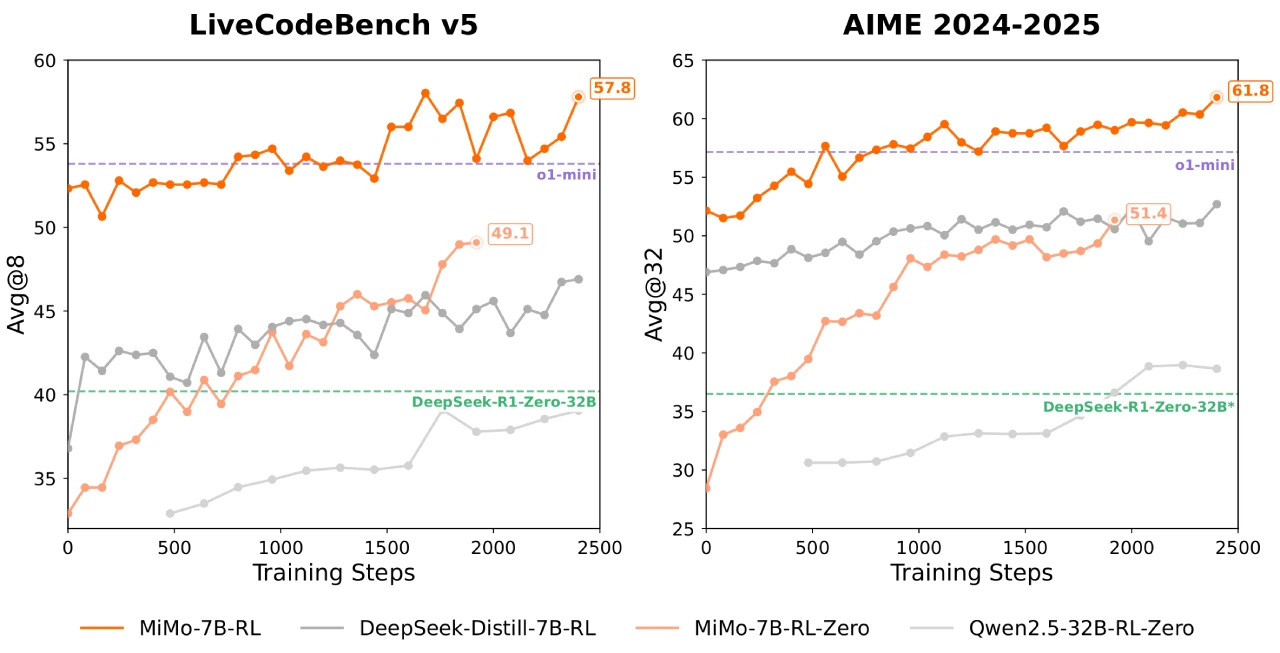

Xiaomi MiMo 是小米公司于 2025 年 4 月 30 日宣布開源的首個為推理而生的ai大模型。MiMo - 7B 系列模型通過充分挖掘語言模型的推理潛力,不僅關注后訓練,還注重針對推理的預訓練策略。該系列模型在相對較小的 7B 規模下,展現出超越許多 32B 模型的推理能力,其中 MiMo - 7B - RL 在數學和代碼推理任務上的表現可與 OpenAI o1 - mini 相媲美。

MiMo核心特點

預訓練

數據預處理優化:改進文本提取工具包,采用多維數據過濾,增加預訓練數據中的推理模式密度。

合成數據生成:運用多種策略生成大量多樣化的合成推理數據。

三階段數據混合:預訓練采用三階段數據混合策略,MiMo - 7B - Base 在約 25 萬億個標記上進行預訓練。

多令牌預測:引入多令牌預測作為額外訓練目標,提升模型性能并加速推理。

后訓練

優質訓練數據:精心挑選 130K 個數學和代碼問題作為 RL 訓練數據,每個問題都經過仔細清理和難度評估,并使用基于規則的驗證器確保數據質量。

代碼獎勵機制:針對具有挑戰性的代碼問題,引入測試難度驅動的代碼獎勵,通過為不同難度的測試用例分配細粒度分數,優化策略。

數據重采樣:對簡單問題實施數據重采樣策略,提高滾動采樣效率,穩定策略更新。

RL 基礎設施

無縫滾動引擎:開發無縫滾動引擎,集成連續滾動、異步獎勵計算和提前終止功能,減少 GPU 空閑時間,使訓練速度提高 2.29 倍,驗證速度提高 1.96 倍。

MTP 支持:在 vLLM 中支持 MTP,并增強 RL 系統中推理引擎的魯棒性。

MiMo模型版本

MiMo - 7B - Base:具有卓越推理潛力的基礎模型

MiMo - 7B - RL - Zero:從基礎模型訓練的 RL 模型

MiMo - 7B - SFT:從基礎模型訓練的 SFT 模型

MiMo - 7B - RL:從 SFT 模型訓練的 RL 模型,性能與 OpenAI o1 - mini 相當。

技術細節與創新點

預訓練數據優化:通過多維度數據過濾和合成推理數據生成,提升了預訓練數據的質量和推理模式密度。

MTP模塊:在預訓練中引入MTP模塊,顯著提升了推理任務的性能和推理速度。

RL基礎設施:開發了無縫回放引擎(Seamless Rollout Engine),加速了RL訓練和驗證過程,分別實現了2.29倍和1.96倍的速度提升。

測試難度驅動獎勵機制:為解決代碼問題中的稀疏獎勵問題,提出了基于測試難度的獎勵機制,提升了模型在困難問題上的學習效率。

實驗與結果

預訓練模型性能

MiMo-7B-Base:在多個基準測試中超越了其他7B參數規模的開源模型,如BBH、SuperGPQA等。

推理潛力評估:采用pass@k指標評估模型的推理潛力,MiMo-7B-Base在所有基準測試中均展現出更高的pass@k分數。

后訓練模型性能

MiMo-7B-RL-Zero:直接從MiMo-7B-Base進行RL訓練,展現了強大的推理能力。

MiMo-7B-RL:從SFT模型進行RL訓練,最終在數學和代碼任務上超越了OpenAI的o1-mini模型。

具體表現:

在AIME 2025中,MiMo-7B-RL得分55.4,超過o1-mini 4.7分。

在LiveCodeBench v5和v6中,MiMo-7B-RL顯著優于o1-mini。

相關鏈接

Hugging Face平臺:https://huggingface.co/XiaomiMiMo

GitHub 倉庫:https://github.com/XiaomiMiMo/MiMo

技術報告:https://github.com/XiaomiMiMo/MiMo/blob/main/MiMo-7B-Technical-Report.pdf

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺