Embodied-Reasoner:浙江大學和阿里巴巴達摩院等機構聯合提出的一個開源的多模態具身模型

Embodied-Reasoner是什么?

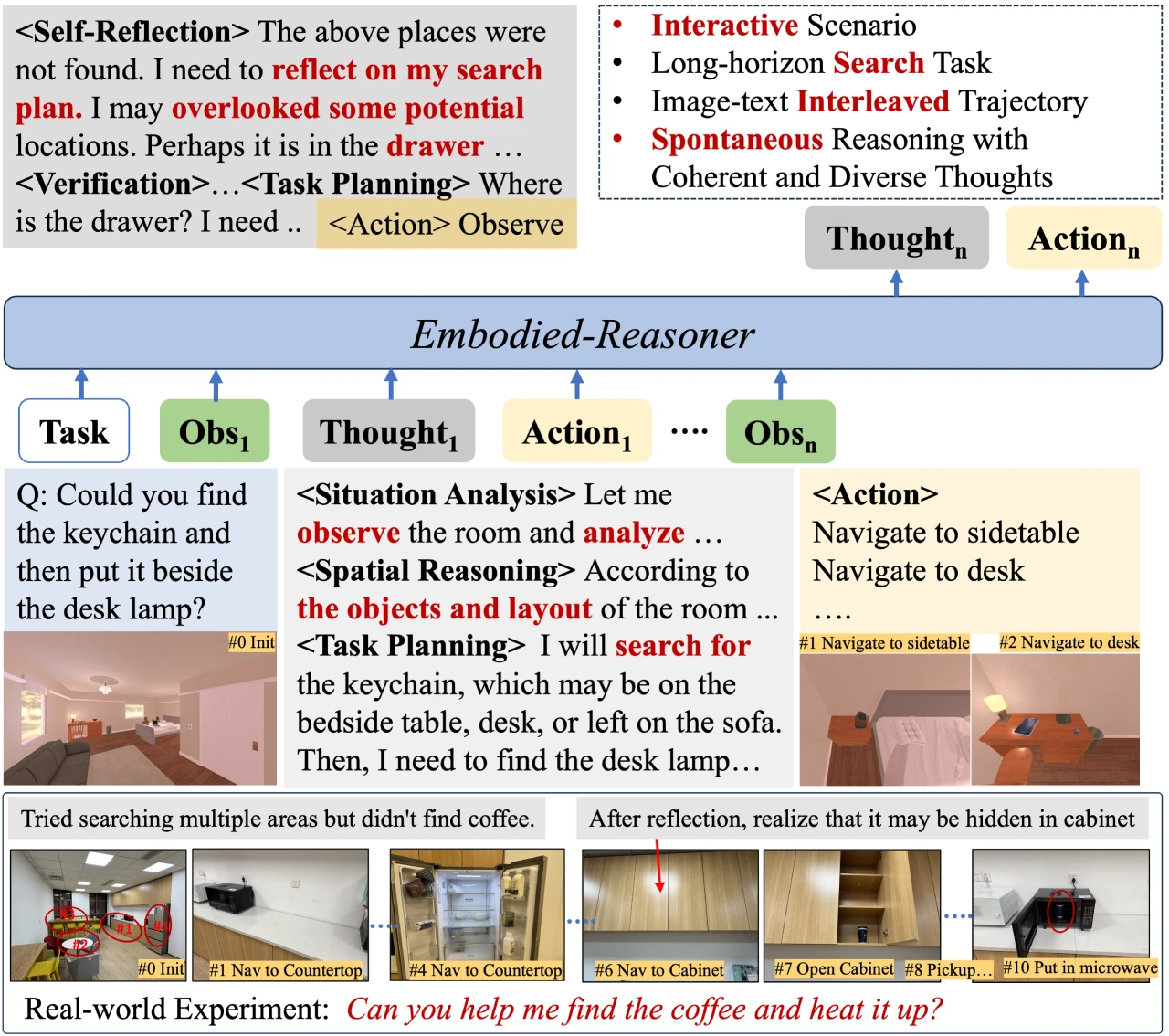

Embodied-Reasoner是由中科院軟件所、浙江大學和阿里巴巴達摩院等機構聯合提出的一個開源的多模態具身模型,它可以將深度推理能力擴展到具身交互任務中。能夠處理復雜的具身任務,例如在 ai2-THOR 模擬器中搜索隱藏物體、操縱和運輸物品等。

Embodied-Reasoner核心特點

深度推理能力:具備分析、空間推理、反思、規劃等多種推理能力。

多模態交互處理能力:能夠處理長序列的圖像-文本交互上下文。

環境交互能力:可以自主觀察環境、探索房間并找到隱藏物體。

開源模型和數據集:

提供 7B 和 2B 兩種大小的開源模型。

數據集包含 9.3k 交互式的觀察-推理-行動軌跡,涵蓋 64K 圖像和 8M 思考標記。

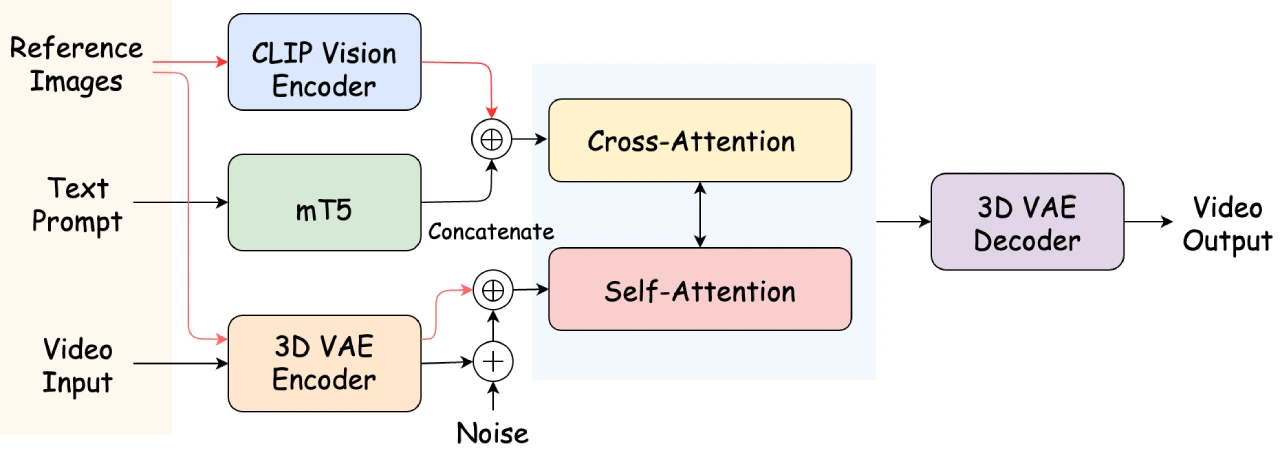

Embodied-Reasoner技術亮點

任務和軌跡引擎:自動合成連貫的“觀察-思考-行動”軌跡,覆蓋 107 種多樣化的室內場景,如廚房和客廳,涉及 2,100 個交互對象和 2,600 個容器。

長鏈思考與多樣化思考模式:包括分析、空間推理、反思、規劃和驗證等,這些連貫的圖像-文本交錯軌跡增強了其空間和時間推理能力。

迭代訓練流程:結合模仿學習、自我探索調整和自我修正調整的三階段迭代訓練流程。

交互式評估框架:包含 809 個測試用例,覆蓋 12 種新穎場景,評估模型在指令理解、關鍵動作和最終狀態方面的表現。

Embodied-Reasoner性能表現

成功率(Success Rate):衡量任務是否成功完成。

搜索效率(Search Efficiency):評估任務效率,步驟越多效率越低。

任務完整性(Task Completeness):計算預測動作中屬于關鍵動作的比例。

Embodied-Reasoner應用案例

模擬器實驗:Embodied-Reasoner 展現出自發的思考行為,例如分析環境狀態、反思遺漏細節、基于最新觀察進行推理以及回憶線索進行高效規劃。相比之下,缺乏思考能力的通用 VLM 在長時域交互任務中表現不佳,容易忘記任務或重復搜索。

真實世界實驗:在真實環境中,Embodied-Reasoner 能夠排除干擾,最終找到目標物體并完成任務,而 OpenAI 的 o3-mini 模型則無法制定合理計劃。

Embodied-Reasoner使用指南

訓練

1. 安裝依賴:

conda create -n llama-factory python=3.11 conda activate llama-factory git clone -b embodied-reasoner https://github.com/iGangao/LLaMA-Factory.git cd LLaMA-Factory pip install -e ".[torch,metrics]" pip install wandb accelerate deepspeed importlib-metadata

2. 數據準備:參考 data/README.md 文件了解數據集文件的格式。

3. 運行訓練腳本:運行訓練腳本。

評估

1. 安裝依賴:

conda create -n embodied-reasoner python=3.9 conda activate embodied-reasoner pip install -r requirements.txt

2. 運行評估腳本:運行評估腳本。

數據引擎

TaskGenerate.py:合成任務模板和對應的關鍵動作。

o1StyleGenerate.py和 o1StyleGenerate_ordered.py:分別為 10 種不同子任務類型合成軌跡,后者用于合成更復雜的順序對象轉移任務。

相關鏈接

GitHub項目主頁:https://github.com/zwq2018/embodied_reasoner

Hugging Face 數據集:https://huggingface.co/datasets/embodied_reasoner

Arxiv 論文:https://arxiv.org/abs/2503.21696

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺