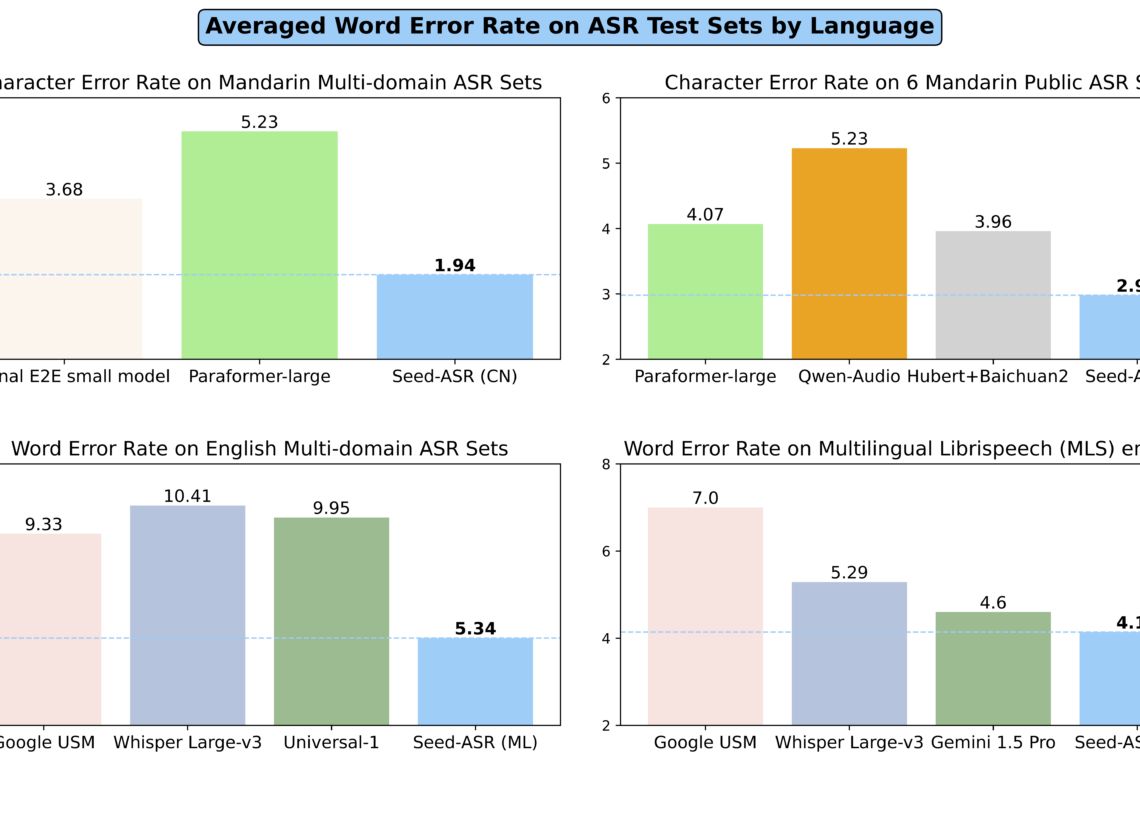

Seed-ASR:字節跳動自動語音識別模型

Seed-ASR,字節跳動自動語音識別模型,可將各種語音轉化為文本信息,與傳統 TTS 面向單一任務不同,Seed-TTS 能夠建模各種聲音,且允許同時從很多個維度進行操控,可識別不同語言、方言、口音,甚至吞字這類語音上的瑕疵。Seed-ASR在超過2000萬小時的語音數據和近90萬小時的配對ASR數據上進行了訓練。不僅支持普通話,還能識別13種中國方言和7種外語以及各種口音的英語。

Seed-ASR 具有強大的上下文感知能力,能夠識別在特定上下文下的語音內容。例如,模型可以利用歷史對話或會議記錄來更準確地識別當前語音中的人名、地名或其他上下文相關的關鍵詞。

Seed-ASR具備強大的擴展性。這意味著它不只是一個固定的系統,而是可以根據具體需求進行定制的平臺。比如說,你想讓它專門識別醫學術語,或者理解某種特殊口音,都可以通過微調來實現。

Seed-ASR最核心的技術就是把大語言模型融入到了語音識別中,為 Seed-ASR引入了上下文理解能力。這可不是簡單地把兩個系統拼在一起,而是從根本上改變了處理語音的方式。它就像是給語音識別系統裝上了一個超級大腦,不僅能聽,還能思考。

Seed-ASR技術亮點:

高精度識別:通過數十億參數的模型處理復雜的語音輸入,實現高精度識別。

大容量模型:使用大語言模型,提高了語音識別的準確性和上下文理解能力,好比是用"超級計算機"來幫你聽寫筆記,想想就覺得太酷了。

支持多種語言:包括普通話、13種中國方言以及多種外語,并計劃擴展至40多種語言。

上下文感知:能夠結合上下文信息,提高識別的準確性,就像你跟朋友聊天,它能聽懂你們之前說過什么,然后根據這些信息更準確地理解你現在說的話。

分階段訓練方法:包括自監督學習、監督微調、上下文微調和強化學習,逐步增強模型能力。

Seed-ASR應用場景:

人機交互:提供語音輸入渠道,通過實時將語音轉成文字作為輸入,達到和設備/硬件/應用快速、便捷交互的目的。

內容審核:將錄音識別為文字,通過質檢規則對文本進行分析,及時發現違規內容并干預處理。

會議訪談轉寫:將會議、訪談音頻實時或異步識別為文字,自動切分有語音部分識別,降本增效。

音視頻字幕:支持自動將音視頻中的語音、歌詞識別轉換為文本,一鍵生成與音視頻對應的字幕內容。

Seed-ASR 已在豆包 APP 中應用,被網友用在英語會話、虛擬聊天伴侶、復刻親友聲音等多個場景。面向更多企業客戶,Seed-ASR 依托火山引擎, 在語音交互、內容審核、會議訪談轉寫、音視頻字幕等場景也有落地。

截至目前,豆包大模型團隊語音方向已發布 Seed-TTS 、Seed-ASR 等多項技術成果。

Seed-ASR官網:https://bytedancespeech.github.io/seedasr_tech_report/

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺