V2A:Google發(fā)布的自動生成與視頻內(nèi)容同步的音頻技術(shù)

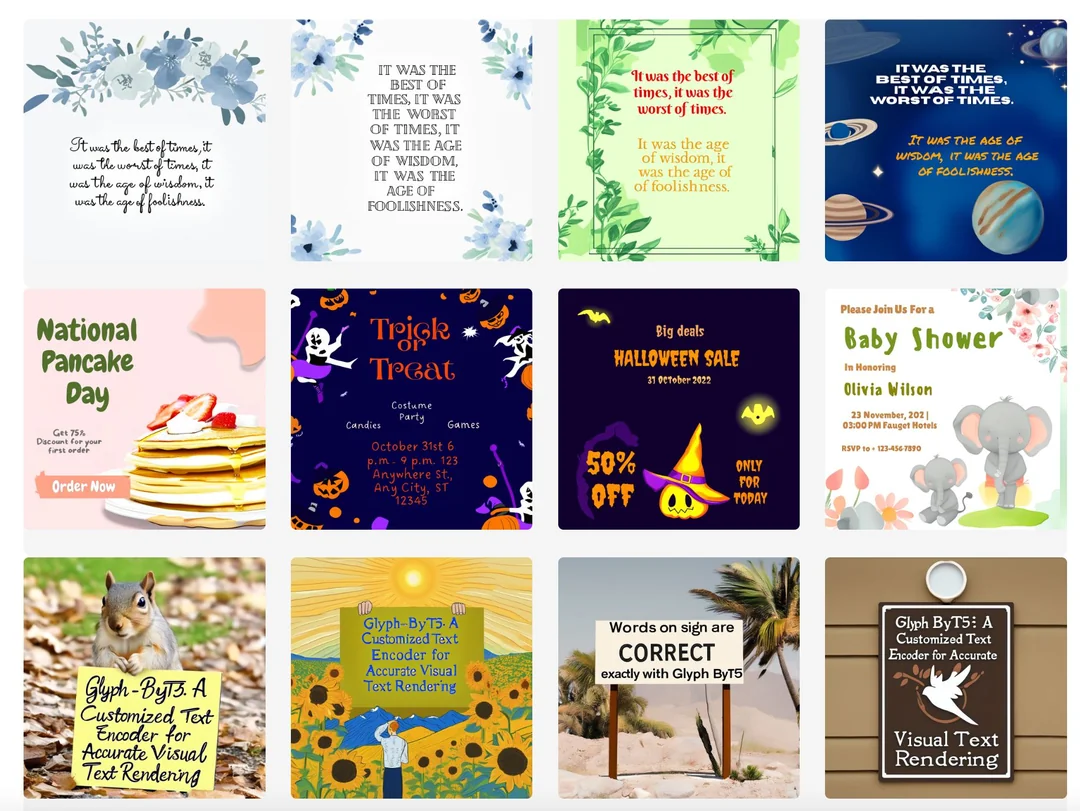

Google DeepMind最近發(fā)布了一項名為V2A(Video-to-Audio)的技術(shù),V2A能夠根據(jù)視頻畫面和文字描述自動生成與視頻內(nèi)容同步的音頻,也就是給 ai 視頻自動配音、配樂。這使得用戶可以通過文字描述來生成背景音樂、環(huán)境音效來自動生成與視頻內(nèi)容同步的音軌。這包括背景音樂、環(huán)境音效甚至與視頻內(nèi)容匹配的對話。

視頻生成模型正以驚人的速度發(fā)展,但目前的視頻生成模型只能生成無聲輸出。V2A技術(shù)成為讓生成的電影栩栩如生的一種有前途的方法。

V2A主要功能

音頻生成:V2A可以根據(jù)視頻畫面和用戶提供的文字描述,自動生成與視頻內(nèi)容同步的音軌。

同步音頻:V2A能夠確保生成的音頻與視頻內(nèi)容完美同步,使得視頻和音頻之間沒有任何延遲或錯位。

多樣化音軌:用戶可以為任何視頻生成無限數(shù)量的音頻,嘗試不同的音效組合。

創(chuàng)意提示:V2A支持“正向提示”和“負(fù)向提示”功能,通過這些提示,用戶可以精確控制生成的音頻效果。

高質(zhì)量音頻:通過在訓(xùn)練過程中引入詳細(xì)的聲音描述和對話轉(zhuǎn)錄,生成的音軌真實且富有表現(xiàn)力。

自動化處理:V2A系統(tǒng)不需要手動對齊生成的聲音與視頻,減少了調(diào)整聲音、視覺和時間元素的繁瑣工作。

V2A工作原理

輸入視頻和文字描述:用戶提供視頻和文字描述作為輸入。

視頻編碼:系統(tǒng)將視頻轉(zhuǎn)換成AI可以處理的格式。

生成音頻:AI模型從隨機噪聲開始,逐步生成與視頻和文字描述相匹配的音頻。

合成音頻和視頻:生成的音頻與視頻結(jié)合,形成完整的音視頻文件。

調(diào)整和控制:用戶可以提供額外的提示進(jìn)行調(diào)整,以滿足特殊需求。

V2A技術(shù)發(fā)展

盡管V2A技術(shù)已經(jīng)展現(xiàn)出巨大潛力,DeepMind團隊仍在不斷改進(jìn)和完善這項技術(shù)。目前的研究方向和改進(jìn)目標(biāo)包括:

音頻輸出質(zhì)量改進(jìn):確保在各種視頻質(zhì)量下保持音頻輸出的一致性和高質(zhì)量。

唇同步改進(jìn):改進(jìn)對話視頻中的唇同步問題,確保生成的語音與角色的唇部動作完美同步。

處理視頻失真:解決視頻失真或內(nèi)容超出模型訓(xùn)練數(shù)據(jù)分布時的音頻生成問題。

安全與透明性:進(jìn)行嚴(yán)格的安全評估和測試,確保技術(shù)的安全性和透明性。

V2A的應(yīng)用很廣泛,從社交媒體內(nèi)容制作到電影和廣告的音頻設(shè)計都有無限的可能。

V2A 技術(shù)的獨特之處在于,它可以理解視頻中的原始像素,并自動將生成的聲音與視頻同步,目前,V2A嘗試通過輸入的對話文本生成與角色唇部動作同步的語音,但有時會出現(xiàn)視頻中的口型與生成的語音不完全匹配的情況。DeepMind正在致力于改進(jìn)這一方面。

詳細(xì)情況:https://deepmind.google/discover/blog/generating-audio-for-video/

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺

開源AI應(yīng)用平臺