StableAvatar

StableAvatar 簡介

StableAvatar 是什么?

StableAvatar 是由復旦大學、微軟亞洲研究院和西安交通大學等機構的研究人員開發的一個能通過音頻直接生成唱歌或說話視頻的工具,而且視頻時長不受限制,畫面質量也很高。

StableAvatar 核心技術

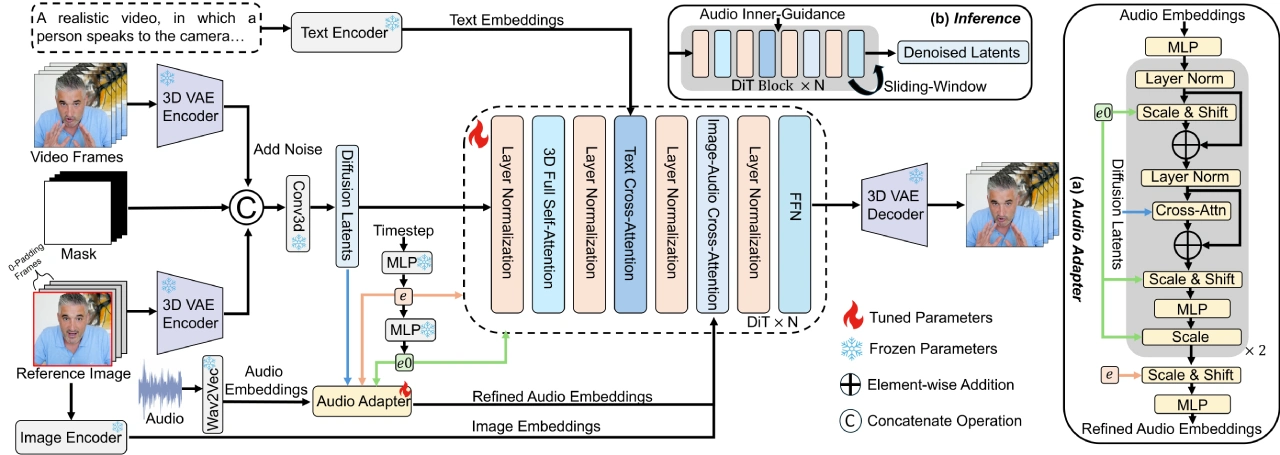

時間步感知音頻適配器:這個技術主要是防止音頻信息在轉換過程中出錯。它會把一開始的音頻信息和圖片的初始信息做“交叉注意力”處理(簡單理解就是讓兩者更好地關聯起來),再用“時間步嵌入”做調整(類似給不同時間點的信息做微調),最后得到更準確的音頻信息,避免后面生成視頻時畫面和音頻對不上或者畫面變形。

音頻原生引導機制:在生成視頻的最后階段(也就是推理階段),它會利用模型自己預測的音頻和畫面信息,把這些動態變化的信息當作“引導信號”,讓生成的視頻和音頻同步性更強,不會出現聲音和嘴型對不上的情況。

動態加權滑動窗口去噪策略:生成長視頻時,畫面容易卡頓或者不連貫。這個技術通過在時間維度上融合畫面的潛變量信息(可以理解為畫面的隱藏特征),讓長視頻的每一幀過渡更平滑,不會出現突然的跳動或者變形。

StableAvatar 工作原理

處理音頻:先把輸入的音頻通過 Wav2Vec 模型提取出音頻特征(也就是 audio embeddings),然后用前面提到的“音頻適配器”對這些特征做優化,讓音頻信息更準確。

處理參考圖像(比如人物的初始照片):參考圖像會通過兩條路徑輸入到生成視頻的模型里:

第一條路徑:把參考圖像和零填充幀(相當于空白幀)按時間軸拼接起來,再通過一個固定的 3D VAE 編碼器轉換成潛變量編碼(類似畫面的隱藏信息)。這個潛變量編碼會和壓縮后的視頻幀以及二值掩碼(用來標記哪些部分需要重點處理)在通道軸上拼接,為后續生成畫面提供基礎。

第二條路徑:通過 CLIP 編碼器(一種能提取圖像關鍵特征的模型)把參考圖像轉換成 image embeddings(圖像特征),然后把這些特征輸入到去噪模塊(DiT)的每個“圖像-音頻交叉注意力模塊”里,目的是讓生成的視頻里人物的長相和參考圖像一致。

生成視頻:推理階段,原本應該輸入的真實視頻幀會被替換成隨機噪聲(這是這類模型的常規操作),其他輸入(比如優化后的音頻、處理好的參考圖像信息)保持不變,最終通過模型計算生成連續的視頻幀,形成完整視頻。

StableAvatar 優勢

能生成超長視頻:以前的工具大多只能生成不到 15 秒的短視頻,而 StableAvatar 可以生成任意時長的視頻,而且畫面質量依然很高(高保真)。

人物形象不走樣:即使生成很長的視頻,視頻里人物的臉和身體動作也能保持一致,不會出現臉變形、身體比例奇怪或者前后外觀不搭的問題。

不用額外處理:生成的視頻直接就能用,不需要再用其他工具去修臉(比如常見的面部置換工具 FaceFusion 或者修復模型 GFP-GAN、CodeFormer 等),省了好多麻煩。

StableAvatar 的應用場景

1. 電影和視頻制作

高難度動作場景:不用演員親自冒險拍危險動作(比如跳樓、爆炸),用它生成視頻能降低成本和風險。

角色動畫:給電影或視頻里的人物加上逼真的動作和表情,讓人物更生動。

修復老影片:能把老舊電影膠片里的人物修復得更清晰,讓經典角色重新鮮活起來。

2. 游戲開發

角色動畫:游戲里的角色動作和表情更真實,玩家玩起來更有代入感。

過場動畫:游戲劇情過渡的視頻更精彩,吸引玩家繼續玩。

虛擬角色互動:游戲里的 NPC(非玩家角色)動作和表情更自然,讓游戲世界更真實。

3. 虛擬現實(VR)和增強現實(AR)

創建虛擬角色:在 VR/AR 應用里生成逼真的人物,讓用戶感覺像和真人互動。

VR 社交:用戶可以和生成的虛擬人物聊天、互動,增加社交樂趣。

VR 旅游:讓用戶通過 VR 設備“親身”體驗世界各地的風景,就像真的去旅游了一樣。

4. 社交媒體和直播

虛擬主播:生成的虛擬主播形象始終一致,直播時動畫效果更真實。

創意內容:短視頻創作者和數字藝術家可以用它設計各種有趣的動態形象,做出更有創意的內容。

5. 教育和客服

虛擬助手:在教育或客服場景里,生成形象一致的虛擬老師或客服,提供更生動、個性化的服務(比如虛擬老師一直保持同一個外貌給學生上課)。

6. 廣告和數字營銷

電影級廣告:能生成復雜的人物動作和鏡頭效果,適合做廣告、短片或者動畫宣傳,畫面質量達到電影級別。

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI