MultiTalk:美團開源的音頻驅動多人對話視頻生成工具

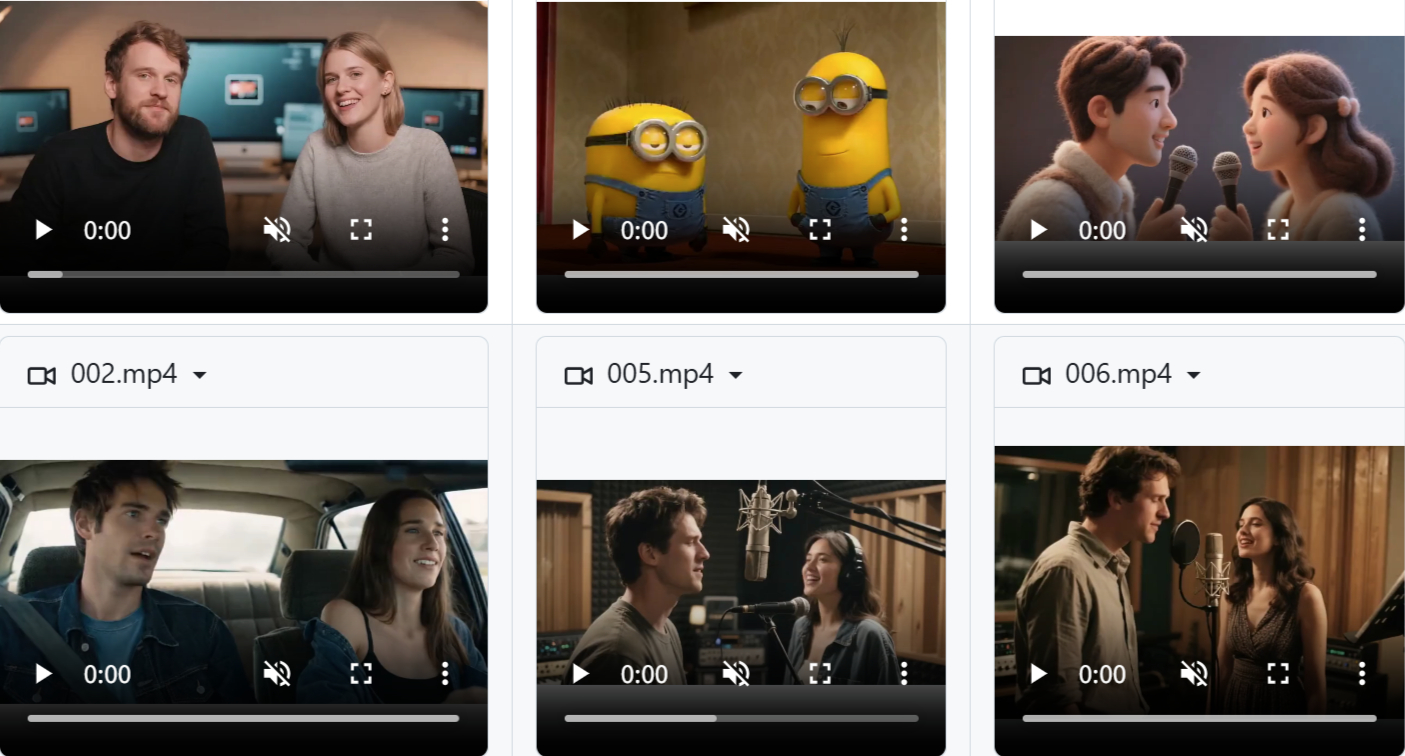

MultiTalk 是美團視覺智能團隊開源的音頻驅動多人對話視頻生成工具。它能根據多人音頻、參考圖像和文字提示,生成口型同步、肢體自然的數字人對話視頻,效果很好。用戶只需上傳音頻、參考圖和提示詞,就能生成嘴型匹配的對話視頻,還能生成歌唱場景和卡通角色。

這個項目有不少實用特點:音頻驅動的嘴型同步很精準,能用提示詞控制虛擬角色動作,能輸出不同分辨率的視頻,還能生成長達 15 秒的對話場景。另外,它集成了文本轉語音功能,做了多項優化來提高生成效率,支持低顯存模式和多 GPU 推理,在單張 RTX 4090 顯卡上就能運行。

功能特征

?音頻驅動:輸入多人音頻,就能生成自然的口型同步和肢體動作

?單張照片輸入:僅用一張參考圖像,就能生成多人互動視頻

?復雜動作遵循:支持復雜文字提示,生成符合描述的動作和場景

?多語言支持:能處理多語言音頻,實現精準的唇部同步

?長視頻生成:用自回歸方法生成連貫的長視頻

?高效訓練策略:通過兩階段訓練、部分參數訓練和多任務訓練,提升模型性能

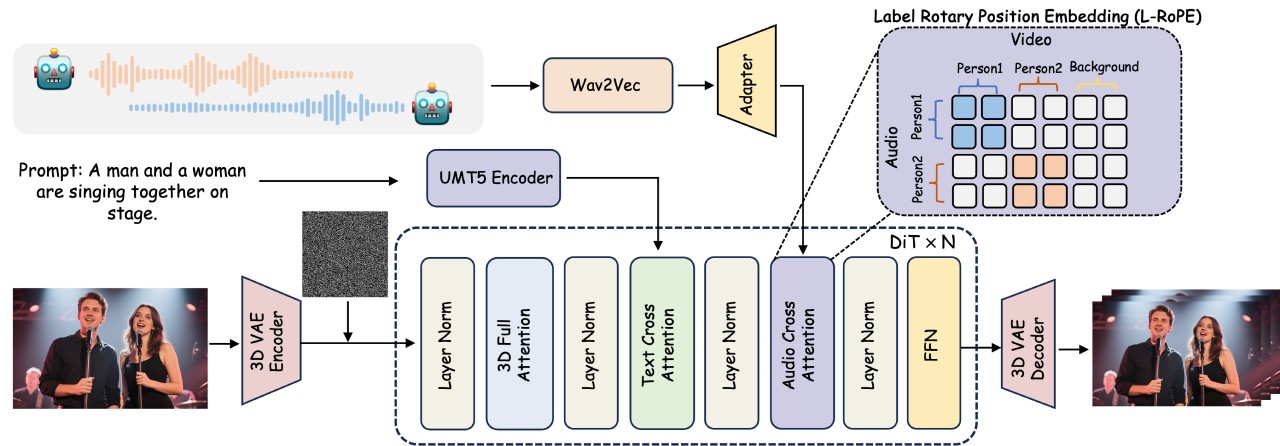

?L-RoPE 技術:借助標簽旋轉位置編碼,實現多流音頻與人物的精準綁定

?高質量輸出:生成的視頻自然流暢,視覺上幾乎沒有偽影

技術亮點

?首創 L-RoPE 技術:用標簽旋轉位置編碼解決多音頻流與人物錯位問題,讓音頻和人物精準對應

?音頻驅動視頻生成:輸入多人音頻、參考圖像和文字提示,就能生成口型同步、肢體自然的交互視頻

?局部參數訓練 + 多任務學習策略:在保留復雜動作指令跟隨能力的同時,實現動態人物的自適應定位

?多場景支持:可用于影視制作、直播電商等多種場景

技術框架

?基礎模型結構:以 DiT 視頻擴散模型為核心,集成 3D 變分自編碼器,高效處理視頻數據

?單人音頻集成:在每個 DiT 塊的文本交叉注意力層后添加音頻交叉注意力機制,用 Wav2Vec 提取音頻特征,通過音頻適配器解決視頻和音頻時間粒度不匹配的問題

?多人音頻處理:靠 L-RoPE 技術實現多流音頻與多個人物的精準綁定,避免 “齊聲說話”

訓練策略:

?兩階段訓練:先練單人視頻生成能力,再練多人物交互和綁定

?部分參數訓練:只更新音頻交叉注意力層和音頻適配器的網絡參數,凍結其他基礎模型參數

?多任務訓練:結合音頻 + 圖像到視頻、圖像到視頻兩種訓練方式,增強模型的指令遵循能力

性能表現

?定量評估:在頭部和身體動作生成任務中,和多個先進方法相比,在唇形同步(Sync-C、Sync-D)和視頻質量(FID、FVD)上表現突出

?定性評估:處理復雜交互場景時效果好,能生成精準響應復雜文字提示的視頻,視覺偽影少,畫面自然真實

?長視頻生成:用自回歸方法,把之前生成視頻的末尾部分作為條件,生成新的視頻片段,保證時間上的連貫和擴展

適用場景

影視制作:虛擬角色互動、動畫配音、特效合成、短片創作

直播電商:虛擬主播互動、產品展示解說、多語言直播

教育領域:虛擬教師互動、語言學習、歷史重現

游戲開發:虛擬角色對話、NPC 互動、多人在線游戲

廣告營銷:虛擬代言人、產品推廣、社交媒體廣告

虛擬社交:虛擬社交平臺互動、虛擬會議

娛樂創意:音樂視頻、虛擬演唱會、創意短片

公共服務:新聞播報、公共服務宣傳

企業培訓:虛擬培訓場景、情景模擬

國際交流:多語言對話、文化交流

項目地址

項目主頁:https://meigen-ai.github.io/multi-talk/

開源代碼:https://github.com/MeiGen-AI/MultiTalk

論文技術:https://arxiv.org/abs/2505.22647

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI