dots.llm1:小紅書Hi Lab發布的首個開源大模型

小紅書于2025年6月7日開放其首個大模型dots.llm1,是小紅書Hi Lab(人文智能實驗室)自主研發的,dots.llm1是一個1420億參數的專家混合模型(MoE),通過推理時只激活140億參數,保持高性能的同時,大大降低了訓練和推理成本。

模型特色

使用大規模自然訓練數據:使用11.2萬億token非合成高質量訓練數據,在現階段的開源大模型中非常少見,這使得它在中文測試中有強大的性能,以91.3的平均分超過了DeepSeek開源的V2、V3和阿里開源的Qwen2.5 32B和72B。

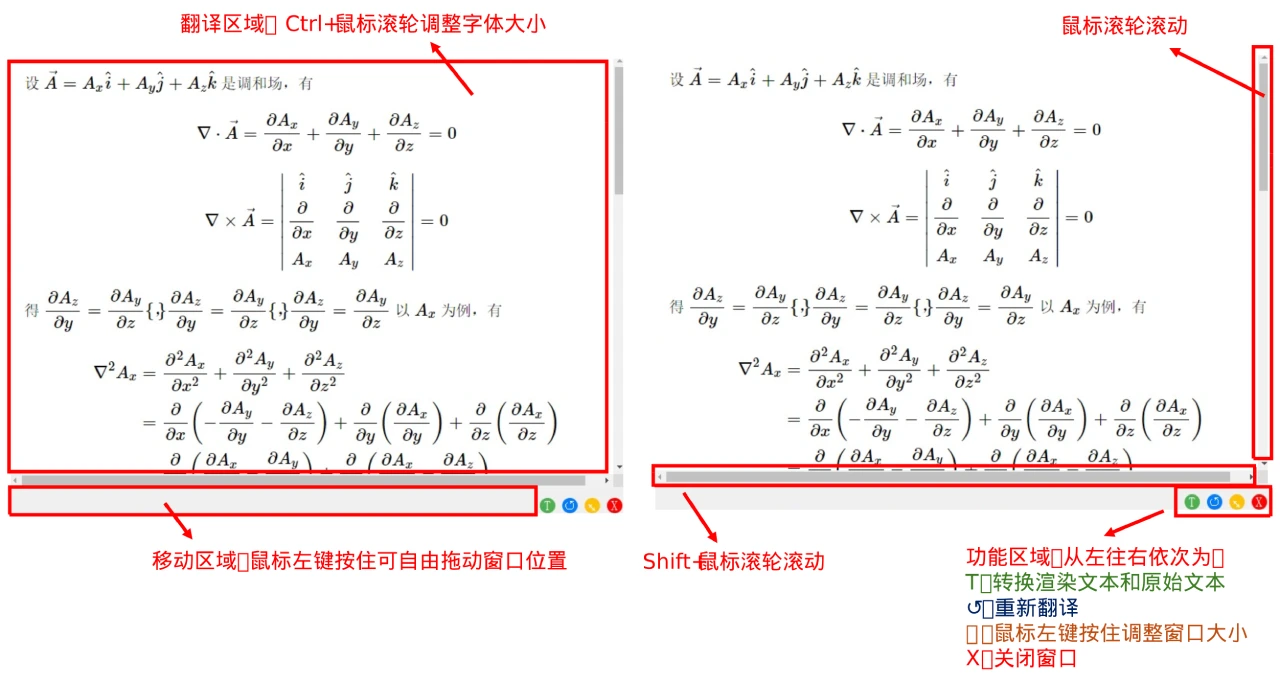

架構設計:使用單向解碼器Transformer架構,但將前饋網絡替換成MoE。在推理時不激活全部專家網絡,而是根據輸入標記的性質動態選擇激活一小部分專家網絡做計算,這種稀疏激活的方式極大降低了算力需求的同時保證了模型高性能。dots.llm1的MoE由128個路由專家和2個共享專家組成,每個專家網絡是一個兩層的前饋網絡,使用SwiGLU激活函數。在每個輸入標記的處理上會通過一個路由機制選擇6個最相關的專家網絡,加上2個共享專家,總共激活8個專家網絡。

注意力層優化:使用經典的多頭注意力機制(MHA),且在其基礎上添加了RMSNorm歸一化操作,避免了輸入值過大或過小對模型訓練的影響,從而提高了模型的穩定性和性能。

負載平衡策略:在MoE模塊上引入了無輔助損失負載平衡策略。

模型性能

中文測試:中文測試表現出色,如在CLUEWSC語義理解上得分92.6,為業內領先水平;C-Eval綜合知識測試得分92.2超過了包括DeepSeek-V3在內所有對比模型;中文任務平均得分80.5,明顯領先;以91.3的平均分超過了DeepSeek開源的V2、V3與阿里 open Qwen2.5 32B、72B。

數學推理:在MATH500基線測試得到84.8分,接近行業頂尖;在aiME24競賽題上得分33.1,體現出處理復雜數學問題的能力;CNMO24(中國數學奧林匹克)得分40.6,數學綜合得分60.9。

英語和代碼能力:在MMLU、DROP、 GPQA等英語基準測試與Qwen相當,平均得分64.4;代碼能力平均分達到了Qwen2.5的水平。

指令和人類偏好對齊:在IFEval、AlpacaEval2、ArenaHard等指令和人類偏好對齊上,平均得分為77.9,表明模型能夠準確理解和執行復雜的指令。

成本控制優勢

與Qwen2.5-72B相比,dots.llm1在訓練每萬億token時,GPU小時從340K減少到130K,效率提升得益于其獨特的通信和計算重疊方案及高效的分組GEMM實現。

模型支持與應用場景

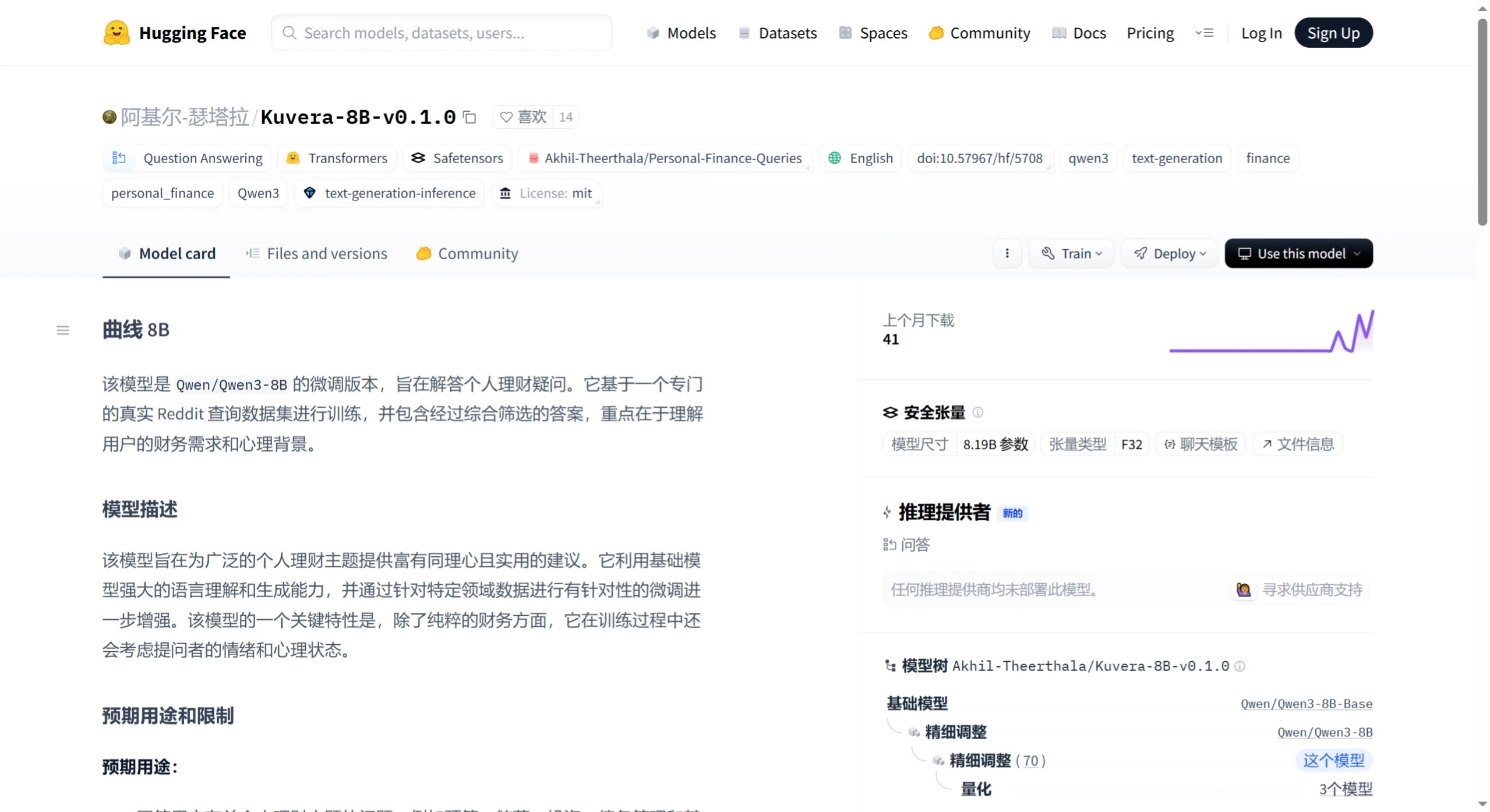

支持功能:支持中英雙語,上下文長度達32768個token,還支持function call功能,官方提供的mmlu-pro評測分數比Qwen3-235b-a22b好,但與最新的DeepSeek-V3相當。

應用場景:結合小紅書生活方式分享平臺積累的海量高質量UGC內容,以及日均近6億的搜索量與70%月活用戶使用搜索功能,dots.llm1在生活場景對話、創意寫作、生活經驗答疑等方面有其獨特的應用優勢,小紅書也正在圍繞這一點構建自己的AI技術體系。

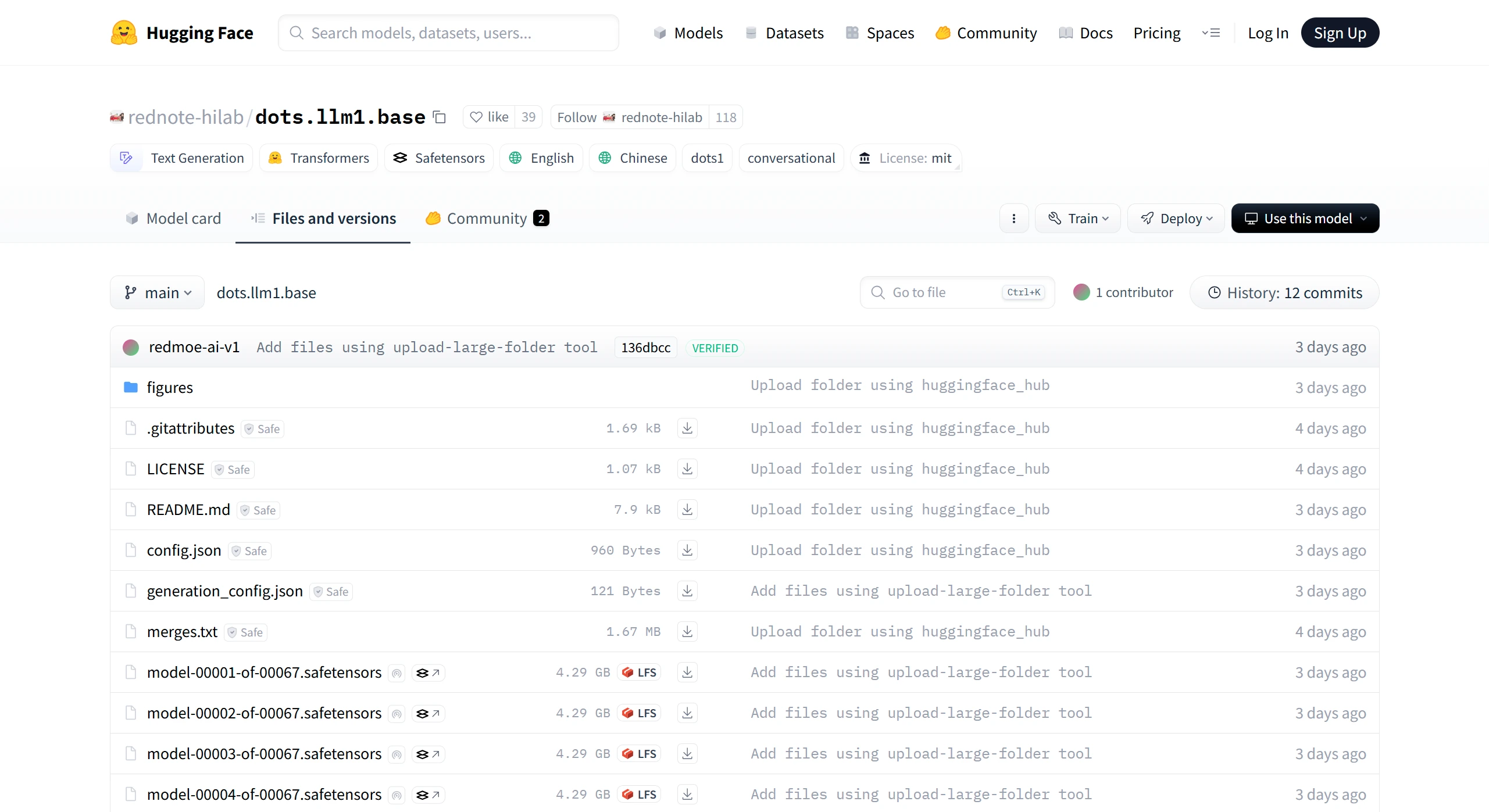

開源地址:https://huggingface.co/rednote-hilab/dots.llm1.base/tree/main

相關文章

- 用戶登錄

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺