DiffRhythm:全球首個基于擴散模型的端到端音樂生成工具

DiffRhythm是什么?

DiffRhythm是全球首個基于擴散模型的端到端AI音樂生成工具。不管你是剛接觸音樂的新手,還是經驗豐富的專業制作人,只要輸入歌詞、風格、情感等文字描述,它就能快速產出各種風格的音樂,從古典交響樂到賽博朋克風都不在話下,不需要人工干預就可以幫你輕松創作屬于自己的音樂作品。

DiffRhythm功能特點

端到端生成:直接處理原始音頻波形,省去中間符號轉換環節,讓音樂里細膩的情感得以完整保留。

多模態理解:能綜合文本、音樂甚至圖像信息,精準把握像“溫暖復古”“未來科技感”這類比較抽象的風格特點。

動態可控性:可以實時對節奏、和弦走向進行調整,就像用調色盤調配顏色一樣靈活地組合音樂元素。

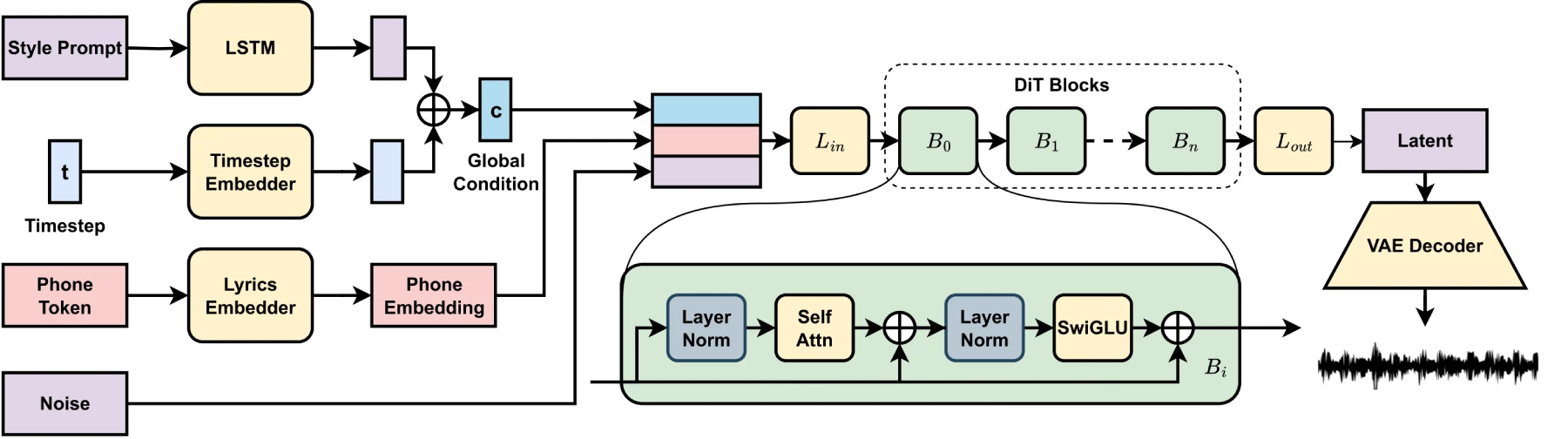

潛在擴散模型:基于擴散模型,在短短十秒內就能合成包含人聲和伴奏的完整歌曲,時長最長可達4分45秒,而且音樂性和可懂度都很高。

非自回歸結構:推理速度快,結構簡單,保證了工具的可擴展性。

DiffRhythm核心技術

DiffRhythm的核心是擴散模型,工作原理有點像玩“噪聲消除游戲”,分兩個階段:

前向加噪:把原始音樂片段一點點加上隨機噪聲,直到變成白噪音。

反向去噪:通過訓練好的神經網絡,從這些噪聲里慢慢還原出符合用戶要求的音樂,最終得到高質量音頻。

相比傳統ai音樂工具的優勢

端到端生成:直接處理原始音頻波形,無需中間轉換,保留細膩情感。

多模態理解:結合多種輸入,精準捕捉抽象風格。

動態可控性:實時調整節奏、和弦走向,靈活組合音樂元素。

DiffRhythm如何使用

AI生成帶時間戳的歌詞:你可以設定歌曲主題和風格,讓AI生成帶時間戳的歌詞;也能自己寫好歌詞后添加時間戳。

生成歌曲:把帶時間戳的歌詞輸入界面提交,就能得到歌曲。不過目前版本生成的歌曲最長為95秒,歌詞太長會被截斷。

DiffRhythm應用

內容創作者:短視頻博主能在一分鐘內生成適配視頻情緒的背景音樂,不用擔心版權問題。

獨立游戲開發者:低成本打造高品質場景音效庫。

音樂產業:唱片公司借助AI輔助創作熱門歌曲的Remix版本,延長IP的生命周期。

演出行業:實時生成與觀眾互動反饋同步的即興音樂 。

GitHub倉庫:https://github.com/ASLP-lab/DiffRhythm

在線演示:https://huggingface.co/spaces/ASLP-lab/DiffRhythm

項目地址:https://aslp-lab.github.io/DiffRhythm.github.io/

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺