Mercury:首個(gè)商用級(jí)別擴(kuò)散大型語(yǔ)言模型(dLLM)

Mercury是什么?

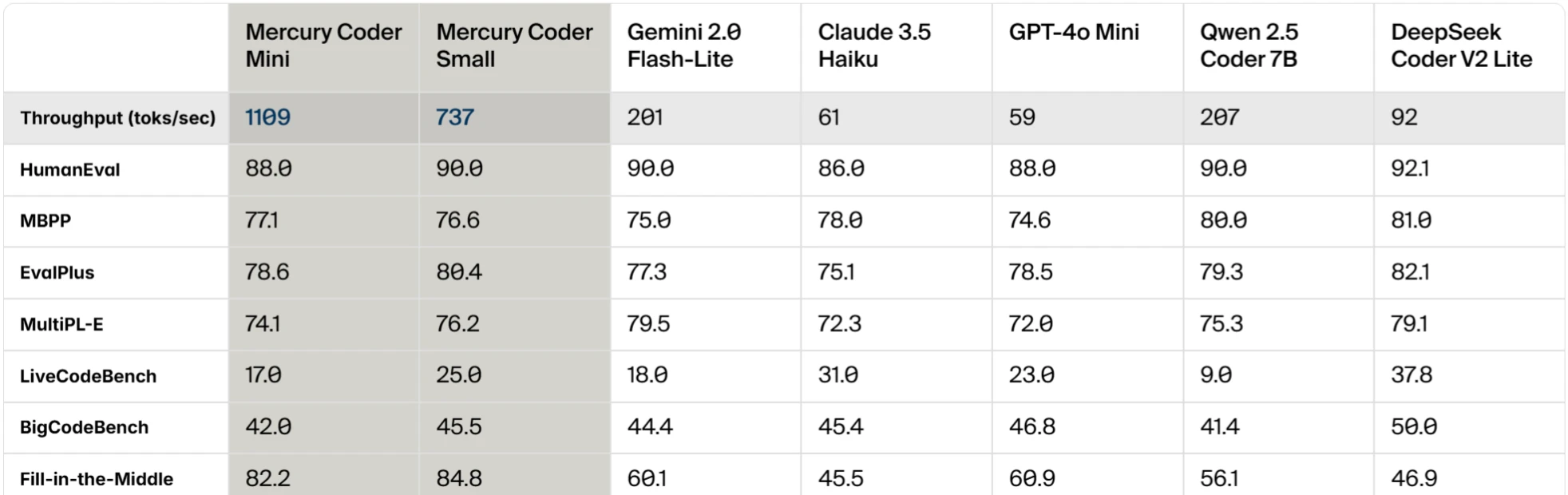

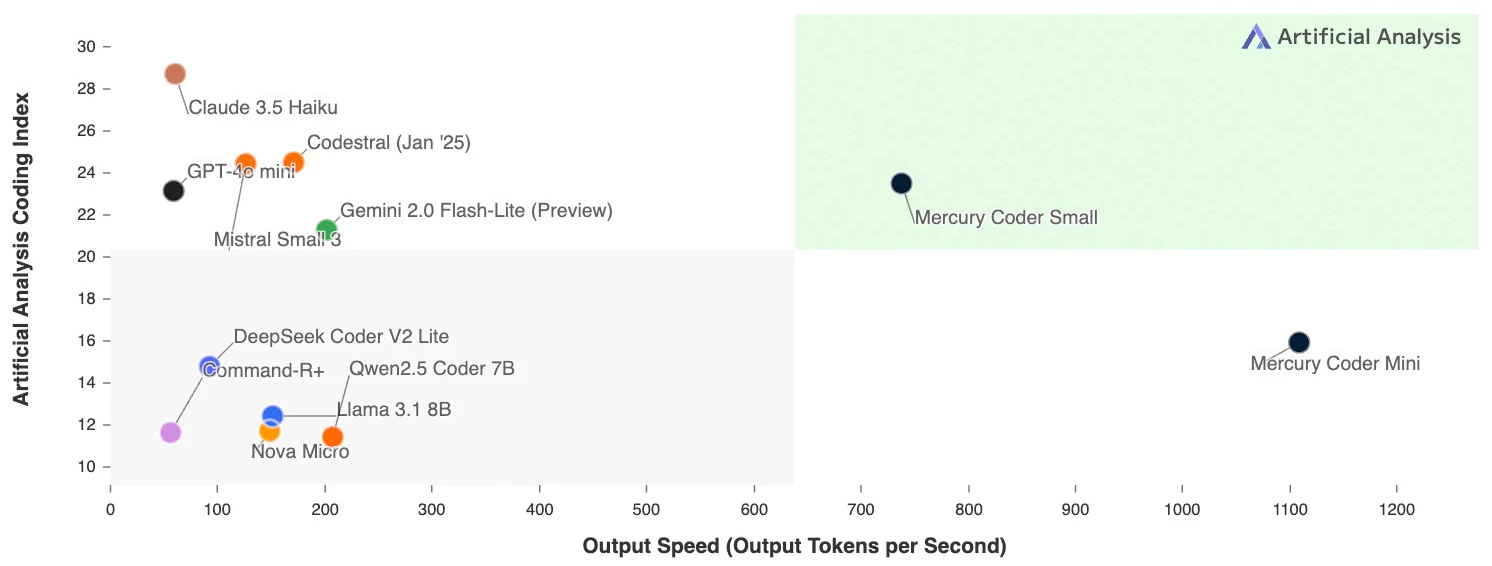

Mercury是由創(chuàng)業(yè)公司Inception Labs推出的首個(gè)商用級(jí)別擴(kuò)散大型語(yǔ)言模型(dLLM)。在Copilot Arena基準(zhǔn)測(cè)試中,Mercury Coder速度超過(guò)了包括GPT-4o Mini和Claude 3.5 Haiku等多個(gè)現(xiàn)有模型。 在實(shí)際應(yīng)用中,Mercury Coder能夠以極快的速度生成高質(zhì)量的代碼。

技術(shù)原理

擴(kuò)散模型:Mercury采用擴(kuò)散模型技術(shù),與傳統(tǒng)自回歸模型不同,它通過(guò)“從粗到細(xì)”的生成過(guò)程,從純?cè)肼曢_始,通過(guò)多個(gè)去噪步驟逐步生成有意義的文本。

并行生成:利用GPU的并行生成機(jī)制,Mercury能夠在生成文本時(shí)同時(shí)修改多個(gè)token,從而顯著提高生成速度和效率。

創(chuàng)新點(diǎn)

速度優(yōu)勢(shì):Mercury在NVIDIA H100上能以每秒超過(guò)1000 token的速度運(yùn)行,比現(xiàn)有的經(jīng)過(guò)速度優(yōu)化的LLM快5到10倍。

成本效益:通過(guò)新的語(yǔ)言生成方法,Mercury將推理成本降低了10倍,同時(shí)保持了與前沿模型相當(dāng)?shù)男阅堋?/p>

糾錯(cuò)能力:擴(kuò)散模型的特性使得Mercury能夠在生成過(guò)程中不斷改進(jìn)輸出,糾正錯(cuò)誤和幻覺。

Mercury功能特征

擴(kuò)散模型技術(shù):Mercury采用擴(kuò)散模型,通過(guò)“從粗到細(xì)”的生成過(guò)程,從純?cè)肼曢_始,逐步生成有意義的文本。

并行生成:利用GPU的并行生成機(jī)制,Mercury能夠在生成文本時(shí)同時(shí)修改多個(gè)token,顯著提高生成速度和效率。

速度優(yōu)勢(shì):在NVIDIA H100上能以每秒超過(guò)1000 token的速度運(yùn)行,比現(xiàn)有的經(jīng)過(guò)速度優(yōu)化的LLM快5到10倍。

成本效益:通過(guò)新的語(yǔ)言生成方法,Mercury將推理成本降低了10倍,同時(shí)保持了與前沿模型相當(dāng)?shù)男阅堋?/p>

糾錯(cuò)能力:擴(kuò)散模型的特性使得Mercury能夠在生成過(guò)程中不斷改進(jìn)輸出,糾正錯(cuò)誤和幻覺。

Mercury應(yīng)用

編程與代碼生成:Mercury Coder專門為代碼生成進(jìn)行了優(yōu)化,在標(biāo)準(zhǔn)編碼基準(zhǔn)測(cè)試中表現(xiàn)優(yōu)異,速度比傳統(tǒng)模型快10倍以上。

Agent應(yīng)用:Mercury的高速度和效率使其在需要大量規(guī)劃和長(zhǎng)篇生成的應(yīng)用中表現(xiàn)出色,如智能客服、代碼助手等。

邊緣應(yīng)用:由于其高效性,Mercury在資源受限的環(huán)境中也能表現(xiàn)出色,如手機(jī)或筆記本電腦上的應(yīng)用。

高級(jí)推理:Mercury可以利用錯(cuò)誤修正來(lái)修復(fù)幻覺并提升回答質(zhì)量,適用于需要深度推理的任務(wù)。

可控生成:Mercury可以編輯輸出內(nèi)容,按任意順序生成詞,適用于需要靈活生成內(nèi)容的場(chǎng)景。

Mercury如何使用?

安裝與配置:Mercury Coder已上線,可公開試用。用戶可以通過(guò)Inception Labs提供的playground體驗(yàn)其功能,或通過(guò)API和內(nèi)部部署服務(wù)進(jìn)行企業(yè)級(jí)應(yīng)用。

體驗(yàn)與測(cè)試:用戶可以在Inception Labs的官方網(wǎng)站上體驗(yàn)Mercury Coder的強(qiáng)大能力,輸入代碼需求,即時(shí)生成高質(zhì)量的代碼。

在線體驗(yàn):https://chat.inceptionlabs.ai/

官方介紹:https://www.inceptionlabs.ai/news

- 用戶登錄

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺(tái)

開源AI應(yīng)用平臺(tái)