Step-Video-T2V

Step-Video-T2V簡(jiǎn)介

Step-Video-T2V是一個(gè)由階躍星辰與吉利汽車合作開源的先進(jìn)文本到視頻生成模型。它具備諸多突出特性,在視頻生成領(lǐng)域展現(xiàn)出強(qiáng)大實(shí)力。

Step-Video-T2V模型的亮點(diǎn)

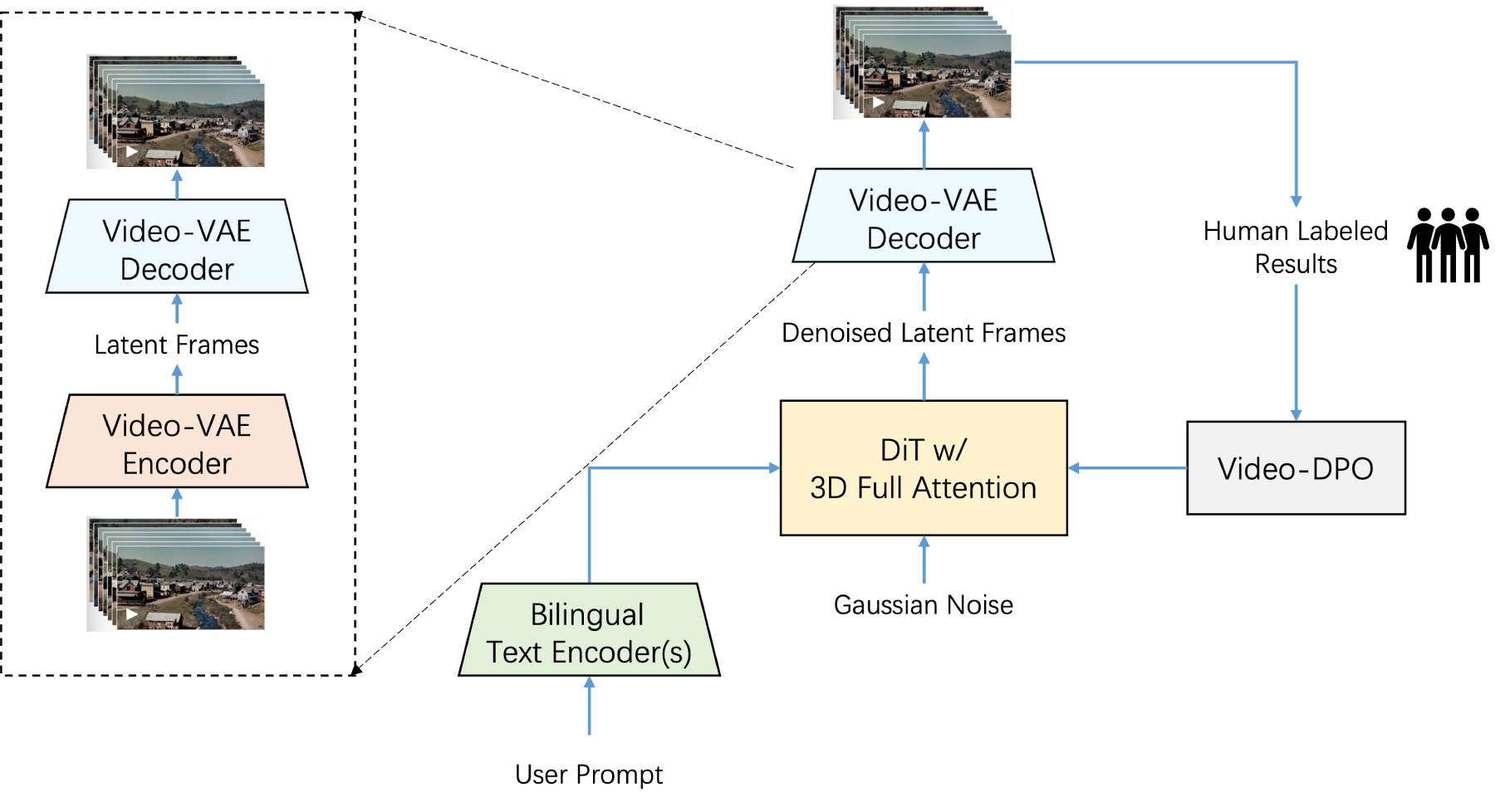

運(yùn)用DiT模型和流匹配訓(xùn)練方法,實(shí)現(xiàn)了16×16倍空間壓縮以及8倍時(shí)間壓縮,極大地提升了大規(guī)模視頻生成的效率。

擁有300億龐大參數(shù)參數(shù),能夠生成分辨率高達(dá)544x992的高質(zhì)量高分辨率視頻。

支持中文與英文提示輸入,方便不同語言背景的用戶使用。

Step-Video-T2V的功能特征

大規(guī)模參數(shù):參數(shù)量高達(dá)300億,賦予模型極高的生成能力和準(zhǔn)確性,使其能夠更精準(zhǔn)地理解文本描述并轉(zhuǎn)化為高質(zhì)量視頻。

高效的視頻生成:支持生成最長(zhǎng)204幀(544x992像素)的高質(zhì)量視頻,滿足多樣化的創(chuàng)作需求。采用深度壓縮的變分自編碼器(Video-VAE),達(dá)成16×16的空間壓縮和8×的時(shí)間壓縮,在保證視頻質(zhì)量的同時(shí),有效降低了訓(xùn)練和推理的成本。

雙語文本編碼器:支持中英文輸入,能夠深入理解和生成符合文本描述的視頻內(nèi)容,讓不同語言的用戶都能方便地使用該模型。

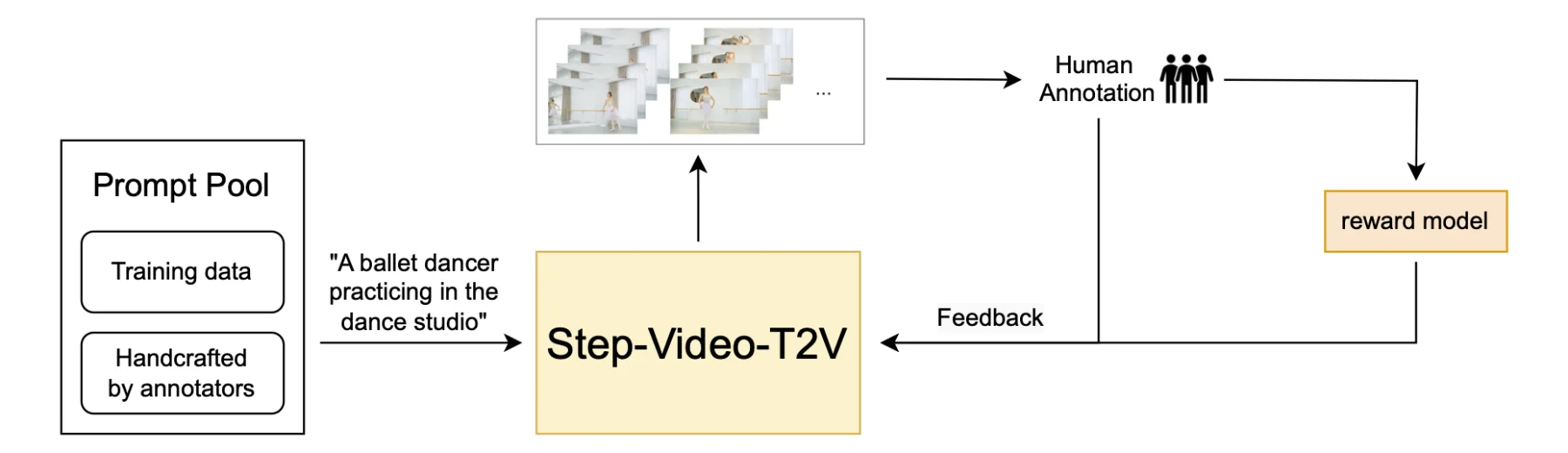

先進(jìn)的架構(gòu):使用3D全注意力DiT架構(gòu),能夠靈活適應(yīng)動(dòng)態(tài)分辨率的變化,確保視頻生成的穩(wěn)定性和高質(zhì)量,引入視頻偏好優(yōu)化(Direct Preference Optimization, DPO),通過人類反饋機(jī)制,進(jìn)一步提升生成視頻的質(zhì)量和平滑度,使其更符合用戶的預(yù)期。

多模態(tài)融合:結(jié)合圖像、語音和文本三種模態(tài)的理解能力,生成的內(nèi)容在細(xì)節(jié)上更為逼真。例如,生成的人物表情更加生動(dòng)、光影變化更加自然、動(dòng)態(tài)物體的表現(xiàn)更加流暢真實(shí)。

靈活的操作模式:提供基礎(chǔ)版(50步生成)和Turbo版本(15步蒸餾加速),以滿足不同用戶在不同場(chǎng)景下的性能需求。在實(shí)際操作中,生成204幀視頻大約需要4塊80GB顯存的GPU,耗時(shí)約12分鐘。

Step-Video-T2V的應(yīng)用場(chǎng)景

創(chuàng)意視頻制作:協(xié)助視頻創(chuàng)作者生成復(fù)雜場(chǎng)景和精細(xì)的創(chuàng)意視頻內(nèi)容,非常適合廣告制作、短視頻創(chuàng)作等領(lǐng)域。

動(dòng)畫與影視制作:在動(dòng)畫和影視行業(yè)中可用于生成高質(zhì)量的虛擬角色、動(dòng)態(tài)場(chǎng)景和復(fù)雜動(dòng)作。

教育與培訓(xùn):能夠創(chuàng)建互動(dòng)性強(qiáng)的教學(xué)視頻,使教學(xué)過程更加生動(dòng)有趣,增強(qiáng)學(xué)生的參與感和學(xué)習(xí)效果。

娛樂產(chǎn)業(yè):可以自動(dòng)生成游戲CG、電影預(yù)告片和其他娛樂內(nèi)容,節(jié)省大量時(shí)間和人力成本。

文化傳播:尤其在中國(guó)風(fēng)美學(xué)方面表現(xiàn)出色,可以生成水墨畫、古風(fēng)場(chǎng)景等內(nèi)容,有助于傳統(tǒng)文化的數(shù)字化傳播,讓傳統(tǒng)文化在新時(shí)代煥發(fā)出新的活力。

Step-Video-T2V的使用方法:

1. 安裝依賴:

安裝必要的Python庫(kù)和依賴項(xiàng)。通常可以通過pip或其他包管理工具進(jìn)行安裝。

pip install transformers torch torchvision torchaudio

2. 配置環(huán)境:

設(shè)置運(yùn)行所需的硬件環(huán)境,推薦至少4塊80GB顯存的NVIDIA GPU。

下載并解壓模型權(quán)重文件至指定目錄。

3. 加載模型:

使用Hugging Face Transformers庫(kù)加載預(yù)訓(xùn)練的Step-Video-T2V模型。

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "stepfun-ai/Step-Video-T2V" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name)

4. 生成視頻:

準(zhǔn)備好文本提示,并將其轉(zhuǎn)換為模型可用的形式。

運(yùn)行生成腳本,等待輸出結(jié)果。

input_text = "A red-haired woman performing on stage." inputs = tokenizer(input_text, return_tensors="pt") # Generate video frames (this is a simplified example; actual implementation may vary) outputs = model.generate(**inputs, max_length=204) # Adjust parameters as needed # Save or display the generated video frames

5. 后處理:

對(duì)生成的視頻幀進(jìn)行后期處理,如拼接成完整視頻、添加音頻等。

訪問資源:

GitHub倉(cāng)庫(kù):https://github.com/stepfun-ai/Step-Video-T2V

Hugging Face演示:https://huggingface.co/stepfun-ai

提交您的產(chǎn)品

提交您的產(chǎn)品  Ai應(yīng)用

Ai應(yīng)用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應(yīng)用平臺(tái)

開源AI應(yīng)用平臺(tái)